AI技術の導入は、従来のコンピューティング環境には存在しなかった新たな脆弱性を生み出します。これには、サイバー攻撃者による悪意のある攻撃や、プラットフォームやユーザの行動に起因する脆弱性などが含まれます。

目次

AIセキュリティの脆弱性

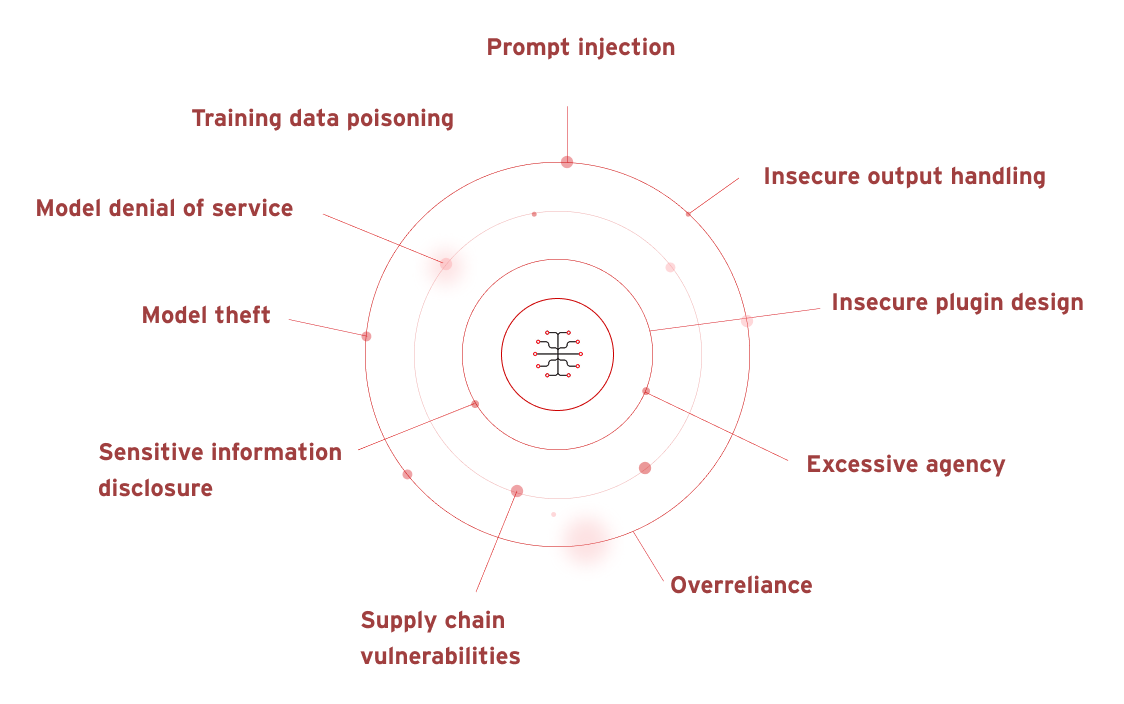

OWASP(Open Worldwide Application Security Project)は、大規模言語モデル(LLM)や生成AI(GenAI)に関連する複数の脆弱性を特定しています。具体的には、以下の項目が挙げられます。

- プロンプトインジェクション

- 安全でない出力処理

- トレーニングデータのポイズニング

- モデルに対するサービス拒否攻撃(DoS攻撃)

- サプライチェーンにおける脆弱性

- 機密情報の漏洩

- 安全でないプラグイン設計

- 過剰なエージェンシー(過度な権限付与)

- 過剰な依存

- モデルの窃取

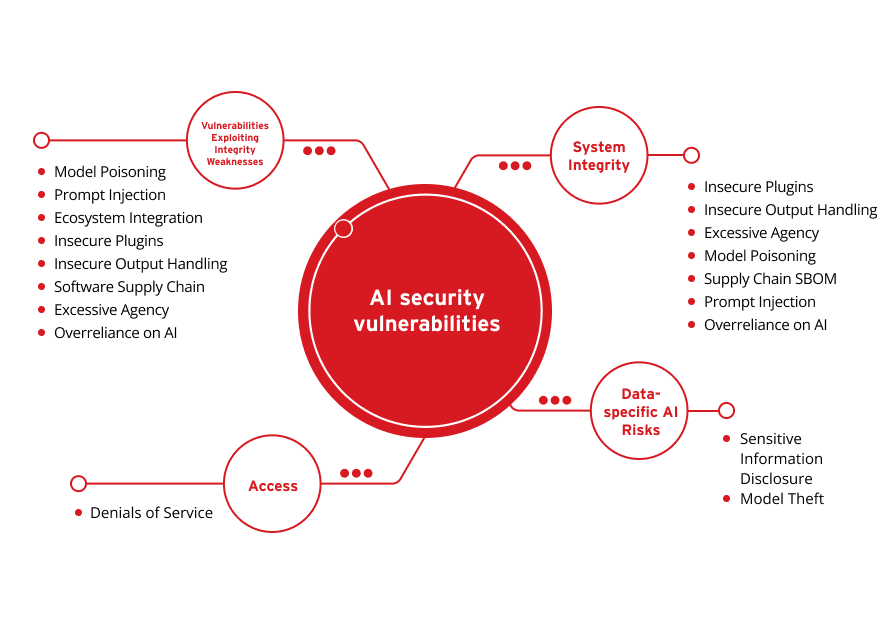

これらの脆弱性は、次の4つのカテゴリに分けることができます。

データ固有のAIリスク

システムの完全性

アクセス

完全性の弱点を突く脆弱性

機密情報の漏洩

モデルの窃取

安全でないプラグイン設計

安全でない出力処理

過剰なエージェンシー(過度な権限付与)

モデルに対するサービス拒否攻撃(DoS攻撃)

サプライチェーンにおける脆弱性

プロンプトインジェクション

過剰な依存

サービス拒否

モデルに対するサービス拒否攻撃(DoS攻撃)

プロンプトインジェクション

エコシステムの統合

安全でないプラグイン設計

安全でない出力処理

ソフトウェアサプライチェーン

過剰なエージェンシー(過度な権限付与)

過剰な依存

AIは、利用可能なデータとユーザからの入力に大きく依存しているため、デジタル防御を突破し、機密情報を窃取する攻撃の対象となるケースが増加しています。ガートナー社の最新調査によると、2024年第1四半期に報告された新たなリスクの上位5件のうち、AI関連のリスクが上位2件を占めました。それは、AIを悪用した攻撃と、AIによる誤情報の拡散です。ガートナー社は、AIが「フィッシングやソーシャルエンジニアリングを容易にし、侵入の精度と信頼性を高め、より破壊的な攻撃を可能にする」可能性があると指摘しています。

不正AI

不正AIとは、AIがユーザの意図と異なる動作をする状態を指します。この不一致は、適切なガードレールが設けられていない場合などに偶発的に発生することもあれば、攻撃者によって意図的に引き起こされることもあります。意図的なケースでは、攻撃者がAIシステムやその利用方法を妨害したり、悪意のあるAIモデルを環境内に導入したりする可能性があります。

不正対策の自動化

AIによる不正行為の自動化とは、フィッシング、ビジネスメール詐欺(BEC)、ディープフェイク動画・音声など、ビジネスプロセスを悪用したコンテンツ(テキスト、音声、映像など)をAIが自動生成することを指します。これにより、不正行為は容易に大規模化し、より巧妙かつ迅速に展開される恐れがあります。

データガバナンスの重要性

AIシステムはデータに依存しているため、使用するデータやリアルタイムで処理されるデータは、プライバシー保護や各種規制への準拠が求められます。リスクを最小限に抑えるためには、積極的かつ効果的なデータガバナンスの実施が不可欠です。

大規模言語モデル (LLM) のセキュリティリスク

LLMは、以下のような深刻な脆弱性に直面しています。

- モデルの動作を意図的に操作するプロンプトインジェクション

- 機密情報の漏洩を引き起こす情報漏洩

- 下流システムへの攻撃を許す不適切な出力処理

- サードパーティへの依存によるサプライチェーンの脆弱性

- 過剰な権限付与による不要なアクセス許可

- モデルの整合性を損なうデータポイズニング

- 機密指示が漏洩するシステムプロンプトの露出

さらに、ベクトル埋め込みの脆弱性、誤情報の生成、無制限消費攻撃なども、LLMアプリケーションのセキュリティ、信頼性、可用性を脅かす要因となります。

ユーザプロンプトに関連する生成AIのセキュリティリスク

生成AI(GenAI)は、過去および現在のデータを活用してユーザを支援します。そのため、プロンプトを必要とするツールでは、入力内容を慎重に検討することが重要です。ChatGPTのチャット履歴をオフにするオプションのように、一部のツールではユーザがデータ収集をオプトアウトできます。AIガバナンスや利用ポリシーによっては、これらの予防策がコンプライアンス維持の要件となる場合があります。

財務情報、未公開のソフトウェアに関する機密情報、個人識別情報(PII)などのセンシティブなデータをAIアプリケーションに入力すると、これらの情報が第三者にアクセス可能な状態になるリスクがあります。入力されたデータは、操作されたり、類似の問い合わせに対する応答として他のユーザに提示されたり、AIのセキュリティ対策が破られた場合に攻撃者に盗まれたりする可能性があります。特に、アイデア出しや大量のデータ集約を目的として生成AIを活用する際に、暗号化やセキュリティ対策が不十分であると、リスクはさらに高まります。

ChatGPTのセキュリティリスク

ChatGPTは、ユーザのプロンプトに対してテキストベースの応答を生成するAIツールであり、攻撃者によって悪用される可能性があります。例えば、標的の文章サンプルをもとにフィッシングメールを生成したり、誤字脱字や文法を修正して説得力を高めたりすることで、攻撃の精度が向上します。また、プロンプトインジェクションやジェイルブレイクなどの手法により、ユーザデータが盗まれたり、侵害されたりするリスクも存在します。

さらに、攻撃者が直接関与しない場合でも、セキュリティリスクは発生します。例えば、ChatGPTがユーザから受け取った情報をLLMの学習に利用する可能性があるほか、macOS版ChatGPTアプリが起動時にチャット内容を暗号化されていない状態で保存していることからもわかるように、データ暗号化が不十分であるリスクも存在します。

OpenAIのセキュリティリスク

OpenAIのAPIは、サイバー犯罪者の標的となる可能性があります。SOC 2に準拠し、定期的な侵入テストも実施されていますが、サイバー脅威は日々進化しており、リスクを完全に排除することは困難です。Soft Kraftの最新レポートでは、OpenAIにおけるデータセキュリティリスクを詳細に分析し、特に企業ユーザにとって重要な懸念点を明らかにしています。

主なリスクは以下のとおりです。

- ChatGPTの会話データがモデルの再学習に使用される可能性

- API経由で送信されたデータが内部・外部に公開される可能性

- 一般データ保護規則(GDPR)への準拠が困難になる可能性

- サードパーティのサブプロセッサの利用により、位置情報やデータ処理が複雑化する可能性

Microsoft Copilot AIのセキュリティリスク

Microsoft Copilot AIは、Microsoft 365アプリケーションと連携し、ユーザがすぐに利用できる環境を提供しています。最新のCopilot+ PCには専用の物理キーが搭載されており、より迅速な操作が可能です。しかし、こうした利便性の向上は、他の生成AIツールと同様に、セキュリティリスクを伴う可能性があります。

以下のようなリスクが考えられます。

- 権限設定の不備やプライバシー設定の未適用による機密情報の漏洩

- ユーザアクセス管理の不備による情報の不正利用

- プラットフォーム自体への攻撃により、データのアクセス方法や共有方法が改ざんされる可能性

AIセキュリティリスクへの対応

AI技術の進化に伴い、セキュリティ対策も高度化する必要があります。トレンドマイクロは、35年にわたる脅威インテリジェンスの蓄積、20年に及ぶAI技術の研究開発、そして比類なき脆弱性保護を基盤に、AI時代に対応したプロアクティブなセキュリティを提供しています。それが、Trend Vision One™ AIセキュリティです。

トレンドマイクロのAIセキュリティソリューションは、AIスタック全体を含む重要なビジネスワークロードを保護し、お客さまのセキュリティ体制を強化します。独自技術であるTrend Cybertronを搭載したAIセキュリティは、攻撃経路の予測、異常の検知、ディープフェイクやAI生成攻撃の防御を通じて、セキュリティの死角を排除し、AIをイノベーションの推進力へと変革します。