AI(人工知能)に関する企業ポリシーは、AI技術の適切かつ承認された利用を定義する一連の運用ルールです。これにより、コンプライアンスの遵守、データプライバシーの保護、およびデジタルセキュリティの維持が可能となります。

目次

AI企業ポリシーテンプレート

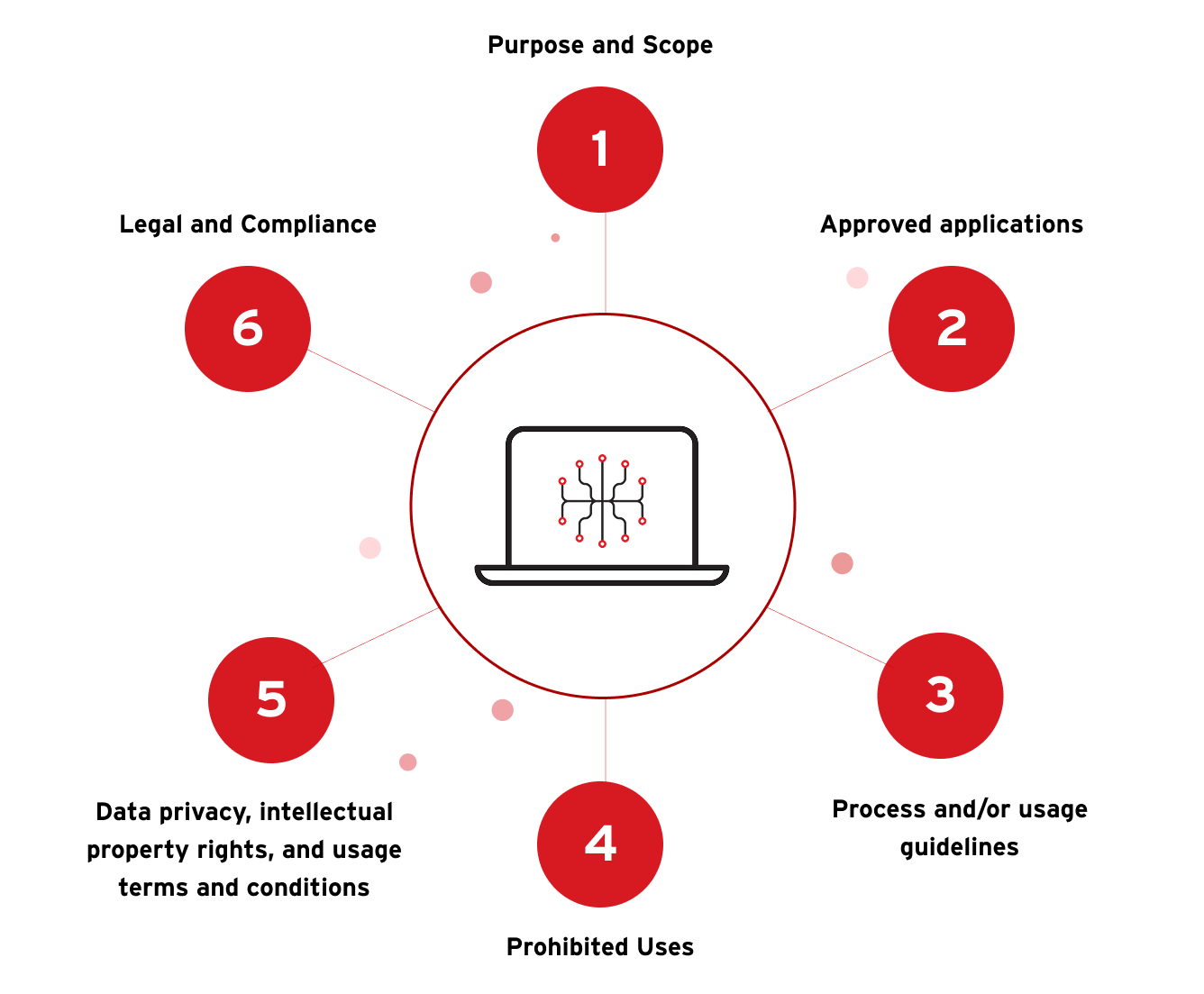

ポリシーがベストプラクティスの理解を促進し、リスクの軽減に効果を発揮するためには、いくつかの重要な領域に焦点を当てることが不可欠です。主な対象領域には、以下が含まれます。

目的と範囲

このセクションでは、AIに関する企業ポリシーの目的と適用範囲を明確にします。ポリシーは、正規の従業員だけでなく、外部委託先の個人や機関など、遵守が求められるすべての関係者を対象としています。

承認されたアプリケーション

ここでは、使用が承認されたAI関連アプリケーションを一覧化します。各アプリケーションのアクセス手順を明示することで、コンプライアンスの確保につながります。ただし、ログイン資格情報などの機密情報は記載せず、必要に応じて、またはオンボーディングプロセス中に、管理者によって安全な方法で提供します。

プロセスおよび使用ガイドライン

AIの利用に関する適切なプロセスを、箇条書きなどで簡潔にまとめることで、ユーザが正しい手順を理解し、遵守しやすくなります。このセクションでは、運用ガードレールの設定、許可プロセス、社内コミュニケーション、AI生成コンテンツの品質管理、ならびにAIシステムへのデータ・ツールアクセスの取り扱い方を明示します。また、関連するリスクや脆弱性が疑われた場合の対応方法も記載します。

禁止事項

このセクションでは、承認されたAIアプリケーションの使用が禁止される状況や方法を明確にします。合理的な例外がある場合は、それも併せて記載します。用語は明確かつ簡潔にし、誤解や混乱を防ぐことが重要です。

データプライバシー、知的財産権、および使用条件

ここでは、AIツールの契約条件を確認し、誤用や責任問題を回避するための指針を示します。データプライバシーの保護、知的財産権の尊重、機密情報の取り扱いに関する注意点を明確にし、AIツールが不適切なアクセスを行わないよう管理します。

法務とコンプライアンス

このセクションでは、AIの利用に際して遵守すべき法令・規制・社内ガイドラインを明示します。対象には、政府機関による法的要件、社内の法務・セキュリティ・IT部門の規定などが含まれます。これにより、組織全体でのコンプライアンス維持を支援します。

AI企業ポリシーの例

パン・カナディアンAI戦略

パン・カナディアンAI戦略は、複数の戦略的優先事項に基づいて構成されており、統合されたミッションのもとで推進されています。その目的は、「人々と地球に対して、社会的・経済的・環境的にプラスの影響をもたらすこと」にあります。

Microsoftの責任あるAIプラクティス

Microsoftは、AIを倫理的かつ責任ある方法で活用することに重点を置き、研究・ポリシー・エンジニアリングに関する取り組みを体系化しています。2024年5月には、包括的な「責任あるAIの透明性レポート」を公開しました。このレポートでは、AIリスクのマッピング・測定・管理から、安全で信頼性の高い最先端AIモデルの構築まで、広範な内容が網羅されています。

米国標準技術研究所(NIST)によるAI標準とポリシーへの貢献

NISTは、主要な民間および公共部門の利害関係者や連邦機関と連携し、新たなAI標準の策定を進めています。NISTは、「米国とEUの貿易技術評議会、OECD、欧州評議会、4か国の安全保障対話などの米国および国際的なAI政策の取り組みに積極的に関与しています。NISTは、これらの取り組みの一環として、米国商務省の国際貿易局および米国国務省とも協力しています。

2024年7月には、以下の4つの出版物を発表しました。これらは、AIシステムの安全性・セキュリティ・信頼性の向上を目的としています。

- Generative AI

- 安全なソフトウェア

- AI標準

- Dual-Use Foundation Modelsの悪用リスク管理レポート(初期公開草案)

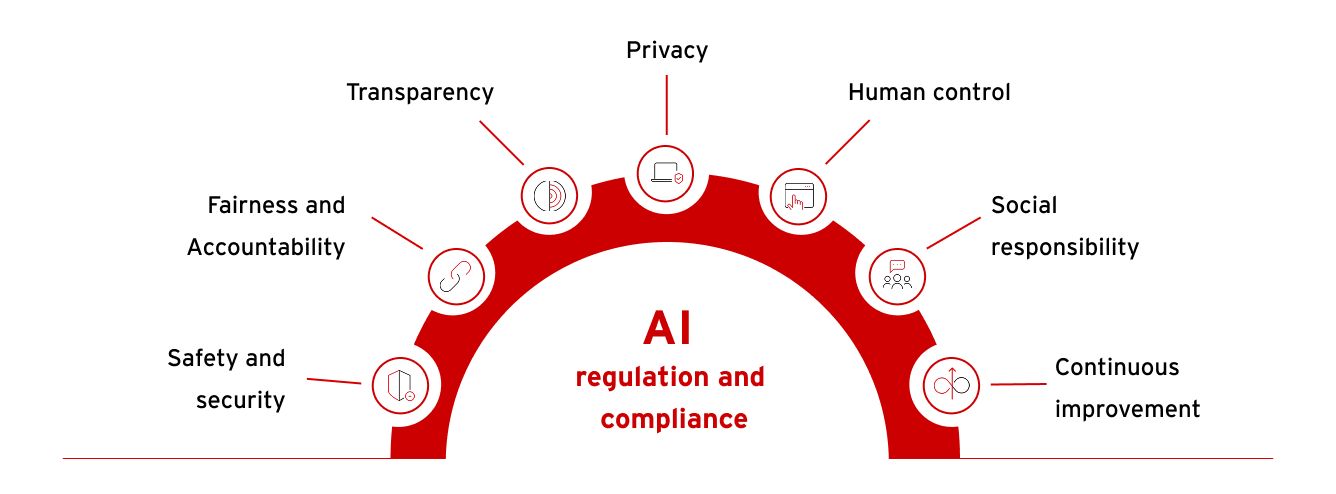

AIの規制とコンプライアンス

AI倫理の定義

AI倫理とは、AIシステムの責任ある開発・展開・利用を管理するための原則とガイドラインを指します。これには、安全性・セキュリティ、公平性、説明責任、透明性、プライバシー、人的制御、社会的責任、継続的な改善など、幅広い課題への対応が含まれます。

最先端のAI規制に関する専門家の推奨事項

OpenAIの研究者によって発表されたレポート(arXiv:2307.03718:Frontier AI Regulation: Managing Emerging Risks to Public Safety)は、では、最先端AIモデルに対する規制の必要性と課題が指摘されています。主な懸念点は以下の通りです。

- 危険な能力が予期せず発現する可能性

- 展開されたモデルの悪用防止が困難

- モデルの能力が広範に拡散するリスク

このレポートでは、規制に必要な3つの構成要素が提案されています。

- 標準設定プロセス:開発者に求められる要件を明確化

- 登録・報告要件:規制当局が開発プロセスを把握できるようにする

- 安全基準の遵守メカニズム:開発・展開における安全性を確保

AIポリシー策定における支援体制

企業が効果的なAIポリシーを策定・運用するためには、2つの補完的なアプローチが有効です。

1つは社内のセキュリティチームによるポリシーの設計と実装、もう1つは専門コンサルティング企業との連携によるレッドチーム評価の実施です。

社内チームやコンサルタントは、ポリシーの基本設計や運用ルールの整備に注力します。一方、レッドチーム評価は、AIシステムに潜在する脆弱性やリスクを洗い出し、ポリシーの堅牢性と網羅性を高めるための重要な洞察を提供します。

コンサルティング企業は、AIガバナンス、規制コンプライアンス、およびベストプラクティスの専門知識を提供し、データプライバシー、知的財産保護、およびリスク緩和など業界標準に準拠したポリシー策定を支援します。レッドチーム評価は、システムの脆弱性を発見し、敵対攻撃、データポイズニング、モデル盗難などの実際の脅威をシミュレートし、ポリシーフレームワークを改良および強化するための実践的な洞察を提供することで、この問題を解決します。これらの評価は、既存ポリシーの有効性を検証し、潜在的な悪用シナリオを明らかにすることで、AIの安全性と信頼性を高める支援となります。組織は、戦略的コンサルティングと脆弱性評価の両方からの洞察を統合することにより、独自の運用および戦略的ニーズを満たしながら、安全で公平で適応性の高いAIポリシーを確立することが可能です。