Artificial Intelligence (AI)

ディープフェイクを悪用したサイバー攻撃:新たなAI犯罪ツールセットの分析

本稿では、犯罪者たちがいかにディープフェイクを犯罪に悪用しているのか、そして悪用に必要なツールキットや関連する地下活動の実態について、包括的に解説します。

はじめに

ディープフェイクを作成するためのツールは、以前よりも強力でありながら手に入りやすくなっており、価格は下がり、操作も簡単になっています。犯罪者は、わずかな予算と労力、専門知識だけで非常に精巧なディープフェイクを容易に生成できるようになっており、今後はそのコストがさらに下がり、性能も向上していくと見られています。

犯罪者たちは、生成AIが一般に普及する以前から、ディープフェイクを使ったソーシャルエンジニアリングや誤情報の拡散によって利益を得ようと試みてきましたが、現在ではこの技術によって、消費者を狙った恐喝から企業詐欺に至るまで、これまで以上に効果的かつ多様な手法で金銭を得ることが可能になっています。本稿では、企業がどのように標的とされているか、また個人に対してディープフェイクがどのように悪用されているかについても取り上げています。

さらに、ディープフェイクの生成を支えるツールキットについても分析しています。もともと悪用を想定していない市販のツールをそのまま流用することにより、犯罪者はもはや特注のアンダーグラウンドサービスに依存する必要がなくなっている実態が明らかになりました。また、本稿では、犯罪者が集うアンダーグラウンドコミュニティにおける活発な議論にも注目しています。アンダーグラウンドコミュニティでは、有用なツールの推薦から、標的を欺き、操作し、詐取するために実際に使われているプレイブックまでさまざまな情報が共有されています。

これらの調査、分析により本稿は、ディープフェイクを悪用する現在の犯罪者たちの関心がどこに向かっているのかを読者に明確に伝えるものといたしました。

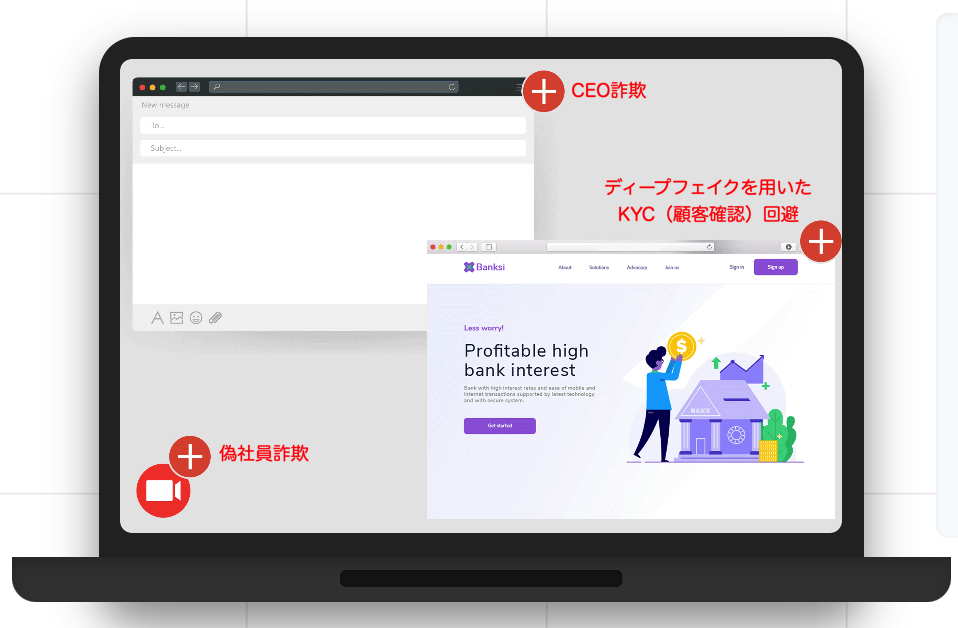

ディープフェイクを用いた攻撃

ディープフェイクはそのさまざまな形態において、すでに比較的長い期間存在しています。2017年には、技術コミュニティが DeepFaceLab のようなツールを使って実験を始め、翌年にはそれが一般的に使われるようになりました。この技術が一般ユーザにも手の届くものとなってからは、サイバー犯罪者による悪用が広がってきました。偽のプロパガンダ映像による誤情報の拡散、暗号資産関連の詐欺、さらには特定の個人や組織を狙った攻撃にまで及んでおり、2019年には ディープフェイク音声を用いたCEO詐欺 が初めて確認されました。

犯罪者たちは、企業と個人を攻撃する際にディープフェイクを異なる形で活用しています。企業に対する攻撃では、標的となる組織に合わせて手口をカスタマイズする傾向がありますが、個人に対してはより汎用的なディープフェイクを使うことが多く、幅広い対象に対して柔軟に適用できるようになっています。本セクションでは、標的の種類に応じて犯罪者がどのようにディープフェイクの使用方法を変えているかを比較し、用いられているさまざまな手口を明らかにします。

ディープフェイクを用いて企業を狙う攻撃

企業を標的としたディープフェイクを用いた攻撃は、一般的に非常に標的を絞った形で行われます。こうした攻撃には、被害者に関する事前の知識、綿密な偵察、そして時間をかけた入念な計画が必要とされます。攻撃の多くは、送金手続きを実行するのに適した従業員を見つけ出すか、人事部門の採用プロセスについて詳細に把握することが前提となります。

CEO詐欺

CEO詐欺は、ビジネスメール詐欺(BEC)としても知られており、攻撃者が標的企業の幹部になりすまし、下位の従業員を騙して会社の資金を送金させたり、機密情報やデータを移動・漏洩させたりする手口です。

音声や映像によるディープフェイクは、攻撃者の作り話に信憑性を与える要素となります。最も大きな被害事例として知られているのは、2024年2月に公表されたケースで、香港の企業が2,500万ドルを失いました。標的となった従業員は、偽の幹部や他の上級職員とされる人物たちと、ディープフェイクによって生成されたビデオ会議に出席し、そこで騙されたのです。このリアルタイムのビデオ通話はすべて偽物でした。

このような攻撃でディープフェイクが詐欺の信憑性を高めるために使われたのは、これが初めてではありません。すでに2019年にも、イギリスの企業が非常によく似た手口で攻撃を受けており、その際にはWhatsApp音声メッセージにディープフェイクが使用されていました。

偽社員詐欺

過去2年間で、ディープフェイクを用いた新たな雇用詐欺が登場しました。これは、攻撃者がリモートワークの求人に応募する求職者になりすますという手口です。

攻撃者は、実在する人物の外見と完璧な履歴書を使って採用プロセスを進めます。履歴書はたいてい、LinkedInのようなサイトから取得されたものです。ライブの面接時には、ディープフェイクのビデオストリーミングツールを使って本人になりすまし、ChatGPTのようなAIツールを活用してリアルタイムで技術的な質問に正確に答えます。

ディープフェイクを使った企業攻撃には一定の準備が必要ですが、偽社員詐欺はさらに長期的な戦略を取ります。攻撃者が採用され、企業からノートパソコンを支給されると、目立たないようにふるまいながら数か月間は給料を受け取り続けます。そして最終的に、ネットワークへのアクセスを金銭的に悪用する段階に入ります。多くの場合、それは社内データの窃取やランサムウェアの展開という形で実行されます。

ディープフェイクを用いたKYC(顧客確認)回避

ディープフェイクを利用した「Know Your Customer(KYC:顧客確認)」の回避は、銀行、金融サービス、保険会社などを標的としています。KYCとは、マネーロンダリングのリスクを低減するために金融機関が実施を義務づけられている本人確認手続きです。KYC規制では、銀行、金融サービス、両替業者、フィンテック企業などに対し、顧客の身元を確認するための特定の情報の収集が求められており、これによって偽の身分証で口座を開設することが困難になるよう設計されています。KYCシステムでは通常、新規顧客に対して、有効な身分証明書とともに顔認証を提出するよう求められ、ライブ映像の顔と書類内の写真が一致する必要があります。現在、犯罪者はディープフェイクを用いて、こうしたKYCチェックを回避しています。

犯罪者が集うアンダーグラウンド市場では、偽の身分情報を使って銀行や暗号資産プラットフォームに正規の口座を開設できるようにするサービスが提供されています。これらのサービスでは、KYCチェックを突破するために特別に作成されたディープフェイクの写真や動画が使われています。

KYC回避型の攻撃は、CEO詐欺や偽社員詐欺のように綿密な下調べを必要とせず、特定の銀行を標的とするものではありません。目的は、犯罪行為に利用できる口座を開設することにあります。一度KYCの回避に成功すると、同じディープフェイクが他の金融サービスでも繰り返し使われることがあります。

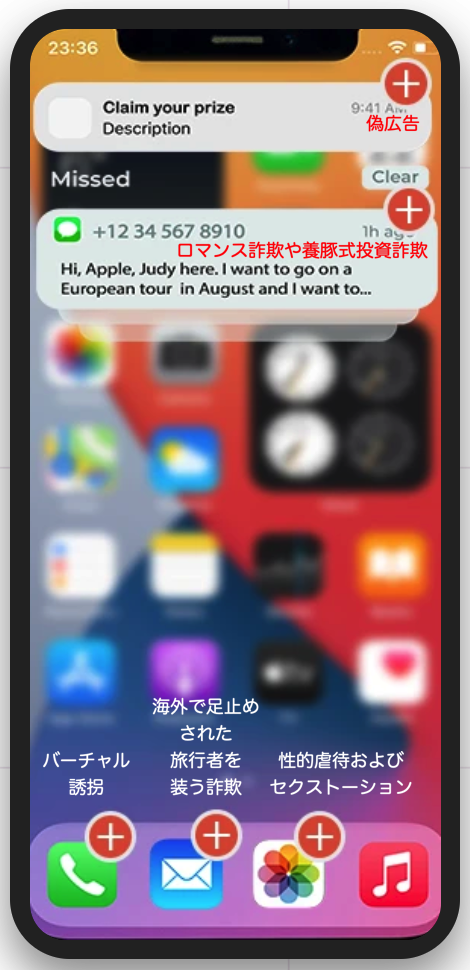

ディープフェイクを用いて個人ユーザを狙う攻撃

企業を狙った攻撃とは異なり、個人を対象とする攻撃は広範かつ無差別に行われる傾向があり、被害者に関する事前情報はほとんど、あるいはまったく必要とされません。しかし近年では、特定の個人を狙ったより個別化された攻撃の増加も見られるようになっており、本セクションではその詳細について述べます。

偽広告

偽広告はもともと、フェイクニュース やプロパガンダ動画として始まりましたが、現在では完全に犯罪的な攻撃へと進化しています。これらの詐欺広告では、攻撃者が有名人や信頼されている人物になりすまし、商品を宣伝するディープフェイク動画を使います。多くの場合、それは暗号資産(仮想通貨)プロジェクトの宣伝として見られます。

被害者が資金を投資した後、宣伝されていた暗号資産が実は存在しないものであり、犯人がそのまま資金を持ち逃げしていたことに後から気づくことになります。こうした事例は、2024年にも発生しており、偽の暗号資産取引所 BinanceのCEOを装った動画や、イーロン・マスク、ビル・ゲイツ といった著名人の姿を使ったディープフェイク動画が確認されています。

ここに示されている画像は、ChatGPTを使って作られた偽広告の一例です。一部の偽広告は比較的容易に見分けがつくものもありますが、ディープフェイクや生成AIの技術は日々進化しており、有名人や著名人の外見を自然に再現することで、あたかも本物の推薦であるかのように見せかける、より巧妙な詐欺が増えつつあります。

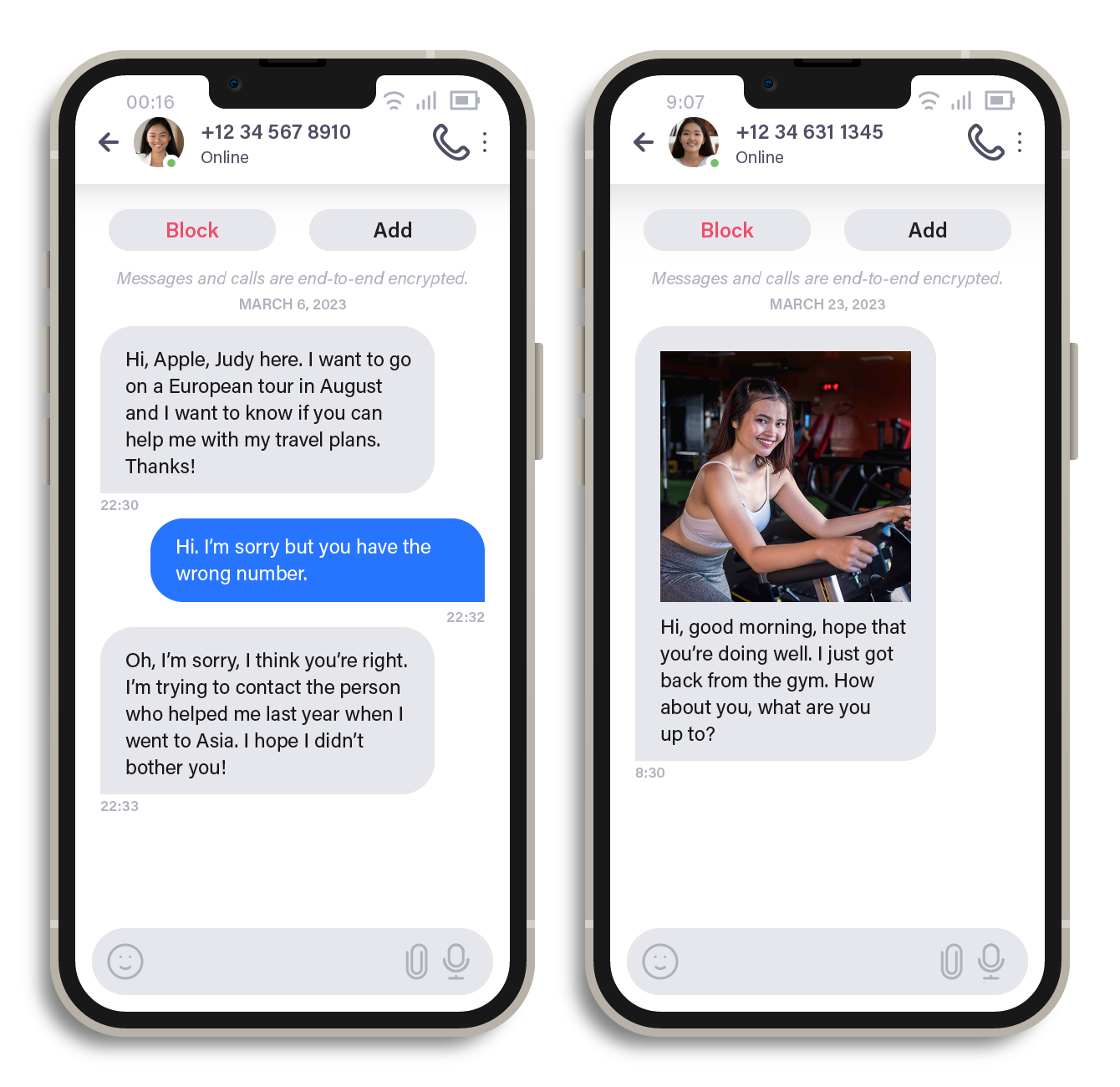

ロマンス詐欺や養豚式投資詐欺

ジュディ:こんにちは、アップル。ジュディです。8月にヨーロッパ旅行を計画していて、旅行の相談に乗ってもらえたらと思って連絡しました。よろしくお願いします!

あなた:こんにちは、すみませんが番号を間違えていると思います。

ジュディ:あっ、ごめんなさい。確かにそうかもしれません。去年アジア旅行のときに助けてもらった人に連絡しようとしてたんです。ご迷惑でなければいいのですが!

メッセージ:おはようございます。元気にしてるといいな。ちょうどジムから帰ってきたところです。あなたはどう?何してるの?

ディープフェイクは、いわゆる養豚式投資詐欺として知られるものやロマンス詐欺にも利用されています。この手口では、犯罪者が被害者とライブビデオ通話をしたり、魅力的な異性や仮想通貨投資の専門家になりすましたディープフェイク動画をやり取りしたりすることで、信頼を築こうとします。

こうした詐欺は「会話型詐欺」とも呼ばれ、長時間のやり取りを通じて、数週間からときには数か月をかけて被害者の信頼を得ていくのが特徴です。会話型詐欺は、ますます一般的かつ効果的になっており、その中で偽の音声や映像は、攻撃者の作り話にさらなる信憑性を持たせる手段として使われています。内部データによれば、ディープフェイクを用いた詐欺動画の試行件数は、2025年2月時点で全体の4%だったのに対し、3月には24%へと急増しています。

バーチャル誘拐

緊急警告:AIによるディープフェイクの悪意ある、または犯罪的な利用の可能性

電子証拠を操作して刑事司法の捜査を妨害する

バーチャル誘拐は、ディープフェイクを用いて個人を標的とする、より直接的な攻撃手法です。この詐欺では、攻撃者が被害者に連絡し、「あなたの家族、たとえば息子や娘を誘拐した」と主張し、身代金を要求します。

この誘拐の主張を裏付けるために、攻撃者は人質とされる家族の音声クリップを用います。この音声は、ソーシャルメディアなどから入手した実際の音声をもとに、音声クローン技術を使って作られたもので、あたかも本当にその家族が話しているように聞こえます。家族はその音声を聞いて大切な人が危険にさらされていると信じ込んでしまいますが、実際にはその本人は無事で、こうした詐欺に自分の音声や人格が悪用されていることすら知らないというのが実情です。

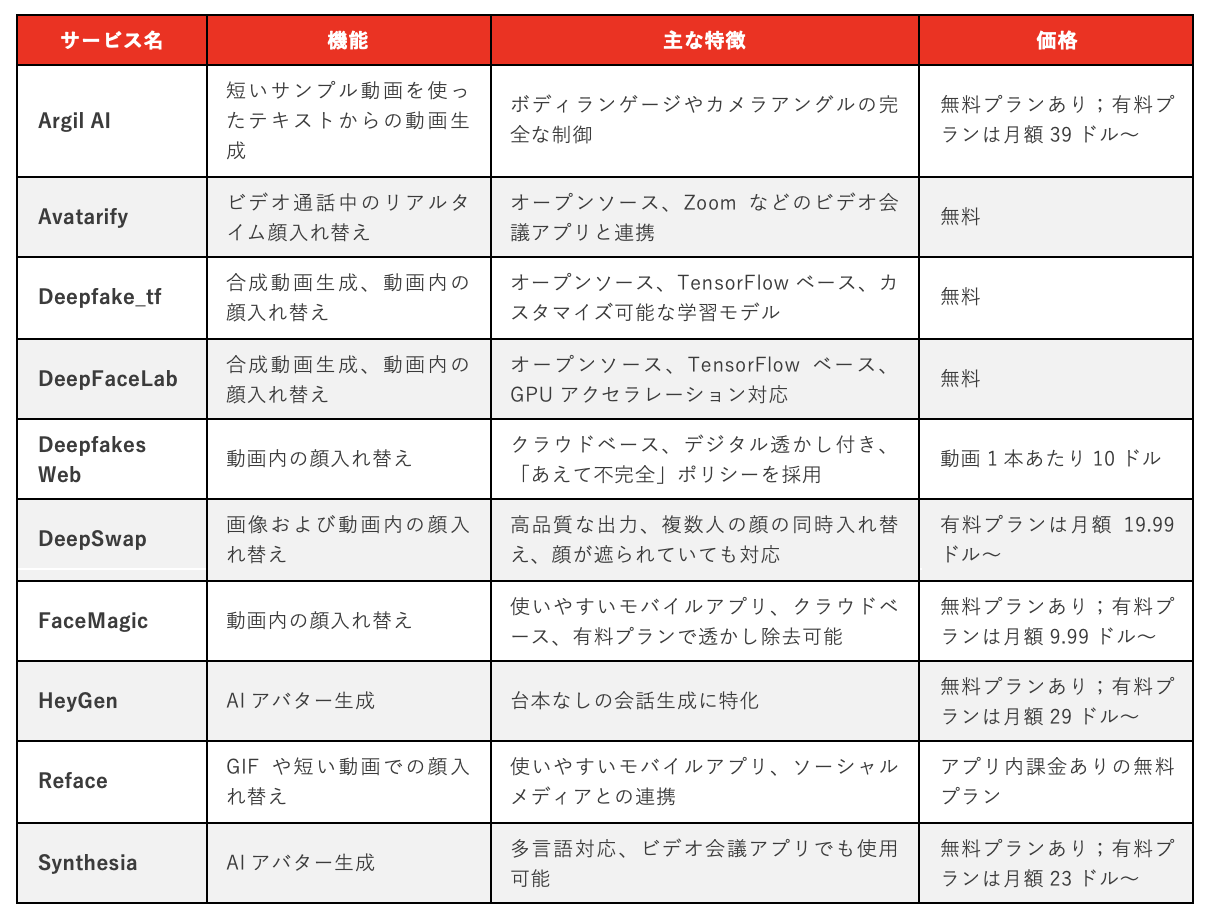

海外で足止めされた旅行者を装う詐欺

こんにちは、今イタリアにいるんだけど、聞いて。クレジットカードが使えなくなってしまったの。現金を少し送ってもらえないかな?

「海外で足止めされた旅行者」を装う詐欺では、攻撃者が誰かのメールアドレスとその連絡先リストを盗み出し、アドレス帳に登録されているすべての相手に連絡を取ります。その際、「自分は海外旅行中に足止めされている」「事故に巻き込まれた」などと説明し、困難な状況から脱するために緊急で送金が必要だと助けを求めてきます。

この手口は以前から存在していますが、近年ではAIによる音声クローン技術が用いられるようになり、本人になりすまして連絡することで、詐欺の信憑性がより高まっています。

性的虐待およびセクストーション

ディープフェイクが未成年のヌード画像の生成に悪用される事例も確認されています。この場合、犯罪者は実在する子どもや架空の子どもの偽の画像を作成します。多くの場合、もとになる実在の子どもの画像は、子どもとのライブチャットなどのやり取りの中で収集されます。こうしたグルーミング(信頼関係を装って接近し、性的搾取を目的とする行為)は、最短で18分程度で成立してしまうこともあります。

また、犯罪者が被害者のヌード画像を生成し、それを使って脅迫を行うケースもあります。かつてのセクストーションは、被害者本人に自発的に性的な画像を送らせるものでしたが、現在では被害者の同意なく、ネット上で公開されている一般的な写真からでもディープフェイクを使って偽のヌード画像を作成することが可能になっています。こうした画像生成には、いわゆる「ヌーディファイ(nudifying)」アプリが使われており、元の写真をもとに衣服を除去したように見せかける画像を作り出します。別の手法として、ポルノ画像に対象者の顔を合成する方法もあります。こうして作られた偽画像が公開されることで評判を毀損し、精神的なダメージを与えることができるため、悪質な手口として機能するセクストーションの一形態となっています。

この画像はMidjourneyで生成されたものです。Midjourneyには、衣服の除去やヌードの生成といった悪用を防ぐためにプロンプトを自動修正するセーフガードが導入されていますが、他の生成AIプラットフォームにはそのような制限がない場合もあります。さらに、生成AIでは人物のポーズや姿勢まで編集できるため、追加のリスクが生じています。

* * *

要するに、犯罪者は年齢を問わず、入手しやすく非常に安価なツールを使って、個人のヌード画像を簡単に生成することができます。こうした画像は、被害者が削除を求めても実際には取り下げることが非常に難しく、特に著名人の場合はさらに困難です。また、世界の多くの地域では、一般市民を保護したり、こうした行為を犯罪として処罰したりするための法的整備が遅れているのが現状です。さらに、ディープフェイクによる児童虐待素材は、実在しない児童の捜索に法執行機関の時間や資源が費やされてしまうため、実際に救出が必要な子どもへの対応が遅れるという、別の深刻な課題も引き起こしています。

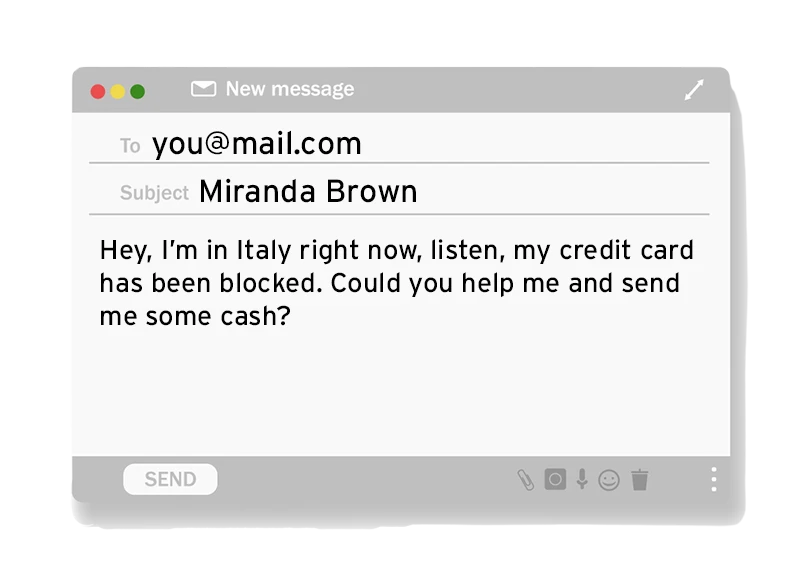

ディープフェイク技術は、かつては限られた分野での実験的な試みに過ぎませんでしたが、現在ではサイバー犯罪者の手に渡り、個人にも企業にも深刻な影響を与える強力な武器へと変貌しています。表1では、ディープフェイクを利用したさまざまなサイバー犯罪を、攻撃の広がりと被害者の種類に基づいて分類しています。なお、ロマンス詐欺やセクストーションといった広範囲に及ぶ攻撃であっても、特定の個人を狙ったものに変化することがある点には注意が必要です。

犯罪者が集うアンダーグラウンドコミュニティの監視においては、彼らの多くが企業や組織を主な標的としていることが確認されています。しかし、個人に対する攻撃も無視できません。セクストーションや音声クローンなど、ディープフェイクを活用した攻撃手法は容易にカスタマイズ可能であり、企業を狙った攻撃にも転用できるリスクがあるためです。

* * *

簡単に作れるディープフェイク

現在のデジタル市場では、ディープフェイクの作成が驚くほど簡単になっています。音声や映像のディープフェイクを生成するためのツールは数多く存在しており、中にはリアルタイムで顔を入れ替えるビデオストリーミング機能を備えたものもあります。主流のAIベースの画像生成ツールを使えば、実在しない人物の非常にリアルなポートレートを作成したり、あたかも実在する人物であるかのように見える画像を捏造したりすることも可能です。中にはさらに悪質な機能を備えたツールも存在し、実在する人の写真や架空の人物の画像からヌード画像を生成するものもあります。

ディープフェイク生成ツールは、多くの場合、使いやすいオールインワンのパッケージとして提供されています。一部のプラットフォームは、合成メディアを生成するための包括的かつ一括型のソリューションとして売り出されていますが、他のツールは音声・映像・画像といった特定の分野に特化しており、その分より精巧な出力を可能にしています。次のセクションでは、こうした各種サービスについて詳しく取り上げていきます。

なお、合成メディア生成プラットフォームは、他のあらゆる技術と同様、それ自体が善悪を持つものではありません。これらのツールは本来、正当な目的でコンテンツを作成するために設計されていますが、悪用される可能性も常に存在しており、そのリスクについてもこのセクションであわせて考察します。

* * *

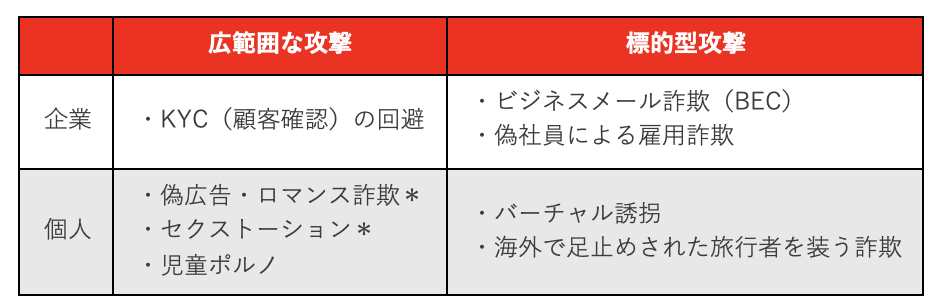

ディープフェイク音声

今回の分析でまず明らかになったのは、AIによる音声生成技術の市場が非常に成熟しているという点です。音声のクローン生成やスタジオ品質のナレーションを提供するサービスが多数存在しており、これらの技術は業界のあり方を一変させています。従来は高品質な音声を収録するには録音機材や静かな環境、話者の物理的な立ち会いなどが必要でしたが、そうしたハードルが取り払われたのです。たとえば「Speechify」は月額9.99ドルのサブスクリプションサービスで、誰でもオーディオブックを作成できるプラットフォームです。音声クローンやテキスト読み上げツールを活用し、実際に録音スタジオに入ることなく、自分の声で本を朗読したかのような音声を生成できます。

一方で、「Play.ht」のようなプラットフォームでは、音声合成を会話型AIと統合するためのAPIも提供されています。これにより、企業はリアルタイムでユーザと自然な会話ができるAIエージェントを構築することが可能となり、特にカスタマーサポートなどの分野で活用が期待されています。

これらのサービスには多くの正当な用途がある一方で、悪用の可能性があることも無視できません。サービス提供者は、自らの製品がどのように提供され、使用されるのかについて注意を払う必要があります。たとえば「Play.ht」は、月額わずか5ドルで利用できる下位APIプランを「Hacker Plan(ハッカープラン)」という名称で提供しています。この名称は耳を引く一方で、合成音声の不適切な利用リスクを考えると、懸念を呼び起こす可能性もあります。

* * *

一方で、「Resemble AI」のように、より慎重かつ責任ある姿勢でサービスを提供している企業も存在します。この企業は、カスタム音声生成、音声クローン、テキスト読み上げ機能に加え、ニューラル・ウォーターマーキングや、コンテンツの出所を証明するための標準規格である C2PA(Coalition for Content Provenance and Authenticity) に準拠することで、保護の仕組みを導入しています。これにより、音声クリップにメタデータを埋め込み、AIによって生成されたコンテンツであることを証明し、その出所を追跡するためのデジタル証明書を付与することが可能になります。

こうした対策があるにもかかわらず、ディープフェイク音声は依然として懸念材料となっています。というのも、ほとんどの音声合成サービスが多言語対応をしており、悪意のある利用者にとっては、非常に強力な詐欺ツールとなり得るためです。発音、イントネーション、感情表現まで細かく制御できる機能と組み合わせれば、異なる言語・文化圏を越えて、説得力と感情的な影響力を持つ音声クリップを作成することが可能になります。

さらに問題なのは、音声ディープフェイクの生成が非常に容易になってきている点です。現在では、多くのサービスが「ワンショット音声生成」に対応しており、わずか数秒の音声サンプルからでも、本人そっくりの音声を再現できてしまいます。

加えて、利用のハードルが驚くほど低いことも大きな問題です。確かに、最高品質の音声合成を求める場合は月額1,000ドル以上のコストがかかることもありますが、月額わずか5ドルからでも十分に実用的なレベルの音声出力を提供しているプラットフォームも多く存在しています。これにより、予算に関係なく、誰でもこうしたツールにアクセスできる状況が生まれています。表2では、市場で入手可能な音声ディープフェイク生成サービスの主な機能と価格を一覧にしています。なお、掲載されている価格は執筆時点での提供価格に基づいています。

ソーシャルメディアや動画コンテンツなどを通じて、音声クリップが大量に公開されている現状と、ディープフェイク音声の作成が極めて容易になっていることを踏まえると、音声なりすましの脅威をもはや軽視することはできません。

* * *

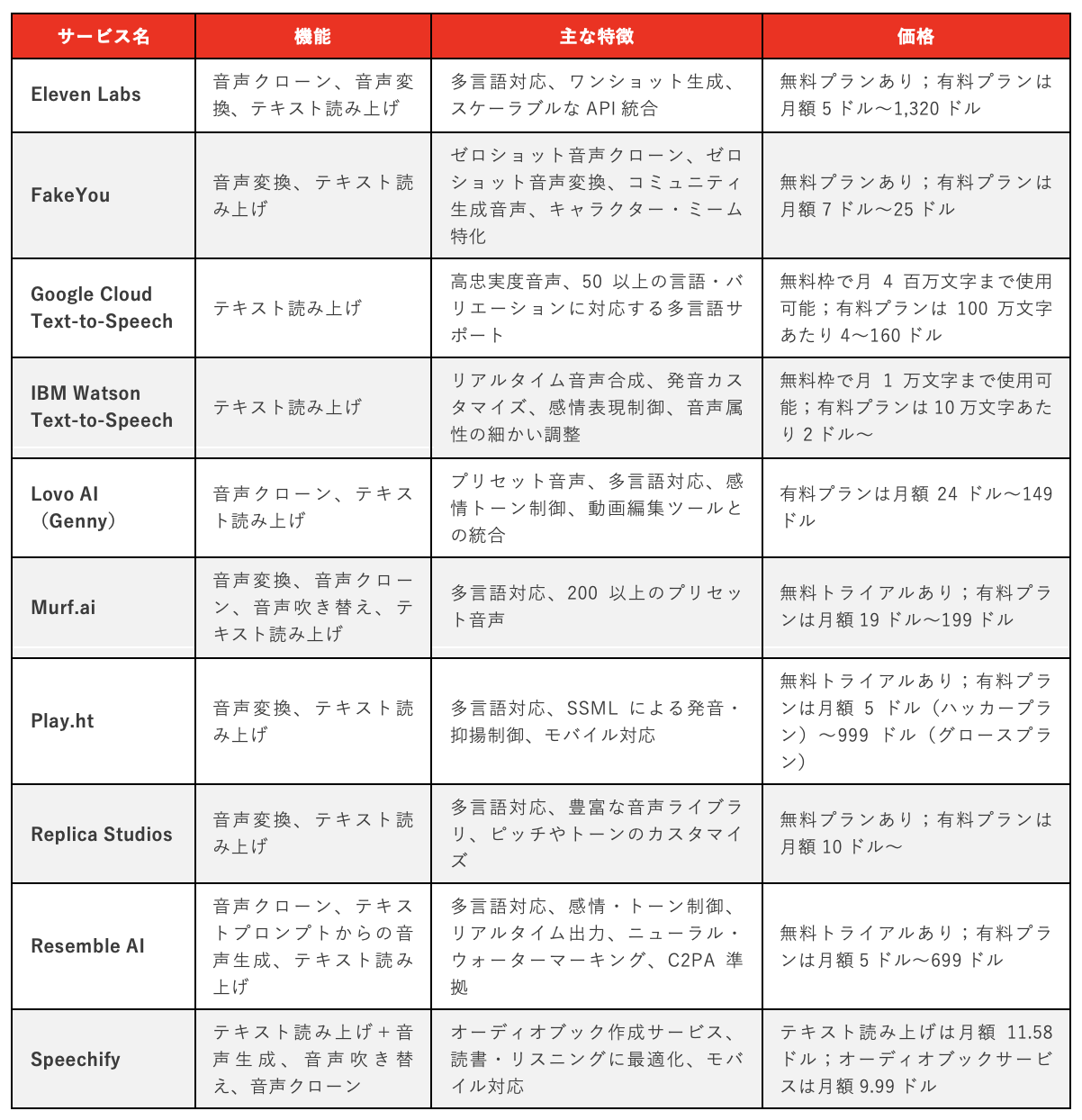

ディープフェイク動画

AIを活用した動画生成プラットフォームは急速に注目を集めており、プロフェッショナルな見た目の映像コンテンツを簡単に制作できるようになっています。しかし、この手軽さは同時に悪用のリスクも伴います。ごくわずかな労力や技術、資金で、誰でも信憑性の高い、かつ有害になりうる合成動画を作成できてしまうのです。

合成動画プラットフォームは、特にコンテンツ制作者にとって大きな変革をもたらしています。カメラの前に立つことに抵抗がある人や、映像制作の経験が乏しい人であっても、魅力的で高品質な動画を簡単に作れるようになっているためです。

* * *

たとえば「Argil AI」では、短いサンプル動画からユーザの動きや話し方を学習し、そのクローンを生成して、テキストから直接動画を作成することができます。これにより、カメラの前に立つ必要がまったくなくなり、コンテンツ制作においては非常に有用です。しかし、月額わずか39ドルのサブスクリプションで、悪意のあるユーザが他人のリアルな偽動画を簡単に生成できてしまうというリスクもあります。ボディランゲージを含めて完全にコントロールされた人物映像を作ることが可能となり、たとえば企業の経営者が虚偽の指示を出したり、不正行為に関与しているように見せかけたりする動画が作られれば、社会的信用や企業の安全保障に深刻な影響を与える可能性があります。

もう一つの例として「AI Studios」があります。これはYouTubeのようなプラットフォーム向けにコンテンツを制作するクリエイターを支援するスイートで、ドキュメントからの動画生成、アバター作成、音声クローン、AIによる吹き替えといったサービスを提供しています。特筆すべきはその価格の手頃さです。いずれのプラットフォームもフリーミアムモデルを採用しており、無料で始められる基本プランに加え、それぞれ月額19.99ドルと24.00ドルから利用可能な有料プランが用意されています。

合成動画プラットフォームは非常に直感的で使いやすくなっており、「Reface.ai」のようなモバイルアプリを使えば、GIFや短い動画内で簡単に顔を入れ替えることができます。そのままソーシャルメディアに直接投稿することも可能で、合成動画の作成はこれまでになく身近なものとなっています。一方で、「DeepFaceLab」や「Deepfake_tf」といったオープンソースの代替ツールも存在し、より高度かつ柔軟な合成動画生成が可能です。これらはディープラーニングのフレームワークを利用して動画内の顔を入れ替えるもので、たとえばGANやCNNといったニューラルネットワークを活用してリアルさや編集機能を高めています。これらは無料で使用できますが、一定の専門知識や高性能なハードウェアが求められます。ただし、それによって悪用のリスクがなくなるわけではなく、単に利用が悪意のある高度なスキルを持つユーザに限定されるだけに過ぎません。

「Vidnoz Face Swap」もまた、AIによる音声クローン、テキスト読み上げ、パーソナライズされたアバターによる動画生成に対応したプラットフォームの一つです。しかし、このサービスの提供範囲はそれだけにとどまりません。このプラットフォームでは、実在する写真からキスシーンの動画を作成したり、子どもを含むシミュレート映像を数クリックで生成したりと、倫理的に問題のあるコンテンツも容易に作成できるようになっています。

さらに、合成動画の生成における大きな障壁のひとつも取り除かれつつあります。かつては高品質な合成メディアを作るには高性能なシステムが必要不可欠でしたが、現在ではGPUクラスタを用いたクラウドベースのサービスの登場により、そのハードルは大きく下がっています。たとえば「Deepfakes Web」は、専用のコンピュータ環境を必要とせず、高性能なハードウェアや専門的な知識を持たないユーザでも、現実的で説得力のある合成動画を作成できるようにしています。

悪意ある目的で使われた場合に特に危険となる動画生成サービスのカテゴリも存在します。それは、リアルタイムでの映像操作を可能にするサービスです。「Avatarify」のようなプラットフォームでは、ビデオ通話中にリアルタイムで顔を入れ替えることができます。また、「Synthesia」や「HeyGen」のようなサービスでは、実際の映像と音声録音からインタラクティブなAIクローンを作成し、それをビデオ会議に参加させることが可能です。このようなツールが悪意ある手に渡れば、信頼されている人物になりすまして企業の会議に潜入したり、完全に架空の人物を作り出して組織に干渉したりすることも可能になります。こうしたサービスは、あらゆる予算帯に対応しています。フリーミアムモデルで提供されるプラットフォームもあれば、月額数百ドルを要する高価格帯のものも存在します。価格の高さが一部の悪意あるユーザにとって参入障壁となることもありますが、それは同時に高性能であることを意味し、その結果としてディープフェイクの見分けがさらに困難になる可能性もあります。

犯罪者にとっては、たとえ高額なサービスであっても、成功した攻撃によって得られるリターンと比較すればわずかな投資であり、十分に費用に見合う価値があると考えられています。表3では、AIによる動画コンテンツの生成が可能なサービスの一部を、機能と価格とともに紹介しています。記載されている価格は執筆時点での提供内容に基づいています。

* * *

AI生成画像

AIを活用した画像の加工技術は非常に高度かつ手軽になっており、もはや限られたスキルを持つ人や特定のコミュニティだけのものではなくなっています。現在では、静止画だけでなく、動画クリップやストリーミング映像に対しても顔の入れ替えが可能な、さまざまなディープフェイク画像生成サービスが存在しています。

「DeepSwap」はこうしたサービスのひとつであり、中でも静止画像に関しては特に高い品質を誇ります。表情や感情のバリエーション、カメラアングルや照明条件の違いといった難易度の高いシチュエーションにおいても、非常に自然で説得力のある画像を生成することが可能です。この技術は、悪意あるユーザの手に渡れば、実際には存在しない状況に他人を置いたかのような画像を作成したり、デジタル文書に別人の顔を合成したりといった形で、偽情報の拡散や詐欺に利用される危険性があります。

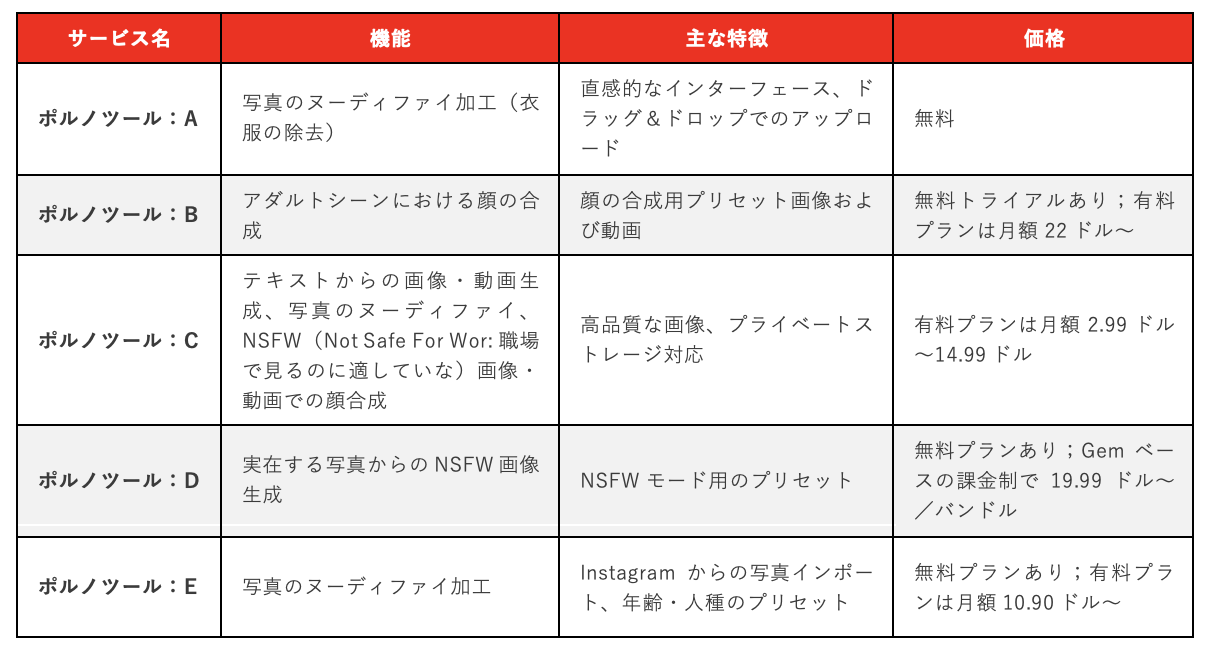

企業環境では比較的関係が薄いかもしれませんが、AI生成画像の中でも特に深刻な問題として議論されるべきなのが、いわゆる「ディープヌード」です。最近では、写真の人物の服をデジタル的に脱がせる「ポルノ」系のサービスが登場しており、その代表例が「ポルノツール:A」や「ポルノツール:E」です。これらはヌード生成を目的に開発された独自エンジンを使用しており、「ポルノツール:E」ではInstagramから直接画像をアップロードして加工することさえ可能です。「ポルノツール:D」や「ポルノツール:B」はさらに一歩踏み込み、前者は実在する写真からポルノ画像を生成でき、後者は特定のポルノ映像に他人の顔を合成する機能を提供しています。

* * *

多くのプラットフォームでは、倫理的な免責事項や利用上の注意喚起がウェブサイト上に掲載されていますが、そうした警告が悪用を抑止する効果は限定的であると言わざるを得ません。誰でも、他人のソーシャルメディアに投稿された写真を簡単に取得し、それをこれらのプラットフォームにアップロードして、恐喝、侮辱、あるいは嫌がらせの手段として利用することができてしまいます。その結果は、単なる評判の失墜にとどまらず、被害者のアイデンティティや信念を深く揺るがし、精神的な健康を著しく損なうなど、深刻な心理的影響を引き起こす恐れがあります。

特に懸念されるのは、これらのサービスのアクセスのしやすさです。多くのプラットフォームが無料トライアルや機能制限付きの無料プランを提供しており、有料プランであっても月額9.99ドルから22ドル程度と比較的安価です。これらのツールが進化し続け、ますます利用しやすくなるにつれて、個人による悪用や被害の可能性も比例して拡大していくでしょう。ほんの数クリックで写真を“武器化”できてしまう現実において、そのリスクはもはや無視できないものとなっています。表4では、画像をヌード体に合成する機能や、性的コンテンツの生成を可能にするサービスの一例を、機能と価格情報とともに紹介しています。記載されている価格は執筆時点での提供内容に基づいています。

アンダーグラウンド市場におけるディープフェイクの議論

ディープフェイク画像、音声、動画、そして動画ストリーミングを活用した犯罪ビジネスの計画は、比較的少ないスキルと資金で詐欺やその他の犯罪行為を洗練・高度化するため、サイバー犯罪の手段として非常に理想的です。合成メディア生成サービスは操作が簡単で、すでにインターネット上には高品質なフェイクを非常に安価に作成できるツールが多数出回っています。

2024年に実施したアンダーグラウンド市場の調査では、過去に確認していた犯罪用ディープフェイク生成ツールのいくつかが、すでに使われなくなっていました。これは、汎用のディープフェイク作成ソフトウェアが広く普及したことにより、犯罪専用のツールが時代遅れになったことが一因と考えられます。2025年の観察では、悪意あるアクターたちはすでに、こうした汎用かつ広く入手可能なディープフェイク作成ソフトウェアを好んで使おうとしており、それを用いた犯罪手法について議論を交わしていることが確認されています。また、インターネット上のオープンソース/クローズドソースのツールを活用して犯罪目的を達成するための、ディープフェイク作成チュートリアルやプレイブックも共有されています。

2024年11月には、ある犯罪フォーラム上で「Deep-Live-Cam」という無料のオープンソースツールを使った動画ディープフェイクの作成方法を紹介するプレイブックが投稿されているのを確認しました。このツールは、マルチメディアライブラリとしてffmpegを使用し、Visual Studioでソースコードをコンパイルして動作します。チュートリアルは技術的かつ詳細に書かれており、読者が手順に従えば誰でも無料でディープフェイク動画を作成できる内容となっています。また、動画ストリーミング用のドライバーであるOpen Broadcaster Software(OBS)を使って、カメラ映像上にディープフェイクを重ね、自身の顔を偽装する方法まで含まれています。

2024年12月初旬、ある犯罪者が地下フォーラム上で、暗号資産取引所、出会い系および金融アプリ、オンラインカジノなどでのKYC認証を通過するためのチュートリアルとプレイブックを提供していました。このサイバー犯罪者によるチュートリアルには、以下の内容が含まれていたとされています:

- ウェブブラウザまたは専用アプリケーションを使ってKYCチェックおよび本人確認サービスを回避するための詳細なマニュアル。構成ファイル、テキストによるチュートリアル、学習教材、動画が含まれていました。

- VcamPro(別名 Vcam)というAndroid用の仮想カメラアプリのライセンス付きバージョン。

- iOS 15および16向けの偽のiPhoneカメラアプリ。

- Windows OS専用で、GeForce RTX 2070以上のグラフィックスカードを必要とするディープフェイク動画作成用の非公開ツール。

- OBSおよびOBS Studioを使った動画録画およびライブ配信の設定サービス。

- 顧客が提供するアカウントのKYC認証を回避するための設定サービスおよびアドバイス。

さらに2025年1月には、別の人物がKYCチェックの突破を目的としたディープフェイク画像の作成を、オンデマンドサービスとして提供していました。この人物は自身の使用するツールキットを共有し、オープンソースの「DeepFaceLive」と「DeepFaceLab」、さらに音声クローンツール「AI Voice Changer」を使用していると述べていました。また、この人物は、2つの異なる暗号資産取引所でKYCチェックの回避に成功したことも明かしていました。

現在までの観察では、ディープフェイク生成の最大の用途はKYC(顧客確認)回避であると見られています。これは、サイバー犯罪者にとって匿名の暗号資産取引所アカウントを開設し、資金洗浄に利用できる点が魅力的だからだと考えられます。

また、ここ数か月の間に、ディープフェイクを使った詐欺を専門とする犯罪グループが法執行機関によって摘発される事例も確認されています。2024年10月には、香港警察が、ディープフェイクによるロマンス詐欺に特化した27人のグループを逮捕しました。さらに2025年には、スペイン警察が、国内の有名人のディープフェイク映像を使った広告を用い、世界的な投資詐欺を展開していた6人のグループを摘発しています。ディープフェイクを活用した詐欺は、犯罪の世界で急速に流行しつつあり、その動きは加速しているように見えます。

この現状は、こうしたプラットフォームを開発・運営する企業に対して、適切な安全対策を講じる責任を突きつけるものです。たとえば、ユーザの身元確認、他人の肖像を使用する際の利用目的の申告、リアルタイムでのプロンプト内容のフィルタリング、生成されたAIメディアへのフィンガープリント情報の埋め込みなどは、悪用防止に有効な手段の一部です。あわせて、プラットフォーム側のポリシーに違反する出力をブロックし、サーバ側で包括的なログを保持することも、悪用時の証拠追跡を可能にする上で重要です。

一部のプラットフォームでは、生成コンテンツに透かしを入れるといった安全対策が導入されていますが、実際には有料プランにアップグレードするとこうした透かしが自動的に削除されるケースも少なくありません。つまり、金銭を支払うことで、埋め込まれた識別情報のない合成メディアを自由に生成できてしまうのです。これは、コンテンツが本物か偽物かを見分けるために残された数少ない信頼できる手段の一つを失うことを意味しており、特にAI生成コンテンツが人を傷つけたり搾取したりする目的で使われる場合には、深刻な問題となります。

結論

ディープフェイク技術は、これまでになく手軽かつ安価に利用できるようになっており、今後さらに低価格化・高性能化が進んでいくことは確実です。しかし残念ながら、それに伴ってこの技術に関連するリスクも急速に拡大しています。企業スパイ行為から個人情報の窃取、金融詐欺、個人への恐喝に至るまで、企業と個人の双方が脅威にさらされています。

さらに深刻なのは、サイバー犯罪者が正規の、安価で使いやすいサービスを積極的に悪用している点です。悪意あるアクターたちはこれらのツールの使い方を熟知しているだけでなく、地下フォーラムでノウハウを共有し合い、手口を洗練させることで、他の犯罪者たちがこの技術を悪用するハードルをますます下げています。

プラットフォーム提供者に対し、ツールの悪用を防ぐための対策を講じるよう提言はしてきましたが、重要なのは、ディープフェイク技術がすでに広く拡散してしまっているという現実を直視することです。仮に一つのサービス提供者が適切な対応を怠っただけでも、その影響は重大で、場合によっては取り返しのつかない事態を招く恐れがあります。

理想的には、AI生成メディアが広がるにつれて、その悪用の可能性やそれに伴う危険性について、社会全体の認識も高まっていくはずです。しかし、この「認識の広がり」は、同時により深く、より根本的な脅威も招きます。それは「信頼の喪失」です。ディープフェイクが広く普及することで、現実と虚構の境界線が曖昧になり、私たちが見たり聞いたりするものに対する信頼が揺らぎ、世界についての知識を築く基盤そのものが侵食されてしまうのです。

つまり、今後はあらゆるコンテンツが「初めから偽物かもしれない」と考えるべき時代に入るということです。これまでの「信じるが、確認もする(trust but verify)」という姿勢では、もはや十分ではなくなりつつあります。言い換えれば、私たちは「目や耳で得た情報を基本的に信じる世界」から、「まず疑い、証明されたものだけを信じるゼロトラスト(zero-trust)の世界」へと移行しつつあるのです。そこでは、すべてのコンテンツが本物であることを証明しなければならず、そうでないものは疑わしいものとして扱われます。

このように、単に「AIによって作られたかもしれない」と認識するだけでは、もはや十分ではありません。信頼が失われるなかで、人々は本物のコンテンツや正当なコミュニケーションすらも疑い、無視するようになってしまう可能性があります。自分自身を守るためには、ディープフェイクを検出するためのツールを積極的に導入し、活用していくことが求められています。

Trend Vision One™ AI Security は、AI生成コンテンツを検出するための高度なディープフェイク検出技術を備えています。画像のノイズ解析や色彩検出といった従来の手法に加え、ユーザの行動特性の分析も組み合わせることで、より強力なディープフェイク対策を実現しています。疑わしいコンテンツが検出されると、Trendはただちに企業のセキュリティチームにアラートを送信し、それによりチームは学習と啓発、そして今後の攻撃を未然に防ぐための積極的な対策を講じることができます。また、この技術はライブビデオ通話において、相手がディープフェイク技術を使用していないかを確認する手段としても活用でき、ユーザに対して「目の前にいる人物が実際には別人である可能性」を警告することが可能です。これらの機能は、個人ユーザ向けにも Trend Micro Deepfake Inspector にて利用可能です。

もちろん、こうしたソリューションも完全ではありませんが、ディープフェイク攻撃の難易度を高め、攻撃の成功率を下げるという意味では非常に有効です。そして時間とともに、デジタルコンテンツへの信頼を回復する手助けとなるでしょう。すべての人が完全に守られるわけではありませんが、誰もが被害者になる必要もないのです。

参考記事:

Deepfake It Till You Make It: A Comprehensive View of the New AI Criminal Toolset

By David Sancho, Salvatore Gariuolo, Vincenzo Ciancaglini

翻訳:与那城 務(Platform Marketing, Trend Micro™ Research)