Bezpieczeństwo AI obejmuje zarówno ochronę technologii sztucznej inteligencji, jak i jej wykorzystanie do wzmacniania cyberbezpieczeństwa – poprzez lepsze wykrywanie luk i proaktywne reagowanie na zagrożenia.

Spis treści

AI Security

Termin „sztuczna inteligencja” (AI) został po raz pierwszy użyty w latach 50. w celu opisania komputerów i maszyn, które naśladują strukturę i funkcje ludzkiego mózgu, aby wykonywać skomplikowane zadania, rozwiązywać złożone problemy, przewidywać przyszłe wyniki i wyciągać wnioski z doświadczenia.

AI security (zwane również bezpieczeństwem opartym na sztucznej inteligencji lub „bezpieczeństwem dla sztucznej inteligencji”) to dziedzina cyberbezpieczeństwa, która obejmuje wszystkie procesy, praktyki i środki stosowane przez organizacje w celu zabezpieczenia swoich pakietów sztucznej inteligencji oraz ochrony systemów, danych i aplikacji opartych na sztucznej inteligencji przed potencjalnymi zagrożeniami. Obejmuje to wykorzystanie narzędzi i technologii opartych na sztucznej inteligencji do:

- Zabezpieczenia każdego aspektu sieci AI organizacji od punktów końcowych po modele AI

- Ochrony modeli, systemów i aplikacji sztucznej inteligencji przed szeroką gamą cyberzagrożeń, cyberprzestępców i cyberataków.

- Identyfikacji i ograniczania wszelkich luk lub słabych punktów w zabezpieczeniach AI i cyberbezpieczeństwie, zanim zostaną one wykorzystane.

- Ochrony infrastruktury sztucznej inteligencji i danych szkoleniowych, aby zapobiec uszkodzeniu, zanieczyszczeniu lub kradzieży danych modeli sztucznej inteligencji.

- Zapewnienia jakości i integralności danych w dużych modelach językowych AI (LLM), silnikach generatywnej sztucznej inteligencji (GenAI) oraz procesach głębokiego uczenia się i uczenia maszynowego (ML).

- Rozwiązania potencjalnych problemów etycznych i wątpliwości związanych z kwestiami stronniczości, przejrzystości, prywatności danych i możliwości wyjaśnienia.

- Zapewnienia pełnej zgodności wszystkich zastosowań sztucznej inteligencji danych i rozwoju z odpowiednimi przepisami prawa, polityką firmy i regulacjami branżowymi.

Bezpieczeństwo AI a cyberbezpieczeństwo oparte na AI

Choć oba terminy brzmią niemal identycznie, istnieje istotna różnica między bezpieczeństwem AI a cyberbezpieczeństwem opartym na AI.

Bezpieczeństwo AI polega na zabezpieczeniu samej sztucznej inteligencji — ochronie pakietu sztucznej inteligencji organizacji i zabezpieczeniu jej systemów, komponentów, sieci i aplikacji.

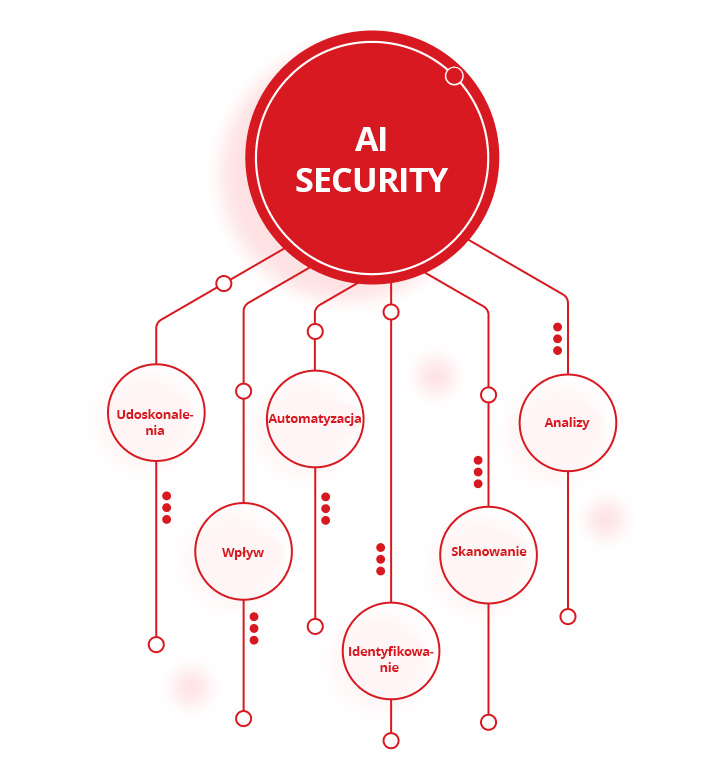

Cyberbezpieczeństwo oparte na AI (zwane również „AI for security”) polega na wykorzystywaniu narzędzi i technologii AI do ochrony infrastruktury IT przed cyberprzestępcami, cyberatakami i innymi zagrożeniami cybernetycznymi. Obejmuje to wykorzystanie sztucznej inteligencji do:

- Analizy duże ilości danych w celu wykrywania wzorców, identyfikowania anomalii i wskazywania potencjalnych zagrożeń dla bezpieczeństwa

- Skanowania i eliminacji podatności i luk w zabezpieczeniach cyberbezpieczeństwa organizacji

- Identyfikowania i ochrony przed naruszeniami bezpieczeństwa danych i innymi cyberatakami w czasie rzeczywistym

- Automatyzacji narzędzia do wykrywania zagrożeń i reagowania, aby zmniejszyć zapotrzebowanie zespołów ds. bezpieczeństwa oraz poprawić szybkość i dokładność cyberochrony

- Wykorzystania najnowszych informacje o zagrożeniach , aby wyprzedzić przestępców i być na bieżąco z nowymi lub powstającymi wektorami ataku

- Udoskonalenia ogólnych strategii i możliwości zarządzania cyberzagrożeniami organizacji

Znaczenie zabezpieczania systemów AI

Chociaż idea sztucznej inteligencji istnieje już od dziesięcioleci, ostatnie postępy w technologii sztucznej inteligencji zmieniły branże, od transportu i opieki zdrowotnej po cyberbezpieczeństwo. Niestety, powszechna implementacja sztucznej inteligencji umożliwiła przestępcom jej wykorzystanie, co doprowadziło do znacznego wzrostu liczby, zakresu i wyrafinowania cyberataków.

W rezultacie organizacje muszą upewnić się, że robią wszystko, co w ich mocy, aby zachować integralność, poufność i dostępność swoich danych AI, chronić narzędzia i aplikacje AI przed nowymi i powstającymi zagrożeniami cybernetycznymi i cyberatakami oraz chronić modele, systemy i algorytmy AI przed szeroką gamą stale zmieniających się zagrożeń cybernetycznych.

Brak zabezpieczenia systemów sztucznej inteligencji przed którymkolwiek z tych zagrożeń może potencjalnie narazić organizację na atak, zagrozić jej klientom i partnerom oraz spowodować straty rzędu milionów dolarów w postaci kosztów naprawy, żądań okupu, utraty sprzedaży i spadku wydajności.

Jakie są zagrożenia dla bezpieczeństwa AI?

Potencjał sztucznej inteligencji do zrewolucjonizowania branży cyberbezpieczeństwa jest wyraźnie obiecujący. Istnieje jednak coraz więcej zagrożeń i wyzwań związanych z bezpieczeństwem AI, które organizacje muszą wziąć pod uwagę przy wdrażaniu skutecznej strategii bezpieczeństwa AI. Oto one:

- Ryzyko zwiększenia powierzchni ataku — integracja własnych i zewnętrznych modeli sztucznej inteligencji z infrastrukturą IT organizacji może znacznie zwiększyć powierzchnię ataku, zwiększyć liczbę słabych punktów, które mogą wykorzystać przestępcy, i pozostawić systemy sztucznej inteligencji narażone na potężniejsze lub częstsze cyberataki.

- Ryzyko złośliwych lub wrogich ataków na dane i algorytmy sztucznej inteligencji — hakerzy mogą uzyskać nieuprawniony dostęp do narzędzi i danych sztucznej inteligencji, manipulować danymi i algorytmami sztucznej inteligencji w celu wprowadzenia luk lub stronniczości, zagrozić zdolności modeli sztucznej inteligencji do dokonywania dokładnych prognoz lub obrony przed przyszłymi atakami oraz manipulować, nadużywać lub kraść modele i algorytmy sztucznej inteligencji.

- Ryzyko zatrucia danych, korupcji i manipulacji — cyberprzestępcy mogą uszkodzić procesy uczenia maszynowego (ML) lub „truć” modele AI, celowo zmieniając swoje dane wejściowe lub wstawiając nowe dane samodzielnie, aby naruszyć bezpieczeństwo narzędzi i systemów AI.

- Zagrożenia dla modeli szkoleniowych AI — cyberprzestępcy mogą wykradać, manipulować lub odwrócić zastrzeżone modele szkoleniowe AI. Mogą również uszkodzić, naruszyć lub manipulować danymi wykorzystywanymi do opracowywania i szkolenia modeli AI w celu naruszenia ich dokładności, skuteczności i integralności.

- Ryzyko uprzedzeń, dyskryminacji, prywatności danych i braku przejrzystości — ludzkie błędy i cyberataki mogą zwiększyć obawy o prywatność danych i uprzedzenia w modelach AI oraz potencjalnie naruszyć zasady przejrzystości, uczciwości i odpowiedzialności.

- Ryzyko nieprzestrzegania przepisów branżowych i rządowych — brak ochrony danych wrażliwych, osobistych lub poufnych może skutkować surowymi karami i zarzutami nieprzestrzegania przepisów zarówno przez organy rządowe, jak i branżowe, w tym przez ogólne rozporządzenie o ochronie danych (RODO).

- Ryzyko ataków na dostawców zewnętrznych — atakujący mogą atakować systemy AI w dowolnym miejscu łańcucha dostaw organizacji, aby wykorzystać słabe strony sieci, komponentów, ram i bibliotek oprogramowania partnerów zewnętrznych, a następnie wykorzystać te luki do atakowania innych modeli AI w dowolnym miejscu łańcucha.

- Ryzyko związane z rozbieżnością i degradacją modeli AI — z biegiem czasu wszystkie modele sztucznej inteligencji mogą być podatne na rozbieżności lub degradację. Hakerzy mogą wykorzystać uszkodzone lub nieprawidłowo działające modele sztucznej inteligencji, aby zmienić ich zachowanie lub wpłynąć na ich dokładność i niezawodność.

- Ryzyko kradzieży danych uwierzytelniających chatbota — cyberprzestępcy mogą ukraść dane uwierzytelniające chatbota dla dostawców sztucznej inteligencji, takich jak ChatGPT, lub kupić skradzione dane uwierzytelniające w cdark webie i wykorzystać je do uzyskania nielegalnego dostępu do zastrzeżonych narzędzi i systemów sztucznej inteligencji.

- Ryzyko związane z fałszywymi zdjęciami, filmami i dźwiękiem — hakerzy mogą wykorzystywać generowane przez sztuczną inteligencję fałszywe obrazy i filmy do oszukiwania organizacji, wymuszania okupu od osób fizycznych lub firm, nakłaniania pracowników do udzielania dostępu do krytycznych systemów, ujawniania poufnych informacji lub kradzieży cennych danych.

- Ryzyko bezpośrednich i pośrednich ataków typu prompt injection — ataki typu prompt injection mogą wykorzystywać złośliwy kod do nakłonienia dużych modeli językowych (LLM) i innych narzędzi sztucznej inteligencji do ujawnienia poufnych informacji, umożliwienia nieautoryzowanego dostępu lub usunięcia kluczowych dokumentów.

- Ryzyko nadużycia halucynacji AI inteligencję — hakerzy mogą wykorzystać powszechne „halucynacje” AI, aby celowo naruszyć dane, na których opierają się modele AI, oraz podejmowane przez nie decyzje.

- Zagrożenia dla zasobów i infrastruktury chmury — cyberprzestępcy mogą włamać się do opartych na chmurze modeli sztucznej inteligencji i uszkodzić lub ukraść swoje dane i inne zasoby.

Jeśli organizacje nie zadbają o to, aby ich zabezpieczenia AI i cyberbezpieczeństwa były jak najbardziej solidne, kompleksowe i aktualne, złoczyńcy mogą wykorzystać te i inne zagrożenia, aby podważyć skuteczność i niezawodność modeli AI, wykraść poufne lub prywatne dane i potencjalnie spowodować znaczne szkody finansowe i reputacyjne.

Jakie są korzyści z bezpieczeństwa AI?

Organizacje, które wdrażają środki bezpieczeństwa AI w celu zabezpieczenia swoich rozwiązań AI, czerpią korzyści z wielu istotnych zalet. Należą do nich zwiększone możliwości:

- Ochrony danych AI przed atakami, uszkodzeniem, manipulacją, naruszeniem lub kradzieżą

- Zabezpieczenia modeli sztucznej inteligencji przed atakami hakerskimi i cyberatakami, uruchamiając narzędzia i technologie wykrywania i reagowania na zagrożenia w czasie rzeczywistym, wyszukiwania zagrożeń oraz skanowania luk w zabezpieczeniach

- Ochrony infrastruktury sztucznej inteligencji, aktywnie eliminując słabe punkty lub luki w zabezpieczeniach cyberochrony, zarządzając ryzykiem cybernetycznym i ograniczając je oraz chroniąc zasoby sztucznej inteligencji

- Zabezpieczenia użytkowników sztucznej inteligencji i aplikacji lokalnych przed atakami złośliwego kodu, nielegalnym lub nieautoryzowanym dostępem, oszustwami i phishingiem oraz złośliwym oprogramowaniem i ransomware

- Kontroli dostępu do prywatnych i publicznych usług AI, w tym aplikacji modelu wielkojęzycznego (LLM)

- Ochrony przed atakami typu zero-day, które są ukierunkowane na nieznane wcześniej luki w zabezpieczeniach oprogramowania lub sprzętu, aby umożliwić przestępcom kradzież danych, naruszenie informacji poufnych, zainstalowanie złośliwego oprogramowania i innych wirusów lub uzyskanie dostępu do infrastruktury IT organizacji

Najlepsze praktyki w zakresie bezpieczeństwa AI

Najskuteczniejsze rozwiązania z zakresu bezpieczeństwa sztucznej inteligencji są zgodne z wieloma najlepszymi praktykami branżowymi, aby chronić narzędzia i zasoby sztucznej inteligencji oraz poprawiać ich stan bezpieczeństwa. Praktyki te obejmują:

- Opracowanie kompleksowej strategii bezpieczeństwa AI, która łączy zaawansowane modelowanie zagrożeń i działania związane z wyszukiwaniem zagrożeń z funkcjami oceny ryzyka opartymi na sztucznej inteligencji, kompleksowymi mechanizmami kontroli bezpieczeństwa AI oraz szczegółowymi planami i procedurami reagowania na incydenty w celu ochrony systemów i danych AI organizacji.

- Zapewnienie jakości, integralności i niezawodności danych szkoleniowych AI w celu rozwiązania problemów związanych z przejrzystością, uprzedzeniami i łatwością wyjaśniania oraz zapewnienie jak najdokładniejszych i skutecznych modeli AI.

- Wdrażanie standardowych ram bezpieczeństwa AI w celu ustanowienia jasnego zestawu standardów i wytycznych dotyczących zabezpieczania systemów AI, eliminowania słabych punktów lub luk w zabezpieczeniach AI oraz utrzymywania zgodności ze wszystkimi odpowiednimi przepisami dotyczącymi bezpieczeństwa AI. Obejmuje to integrację struktur bezpieczeństwa, takich jak struktury zarządzania ryzykiem sztucznej inteligencji (National Institute of Standards and Technology, NIST), MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) i Sensible Regulatory Framework for AI Security, Lista Open Worldwide Application Security Project (OWASP) obejmująca 10 najlepszych praktyk w zakresie zastosowań modelu wielkojęzycznego (LLM), Google Secure AI Framework (SAIF), oraz normy ISO/IEC 27001 dotyczące systemów zarządzania bezpieczeństwem informacji (ISMS).

- Integracja zabezpieczeń AI z istniejącymi środkami bezpieczeństwa i cyberbezpieczeństwa w celu zapewnienia bezproblemowej, kompleksowej ochrony przed cyberzagrożeniami dla wszystkich aplikacji, narzędzi, systemów i sieci AI i IT.

- Prowadzenie regularnych szkoleń i programów uświadamiających dla pracowników, aby zwiększać świadomość na temat najnowszych zagrożeń i środków bezpieczeństwa zarówno wśród zespołów ds. cyberbezpieczeństwa, jak i innych pracowników, a także promowanie kultury korporacyjnej opartej na ciągłym doskonaleniu.

- Ciągłe monitorowanie, ocena i aktualizacja modeli sztucznej inteligencji w celu wykrywania i ograniczania luk w zabezpieczeniach narzędzi i systemów sztucznej inteligencji, identyfikowania pojawiających się zagrożeń w momencie ich wystąpienia oraz ciągłego udoskonalania modeli i aplikacji sztucznej inteligencji w celu poprawy ich dokładności, wydajności i niezawodności.

Przykłady zastosowań cyberbezpieczeństwa opartego na sztucznej inteligencji

W miarę jak narzędzia sztucznej inteligencji stają się coraz bardziej zaawansowane, potencjalne zastosowania i aplikacje sztucznej inteligencji w cyberbezpieczeństwie rosną niemal codziennie.

Aplikacje cyberbezpieczeństwa oparte na sztucznej inteligencji mogą między innymi znacznie zwiększyć zasięg i skuteczność zabezpieczeń cybernetycznych organizacji, automatyzując działania związane z wykrywaniem zagrożeń i reagowaniem na incydenty , regularnie i na bieżąco przeprowadzając skanowanie luk bezpieczeństwa i inne proaktywne środki oraz wykorzystując najnowsze analizy zagrożeń i analizy bezpieczeństwa do przewidywania, zapobiegania i ochrony organizacji przed nowymi i powstającymi zagrożeniami cybernetycznymi.

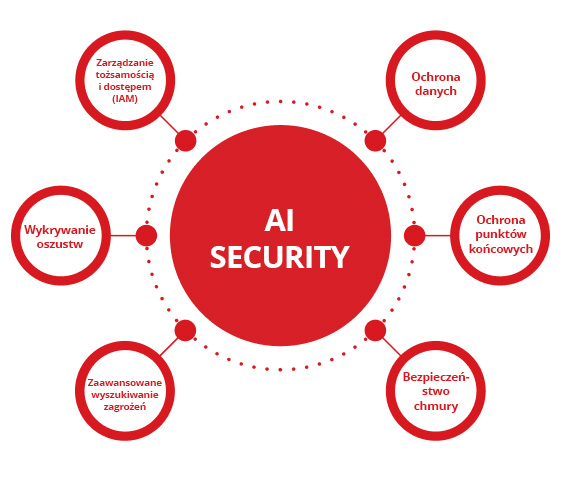

Niektóre z najbardziej skutecznych i powszechnie stosowanych aplikacji cyberbezpieczeństwa AI obejmują wykorzystanie sztucznej inteligencji w ochronie danych, bezpieczeństwie punktów końcowych, bezpieczeństwie chmury, zaawansowanym poszukiwaniu zagrożeń, wykrywaniu oszustw oraz zarządzaniu tożsamością i dostępem (IAM).

Ochrona danych

Organizacje mogą wykorzystywać sztuczną inteligencję do klasyfikowania i szyfrowania poufnych lub wrażliwych informacji, monitorowania dostępu do systemów w celu szybszego i dokładniejszego wykrywania naruszeń bezpieczeństwa danych, ochrony danych sztucznej inteligencji przed utratą lub uszkodzeniem oraz zabezpieczenia swoich zasobów sztucznej inteligencji przed nieuprawnionym dostępem, wykorzystaniem lub ujawnieniem. Jednakże luki w zabezpieczeniach informacji wrażliwych w środowiskach AI mogą prowadzić do poważnych naruszeń bezpieczeństwa danych i problemów związanych z przestrzeganiem przepisów, dlatego tak ważne jest proaktywne identyfikowanie i ograniczanie tych słabych punktów.

Ochrona punktów końcowych

Rozwiązania EDR (Endpoint Detection and Response) oparte na sztucznej inteligencji mogą pomóc w ochronie laptopów, komputerów stacjonarnych, serwerów komputerowych, urządzeń mobilnych i innych punktów końcowych sieci w czasie rzeczywistym poprzez proaktywne wykrywanie i blokowanie złośliwego oprogramowania, oprogramowania ransomware i innych cyberataków, zanim jeszcze do nich dojdzie.

Bezpieczeństwo chmury

Technologie bezpieczeństwa chmury oparte na sztucznej inteligencji mogą monitorować i kontrolować dostęp do środowisk chmury przez całą dobę, identyfikować wszelkie nieprawidłowości lub podejrzane działania, ostrzegać zespoły ds. bezpieczeństwa o potencjalnych zagrożeniach w momencie ich wystąpienia oraz chronić dane i aplikacje w chmurze przed nieautoryzowanym dostępem i naruszeniami bezpieczeństwa danych.

Zaawansowane wyszukiwanie zagrożeń

Zaawansowane narzędzia do wykrywania zagrożeń oparte na sztucznej inteligencji mogą szybko i łatwo analizować dzienniki danych, wzorce ruchu sieciowego oraz działania i zachowania użytkowników w celu wykrywania złośliwych ataków, zatrzymania cyberprzestępców w trakcie działania, zanim spowodują trwałe szkody, oraz ochrony systemów i infrastruktury AI przed zaawansowanymi, uporczywymi zagrożeniami (APT) i innymi cyberatakami.

Wykrywanie oszustw

Organizacje z branży bankowej i usług finansowych mogą wykorzystywać algorytmy uczenia maszynowego (ML), sieci neuronowe i inne zaawansowane technologie sztucznej inteligencji do wykrywania potencjalnych oszustw, blokowania nieautoryzowanego dostępu do kont bankowych lub innych kont internetowych oraz zapobiegania kradzieży tożsamości w transakcjach finansowych i e-commerce.

Zarządzanie tożsamością i dostępem (IAM)

Rozwiązania do zarządzania tożsamością i dostępem (IAM) oparte na sztucznej inteligencji mogą pomóc organizacjom monitorować i zabezpieczać każdy etap procesów uwierzytelniania, autoryzacji i zarządzania dostępem, aby zapewnić zgodność z polityką firmy i procedurami dotyczącymi sztucznej inteligencji, zachować zgodność z przepisami branżowymi, zapobiegać nieuprawnionemu dostępowi do poufnych danych i chronić systemy przed atakami hakerów.

Gdzie mogę uzyskać pomoc w zakresie bezpieczeństwa AI?

Trend Vision One™ to kompleksowa platforma oparta na sztucznej inteligencji i cyberbezpieczeństwie.

Trend Vision One oferuje zaawansowany zestaw wiodących w branży narzędzi i technologii sztucznej inteligencji, które wykrywają, przewidują i zapobiegają zagrożeniom cybernetycznym znacznie szybciej i skuteczniej niż tradycyjne zespoły ds. bezpieczeństwa prowadzone przez człowieka. Skuteczna ochrona pakietów AI wymaga ochrony każdej warstwy, od danych po infrastrukturę i użytkowników, poprzez zapewnienie widoczności wdrożeń AI typu shadow, egzekwowanie ścisłych kontroli dostępu w celu zapewnienia zgodności oraz ustanowienie zabezpieczeń dla interfejsów API AI, aby zapobiec nadużyciom i zatruciu modeli. Te możliwości pozwalają organizacjom zabezpieczyć cały swój stos AI i chronić dane, aplikacje i systemy AI przed większością cyberataków, zanim jeszcze do nich dojdzie.

Trend Vision One zawiera również niezrównane możliwości oparte na sztucznej inteligencji Trend Cybertron: pierwszego na świecie prawdziwie proaktywnego rozwiązania AI w zakresie cyberbezpieczeństwa. Korzystając ze sprawdzonego zbioru dużych modeli językowych (LLM) firmy Trend Micro, zestawów danych, zaawansowanych agentów AI oraz ponad 20 lat inwestycji w dziedzinie bezpieczeństwa AI, Trend Cybertron może analizować historyczne wzorce i dane w celu przewidywania ataków specyficznych dla każdego klienta, umożliwiając organizacjom osiągnięcie czasu naprawy o 99% szybszego niż w przypadku tradycyjnej reakcji na incydenty oraz praktycznie z dnia na dzień przekształcić działania organizacji w zakresie bezpieczeństwa z reaktywnych w proaktywne.

Trend Cybertron został również zaprojektowany tak, aby nieustannie ewoluować i dostosowywać się do zmieniających się potrzeb organizacji oraz być na bieżąco z najnowszymi taktykami, technikami i procedurami (TTP) stosowanymi przez cyberprzestępców. Dzięki temu organizacje mogą mieć pewność, że zarówno zabezpieczenia AI, jak i cyberbezpieczeństwo AI są zawsze tak solidne, kompletne i aktualne, jak to tylko możliwe.

Michael Habibi jest liderem w dziedzinie cyberbezpieczeństwa z ponad 12-letnim doświadczeniem, specjalizującym się w rozwoju produktów i innowacjach strategicznych. Jako wiceprezes ds. zarządzania produktami w firmie Trend Micro, Michael kieruje dostosowywaniem strategii produktów dla punktów końcowych do szybko zmieniającego się środowiska zagrożeń.

Często zadawane pytania (FAQ)

Czym jest bezpieczeństwo AI?

Zabezpieczenie AI (lub „bezpieczeństwo AI”) to wykorzystanie różnych narzędzi, praktyk i technologii w celu zabezpieczenia pakietu AI w organizacji.

Co oznacza AI w bezpieczeństwie?

AI odnosi się do „sztucznej inteligencji”. Sztuczna inteligencja jest wykorzystywana w dziedzinie bezpieczeństwa w celu poprawy cyberochrony organizacji i ochrony pakietów AI.

Jak AI może być wykorzystywana w bezpieczeństwie?

AI może być wykorzystywana do ochrony sieci, modeli, systemów, punktów końcowych i aplikacji przed cyberatakami, uszkodzeniem danych i innymi zagrożeniami.

Czym jest AI w dziedzinie cyberbezpieczeństwa?

Sztuczna inteligencja w cyberbezpieczeństwie odnosi się do wykorzystania narzędzi i technologii AI w celu ochrony organizacji przed cyberatakami.

Czy sztuczna inteligencja stanowi zagrożenie dla bezpieczeństwa?

Jak każda technologia, sztuczna inteligencja może być wykorzystywana zarówno do poprawy środków bezpieczeństwa, jak i do przeprowadzania potężniejszych cyberataków.

Czy zabezpieczenie AI to dobra kariera?

Zabezpieczenie sztucznej inteligencji to rozwijająca się dziedzina, która oferuje wiele wymagających i dobrze opłacalnych możliwości kariery.

Ile robią specjaliści ds. bezpieczeństwa AI?

W zależności od doświadczenia i lokalizacji specjaliści ds. zabezpieczenia AI mogą zarabiać od 60 000 USD do 120 000 USD rocznie.

Jak przejść do zabezpieczeń AI?

Kursy szkoleniowe online, studia z informatyki lub cyberbezpieczeństwa oraz certyfikaty bezpieczeństwa AI to dobry punkt wyjścia do kariery w dziedzinie zabezpieczenia AI.

Jaka jest różnica między cyberbezpieczeństwem opartym na AI a bezpieczeństwem AI?

Cyberbezpieczeństwo odnosi się do narzędzi lub systemów, które chronią organizacje przed cyberatakami. Bezpieczeństwo AI polega na zabezpieczeniu stosu AI organizacji.

Czy sztuczna inteligencja może działać w cyberbezpieczeństwie?

Pod nadzorem człowieka technologie sztucznej inteligencji mogą radykalnie poprawić szybkość, dokładność i skuteczność niemal każdego aspektu cyberbezpieczeństwa.

Jaka jest różnica między tradycyjnym bezpieczeństwem cybernetycznym a bezpieczeństwem opartym na sztucznej inteligencji?

Chociaż ich cele i metody są takie same, cyberbezpieczeństwo oparte na sztucznej inteligencji może zapewnić szybszą, dokładniejszą i bardziej proaktywną ochronę niż tradycyjne cyberbezpieczeństwo.

Czy cyberbezpieczeństwo wymaga kodowania?

Podczas gdy kodowanie może być cenną umiejętnością w wielu zadaniach związanych z cyberbezpieczeństwem, istnieje wiele stanowisk w dziedzinie cyberbezpieczeństwa, które nie wymagają żadnego doświadczenia ani wiedzy specjalistycznej w zakresie kodowania.

Dlaczego AI stanowi zagrożenie dla bezpieczeństwa?

Sztuczna inteligencja może być wykorzystywana przez przestępców do włamywania się do systemów informatycznych, kradzieży poufnych danych, niszczenia stosów AI lub uruchamiania wyrafinowanych cyberataków.

Jaki jest przykład naruszenia bezpieczeństwa danych AI?

Do symulacji głosów i obrazów wideo prawdziwych ludzi wykorzystano głębokie fałszerstwa sztucznej inteligencji, co przekonuje pracowników organizacji do udostępniania poufnych informacji, które powinny być traktowane jako poufne.

Czy aplikacja zabezpieczająca AI jest bezpieczna?

Ostatecznie bezpieczeństwo aplikacji zabezpieczającej zależy od wiarygodności jej programisty, a nie od jej ceny. Trzymaj się głównych, niezależnie przetestowanych marek i unikaj aplikacji pochodzących z nieznanych źródeł.

Jakie są zagrożenia dla bezpieczeństwa związane ze sztuczną inteligencją?

Niektóre typowe zagrożenia związane z bezpieczeństwem sztucznej inteligencji obejmują rozszerzone powierzchnie ataków, zatrucie i uszkodzenie danych oraz zagrożenia dla danych AI, algorytmów i modeli szkoleniowych.

Czy mój system sztucznej inteligencji jest narażony na wysokie ryzyko?

Organizacje mogą zmniejszyć ryzyko związane z systemami sztucznej inteligencji, analizując swoje obecne mechanizmy obronne, stosując najlepsze praktyki branżowe i wdrażając kompleksowe strategie bezpieczeństwa i cyberbezpieczeństwa sztucznej inteligencji.

Czy powinienem ufać wykrywaczowi sztucznej inteligencji?

Chociaż detektory AI mogą być skutecznymi narzędziami, mogą również popełniać błędy. Dlatego ich wyniki powinny być wykorzystywane wyłącznie jako wstępny sygnał do podjęcia dalszych badań, które muszą opierać się na ludzkim osądzie.

Jak zachować ostrożność w przypadku AI?

Naprawdę staranne podejście do sztucznej inteligencji wymaga różnych działań od użytkowników i twórców. Niezależnie od tego, czy korzystasz z AI, czy ją tworzysz, podstawową zasadą jest traktowanie jej jako potężnego, ale niedoskonałego narzędzia — a nie nieomylnego eksperta lub zaufanego doradcy.

Jak zabezpieczyć sztuczną inteligencję?

Kompleksowe zabezpieczenia stosu AI nie pozostawiają żadnych luk, zapewniając ochronę wszystkich elementów — od użytkowników i generowanych przez nich danych po modele, mikrousługi i infrastrukturę bazową.

Powiązane artykuły

10 najlepszych środków ograniczających ryzyko dla LLM i aplikacji Gen AI w 2025 r.

Zarządzanie nowymi zagrożeniami dla bezpieczeństwa publicznego

Jak daleko mogą nas zaprowadzić międzynarodowe standardy?

Jak napisać generatywną politykę cyberbezpieczeństwa AI?

Złośliwe ataki z wykorzystaniem sztucznej inteligencji wśród największych zagrożeń

Rosnące zagrożenie związane z Deepfake tożsamości