Polityka firmy w zakresie AI to obowiązujący zestaw zasad operacyjnych związanych z prawidłowym wykorzystaniem technologii AI. Pomagają one zachować zgodność z przepisami, zapewniają prywatność danych i bezpieczeństwo cyfrowe.

Spis treści

Szablon polityki firmy w zakresie AI

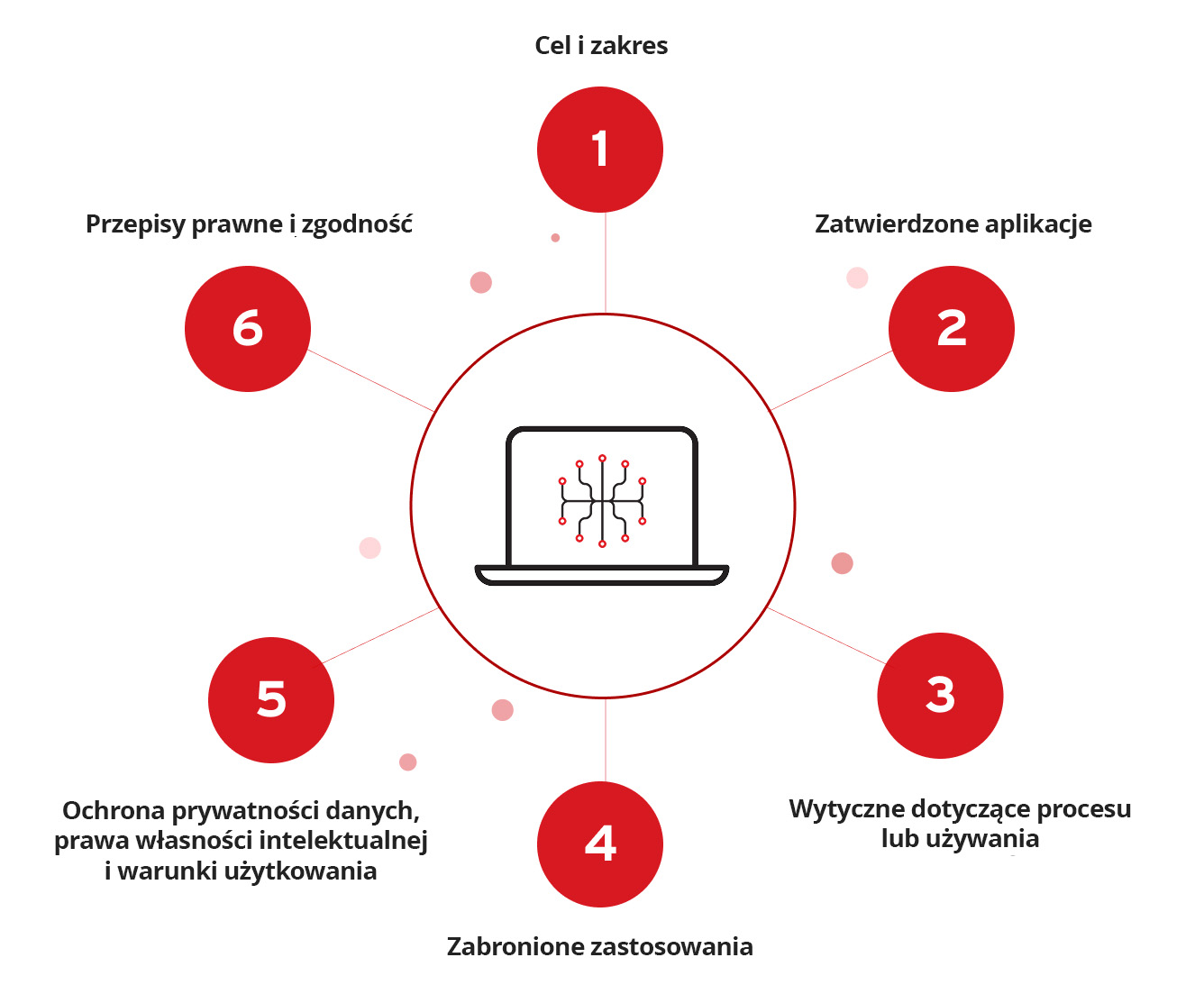

Aby polityka skutecznie edukowała w zakresie najlepszych praktyk i ograniczała ryzyko, musi koncentrować się na kilku kluczowych obszarach. Są to:

Cel i zakres

W tej sekcji otwierającej należy objaśnić cele polityki firmy w zakresie AI. Należy również wskazać, kto, oprócz pracowników, musi przestrzegać polityki, np. osoby lub agencje oferujące usługi outsourcingu.

Zatwierdzone aplikacje

W tym miejscu należy wymienić aplikacje związane z AI, które zostały zatwierdzone do użytku. Można tu też sprecyzować właściwe procedury dostępu do każdej z nich, aby zapewnić zgodność. Należy jednak pominąć poufne informacje, takie jak dane logowania. Te informacje powinny być dostarczane przez kierownictwo w bezpieczny sposób na prośbę osoby ubiegającej się o dostęp lub podczas procesu wdrażania.

Wytyczne dotyczące procesu lub używania

Podsumowanie procesu korzystania z AI, np. w formie wypunktowanej listy, pomaga użytkownikom zrozumieć wymagane kroki i ich przestrzegać. Daje to także okazję do wdrożenia barier operacyjnych i poinformowania, jak podchodzić do kwestii uprawnień, komunikacji wewnętrznej, jakości treści generowanych przez AI oraz ogólnego dostępu do danych i narzędzi przyznanego systemom AI. Pomocne może być również określenie, co należy zrobić, jeśli podejrzewa się ryzyko lub podatność na zagrożenia związane z którymkolwiek z powyższych.

Zabronione zastosowania

W tej sekcji należy wyjaśnić, kiedy, gdzie i jak nie należy używać zatwierdzonych aplikacji AI. Jeśli występują uzasadnione wyjątki, należy je tu uwzględnić. Tak jak w pozostałych częściach polityki, wybrane sformułowania powinny być jasne, zwięzłe i łatwe do wykonania, przy jednoczesnym ograniczeniu ryzyka błędnej interpretacji lub pomyłki.

Ochrona prywatności danych, prawa własności intelektualnej i warunki użytkowania

Ta sekcja ma przypominać użytkownikom o konieczności zapoznania się z warunkami korzystania z narzędzi AI, do których mają dostęp. Pomaga chronić się przed niewłaściwym użyciem lub kwestiami związanymi z odpowiedzialnością. Należy tu podkreślić znaczenie zachowania prywatności danych i unikania plagiatów, poszanowania praw własności intelektualnej i ich posiadaczy oraz nieudzielania danemu narzędziu (lub narzędziom) dostępu do informacji poufnych.

Przepisy prawne i zgodność

W tym miejscu należy wskazać organy zarządzające i przepisy, z którymi organizacja – a co za tym idzie i zespół – musi zachować zgodność podczas korzystania z AI. Powinny one obejmować ustanowione akty rządowe oraz wszelkie wymagania dotyczące zespołu prawnego, bezpieczeństwa lub IT.

Przykłady polityki firmy w zakresie AI

The Pan-Canadian AI Strategy

Podzielona według priorytetów strategicznych i zjednoczona w swojej misji organizacja Pan-Canadian Artificial Intelligence Strategy chce „realizować pozytywne zmiany społeczne, ekonomiczne i środowiskowe z korzyścią dla ludzi i planety”.

Odpowiedzialne praktyki Microsoft w zakresie AI

Zbiór obejmujący wyniki badań, politykę i dokumentację inżynieryjną skoncentrowane na rozwijaniu AI w sposób etyczny i odpowiedzialny. W maju 2024 roku firma Microsoft opublikowała własny kompleksowy Raport dotyczący przejrzystości odpowiedzialnej AI, który obejmuje wszystko, od mapowania, pomiaru i zarządzania ryzykiem związanym ze sztuczną inteligencją po budowanie bezpiecznych i odpowiedzialnych modeli AI.

National Institute of Standards and Technology (NIST) – normy i polityka w zakresie AI

Instytut NIST w ścisłej współpracy z kluczowymi interesariuszami z sektorów prywatnego i publicznego oraz agencjami federalnymi opracował nowe normy w zakresie AI. Instytut jest „mocno angażuje się w działania w USA i na arenie międzynarodowej”. Wysiłki na rzecz polityki w zakresie AI są podejmowane przez różne ciała, takie jak Rada ds. Handlu i Technologii USA-UE, OECD, Rada Europy, „Czterostronny dialog o bezpieczeństwie” i szereg innych. W ramach tych działań NIST współpracuje również z Administracją Handlu Międzynarodowego Departamentu Handlu USA i Departamentem Stanu USA.

W lipcu 2024 r. NIST wydał również cztery publikacje, które „mają pomóc w poprawie bezpieczeństwa, ochrony i wiarygodności systemów sztucznej inteligencji”. Oto one:

- Generatywna AI

- Bezpieczne oprogramowanie

- Normy w zakresie AI

- Wstępny publiczny projekt raportu Zarządzanie ryzykiem nadużyć modeli podstawowych podwójnego zastosowania

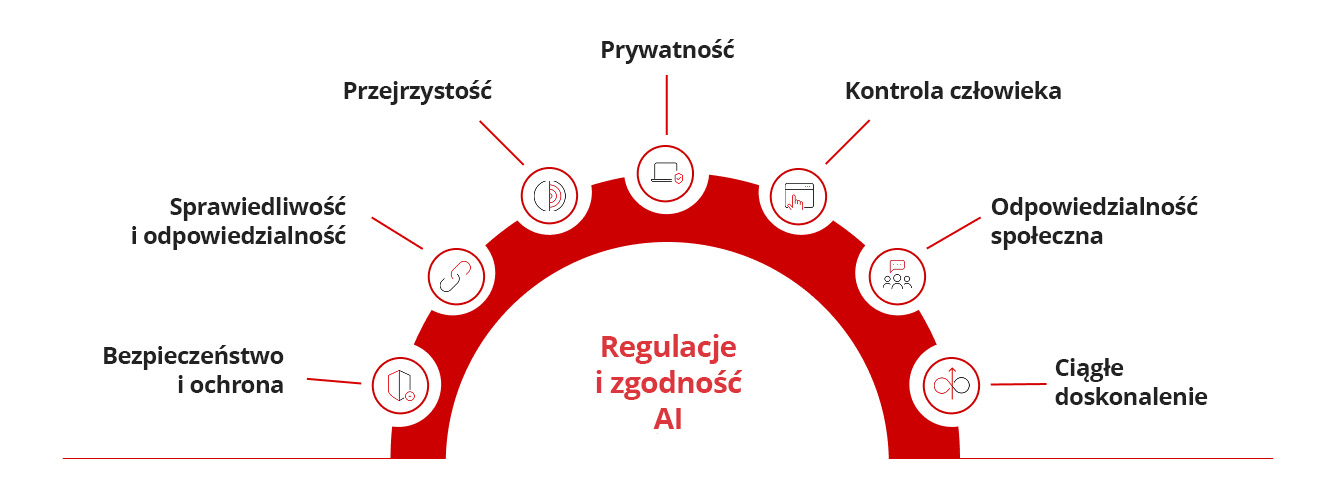

Regulacje dotyczące AI i zgodność z przepisami

Definiowanie etyki AI

Etyka AI obejmuje zasady i wytyczne regulujące odpowiedzialny rozwój, wdrażanie i korzystanie z systemów AI. Dotyka kwestii takich jak dostosowanie, sprawiedliwość, odpowiedzialność, przejrzystość, prywatność, ryzyko oraz społeczny wpływ technologii AI.

Zalecenia ekspertów w zakresie regulacji dotyczących GenAI

Raport opublikowany przez badaczy OpenAI (arXiv:2307.03718: Regulacje dotyczące GenAI: zarządzanie nowymi zagrożeniami dla bezpieczeństwa publicznego) zwraca uwagę na szereg wyzwań związanych z regulacją modeli generatywnej AI celem ochrony użytkowników. Autorzy raportu stwierdzają, że „modele GenAI stanowią szczególne wyzwanie regulacyjne: niebezpieczne możliwości mogą pojawić się nieoczekiwanie; trudno jest skutecznie zapobiegać niewłaściwemu wykorzystaniu wdrożonego modelu; i trudno jest zapobiegać szerokiemu rozprzestrzenianiu się jego możliwości”.

W podsumowaniu raportu stwierdza się ponadto, że regulacji wymagają „co najmniej trzy bloki konstrukcyjne:

- - procesy ustanawiania standardów dla deweloperów GenAI;

- - wymogi dotyczące rejestracji i raportowania w celu zapewnienia organom regulacyjnym wglądu w procesy rozwoju GenAI; oraz

- - mechanizmy zapewniające zgodność ze standardami bezpieczeństwa w zakresie opracowywania i wdrażania modeli GenAI”.

Kto może nam pomóc w zarządzaniu politykami naszej firmy w zakresie sztucznej inteligencji?

Organizacje mogą opracować skuteczne polityki dotyczące sztucznej inteligencji, stosując dwa uzupełniające się podejścia: wykorzystując swoje wewnętrzne zespoły ds. bezpieczeństwa lub współpracując z wyspecjalizowanymi firmami konsultingowymi oraz przeprowadzając oceny typu „Red Teaming”. Podczas gdy zespoły wewnętrzne lub konsultanci koncentrują się na definiowaniu i wdrażaniu podstawowych zasad, Red Teaming dostarcza kluczowych informacji poprzez identyfikację słabych punktów i potencjalnych zagrożeń, zapewniając solidność i kompleksowość zasad.

Firmy konsultingowe oferują specjalistyczną wiedzę w zakresie zarządzania sztuczną inteligencją, zgodności z przepisami i najlepszych praktyk, pomagając organizacjom w opracowywaniu polityk dotyczących kluczowych obszarów, takich jak prywatność danych, ochrona własności intelektualnej i ograniczanie ryzyka, przy jednoczesnym dostosowaniu się do standardów branżowych. Red Teaming uzupełnia to poprzez wykrywanie luk w zabezpieczeniach systemu, symulowanie rzeczywistych zagrożeń, takich jak ataki przeciwników, zatruwanie danych lub kradzież modeli, oraz dostarczanie praktycznych informacji umożliwiających udoskonalenie i wzmocnienie ram polityki. Oceny te sprawdzają również skuteczność istniejących polityk, ujawniają potencjalne scenariusze nadużyć, takie jak wdrażanie sztucznej inteligencji w ukryciu lub nieuprawniony dostęp, oraz identyfikują uprzedzenia lub kwestie etyczne w systemach sztucznej inteligencji. Dzięki połączeniu wniosków płynących zarówno z konsultacji strategicznych, jak i ocen podatności na zagrożenia, organizacje mogą ustanowić zasady dotyczące sztucznej inteligencji, które będą bezpieczne, sprawiedliwe i elastyczne, a jednocześnie będą odpowiadać ich indywidualnym potrzebom operacyjnym i strategicznym.

Często zadawane pytania (FAQ)

Czym są polityki AI?

Polityki AI to wytyczne organizacyjne zapewniające etyczne, przejrzyste i zgodne z prawem wykorzystanie sztucznej inteligencji w firmie.

Co powinna zawierać polityka AI firmy?

Powinna zawierać zasady etyczne, wymagania prawne, ochronę danych, odpowiedzialność, standardy transparentności oraz strategie zarządzania ryzykiem.

Czy firmy potrzebują polityki AI?

Tak, firmy potrzebują polityki AI, aby zapewnić odpowiedzialne wykorzystanie, zgodność z regulacjami, minimalizację ryzyka i zaufanie klientów.

Na czym polega zasada 30% dla AI?

Zasada 30% ogranicza automatyzację AI do 30% zadań, zachowując nadzór człowieka i równowagę w decyzjach.

Jakie są 7 zasad Aktu o AI?

Zasady obejmują przejrzystość, uczciwość, odpowiedzialność, bezpieczeństwo, prywatność, nadzór człowieka i odporność systemów AI.

Jak stworzyć politykę AI?

Określ cele, oceń ryzyka, ustal standardy etyczne, zapewnij zgodność, zaangażuj interesariuszy i wdroż proces monitorowania.

Powiązane artykuły

10 najlepszych środków ograniczających ryzyko dla LLM i aplikacji Gen AI w 2025 r.

Zarządzanie nowymi zagrożeniami dla bezpieczeństwa publicznego

Jak daleko mogą nas zaprowadzić międzynarodowe standardy?

Jak napisać generatywną politykę cyberbezpieczeństwa AI?

Złośliwe ataki z wykorzystaniem sztucznej inteligencji wśród największych zagrożeń

Rosnące zagrożenie związane z Deepfake tożsamości