Zagrożenia dla bezpieczeństwa związane z AI pojawiają się podczas jej wdrażania i używania. Są to m.in. złośliwe cyberataki inicjowane przez cyberprzestępców oraz podatności wynikające z zachowania platform lub użytkowników.

Spis treści

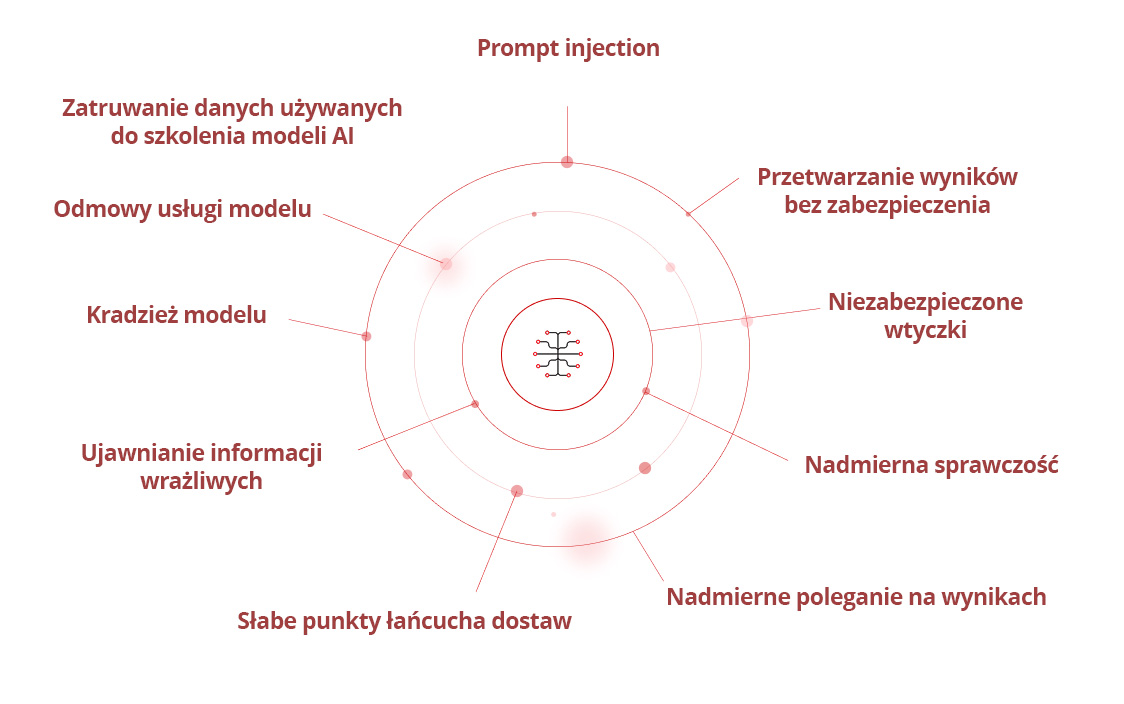

Luki w zabezpieczeniach związane z AI

Open Worldwide Application Security Project (OWASP) zidentyfikował szereg luk w zabezpieczeniach związanych z AI opartą na dużych modelach językowych (ang. Large Language Model, LLM). Są to:

- Prompt injection

- Przetwarzanie wyników bez zabezpieczenia

- Zatruwanie danych używanych do szkolenia modeli AI

- Odmowy usługi modelu

- Słabe punkty łańcucha dostaw

- Ujawnianie informacji wrażliwych

- Niezabezpieczone wtyczki

- Nadmierna sprawczość

- Nadmierne poleganie na wynikach

- Kradzież modelu

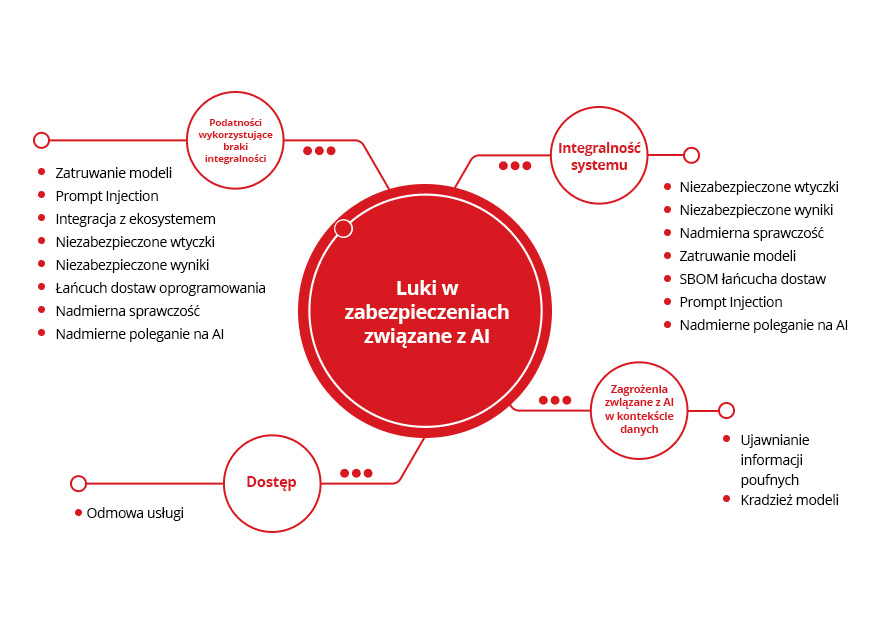

Te podatności można podzielić na następujące główne kategorie:

Zagrożenia związane z AI w kontekście danych

Integralność systemu

Dostęp

Podatności wykorzystujące braki integralności

Ujawnianie informacji poufnych

Kradzież modeli

Niezabezpieczone wtyczki

Niezabezpieczone przetwarzanie wyników

Nadmierna sprawczość

Zatruwanie modeli

SBOM łańcucha dostaw

Prompt Injection

Nadmierne poleganie na AI

Odmowa usługi

Zatruwanie modeli

Prompt Injection

Integracja z ekosystemem

Niezabezpieczone wtyczki

Niezabezpieczone przetwarzanie wyników

Łańcuch dostaw oprogramowania

Nadmierna sprawczość

Nadmierne poleganie na AI

Będąc w dużej mierze zależną od dostępnych danych i informacji wprowadzanych przez użytkowników, AI jest coraz częściej celem złośliwych ataków w nadziei na złamanie zabezpieczeń cyfrowych i wyłudzenia poufnych informacji. W wynikach ankiety przeprowadzonej niedawno przez Gartner® podano pięć najczęściej wymienianych nowych zagrożeń w pierwszym kwartale 2024 roku. Zagrożenia związane z AI zajmują w nich dwa pierwsze miejsca, tj. wspomagane sztuczną inteligencją złośliwe ataki oraz dezinformacja. Jak zauważa Gartner, coraz lepsza AI może „ułatwiać phishing i inżynierię społeczną, dzięki skuteczniejszym włamaniom, większej wiarygodności i atakom wyrządzającym więcej szkód”.

Niedokładność AI

O niedokładności AI mówimy wtedy, gdy podawane przez nią wyniki nie są dopasowane do celu podanego przez użytkownika. Może to być przypadkowe, np. w wyniku awarii chroniących przed tym zabezpieczeń. Może to być również celowe, w którym to przypadku złośliwe podmioty mogą starać się zachwiać stabilnością atakowanej AI lub zainstalować w jej środowisku złośliwie dopasowane modele.

Automatyzacja oszustw

Automatyzacja oszustw polega na tworzeniu treści tekstowych, dźwiękowych lub wideo, które wykorzystują procesy biznesowe, czy to poprzez phishing, włamanie na pocztę służbową (BEC), czy też audio-wizualne treści Deepfake. AI pozwala łatwo skalować automatyzację oszustw.

Zarządzanie danymi

Systemy AI są zależne od danych. Dlatego dane wykorzystywane w systemach AI – oraz dane na żywo, z którymi modele te się stykają – muszą być zgodne ze wszystkimi przepisami dotyczącymi ochrony prywatności i uczciwego użytkowania. Stąd potrzeba proaktywnego i skutecznego zarządzania danymi, by minimalizować ryzyko.

Zagrożenia bezpieczeństwa związane z LLM

Modele LLM są narażone na poważne luki w zabezpieczeniach, w tym wstrzyknięcie poleceń, które manipuluje zachowaniem modelu, ujawnienie poufnych informacji, które naraża dane na ryzyko, oraz nieprawidłowe przetwarzanie wyników, które umożliwia ataki na systemy niższego szczeb Inne poważne zagrożenia obejmują podatność łańcucha dostaw na zależności od podmiotów zewnętrznych, nadmierne przyznawanie niepotrzebnych uprawnień przez agencje, zatrucie danych zagrażające integralności modelu oraz wyciek komunikatów systemowych ujawniających poufne instrukcje. Ponadto słabe punkty osadzania wektorów, generowanie fałszywych informacji i ataki polegające na nieograniczonym zużyciu zagrażają bezpieczeństwu, niezawodności i dostępności aplikacji LLM.

Zagrożenia dla bezpieczeństwa związane z GenAI w kontekście poleceń wprowadzanych przez użytkownika

Generatywna AI (GenAI) wykorzystuje dostępne dane przeszłe i obecne, aby pomagać użytkownikom. Dlatego wprowadzając polecenia w narzędziach GenAI, należy zwracać uwagę na to, jakie informacje się podaje. Niektóre narzędzia pozwalają użytkownikom zrezygnować z gromadzenia danych, na przykład opcja wyłączenia historii czatu w ChatGPT. W zależności od polityki zarządzania AI stosowanej przez danego regulatora branżowego środki zapobiegawcze lub zachowania takie jak wymienione wyżej mogą być wymogiem utrzymania zgodności.

Wstawianie informacji finansowych, poufnych szczegółów dotyczących jeszcze nieopublikowanego oprogramowania, danych osobowych (PII), takich jak adresy osobiste i dane kontaktowe, lub innych danych wrażliwych oznacza, że informacje te są dostępne dla aplikacji AI. Istnieje ryzyko, że zostaną one zmanipulowane, udostępnione innym w rekomendacjach narzędzia w odpowiedzi na podobne zapytania lub skradzione przez złośliwych aktorów, jeśli zabezpieczenia AI zostaną naruszone. Stwarza to szczególne ryzyko w przypadku korzystania z narzędzi GenAI do generowania pomysłów lub szybkiego kompilowania dużych ilości danych, zwłaszcza jeżeli nie są stosowane wystarczająco silne algorytmy szyfrujące lub środki bezpieczeństwa.

Zagrożenia dla bezpieczeństwa związane z ChatGPT

ChatGPT jest narzędziem GenAI, które dostarcza odpowiedzi tekstowych na zapytania użytkownika. Jako takie może być manipulowane przez złośliwe podmioty do ukrywania lub wzmacniania prób phishingu. Również sama platforma może być celem ataków, by umożliwić przestępcom dostęp do danych użytkowników. Ataki te mogą polegać na redagowaniu wiadomości phishingowych na podstawie próbek pisma osoby lub organizacji będących ich celem, a także poprawianie literówek, błędów gramatycznych i językowych, aby wiadomości wyglądały bardziej wiarygodnie. Istnieje również ryzyko kradzieży danych użytkownika lub naruszenia bezpieczeństwa poprzez wstrzykiwanie poleceń lub jailbreak.

Występują też zagrożenia związane ze sposobem użytkowania bez związku ze złośliwymi podmiotami. Na przykład informacje wprowadzane przez użytkownika do ChatGTP mogą być używane do szkolenia LLM. Pojawia się także ryzyko niewystarczającego szyfrowania danych, czego przykładem jest aplikacja ChatGPT na MacOS, która z początku uruchamiała się z czatem użytkownika zapisanym w postaci nieszyfrowanego tekstu.

Zagrożenia dla bezpieczeństwa związane z OpenAI

Sam interfejs API OpenAI może być potencjalnym celem cyberprzestępców. Choć jest on zgodny z SOC 2 i przechodzi regularne testy penetracyjne, to ryzyko nigdy nie jest całkowicie wyeliminowane, ponieważ cyberzagrożenia stale ewoluują. Niedawny artykuł opublikowany w Soft Kraft szczegółowo opisuje ryzyko dla bezpieczeństwa danych związane z OpenAI, ujawniając pięć zagrożeń szczególnie ważnych z punktu widzenia użytkowników korporacyjnych:

- Dane konwersacji ChatGPT mogą być używane do ponownego trenowania modeli

- Dane przesyłane za pośrednictwem interfejsu API mogą być ujawniane wewnętrznie i na zewnątrz

- Zapewnienie zgodności z ogólnym rozporządzeniem o ochronie danych (RODO) może być trudne

- Korzystanie z usług zewnętrznych podmiotów przetwarzania danych komplikuje kwestie związane z lokalizacją i obsługą danych

Zagrożenia dla bezpieczeństwa związane z Microsoft Copilot

Microsoft Copilot AI jest częścią aplikacji Microsoft 365, jest więc łatwo dostępny dla użytkowników. Co więcej, najnowsze komputery Copilot+ mają specjalny klawisz Copilota, zachęcający użytkownika do jeszcze szybszego wprowadzania danych. Ten usprawniony dostęp może być równolegle źródłem zagrożeń, jeżeli do Copilota zostaną wprowadzone poufne informacje, tak samo jak w przypadku innych narzędzi GenAI. Bez prawidłowych uprawnień i odpowiednich ustawień prywatności, możesz też dochodzić do wycieku poufnych danych lub naruszeń. To samo dotyczy zarządzania dostępem użytkowników. I wreszcie, ataki na samą platformę mogą umożliwić złośliwym podmiotom modyfikowanie metod dostępu do danych i ich udostępniania.

Kto może pomóc nam w zarządzaniu zagrożeniami bezpieczeństwa zawiązanym z AI?

Ciągły rozwój innowacji w dziedzinie sztucznej inteligencji wymaga proaktywnego bezpieczeństwa, popartego 35-letnim doświadczeniem w zakresie analizy zagrożeń, 20-letnim pionierskim rozwojem sztucznej inteligencji oraz niezrównaną ochroną przed lukami w zabezpieczeniach — tym właśnie jest Trend Vision One™ AI Security.

Dzięki naszemu rozwiązaniu AI Security chronimy Twoje krytyczne obciążenia biznesowe, w tym cały stos AI, jednocześnie poprawiając ogólny stan bezpieczeństwa. Wspierane przez Trend Cybertron nasze zabezpieczenia AI przewidują ścieżki ataku i wykrywają anomalie, jednocześnie chroniąc przed deepfake'ami i atakami generowanymi przez sztuczną inteligencję, aby wyeliminować luki w zabezpieczeniach i przekształcić zabezpieczenia AI w katalizator innowacji.

Często zadawane pytania (FAQ)

Jakie są zagrożenia bezpieczeństwa związane z AI?

AI niesie ryzyko wycieków danych, ataków, manipulacji modeli, naruszeń prywatności i nadużyć w cyberprzestępczości.

Kto jest prawdziwym ojcem AI?

John McCarthy jest uznawany za ojca AI, twórcę terminu i pioniera badań nad sztuczną inteligencją.

Jakie są 4 kategorie ryzyka w Akcie o AI?

Akt o AI wyróżnia cztery kategorie: niedopuszczalne ryzyko, wysokie ryzyko, ograniczone ryzyko i minimalne ryzyko.

Na czym polega zasada 30% dla AI?

Zasada 30% ogranicza automatyzację AI do 30% zadań, zapewniając nadzór człowieka i odpowiedzialność.

Jak AI wpływa na bezpieczeństwo?

AI poprawia wykrywanie zagrożeń i cyberbezpieczeństwo, ale wprowadza ryzyka jak deepfake, automatyczne ataki i nadużycia danych.

Czy mój system AI jest wysokiego ryzyka?

System AI jest wysokiego ryzyka, jeśli wpływa na bezpieczeństwo, prawa podstawowe, infrastrukturę lub dane osobowe.

Powiązane artykuły

10 najlepszych środków ograniczających ryzyko dla LLM i aplikacji Gen AI w 2025 r.

Zarządzanie nowymi zagrożeniami dla bezpieczeństwa publicznego

Jak daleko mogą nas zaprowadzić międzynarodowe standardy?

Jak napisać generatywną politykę cyberbezpieczeństwa AI?

Złośliwe ataki z wykorzystaniem sztucznej inteligencji wśród największych zagrożeń

Rosnące zagrożenie związane z Deepfake tożsamości