Artificial Intelligence (AI)

静かな飛躍:OpenAIの新しいChatGPTエージェント機能とセキュリティリスク

OpenAIは最近、ChatGPTエージェントを発表しました。この新たな機能はどのような可能性を持ち、どのようなサイバーセキュリティ上のリスクが考えられるのでしょうか。トレンドマイクロでは、独自の「デジタルアシスタントフレームワーク」を用いて、この新しいデジタルアシスタントがもたらす変化とリスクを整理し、組織が安全に活用していくための手がかりを提供します。

主なポイント

- 新たに公開されたChatGPTエージェントは、従来のアシスタントでは想定されていなかったセキュリティ上の課題を伴う高度な機能を備えています。

- このエージェントは操作されるリスクが高まり、プライバシーに関わるリスクにもさらされやすくなっており、組織が意図しない動作や情報漏洩に直面する可能性があります。

- 機能の活用を検討している組織やユーザは、アクティブな利用者の監視を維持することがリスク管理において重要です。

- トレンドマイクロの「デジタルアシスタントフレームワーク」は、こうした新機能とリスクを対応づけて可視化する手法を提供しており、OpenAIの最新アシスタントによる影響をより適切に評価する助けとなります。

OpenAIが発表したChatGPTエージェントは、AIシステムの能力における静かでありながら大きな転換点となっています。従来のアシスタントは主に質問に答える、あるいはコンテンツを生成することに焦点を当てていましたが、新たなエージェントはそれを超えています。カレンダーの管理、メールの送信、コードの実行、外部アプリケーションとの連携など、ユーザの代わりに具体的なアクションを実行できるのです。

言い換えれば、このアシスタントは「補助」するだけでなく、「行動」するようになったのです。

この進化には明確な利点があります。デジタルアシスタント(DA)がより柔軟かつ多機能になり、さまざまなシステムやアプリケーションを横断するタスクを担えるようになります。しかし同時に、AIが自律的に行動することで、デジタル環境の中枢サービスと直接やり取りを行うようになり、新たなリスクが生じます。

本稿では、2つのテーマを取り上げています。まず、OpenAIが公開した内容を整理し、トレンドマイクロが以前の調査で紹介した「デジタルアシスタントフレームワーク」を用いて、新エージェントの機能を体系的に分類します。そして、従来のChatGPTアシスタントとの比較を通じて、どれほどの変化があったのか、そしてその変化によって生じるリスクについて明らかにします。

これらのリスクは、理論上のものでも遠い未来の話でもありません。OpenAIの新エージェントはすでに利用可能となっており、脅威の状況を現実的かつ急速に変化させつつあります。今こそ、その影響にしっかりと向き合う必要があります。

OpenAIのChatGPTエージェント:行動するアシスタント

新しいChatGPTエージェントは、単なるチャットボットの新バージョンではありません。これは、開始から完了まで複雑なマルチステップのタスクを自律的に実行できるアシスタントであり、エージェンティックAIに一歩近づいた存在です。

たとえば、旅行の計画と予約を行ったり、カレンダーを確認してクライアントとの今後の予定をまとめたり、編集可能なプレゼンテーションを作成したりできます。これらはすべて仮想コンピュータ上で実行され、ウェブサイトの操作、コードの生成と実行、情報の統合を可能にし、これまでのアシスタントにはなかった形で「思考」と「行動」を自然に結びつけています。

そのため、ユーザはもはや単なる回答の受け手ではなく、エージェントと共同でタスクを進め、必要に応じて重要な操作を承認したり、制御を取り戻したりするかたちで関与します。

このエージェントは、テキスト入力にも音声入力にも対応しており、出力はテキストだけでなくビジュアルでも返すことができます。スマートフォンなどの携帯デバイスからも利用可能で、必要なときにいつでもアクセスできます。従来の特化型ツール(ウェブ操作、高度な調査、会話能力)それぞれの長所を1つにまとめ、ユーザの代わりに行動する統合的なシステムとなっています。

その内部では、高度な計画立案や推論の能力を備えており、未知のタスクにも対応しながら学習を重ねていきます。ユーザの嗜好やコンテキストを蓄積しながら、継続的に理解を深めていく設計です。

さらに、メールやデジタルカレンダー、各種ウェブサービスなど外部のシステムと直接連携することで、単なる情報提供を超え、実際のアプリケーション上でタスクを実行する、より広範なデジタルエコシステムの一部として機能します。

トレンドマイクロのデジタルアシスタントフレームワークを用いたChatGPTエージェントの機能マッピング

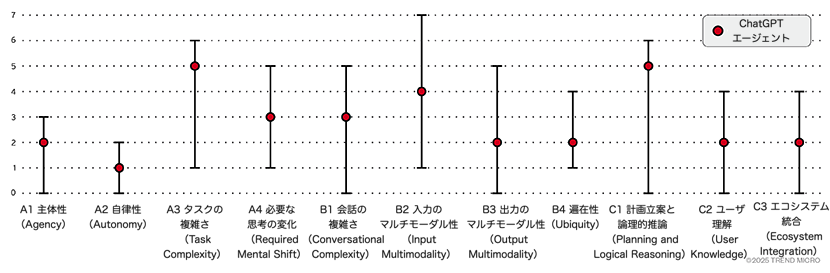

OpenAIの新しいアシスタントが持つ機能を整理し、視覚的にわかりやすく提示するために、ここではトレンドマイクロの「デジタルアシスタントフレームワーク」を使用します。このフレームワークは、デジタルアシスタント(DA)の特徴的な機能を評価する目的で設計されています。

このフレームワークは、2024年12月の記事で初めて紹介されました。その後、「Agency(A1)」の機能を「主体性(A1: Agency)」と「自律性(A2: Autonomy)」の2つに分けてアップデートしています。ここでは自律性(A2: Autonomy)のレベルを次のように定義しています。

自律性(A2: Autonomy)

自律性とは、人間の指示なしに意思決定を実行できる能力を指します。

- A2.0 – 反応型(Reactive):ユーザのリクエストに対してのみ反応して行動します。

- A2.1 – 監督下での作業(Supervised work):明確なユーザの確認を必要とし、監督のもとで動作します。

- A2.2 – 完全自律(Full autonomy):ユーザの監督なしに、タスクを独立して管理します。

以下のインタラクティブな図は、新しいChatGPTエージェントがこのフレームワークにどのようにマッピングされるかを示しており、主要な機能とその進化のレベルを可視化しています。

- A1. 主体性(Agency):ユーザに代わって行動を実行する能力

- A1.2 – アクション連携(Action chaining):デジタルアシスタントは一つのコマンドから複数のアクションを連鎖させることができる

- A2. 自律性(Autonomy):人間の入力なしに意思決定を行う能力

- A2.1 – 監督下での作業(Supervised work):デジタルアシスタントは監督の下で動作し、明示的なユーザ確認を必要とする

- A3. タスクの複雑性(Task complexity):日常業務において電話やPCを置き換える能力

- A3.5 – マルチアプリ置換(Multi-app replacement):デジタルアシスタントは関連アプリの機能を統合できる

- A4. 必要な意識転換(Required mental shift):アシスタントを使用するために必要な関与レベル

- A4.3 – 基本的な行動の委任(Basic actions delegation):ユーザに代わって基本的な行動をデジタルアシスタントに委任する意欲

- B1. 会話の複雑性(Conversational complexity):複雑な会話を持続する能力

- B1.3 – 自然な会話(Natural conversation):デジタルアシスタントは自然な会話ができる

- B2. 入力モダリティ(Input modality):異なるタイプの入力メディアを受け入れる能力

- B2.4 – 音声(Speech):デジタルアシスタントはネイティブな音声処理機能を持つ

- B3. 出力モダリティ(Output modality):様々なメディアで出力を生成または提供する能力

- B3.2 – マルチメディア(Multimedia):デジタルアシスタントは画像、音声、動画出力を生成できる

- B4. ユビキティ(Ubiquity):異なるデバイス間でユーザをフォローし支援する能力

- B4.2 – モバイル(Mobile):デジタルアシスタントは、ユーザが常に身近に持つデバイスを通じてアクセスできる

- C1. 計画と論理的推論(Planning and logical reasoning):計画を立て論理的に推論する能力

- C1.5 – 新領域学習(New domain learning):デジタルアシスタントは新しい領域を自律的に学習し、その中で推論することができる

- C2. ユーザ知識(User knowledge):ユーザに関する情報を取得し保持する能力

- C2.2 – 動的知識(Dynamic knowledge):デジタルアシスタントは時間をかけた相互作用を通じて取得したユーザに関する知識を持つ

- C3. エコシステム統合(Ecosystem integration):より広いエコシステム内の情報にアクセスする能力

- C3.2 – ネイティブな複数プロバイダー連携(Natively chaining multiple providers):デジタルアシスタントは連続的なデータを連結できる

機能とリスク:進化の代償を理解する

OpenAIの新しいエージェントによって実現された機能の飛躍は、大きな利点をもたらす一方で、決して無償ではありません。アシスタントがより自律的になり、デジタルエコシステムに深く統合されることで、それに伴ってリスクも増大していきます。

こうしたリスクを正しく理解するには、まず何が変わったのかを確認する必要があります。新しいエージェントがこれまでのChatGPTの機能をどう発展させたのか、そしてその拡張が従来のアシスタントでは直面しなかった新たな課題をどう生み出しているのかを見ていきます。

自律性(A2: Autonomy)におけるリスク

従来のChatGPTも、ユーザのリクエストをどう処理するかを選択するという点で、ある程度の「主体性」は備えていました。ただし、それらのアシスタントはあくまで反応型(リアクティブ)であり、明示的な指示がなければ行動しない設計でした。

今回のエージェントは、そうした従来型の土台を活かしながらも、自律性(A2: Autonomy)という点で明確な進化を遂げています。ユーザの代わりに動くだけでなく、最小限の監督のもとでタスクを自発的に管理できるようになっているのです。

トレンドマイクロのエージェンティックAI関する調査でも述べたとおり、こうした変化こそが、アシスタントと本格的な「エージェント」を分ける重要な境界線となります。たとえば、Geminiのような従来型のアシスタントは依然として反応型にとどまっていますが、新しいChatGPTエージェントはすでにその境界を超えつつあり、最小限の入力で主体的にタスクを管理できる段階へと踏み出しています。

しかし、この自律性の向上は、従来のChatGPTでは想定されていなかった新たなリスクを生み出します。システムがユーザの監督をあまり必要としなくなった結果、悪意ある第三者がエージェントの行動に影響を与えたり、ユーザの意図に反する形で利用されたりする可能性が高まります。ユーザ自身がすぐには気づきにくい形で、操作や誤誘導が行われるリスクがあるのです。

タスクの複雑さ(A3: Task Complexity)に関するリスク

このリスクは、エージェントが実行可能なタスクの複雑さ(A3: Task Complexity)によってさらに深刻になります。従来のバージョンは指示を出すことにとどまっていましたが、新しいエージェントはユーザに代わって具体的なアクションを実行できます。その中には、たとえばファイルの誤削除、誤った相手へのメール送信、意図しない商品の注文といった、取り返しのつかない結果を招く可能性のある操作も含まれています。

これらのリスクを軽減するために、OpenAIは一連の安全対策を導入しています。たとえば、購入など実世界での重大な結果を伴う操作では、ユーザに明示的な確認を求める設計になっており、メール送信などのセンシティブなタスクでは、アクティブな監視が必要とされています。また、銀行振込のような高リスク操作はブロックされるようになっています。技術的にはエージェントが監視なしでも動作可能ですが、そのような使い方はユーザや組織に重大なリスクをもたらします。

これは、エージェントが今やOpenAIですら完全には予測できない形で悪用されうることを意味します。以前のChatGPTは、比較的単純で予測可能な思考パターンに従っていましたが、新しいエージェントは自律的に新しい領域を学習し、その中で推論を行うことができます。その結果、まったく未知のシナリオでも複雑な行動をとることが可能になっているのです。

計画立案と論理的推論(C1: Plan and Reason)に関するリスク

ただし、このように未知の領域において計画立案と論理的推論(C1: Plan and Reason)が高まることで、逆にプロンプトインジェクションやその他の巧妙な誘導による操作を受けやすくなるという新たなリスクも生まれます。たとえば、攻撃者がエージェントがアクセスするウェブページに、テキストやメタデータの中に悪意あるプロンプトを埋め込むことで、その行動を意図的に誤った方向へ導くことが可能になります。

だからこそ、エージェントをユーザの監視下に置くことが引き続き重要であると強調する必要があります。エージェンティックAIが進化を続けるなかで、安全性を確保するためには、人的な介入が不可欠です。ただし、常に人が関与していたとしても、すべてのリスクを排除できるわけではありません。同じような確認を繰り返すことで「確認疲れ」が生じ、ユーザが反射的に操作を承認してしまうおそれもあるのです。

ユーザ理解(C2: User Knowledge)とエコシステム統合(C3: Ecosystem Integration)に関するリスク

エージェントの機能におけるさらなる進化として挙げられるのが、ユーザ理解(C2: User Knowledge)です。従来のChatGPTは、言語設定や位置情報といった静的な情報を保持するのみでしたが、新しいエージェントは、ユーザとのやり取りを通じて継続的に学習します。行動パターンや好みを把握し、時間の経過とともに個別のニーズにより適応するようになります。

同時に、ユーザのエコシステム統合(C3: Ecosystem Integration)も大幅に向上しています。以前のアシスタントは特定のツールとの連携に限定されており、多くの場合、ユーザ自身が複数のサービスを手動でつなぐ必要がありました。一方、新しいChatGPTエージェントは、複数の情報源を1つのワークフローに自然に統合できます。たとえば、カレンダーを参照して空き時間を確認し、最近のメールから関連情報を抽出し、フォローアップの提案まで行うことが可能です。しかも、これらは外部ツールに頼ることなく完結します。

一見すると、こうした変化は小さな進歩に見えるかもしれません。しかし、その影響は特に_プライバシー_の観点から見ると非常に大きなものとなります。仮にエージェントが不正アクセスを受けた場合、それがユーザについて学習した内容が漏洩する可能性があります。さらに、エージェントがデジタルエコシステム全体と直接つながっているため、連携しているアカウントやログイン済みのウェブサイトから機密性の高い情報が漏れるおそれもあります。

こうしたリスクに対処するために、OpenAIはより厳格なプライバシー管理機能を導入しています。たとえば、閲覧履歴の削除やアクティブセッションからのログアウトが可能であり、自律モードで動作する際にはパスワードなどの機密情報を保存しない設計になっています。ただし、エージェントの能力が高まり、システムへの統合度が深まるほど、そのアクセス権限を本当に必要な範囲に限定することが極めて重要となります。利便性と制御性のあいだで慎重なバランスを取ることが求められます。

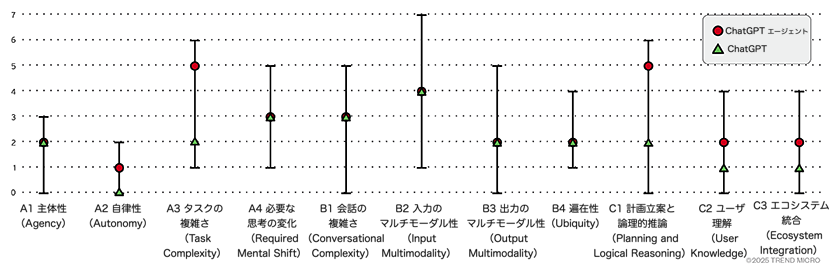

以下の図は、このような能力の変化を示したものであり、トレンドマイクロのフレームワークを用いて、新しいOpenAIエージェントと従来のChatGPTを比較しています。注目すべき点は、_自律性、ユーザ理解、エコシステム統合_といった一見わずかな進化が、リスクの構造そのものを大きく変える可能性を秘めていることです。

- A1. 主体性(Agency):ユーザに代わって行動を実行する能力

- A1.2 – アクション連携(Action chaining):デジタルアシスタントは一つのコマンドから複数のアクションを連鎖させることができる

- A2. 自律性(Autonomy):人間の入力なしに意思決定を行う能力

- A2.1 – 監督下での作業(Supervised work):デジタルアシスタントは監督の下で動作し、明示的なユーザ確認を必要とする

- A3. タスクの複雑性(Task complexity):日常業務において電話やPCを置き換える能力

- A3.5 – マルチアプリ置換(Multi-app replacement):デジタルアシスタントは関連アプリの機能を統合できる

- A4. 必要な意識転換(Required mental shift):アシスタントを使用するために必要な関与レベル

- A4.3 – 基本的な行動の委任(Basic actions delegation):ユーザに代わって基本的な行動をデジタルアシスタントに委任する意欲

- B1. 会話の複雑性(Conversational complexity):複雑な会話を持続する能力

- B1.3 – 自然な会話(Natural conversation):デジタルアシスタントは自然な会話ができる

- B2. 入力モダリティ(Input modality):異なるタイプの入力メディアを受け入れる能力

- B2.4 – 音声(Speech):デジタルアシスタントはネイティブな音声処理機能を持つ

- B3. 出力モダリティ(Output modality):様々なメディアで出力を生成または提供する能力

- B3.2 – マルチメディア(Multimedia):デジタルアシスタントは画像、音声、動画出力を生成できる

- B4. ユビキティ(Ubiquity):異なるデバイス間でユーザをフォローし支援する能力

- B4.2 – モバイル(Mobile):デジタルアシスタントは、ユーザが常に身近に持つデバイスを通じてアクセスできる

- C1. 計画と論理的推論(Planning and logical reasoning):計画を立て論理的に推論する能力

- C1.2 – 1-2ステップ推論(1-2 steps inference):デジタルアシスタントは数段階の思考の連鎖を確実に推論することができる

- C2. ユーザ知識(User knowledge):ユーザに関する情報を取得し保持する能力

- C2.1 – 静的知識(Static knowledge):デジタルアシスタントは、一般的に個人設定(言語、位置など)の形でユーザに関する基本的な知識を持つ

- C3. エコシステム統合(Ecosystem integration):より広いエコシステム内の情報にアクセスする能力

- C3.2 – ネイティブな複数プロバイダー連携(Natively chaining multiple providers):デジタルアシスタントは連続的なデータを連結できる

なお、これらの両者は共通して多くの課題を抱えている点にも留意すべきです。詳しくは、以前の調査で詳しく解説しています。

結論

拡張された機能を備えた新しいChatGPTエージェントは、単なるアシスタントのアップグレードにとどまらず、ユーザのデジタルライフにおける信頼できるパートナー、そして常に寄り添う存在へと進化しつつあります。その進歩の多くは一見すると小さなものに見えるかもしれませんが、たとえわずかな機能向上であっても、新たなリスクを生み出し、デジタルアシスタントとの関わり方や、それを守るために必要な対策のあり方に変化をもたらします。

本稿では、OpenAIの最新エージェントによって新たに生じたリスクに焦点を当ててきました。特に、アシスタントがより自律的になり、複雑なタスクを処理できるようになるにつれて高まる操作リスクは重要な懸念点です。それに加えて、ユーザについての理解が深まり、デジタルエコシステムへのアクセス範囲が広がることで、プライバシーに関する新たなリスクも顕在化しています。

エージェントの自律性が高まっているとはいえ、特に機密性の高い操作については、引き続きユーザによる積極的な監視を行うことが推奨されます。これにより、操作の誘導やその他の脅威によって生じる異常を早期に察知しやすくなります。

より強固で的確なセキュリティアプローチを構築するうえで、トレンドマイクロの「デジタルアシスタントフレームワーク」は有効な手段となります。これは一般ユーザ向けのツールだけでなく、企業環境で拡大しつつあるエージェンティックシステムに対しても有用です。AIがますます進化し、日常生活に深く組み込まれていくなかで、このフレームワークは、新たな機能とそれに伴うリスクとのバランスを理解するための重要な視点を提供します。

参考記事:

The Silent Leap: OpenAI’s New ChatGPT Agent Capabilities and Security Risks

By Salvatore Gariuolo and Rainer Vosseler

翻訳:与那城 務(Platform Marketing, Trend Micro™ Research)