Cyberrisiken

KI-gestützte Fertigungsstraßen für Angriffe

Kriminelle nutzen GenAI, um Texte, Bilder, Videos und Stimmen zu produzieren, die kombiniert als gut koordinierter automatisierter Scam-Ablauf in Fließbandfertigung erstellt und verbreitet werden. Wir zeigen mit Beispielen, was dahintersteckt.

Generative KI bietet eine ganze Reihe von Fähigkeiten, die idealerweise guten Zwecken dienen, doch die Praxis zeigt, dass Betrüger diese Möglichkeiten unter anderem auch nutzen, um alte Betrugsmaschen schneller, intelligenter und überzeugender zu gestalten.

Früher waren Scams schlampig aufgesetzt und daher leicht zu erkennen mit Rechtschreib- und Grammatikfehler, offensichtlich gefälschten Websites und unbeholfenen Anrufen. Heute kann GenAI innerhalb von Minuten überzeugende Fotos von Produkten mit Branding, fehlerfreier Sprache, realistischen Stimmen und lebensechten Videos erstellen. Das bedeutet, dass jeder mit Basis-Computerkenntnissen skalierbare Scams in großem Umfang starten kann, mit Nachrichten, Bildern und Videos, die so echt aussehen, dass selbst die aufmerksamsten Internetnutzer der Echtheit vertrauen.

Das perfekte Phishing

Die größte Herausforderung beim Phishing ist es nicht, eine gefälschte Website zu erstellen, sondern potenzielle Opfer dazu zu bringen, diese zu besuchen. Mithilfe von KI lassen sich Köder schreiben, die Menschen dazu bringen, auf den verdächtigen Link zu klicken: Moderne Tools erstellen in Sekundenschnelle Nachrichten, die so aussehen, als kämen sie von einer vertrauenswürdigen Quelle, nutzen in jeder Sprache natürliche Formulierungen und personalisieren den Inhalt, sodass er direkt auf Opfer zugeschnitten ist, die zuvor profiliert wurden.

Sobald der verdächtige Link angeklickt wird, werden die Opfer auf eine von KI generierte gefälschte Website weitergeleitet, die mit geklonten Logos, Layouts und sogar interaktiven Elementen ausgestattet ist, sodass sie sich genau wie das Original anfühlt. Cyberkriminelle nutzen Website-Builder von Vibe-Coding-Plattformen, um Anmeldeportale zu klonen, bevor sie auf einer legitimen Infrastruktur gehostet werden. Das Ergebnis bleibt gleich: gestohlene Anmeldeinfos, aber die Schnelligkeit und Qualität der Scams ist überzeugender.

Nicht existente Gesichter und Produkte

Generative KI kann Bilder erstellen, die so überzeugend sind, dass sie als offizielle Markenfotos durchgehen könnten, komplett mit makelloser Verpackung, perfekter Beleuchtung und sorgfältig inszeniert. In den Händen von Betrügern geht es um gefälschte Produkte oder sogar imaginäre Personen, die sie völlig realistisch erscheinen lassen, um ahnungslose Online-Nutzer zu täuschen.

Die KI erstellt komplett gefälschte Kundenbewertungen für nichtexistierende Produkte. Außerdem erstellen Cyberkriminelle mit GenAI online Personen, die mit den Opfern über KI-generierte, emotional ansprechende Nachrichten kommunizieren. Sobald das Opfer emotional involviert ist, erfindet der Betrüger einen Notfall und bittet um finanzielle Hilfe. Der Rest ist Geschichte.

Doppelgänger mit KI

Wo Bilder noch Raum für Zweifel lassen, kann ein Video den Ausschlag geben. KI produziert mittlerweile Videos, in denen Doppelgänger von Influencern, Verkäufern oder sogar Prominenten direkt mit Nutzern sprechen, als wären sie echt. Diese Videos werden als Werbung geschaltet, erscheinen in privaten Nachrichten oder sind Teil einer größeren Betrugskampagne. Zweck der KI-generierte Videos sind gefälschte Social-Media-Empfehlungen für Produkte oder Werbung bekannter Personen für Kryptowährungs-Investitionen sowie „virtuelle Entführungsszenarien”.

So gab es etwa Gruppen von KI-generierten Influencern auf TikTok, die irreführende Wellness-Produkte bewarben, die so realistisch waren, dass sie Tausende von Zuschauern täuschten. Laut dem Bericht von Trend Micro zu Deepfakes ermöglichen Fortschritte bei KI-generierten Videos und Deepfakes die Erstellung überzeugender Aufnahmen, die kostengünstiger, einfacher und schneller für Social-Engineering-Betrügereien zu produzieren sind.

KI-gestütztes Stimm-Klonen

Eine Stimme lässt sich aus nur wenigen Sekunden Audio klonen. Als Referenz kann ein Ausschnitt aus einem Podcast, ein kurzes Video in den sozialen Medien oder eine Voicemail dienen. Diese Technik wird zur neuen Waffe, um mit einer dem Opfer vertrauten Stimme dieses zu einer Handlung zu überreden, in Kombination mit KI-generierten Gesichtern und gestohlenen persönlichen Daten raffiniertere Scams zu erstellen, oder um durch Zusammenführen von KI-generierten Deepfake-Stimmen mit großen Sprachmodellen „virtuelle Entführungen” durchzuführen, bei denen die Opfer Anrufe erhalten, die überzeugend die verängstigte Stimme eines geliebten Menschen imitieren, Lösegeld fordern und die Angst und Panik des Opfers ausnutzen.

KI Scam-Fabriken entstehen

KI und Automatisierung haben die Spielregeln komplett verändert. Mit leicht zugänglichen KI-Tools und einfachen Automatisierungsplattformen kann eine Person innerhalb weniger Stunden und oft zu sehr geringen Kosten einen ausgefeilten, hochwertigen Scam erstellen. Die Elemente lassen sich nahtlos kombinieren: Ein Bild kann in ein Video eingefügt, mit einer geklonten Stimme unterlegt und gleichzeitig in sozialen Medien und auf Websites verbreitet werden. Die Automatisierung verbindet die einzelnen Schritte miteinander, sodass der gesamte Prozess fast vollständig von selbst abläuft.

Die Gefahr liegt nicht in der Technologie selbst, sondern in der Art und Weise, wie sie Geschwindigkeit und Qualität ermöglicht. Die Telemetriedaten von Trend Micro von Juni bis September 2025 ergaben, dass Liebesbetrug mit über drei Viertel der gemeldeten Vorfälle am häufigsten auftrat, während Warenbetrug an zweiter Stelle stand.

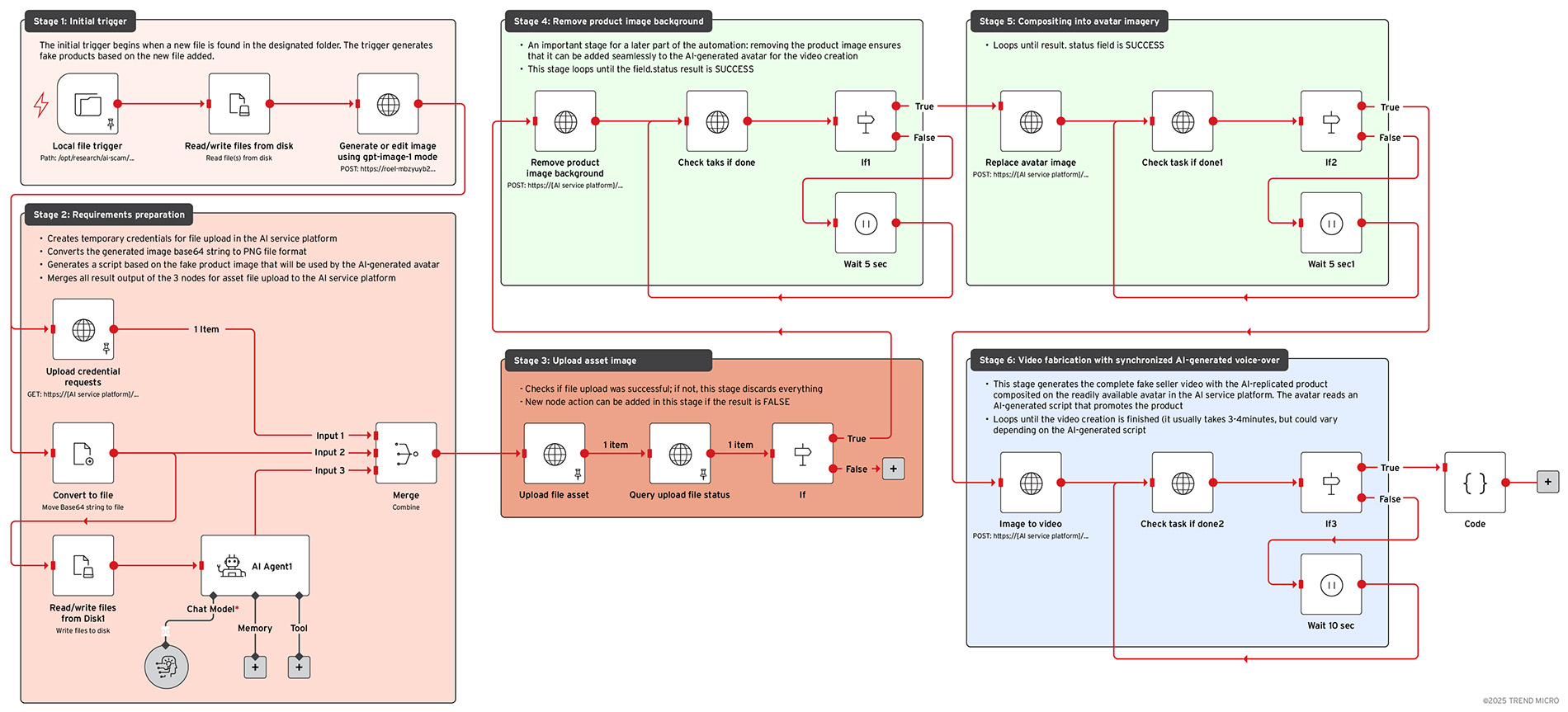

Trend Research hat n8n, eine Open-Source-Automatisierungsplattform, getestet, die verschiedene Apps und Dienste miteinander verbindet, und es Personen ohne fortgeschrittene Programmierkenntnisse ermöglicht, aus vorgefertigten Bausteinen ihr eigenes Mini-Softwaresystem zu erstellen, das dann auf bestimmte Ereignisse reagiert, Daten verarbeitet und automatisch Aktionen auslöst. Die von Trend Research erstellte Simulation versucht, die Art von Einrichtung nachzubilden, die ein realer Bedrohungsakteur verwenden könnte.

Im Test richteten wir einen agentenbasierten Workflow ein: eine Reihe von KI-Agenten, in der jeder eine Aufgabe übernimmt und das Ergebnis dann an das nächste weitergibt, ähnlich wie bei den einzelnen Schritten einer Fertigungsstraße. Dieser Prozess vereinte mehrere kommerzielle Dienste, darunter Bildgenerierung und -bearbeitung, Text-to-Speech und KI-Dienstplattformen, die sofort verfügbare Avatare und Videos anbieten. Mit nur minimalem menschlichem Aufwand verlief der Prozess von Anfang bis Ende reibungslos und lieferte realistische, sofort einsetzbare Inhalte. Eine ausführliche Beschreibung liefert der Originalbeitrag.

Auswirkungen

Da das System modular aufgebaut ist, können Akteure ganz einfach Prompts, Bilder oder Avatar-Vorlagen austauschen, um innerhalb weniger Stunden Hunderte einzigartiger Produktvarianten zu erstellen. Und da für die Darstellung kommerzielle Cloud-Dienste verwendet werden, erzielen sie professionelle Ergebnisse und können gleichzeitig ihre Spuren verwischen.

Es gibt bereits Berichte über die realen Auswirkungen der KI-gestützten Betrugs-Fließbandproduktion. Betrugsnetzwerke nutzen mittlerweile KI-gesteuerte Bots, um gefälschte Angebote zu verwalten, Kundeninteraktionen zu automatisieren und sogar das Verhalten authentischer Verkäufer auf mehreren Online-Marktplätzen und sozialen Plattformen nachzuahmen. Es gibt auch Berichte, wie automatisierte Tools Fälschern ermöglichen, Hunderte von gefälschten Produktangeboten gleichzeitig zu veröffentlichen, die Preise legitimer Verkäufer zu verfolgen und ihre Angebote in Echtzeit anzupassen, um wettbewerbsfähig zu bleiben.

Die digitale Täuschung geht über Bilder hinaus, da KI-gesteuerte Schreibtools auch glaubwürdige Fünf-Sterne-Bewertungen mit regionalem Slang und natürlichen Formulierungen erstellen, die von echten Kundenbewertungen kaum zu unterscheiden sind. Diese gut formulierten Bewertungen helfen Fälschungsverkäufern, schnell Vertrauen zu gewinnen und Käufer zu Impulskäufen zu verleiten.

So sehr Cyberkriminelle auch danach streben, immer überzeugendere Betrugsmaschen zu entwickeln, sind sie doch nach wie vor auf menschliches Versagen angewiesen, damit ihre Opfer auf ihre Social-Engineering-Taktiken hereinfallen. Ein Bericht von 2023 ergab, dass zwar 84 % der Verbraucher Bedenken hinsichtlich KI-gesteuerter Betrugsmaschen während der Weihnachtssaison äußerten, aber 67 % dennoch auf unbekannten Websites einkaufen würden. Es besteht weiterhin eine Diskrepanz zwischen dem Bewusstsein und dem Verhalten der Verbraucher.

Betrüger nutzen zudem KI-generierte Avatare von Fake-Influencern, die in einem KI-generierten Video für ein gefälschtes Produkt werben.

Cyberkriminelle können KI-generierte Marketing-Avatare nutzen, um vollständig gefälschte Online-Shops und Werbekampagnen zu erstellen mit Produktvideos, in denen Fake-Persönlichkeiten für das gefälschte Produkt werben, auf Kommentare reagieren und mit Followern interagieren, ohne dass eine reale Person hinter dem Konto steht.

So schützen Sie sich

Um sicher zu bleiben und Risiken fernzuhalten, reicht es heute nicht mehr, sich der Gefahr bewusst zu sein, sondern es sind intelligente Gewohnheiten erforderlich, um diesen sich ständig weiterentwickelnden Bedrohungen entgegenzutreten.

Einige Marken betten unsichtbare Wasserzeichen oder kryptografische Signaturen in ihre Medien ein, um die Authentizität leichter nachweisen zu können, dennoch bleibt die Aufklärung der Nutzer eine der stärksten Abwehrmaßnahmen.

Sicherheitsteams müssen verstärkt und die auf dem Markt verfügbaren Tools optimal nutzen, um Deepfakes, synthetische Videos und ungewöhnliche Muster im Internet zu erkennen, und Mitarbeiter und Nutzer mit denselben Tools ausstatten, um das Risiko durch menschliches Versagen zu minimieren.

Trend Micro Deepfake Inspector ist ein kostenloses Tool, das nach Betrugsversuchen mit KI-Gesichtstausch sucht und Benutzer in Echtzeit vor potenziellen Identitätsdiebstählen warnt. Es unterstützt auch dabei zu erkennen, ob in einem Live-Videogespräch Deepfake-Technologie verwendet wird.

Trend Micro ScamCheck bietet mehrere Funktionen, die nicht nur häufige Warnsignale und Betrugsversuche erkennen, sondern auch eine tiefere Analyse der Inhalte durchführen, um weniger offensichtliche Anzeichen für Online-Betrug zu finden. Es blockiert Spam- und Betrugstexte sowie Anrufe.

Diese Tools sind aber nur so stark wie die Benutzer, die sie einsetzen. Die Entwicklung praktischer Gewohnheiten, die mit der Entwicklung moderner Betrugsmaschen Schritt halten, kann Ihnen helfen, geschützt zu bleiben:

- Prüfen Sie genau, bevor Sie vertrauen. Überprüfen Sie immer URLs, E-Mail-Adressen, Anrufer-IDs und Produktdetails, bevor Sie handeln. Wenn etwas zu perfekt oder „zu gut, um wahr zu sein” erscheint, nehmen Sie sich einen Moment Zeit, um Nachforschungen anzustellen.

- Analysieren Sie Bewertungen und Angebote sorgfältig. Gefälschte Bewertungen sind oft ausgefeilt, aber unpersönlich. Achten Sie eher auf Feedback von verifizierten Käufern und realistische Rückmeldungen als auf allgemeine Kommentare.

- Seien Sie in Spitzenzeiten besonders wachsam. Betrüger wissen, wann Menschen am meisten einkaufen: Feiertage, Verkaufsveranstaltungen und Spendenaktionen sind die besten Zeiten für Betrug.

- Kontrollieren Sie, was Sie teilen. Geben Sie keine persönlichen Daten auf unbekannten Websites preis und vermeiden Sie es, zu viel in sozialen Medien zu teilen. Selbst kleine Fakten, wie Ihr Arbeitsplatz oder Ihre Reiseziele, können zusammengesetzt werden, um einen Betrug gegen Sie zu konstruieren.

- Schlagen Sie Alarm und melden Sie den Vorfall. Wenn Sie verdächtige Websites, Produkte oder Anzeichen für einen koordinierten Betrug sehen, melden Sie diese sofort. Eine frühzeitige Meldung hilft Plattformen und Ermittlern, diese zu entfernen, bevor sie sich auf weitere Opfer ausbreiten.

Die Verwendung von Markennamen, Produktbildern und ähnlichen Darstellungen bei der Nachbildung der KI-gestützten Fertigungsstraße dient ausschließlich Illustrationszwecken. Es besteht keine Absicht, Marken oder Produkte zu schädigen, herabzuwürdigen oder falsch darzustellen. Jede Ähnlichkeit mit tatsächlichen Produkten oder Marken ist rein zufällig und nicht beabsichtigt. Alle genannten Marken und Bilder bleiben Eigentum ihrer jeweiligen Inhaber.