Zusammenfassung

- Eine wirksame Abwehr erfordert Maßnahmen wie die Verfolgung der Datenherkunft, Verhaltenstests auf versteckte Auslöser und ein robustes Abhängigkeitsmanagement sowie Frameworks wie MITRE ATLAS zur Unterstützung der Bedrohungsmodellierung und -reaktion.

- Um systemische Risiken zu reduzieren, sollten KI-Ökosysteme die Einführung von Standards in Betracht ziehen – wie beispielsweise den Model Artifact Trust Standard, um kryptografische Signaturen und Überprüfbarkeit durchzusetzen, ein KI-spezifisches Netzwerk zum Austausch von Bedrohungen aufzubauen und fortschrittliche Erkennungsplattformen zu integrieren.

Die rasche Einführung von Open-Source-KI-Modellen setzt Unternehmen erheblichen Bedrohungen für die Supply Chain aus. Modelle mit Backdoors enthalten bösartige Verhaltensweisen als Auslöser, wodurch sie für statische Analysen, SBOMs oder Codeüberprüfungen nahezu unsichtbar sind. Wir haben die Gefahren ausführlich analysiert. Wie kann man jedoch diese Bedrohung erkennen?

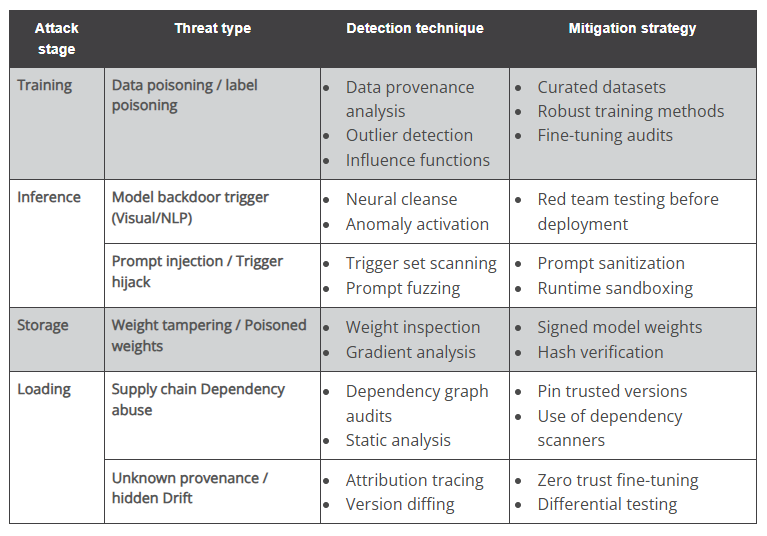

Backdoors in KI-Modellen unterscheiden sich von herkömmlicher Malware: Sie verhalten sich oft ganz normal, bis sie durch einen Trigger ausgelöst werden. Daher reicht eine herkömmliche statische Codeanalyse für eine zuverlässige Erkennung nicht aus. Die folgende Tabelle zeigt die realen Risiken, Techniken der Erkennung sowie Kontrollmechanismen, um sicherere Open-Source-KI-Systeme einzusetzen.

Zur Unterstützung einer strukturierten Bedrohungsmodellierung und des Red Teaming von KI-Systemen sollten Sicherheitsteams das MITRE ATLAS-Framework übernehmen. Die vollständige Umsetzung der Erkenntnisse aus MITRE ATLAS bedarf der Sicherheitslösungen, die über eine einfache Bedrohungsabbildung hinausgehen und Risiken aktiv in Echtzeit mindern, so etwa Trend Vision One™ . Siehe Einzelheiten dazu im Originalbeitrag.

Empfehlungen

Hosting von Open Source-Plattformen (z.B. Hugging Face, GitHub, PyPI)

- Erzwingen Sie die kryptografische Signatur hochgeladener Modelldateien und zugehöriger Artefakte.

- Verlangen Sie vollständige und standardisierte Metadaten (z. B. Trainingsdatenquellen, Hyperparameter und Modellherkunft).

- Führen Sie während des Uploads automatische Scans auf Malware, schädliche Skripte und verdächtige Abhängigkeiten durch.

- Führen Sie nicht veränderbare Audit-Protokolle über Modell-Uploads, -Aktualisierungen und -Löschungen, die über die API zugänglich sind.

- Erleichtern Sie den Austausch von KI-spezifischen Bedrohungsinformationen zwischen Plattformen, Anbietern und Forschern.

Modellentwickler und Mitwirkende

- Verwenden Sie reproduzierbare Trainings-Pipelines, die offenen Zugriff auf Trainingsskripte, Datenreferenzen und Konfigurationsdateien bieten.

- Signieren Sie Modellgewichte und Trainingscode, um die Integrität nachgeschalteter Prozesse sicherzustellen.

- Verwenden Sie nur verifizierte und aktiv gepflegte Abhängigkeiten; vermeiden Sie veraltete und nicht geprüfte Pakete.

- Fügen Sie Verhaltenstestsuiten hinzu, die eine sichere und erwartete Modellleistung demonstrieren.

- Geben Sie die Namen und Quellen von Feinabstimmungsdatensätzen sowie manuelle Dateninterventionen in der Modelldokumentation klar an.

KI-Entwickler und nachgelagerte Nutzer

- Behandeln Sie alle vorab trainierten Modelle standardmäßig als nicht vertrauenswürdig und validieren Sie sie vor der Integration.

- Führen Sie Verhaltenstests wie Anomalieaktivierung und Red-Teaming durch, um potenzielle Backdoors zu erkennen.

- Verwenden Sie verifizierte und signierte Modelle aus vertrauenswürdigen Registern. Plattformen wie Docker drängen auf „vertrauenswürdige” Modellregister, die kryptografische Signaturen enthalten, um die Authentizität und Integrität von Modellen sicherzustellen. Priorisieren Sie Quellen, die eine solche Verifizierung anbieten.

- Fixieren Sie Abhängigkeitsversionen und verwenden Sie Supply-Chain-Scanner, um bekannte Risiken zu erkennen.

- Isolieren Sie die Modellausführung durch Einsatz von Containern oder Sandboxing, um laterale Bewegungen oder den Systemzugriff zu begrenzen.

- Verwenden Sie Ensemble-Techniken oder mehrschichtige Entscheidungssysteme in risikoreichen oder Produktionsumgebungen, um das Risiko einer Modellkompromittierung zu mindern.

- Setzen Sie Plattformen ein, die integrierte Telemetrie und Anomalieerkennung bieten, um verdächtiges Modellverhalten und laterale Bewegungen, die von KI-gesteuerten Prozessen ausgehen, zu melden.

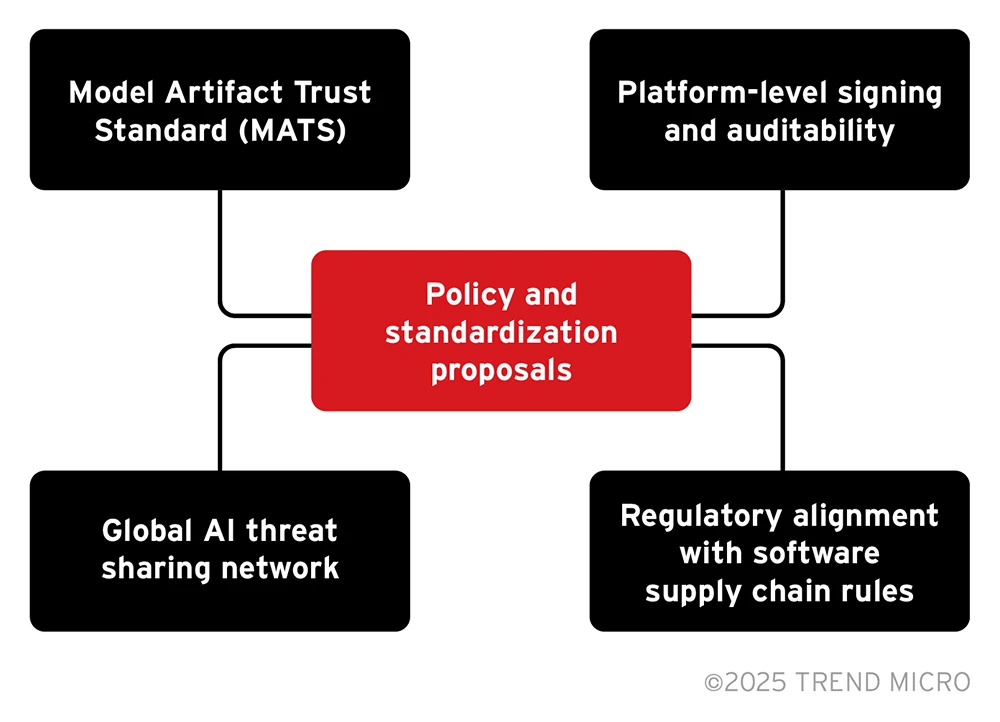

Vorschläge für Richtlinien und Standardisierung

Da KI zunehmend in eine Vielzahl von Branchen integriert wird, erfordert die Sicherheit von Open-Source-KI-Modellen Aufmerksamkeit auf politischer Ebene.

Model Artifact Trust Standard (MATS)

Aufbauend auf der SPDX 3.0 AI-BOM-Grundlage bieten wir einen Vorschlag, den wir als Model Artifact Trust Standard bezeichnen und der die bestehenden Standards erweitert, um modellspezifische Sicherheitsanforderungen zu erfüllen, wie:

- Herkunft der Trainingsdaten: Klare Dokumentation der Datenquellen, Erfassungsmethoden und Vorverarbeitungsschritte.

- Vollständiges Abhängigkeitsmanagement: Pflege nicht nur von Bibliotheken und Frameworks, sondern auch von aufgezeichneten Modellgewichten und Umgebungskonfigurationen.

- Kryptografische Gewichts-Hashes

- Feinabstimmung der Abstammung: Verfolgen von Versionen, Daten und Methodik des Transferlernens.

- Nachweis der Verhaltensvalidierung: Einbeziehung der Ergebnisse von Robustheitstests gegen Angriffe und triggerbasierter Verhaltenszusammenfassungen.

Das AI-Profil von SPDX enthält bereits Elemente wie grundlegende Metadaten (Modellname, Version und Autoren), Datensatzreferenzen (einschließlich Lizenzierung und Herkunft), Modellherkunft, Softwareumgebung und Abhängigkeiten. MATS baut darauf auf und konzentriert sich verstärkt auf sicherheitsrelevante Metadaten und Verhaltenstests.

Signierung und Überprüfbarkeit auf Plattformebene

Plattformen wie Hugging Face und GitHub müssen die kryptografische Signierung von Modellen standardmäßig unterstützen, alle Modell-Uploads und -Änderungen in einem unveränderlichen Audit-Protokoll protokollieren und öffentliche APIs zur Überprüfung bereitstellen.

Die Umsetzung dieser Maßnahmen trägt dazu bei, eine Kontrollkette zu schaffen, um Manipulationen und böswillige Akteure zu identifizieren.

Regulatorische Angleichung an die Regeln für die Software-Supply-Chain

Erweiterung des EU-Cyberresilienzgesetzes um eine ausdrückliche Einbeziehung von KI-Modellen, ähnlich wie das NIST das Secure Software Development Framework (SSDF) von NIST 800-218 auf NIST 800-218A erweitert hat, um KI-spezifische Risiken zu berücksichtigen: Modelle als Artefakte im Software-Lebenszyklus sowie Risikokategorisierung für vortrainierte, fein abgestimmte und kompositorische Modelle.

KI-spezifische Angriffsflächen sind noch nicht in Richtlinien oder Versicherungsstandards berücksichtigt.

Globales Netzwerk zum Austausch von KI-Bedrohungen

Ein kollaboratives Framework, analog zum CVE/CWE-Modell, jedoch speziell für KI-Systeme entwickelt. Es geht um

- Prompt-Injection-Techniken, Modell-Backdoors und Datenvergiftungsvektoren einbeziehen.

- Förderung der Meldung von Bedrohungen durch Red Teams, Forscher und Anbieter.

- Gewährleistung eines robusten Informationsaustauschs, von dem Verteidiger und Sicherheitsexperten erheblich profitieren können.

Die meisten KI-spezifischen Bedrohungen bleiben isoliert, werden nicht gemeldet oder nicht dokumentiert.

Fazit

Modell-Backdoors stellen eine neue Herausforderung für die Software-Supply-Chain-Sicherheit dar. Sie nutzen genau die Stärken von Open-Source-KI aus: Geschwindigkeit, Wiederverwendbarkeit und Kombinierbarkeit.

Um sich dagegen zu schützen, müssen Unternehmen

- das Vertrauen in vorab trainierte Modelle überdenken

- Verhaltenstests als Norm und nicht als Ausnahme einführen

- Sichere Modell-Pipelines mit überprüfbarer Herkunft und kontrollierten Abhängigkeiten aufbauen.

- Frameworks wie MITRE ATLAS einsetzen, um KI-spezifische Bedrohungen bekannten feindlichen Verhaltensweisen zuzuordnen und strukturierte Abwehrmaßnahmen zu ermöglichen.

Plattformen wie Trend Vision One für Telemetrie und Anomalieerkennung wählen, um verdächtiges Verhalten und Bewegungen von KI-Modellen aufzudecken.