La sécurité de l’IA désigne à la fois la protection des technologies d’IA et l’utilisation de l’IA pour renforcer la cybersécurité, en améliorant la détection des vulnérabilités et les réponses proactives aux menaces.

Table des matières

Sécurité de l'IA

Le terme « intelligence artificielle » (IA) a été inventé pour la première fois dans les années 1950 pour décrire les ordinateurs et les machines qui imitent la structure et la fonction du cerveau humain pour effectuer des tâches complexes, résoudre des problèmes complexes, prédire les résultats futurs et apprendre de l’expérience.

La sécurité de l’IA (également appelée sécurité de l’intelligence artificielle ou « sécurité pour l’IA ») est une branche de la cybersécurité qui englobe tous les processus, pratiques et mesures que les organisations utilisent pour sécuriser leur stack IA et protéger leurs systèmes, données et applications d’intelligence artificielle contre les menaces potentielles. Cela inclut l’utilisation d’outils et de technologies optimisés par l’IA pour :

- Sécuriser tous les aspects du réseau d’IA d’une organisation, des endpoints aux modèles d’IA

- Protéger les modèles, systèmes et applications d’IA contre un large éventail de cybermenaces, de cybercriminels et de cyberattaques

- Identifier et atténuer les failles ou vulnérabilités dans les défenses de sécurité et de cybersécurité de l’IA avant qu’elles ne puissent être exploitées

- Protéger l’infrastructure d’IA et les données d’entraînement pour éviter la corruption, l’empoisonnement ou le vol de données des modèles d’IA

- Assurer la qualité et l’intégrité des données des grands modèles de langage d’IA (LLM), des moteurs d’IA générative (GenAI) et des pipelines d’apprentissage profond et d’apprentissage automatique (ML)

- Traiter les problèmes et préoccupations éthiques potentiels concernant les questions de biais, de transparence, de confidentialité des données et d’explicabilité

- Assurez-vous que l’utilisation, les données et le développement de l’IA sont entièrement conformes aux lois, politiques d’entreprise et réglementations sectorielles en vigueur.

Sécurité de l’IA VS Cybersécurité basée sur l’IA

Bien que les deux termes semblent presque identiques, il existe une différence essentielle entre la sécurité de l’IA et la cybersécurité de l’IA.

La sécurité de l’IA consiste à sécuriser l’IA elle-même, à protéger le stack IA d’une organisation et à sécuriser ses systèmes, composants, réseaux et applications d’IA.

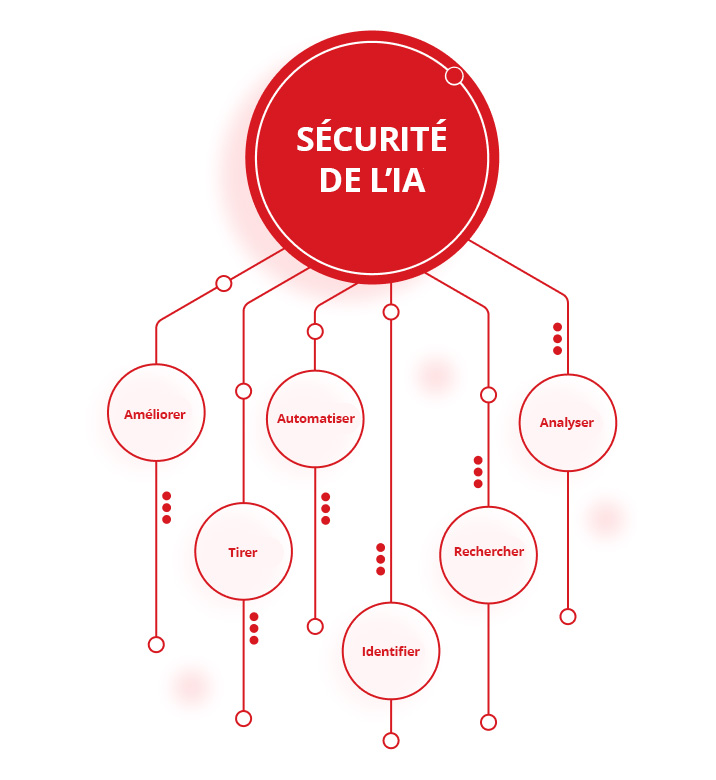

La cybersécurité basée sur l’IA (également appelée « IA pour la sécurité ») consiste à utiliser des outils et technologies d’IA pour protéger les infrastructures IT contre les cybercriminels, les cyberattaques et d’autres cybermenaces. Cela inclut l’utilisation de l’IA pour :

- Analyser de grands volumes de données et détecter les schémas, identifier les anomalies et mettre en évidence les risques de sécurité potentiels

- Rechercher et restaurer les lacunes et vulnérabilités dans les défenses de cybersécurité d’une organisation

- Identifier et se défendre contre les violations de données et autres cyberattaques en temps réel

- Automatiser les outils de détection et de réponse aux menaces pour réduire la demande des équipes de sécurité et améliorer la vitesse et la précision des cyberdéfenses

- Tirer parti des dernières informations sur les menaces pour garder une longueur d'avance sur les acteurs malveillants et rester au fait des vecteurs d'attaque nouveaux ou émergents

- Améliorer les stratégies et capacités globales de gestion des cybermenaces d'une organisation

L’importance de sécuriser les systèmes d’IA

Bien que l’idée de l’intelligence artificielle existe depuis des décennies, les progrès récents dans la technologie IA ont transformé nombre de secteurs, allant du transport et des soins de santé à la cybersécurité. Malheureusement, l’adoption généralisée de l’IA a permis aux acteurs malveillants de l’exploiter, entraînant une augmentation significative du nombre, de la portée et de la sophistication des cyberattaques.

Par conséquent, les organisations doivent s’assurer qu’elles font tout leur possible pour maintenir l’intégrité, la confidentialité et la disponibilité de leurs données d’IA, protéger leurs outils et applications d’IA contre les cyber-risques et les cyberattaques nouveaux et émergents, et protéger leurs modèles, systèmes et algorithmes d’IA contre une grande variété de cybermenaces en évolution constante.

Le fait de ne pas protéger et sécuriser les systèmes d’IA contre l’une de ces menaces pourrait potentiellement exposer une organisation à une attaque, mettre ses clients et partenaires en danger et leur coûter des millions de dollars en dépenses de remédiation, demandes de rançon, ventes perdues et productivité perdue.

Quels sont les risques pour la sécurité de l’IA ?

Le potentiel de l’intelligence artificielle pour révolutionner le domaine de la cybersécurité est clairement prometteur. Mais il existe un nombre croissant de risques et de défis en matière de sécurité de l’IA que les organisations doivent prendre en compte lors de la mise en œuvre d’une stratégie de sécurité de l’IA efficace. Parmi ces risques :

- Risque d’une surface d’attaque accrue : l’intégration de modèles d’IA propriétaires et tiers dans l’infrastructure IT d’une organisation peut considérablement étendre sa surface d’attaque, augmenter le nombre de points faibles que les acteurs malveillants peuvent exploiter et rendre les systèmes d’IA vulnérables aux cyberattaques plus puissantes ou fréquentes.

- Risque d’attaques malveillantes ou contradictoires sur les données et algorithmes d’IA : les acteurs malveillants peuvent obtenir un accès non autorisé aux outils et données d’IA, manipuler les données et algorithmes d’IA pour insérer des erreurs ou des biais, mettre en danger la capacité des modèles d’IA à faire des prédictions précises ou à se défendre contre les futures attaques, et manipuler, abuser ou voler des modèles et algorithmes d’IA.

- Risque d’empoisonnement, de corruption et de manipulation des données : les cybercriminels peuvent corrompre les pipelines d’apprentissage automatique (ML) ou « empoisonner » les modèles d’IA en modifiant délibérément leurs données d’entrée ou en insérant de nouvelles données pour compromettre les outils et systèmes d’IA.

- Risque pour les modèles d’entraînement de l’IA : les cybercriminels peuvent voler, manipuler ou procéder à une rétro-ingénierie des modèles propriétaires d’entraînement de l’IA. Ils peuvent également corrompre, pirater ou falsifier les données utilisées pour développer et former des modèles d’IA afin de compromettre leur précision, leur efficacité et leur intégrité.

- Risque de préjugés, de discrimination, de confidentialité des données et de manque de transparence : les erreurs humaines et les cyberattaques peuvent augmenter les préoccupations et les préjugés en matière de confidentialité des données dans les modèles d’IA et potentiellement compromettre les principes de transparence, d’équité et de responsabilité.

- Risque de non-conformité aux réglementations du secteur et du gouvernement : le non-respect de la protection des données sensibles, personnelles ou confidentielles peut entraîner de lourdes pénalités et des accusations de non-conformité de la part des organismes de réglementation gouvernementaux et du secteur, notamment dans le cas du Règlement général sur la protection des données (RGPD).

- Risque d’attaques contre des fournisseurs tiers : les pirates peuvent cibler les systèmes d’IA n’importe où dans la chaîne d’approvisionnement d’une organisation pour tirer parti des faiblesses dans les réseaux, composants, frameworks et bibliothèques logicielles d’IA de partenaires tiers, puis utiliser ces vulnérabilités pour cibler d’autres modèles d’IA n’importe où ailleurs dans la chaîne.

- Risques de dérive et de dégradation du modèle d’IA : au fil du temps, tous les modèles d’IA peuvent être vulnérables à la dérive ou à la dégradation. Les acteurs malveillants peuvent exploiter des modèles d’IA dégradés ou en dérive pour modifier leur comportement ou compromettre leur précision et leur fiabilité.

- Risque de vol d’informations d’identification de chatbot : les cybercriminels peuvent voler des informations d’identification de chatbot pour des fournisseurs d’IA tels que ChatGPT ou acheter des informations d’identification volées sur le dark web et les utiliser pour obtenir un accès illégal à des outils et systèmes d’IA propriétaires.

- Risque de photos, de vidéos et d’audio deepfake : les acteurs malveillants peuvent utiliser des images et des vidéos factices générées par l’IA pour escroquer des organisations, extorquer des personnes ou des entreprises, inciter les employés à accorder l’accès à des systèmes critiques, divulguer des informations confidentielles ou voler des données précieuses.

- Risque d'attaques directes et indirectes par injection rapide : les attaques par injection rapide peuvent utiliser du code malveillant pour piéger les grands modèles de langage (LLM) et d'autres outils d'IA pour aboutir à des fuites d'informations sensibles, des accès non autorisés ou la suppression de documents clés.

- Risque d’abus de l’IA : les acteurs malveillants peuvent tirer parti des « hallucinations » courantes de l’IA pour compromettre délibérément les données sur lesquelles reposent les modèles d’IA et les décisions qu’ils prennent.

- Risques pour les actifs et l’infrastructure cloud : les cybercriminels peuvent pirater des modèles d’IA basés sur le cloud et corrompre ou voler leurs données et autres actifs.

Si les organisations ne s’assurent pas que leurs mesures de sécurité et de cybersécurité de l’IA sont aussi robustes, complètes et à jour que possible, les acteurs malveillants peuvent exploiter ces risques et d’autres pour nuire à l’efficacité et à la fiabilité des modèles d’IA, voler des données sensibles ou privées, et potentiellement causer un préjudice financier et réputationnel important.

Quels sont les avantages de la sécurité de l’IA ?

Les organisations qui mettent en œuvre des mesures de sécurité de l’IA pour sécuriser leurs stacks d’IA bénéficient d’un certain nombre d’avantages convaincants. Il s’agit notamment de capacités améliorées pour :

- Protéger leurs données d’IA contre la compromission, la corruption, la manipulation, la violation ou le vol

- Sécuriser les modèles d’IA contre les pirates ou les cyberattaques en faisant appel à la détection et la réponse aux menaces en temps réel, la traque des menaces et des outils/technologies d’analyse des vulnérabilités

- Protéger les infrastructures d’IA en éliminant de manière proactive les failles ou vulnérabilités dans les cyberdéfenses, en gérant et en atténuant les cyber-risques et en protégeant les actifs d’IA

- Sécuriser les utilisateurs d’IA et les applications locales contre les attaques de code malveillant, les accès illégaux ou non autorisés, les schémas de fraude et de phishing, ainsi que les attaques de malware et de ransomware

- Contrôler l’accès aux services d’IA privés et publics, y compris les modèles LLM (Large Language Model)

- Se défendre contre les attaques zero-day qui ciblent des vulnérabilités logicielles ou matérielles inconnues jusqu’alors et permettre aux acteurs malveillants de voler des données, de pirater des informations confidentielles, d’installer des malware et autres virus, ou d’accéder à l’infrastructure IT d’une organisation

Meilleures pratiques pour la sécurité de l’IA

Les solutions de sécurité d’IA les plus efficaces suivent un certain nombre de bonnes pratiques standard du secteur pour protéger leurs outils et ressources d’IA et améliorer leur posture de sécurité. Ces pratiques comprennent :

- Le développement d’une stratégie de sécurité IA complète qui combine la modélisation avancée des menaces et les activités de traque des menaces avec des capacités d’évaluation des risques basées sur l’IA, des contrôles de sécurité IA complets, et des plans et procédures détaillés de réponse aux incidents pour protéger les systèmes et données IA d’une organisation.

- La garantie de la qualité, de l’intégrité et de la fiabilité des données d’entraînement de l’IA pour traiter les problèmes liés à la transparence, aux biais et à l’explicabilité, et s’assurer que les modèles d’IA sont aussi précis et efficaces que possible.

- La mise en œuvre de cadres de sécurité d’IA standard pour établir un ensemble clair de normes et de directives pour sécuriser les systèmes d’IA, éliminer les lacunes ou les vulnérabilités dans les défenses de l’IA et maintenir la conformité avec toutes les réglementations pertinentes en matière de sécurité de l’IA. Cela inclut l’intégration de cadres de sécurité tels que le cadre de gestion des risques d’intelligence artificielle du National Institute of Standards and Technology (NIST), la matrice MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) et le cadre Sensible Regulatory Framework for AI Security de MITRE, la liste Open Worldwide Application Security Project (OWASP) des 10 meilleures pratiques pour les modèles LLM (Large Language Model), les principes Secure AI Framework (SAIF) de Google, ainsi que les normes ISO/IEC 27001 pour les systèmes de gestion de la sécurité de l’information (ISMS).

- Intégration de la sécurité de l’IA dans les mesures de sécurité et de cybersécurité existantes pour créer une protection de bout en bout transparente contre les cybermenaces pour toutes les applications, outils, systèmes et réseaux d’IA et informatiques.

- Mener régulièrement des programmes de formation et de sensibilisation des employés pour sensibiliser les équipes de cybersécurité et les autres employés aux dernières menaces et mesures de sécurité, et favoriser une culture d’entreprise basée sur une amélioration continue.

- Surveiller, évaluer et mettre à jour en continu les modèles d’IA pour rechercher et atténuer les vulnérabilités dans les outils et systèmes d’IA, identifier les menaces émergentes à mesure qu’elles surviennent, et affiner constamment les modèles et applications d’IA pour améliorer leur précision, leurs performances et leur fiabilité.

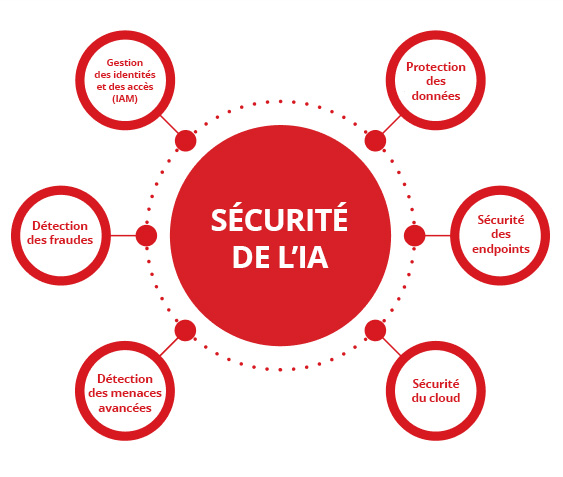

Exemples d’applications de cybersécurité basée sur l’IA

À mesure que les outils d’intelligence artificielle deviennent de plus en plus avancés, les utilisations et applications potentielles de l’IA dans la cybersécurité s’étendent chaque jour.

Entre autres avantages, les applications de cybersécurité basées sur l’IA peuvent améliorer considérablement la portée et l’efficacité des défenses de cybersécurité d’une organisation en automatisant ses activités de détection des menaces et de réponse aux incidents, en effectuant des analyses de vulnérabilité et d’autres mesures proactives de manière régulière ou continue, et en utilisant les informations sur les menaces et analyses de sécurité les plus récentes pour prédire, anticiper et protéger les organisations contre les cybermenaces nouvelles et émergentes.

Parmi les applications de cybersécurité basées sur l’IA les plus efficaces et largement adoptées, on peut citer l’utilisation de l’intelligence artificielle dans la protection des données, la sécurité des endpoints, la sécurité du cloud, la traque avancée des menaces, la détection des fraudes et la gestion des identités et des accès (IAM).

Protection des données

Les organisations peuvent utiliser l’IA pour classer et chiffrer leurs informations confidentielles ou sensibles, surveiller l’accès aux systèmes pour détecter les violations de données plus rapidement et avec plus de précision, protéger les données d’IA contre la perte ou la corruption, et sécuriser leur stack d’IA contre l’accès, l’utilisation ou la divulgation non autorisés. Cependant, les zones d’ombre sur les informations sensibles dans les environnements d’IA peuvent entraîner de graves violations de données et des problèmes de conformité, ce qui rend essentiel l’identification et l’atténuation proactives de ces vulnérabilités.

Sécurité des endpoints

Les solutions de détection et de réponse aux endpoints (EDR) optimisées par l’IA peuvent aider à protéger les ordinateurs portables, les postes de travail, les serveurs informatiques, les appareils mobiles et d’autres endpoints réseau en temps réel, en détectant et en bloquant de manière proactive les malware, les ransomware et autres cyberattaques avant qu’elles ne se produisent.

Sécurité du cloud

Les technologies de sécurité cloud basées sur l’IA peuvent surveiller et contrôler l’accès aux environnements cloud 24 h/24, identifier toute anomalie ou activité suspecte, alerter les équipes de sécurité des menaces potentielles lorsqu’elles se produisent, et protéger les données et applications basées sur le cloud contre les accès non autorisés et les violations de données.

Détection des menaces avancées

Les outils avancés de recherche des menaces par IA peuvent analyser rapidement et facilement les logs de données, les modèles de trafic réseau, les activités et les comportements des utilisateurs pour rechercher des attaques malveillantes, détecter les cybercriminels en action avant qu’ils ne puissent causer des dommages durables, et protéger les systèmes et l’infrastructure d’IA contre les menaces persistantes avancées (APT) et d’autres cyberattaques.

Détection des fraudes

Les organisations des secteurs des services bancaires et financiers peuvent utiliser des algorithmes d’apprentissage automatique (ML), des réseaux neuronaux et d’autres technologies d’IA avancées pour détecter les activités potentiellement frauduleuses, bloquer l’accès non autorisé aux comptes bancaires ou autres comptes en ligne, et prévenir l’usurpation d’identité dans les transactions financières et de commerce électronique.

Gestion des identités et des accès (IAM)

Les solutions de gestion des identités et des accès (IAM) basées sur l’IA peuvent aider les organisations à surveiller et sécuriser chaque étape de leurs processus d’authentification, d’autorisation et de gestion des accès pour s’assurer qu’elles respectent toutes les politiques et tous les playbooks de l’entreprise en matière d’IA, maintenir la conformité aux réglementations du secteur, empêcher l’accès non autorisé aux données sensibles et empêcher les pirates informatiques d’accéder à leurs systèmes.

Où puis-je obtenir de l’aide sur la sécurité de l’IA ?

Trend Vision One ™ est une plateforme tout-en-un axée sur la cybersécurité basée sur l’IA.

Trend Vision One propose un ensemble d’outils et de technologies d’IA leaders de l’industrie, capables de détecter, prédire et prévenir les cybermenaces beaucoup plus rapidement et efficacement que les équipes de sécurité traditionnelles gérées par des humains. Pour assurer une sécurité efficace du stack d’IA, il faut protéger chaque couche, des données à l’infrastructure, en assurant la visibilité sur les environnements d’IA fantômes, en appliquant des contrôles d’accès stricts à des fins de conformité et en établissant des garde-fous pour les API d’IA, ceci afin d’éviter l’utilisation abusive et l’empoisonnement des modèles. Ces fonctionnalités permettent aux organisations de sécuriser l’ensemble de leur stack d’IA et de protéger leurs données, applications et systèmes d’IA contre la grande majorité des cyberattaques avant qu’elles ne se produisent.

Trend Vision One inclut également les fonctionnalités inégalées de Trend Cybertron, la première IA de cybersécurité véritablement proactive au monde. En s'appuyant sur la collection éprouvée de grands modèles de langage (LLM) de Trend Micro, de jeux de données, d'agents d'IA avancés et de plus de 20 ans d'investissement dans le domaine de la sécurité de l'IA, Trend Cybertron peut analyser les modèles historiques et les données pour prédire les attaques spécifiques à chaque client, permettre aux organisations d'atteindre des délais de remédiation 99 % plus rapides par rapport à une approche traditionnelle et rendre les opérations de sécurité d'une organisation plus proactive.

Trend Cybertron a également été conçu pour évoluer et s'adapter en continu afin de suivre les changements dans les besoins d'une organisation et de rester au fait des dernières tactiques, techniques et procédures (TTP) employées par les cybercriminels. Cela permet aux organisations de s’assurer que leurs défenses de sécurité et de cybersécurité de l’IA sont toujours aussi robustes, complètes et à jour que possible.

Michael Habibi est un leader de la cybersécurité avec plus de 12 ans d’expérience, spécialisé dans le développement de produits et l’innovation stratégique. En tant que vice-président de la gestion des produits chez Trend Micro, Michael dirige l'alignement de la stratégie produit des endpoints avec le paysage des menaces en évolution rapide.

Foire aux questions (FAQ)

Qu’est-ce que la sécurité de l’IA ?

La sécurité pour l’IA (ou « sécurité de l’IA ») est l’utilisation de différents outils, pratiques et technologies pour sécuriser la pile d’IA d’une organisation.

Quelle est la signification de l’IA dans la sécurité ?

L’IA fait référence à l’« intelligence artificielle ». L’IA est utilisée dans la sécurité pour améliorer les défenses de cybersécurité d’une organisation et protéger les piles d’IA.

Comment l’IA peut-elle être utilisée dans la sécurité ?

L’IA peut être utilisée pour protéger les réseaux, modèles, systèmes, endpoints et applications d’IA contre les cyberattaques, la corruption de données et d’autres menaces.

Qu’est-ce que l’IA dans la cybersécurité ?

L’IA dans la cybersécurité fait référence à l’utilisation d’outils et de technologies d’IA pour aider à protéger les organisations contre les cyberattaques.

L’IA est-elle un risque pour la sécurité ?

Comme toute technologie, l’IA peut être utilisée pour améliorer les mesures de sécurité ou lancer des cyberattaques plus puissantes.

La sécurité de l’IA est-elle une bonne carrière ?

La sécurité de l’IA est un domaine en pleine croissance qui offre de nombreuses opportunités de carrière difficiles et bien rémunérées.

Combien les agents de sécurité de l’IA gagnent-ils ?

En fonction de leur expérience et de leur emplacement, les agents de sécurité de l’IA peuvent gagner entre 60 000 et plus de 120 000 USD par an.

Comment puis-je accéder à la sécurité de l’IA ?

Les cours de formation en ligne, les diplômes en informatique ou en cybersécurité et les certifications de sécurité de l’IA sont tous de bons points de départ pour une carrière dans la sécurité de l’IA.

Quelle est la différence entre la cybersécurité et la sécurité de l’IA ?

La cybersécurité fait référence aux outils ou systèmes qui protègent les organisations contre les cyberattaques. La sécurité de l’IA consiste à protéger la pile d’IA d’une organisation.

L’IA peut-elle assurer la cybersécurité ?

Sous supervision humaine, les technologies d’IA peuvent améliorer considérablement la vitesse, la précision et l’efficacité de presque tous les aspects de la cybersécurité.

Quelle est la différence entre la cybersécurité traditionnelle et la cybersécurité basée sur l’IA ?

Bien que leurs objectifs et méthodes soient les mêmes, la cybersécurité basée sur l’IA peut fournir une protection plus rapide, plus précise et plus proactive que la cybersécurité traditionnelle.

La cybersécurité nécessite-t-elle un codage ?

Bien que le codage puisse être une compétence précieuse pour de nombreux postes de cybersécurité, il existe de nombreux postes dans la cybersécurité qui ne nécessitent aucune expérience ou expertise en codage.

Pourquoi l’IA est-elle une menace pour la sécurité ?

L’IA peut être utilisée par les acteurs malveillants pour pirater les systèmes informatiques, voler des données confidentielles, corrompre des piles d’IA ou lancer des cyberattaques sophistiquées.

Quel est un exemple de violation de données d’IA ?

Les deepfakes de l’IA ont été utilisés pour simuler les voix ou les images vidéo de personnes réelles, convainquant les employés des organisations de partager des informations confidentielles qui auraient dû être tenues confidentielles.

L’application de sécurité IA est-elle sûre ?

En fin de compte, la sécurité d’une application de sécurité dépend de la fiabilité de son développeur, et non de son prix. Restez fidèle aux grandes marques testées de manière indépendante et évitez les applications de sources inconnues.

Quels sont les risques liés à la sécurité avec l’IA ?

Certains risques courants associés à la sécurité de l’IA comprennent des surfaces d’attaque étendues, l’empoisonnement et la corruption des données, ainsi que des risques pour les données, les algorithmes et les modèles d’entraînement de l’IA.

Mon système d’IA présente-t-il un risque élevé ?

Les organisations peuvent réduire les risques pour les systèmes d’IA en analysant leurs défenses actuelles, en suivant les meilleures pratiques du secteur et en mettant en œuvre des stratégies complètes de sécurité et de cybersécurité de l’IA.

Dois-je faire confiance à un détecteur d’IA ?

Bien que les détecteurs d’IA puissent être des outils efficaces, ils peuvent également faire des erreurs. Par conséquent, leurs résultats ne doivent être utilisés qu’en tant que signal préliminaire pour inciter à une enquête plus approfondie, qui doit reposer sur le jugement humain.

Comment faire attention à l’IA ?

Une approche vraiment prudente de l’IA nécessite différentes actions de la part des utilisateurs et des créateurs. Que vous l’utilisiez ou la construisiez, la règle fondamentale consiste à traiter l’IA comme un outil puissant mais imparfait, et non comme un expert infaillible ou un confiant sécurisé.

Comment sécuriser l’IA ?

Une posture de sécurité complète pour la pile d’IA ne laisse aucun écart, en appliquant une protection à chaque composant, des utilisateurs et des données qu’ils génèrent aux modèles, aux microservices et à l’infrastructure sous-jacente.

Articles associés

Top 10 2025 des risques et des réductions pour les LLM et les applications d’IA de génération

Gestion des risques émergents pour la sécurité publique

Jusqu'où les normes internationales peuvent-elles nous emmener ?

Comment rédiger une politique de cybersécurité IA générative

Attaques malveillantes améliorées par l’IA parmi les principaux risques

Menace croissante des identités factices