L'intelligence artificielle (IA) est une technologie qui permet aux ordinateurs et aux machines d'apprendre, de comprendre, de créer, de résoudre des problèmes, de prévoir les résultats et de prendre des décisions.

Table des matières

Qu’est-ce que l’IA ?

Au niveau le plus basique, l’IA fait référence à des systèmes informatiques ou machine qui utilisent des technologies telles que l’apprentissage automatique (ML), les réseaux neuronaux et les architectures cognitives pour effectuer les types de tâches complexes que seuls les êtres humains étaient capables de réaliser auparavant.

Il s'agit notamment de créer du contenu, de planifier, de raisonner, de communiquer, d'apprendre de l'expérience et de prendre des décisions complexes. Cela dit, comme les systèmes et outils d’IA sont si vastes et variés, aucune définition unique ne s’applique parfaitement à tous.

Depuis son introduction dans les années 1950, l’IA a transformé presque tous les aspects de la vie moderne, de la société et de la technologie. Grâce à sa capacité à analyser de grandes quantités de données, à comprendre les schémas et à acquérir de nouvelles connaissances, l’IA est devenue un outil indispensable dans pratiquement tous les domaines de l’activité humaine, des affaires aux transports, en passant par les soins de santé et la cybersécurité.

Entre autres applications, les organisations utilisent l’IA pour :

- Maîtriser les coûts

- Favoriser l’innovation

- Responsabiliser les équipes

- Simplifier les opérations

- Accélérer la prise de décision

- Consolider et analyser les résultats d’études

- Fournir rapidement un support et un service client

- Automatiser les tâches répétitives

- Aider à la génération d'idées

Un bref historique de l’IA

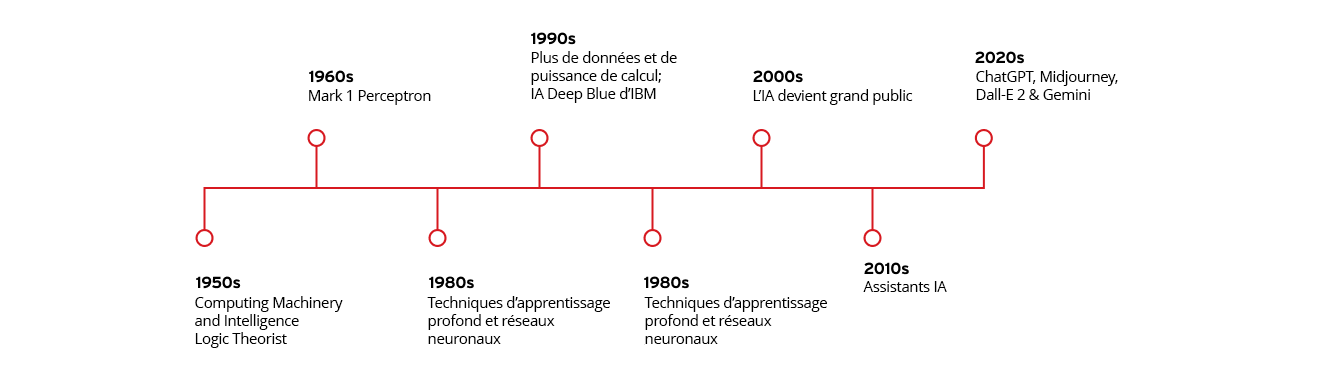

L'idée d'une machine qui peut penser par elle-même remonte à des milliers d'années. Dans son contexte moderne, l’intelligence artificielle en tant que concept défini peut remonter à l’année 1950, lorsque le mathématicien et chercheur en informatique Alan Turing, créateur du célèbre « test de Turing » pour déterminer si un ordinateur peut penser comme un être humain, a publié son article influent sur la notion d’intelligence artificielle, de machines informatiques et d’intelligence.

Dans les décennies qui ont suivi la première publication de Turing, l’IA a connu une évolution spectaculaire dans sa portée et ses capacités, propulsée par des avancées exponentielles en matière de puissance de calcul, de sophistication algorithmique, de disponibilité des données et d’introduction de technologies telles que l’apprentissage automatique, l’exploration de données et les réseaux neuronaux.

Étapes clés dans l’évolution de l’intelligence artificielle

Année

Étapes

Années 1950

- Publication de « Computing Machinery and Intelligence » par Alan Turing

- John McCarthy invente le terme « intelligence artificielle »

- Création de Logic Theorist, le premier programme informatique d’IA

Années 1960

- Création de Mark 1 Perceptron, le premier ordinateur à apprendre par test et erreur

Années 1980

- Croissance des techniques de Deep Learning et des réseaux neuronaux

Années 1990

- L’augmentation de la puissance de données et de calcul accélère la croissance de l’IA et l’investissement dans celle-ci

- L’IA Deep Blue d’IBM bat le champion du monde d’échecs en titre Garry Kasparov

Années 2000

- L’IA se généralise avec le moteur de recherche basé sur l’IA de Google, le moteur de recommandation de produits d’Amazon, le système de reconnaissance faciale de Facebook et les premières voitures autonomes

Années 2010

- Des assistants d’IA comme Siri d’Apple et Alexa d’Amazon sont introduits

- Google lance son cadre d’apprentissage automatique open source, TensorFlow

- Le réseau neuronal AlexNet popularise l’utilisation d’unités de traitement graphique (GPU) pour l’entraînement des modèles d’IA

Années 2020

- OpenAI publie la troisième itération de son très populaire ChatGPT, l'IA générative grand langage (LLM) (GenAI)

- La vague GenAI se poursuit avec le lancement de générateurs d'images comme Midjourney et Dall-E 2 et de chatbots LLM comme Gemini de Google

Comment fonctionne l’IA ?

Les systèmes d’IA fonctionnent en étant alimentés ou en ingérant de grandes quantités de données et en utilisant des processus cognitifs semblables à ceux des humains pour analyser et évaluer ces données. Ce faisant, les systèmes d’IA identifient et catégorisent les schémas et les utilisent pour effectuer des tâches ou faire des prédictions sur les résultats futurs sans supervision humaine directe ni instructions.

Par exemple, un programme d’IA générant des images comme Midjourney qui a fourni un grand nombre de photographies peut apprendre à créer des images « originales » basées sur les prompts (ou invites) saisis par un utilisateur. De même, un chatbot d’IA du service client formé à de grands volumes de texte peut apprendre à interagir avec les clients d’une manière qui imite les agents d’un service client humain.

Bien que chaque système soit différent, les modèles d’IA sont généralement programmés selon le même processus en cinq étapes :

- Formation : le modèle d’IA reçoit d’énormes quantités de données et utilise une série d’algorithmes pour analyser et évaluer les données.

- Raisonnement : le modèle d’IA classe les données qu’il a reçues et identifie tous les modèles qu’il contient.

- Ajustement : alors que le modèle d’IA essaie différents algorithmes, il apprend lesquels ont tendance à être les plus efficaces et affine ses actions en conséquence.

- Création : le modèle d’IA utilise ce qu’il a appris pour effectuer les tâches assignées, prendre des décisions ou créer de la musique, du texte ou des images.

- Amélioration : enfin, le modèle d’IA effectue des ajustements continus pour améliorer sa précision, en « apprenant » efficacement de son expérience.

Apprentissage automatique par rapport au Deep Learning

La plupart des systèmes d’IA modernes utilisent diverses techniques et technologies pour simuler les processus de l’intelligence humaine. Le plus important est le Deep Learning et l’apprentissage automatique (ML). Bien que les termes d’apprentissage automatique et de Deep Learning soient parfois utilisés de manière interchangeable, ils sont en fait des processus très distincts dans le contexte de l’entraînement par IA.

L’apprentissage automatique utilise des algorithmes pour analyser, catégoriser, trier, apprendre et donner du sens à des quantités massives de données afin de produire des modèles précis et de prédire les résultats sans avoir à se faire dire exactement comment procéder.

Le Deep Learning est une sous-catégorie de machine learning qui atteint les mêmes objectifs en utilisant des réseaux neuronaux pour imiter la structure et la fonction du cerveau humain. Nous explorerons ces deux concepts plus en détail ci-dessous.

Principes de base de l’apprentissage automatique

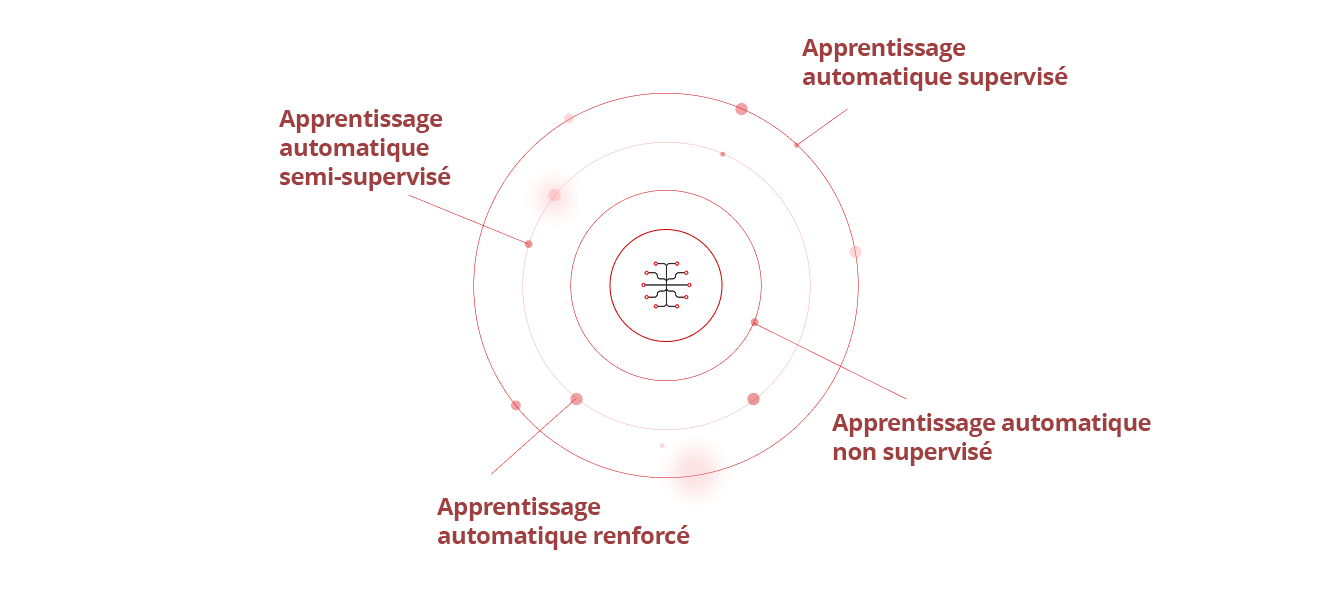

Il existe quatre principaux types d’apprentissage automatique :

- Apprentissage automatique supervisé : l’IA utilise des jeux de données connus, établis et classés pour découvrir des modèles avant de les transmettre à l’algorithme.

- Apprentissage automatique semi-supervisé : l'IA est entraînée sur un petit jeu de données connu et étiqueté, qu'elle s'applique ensuite à des jeux de données plus importants, non étiquetés et inconnus.

- Apprentissage automatique non supervisé : l’IA apprend à partir de jeux de données inconnus, non étiquetés et non classés.

- Apprentissage automatique renforcé : le modèle d’IA n’est pas formé initialement sur les ensembles de données, il apprend donc de tests et d’erreurs et modifie ses comportements jusqu’à ce qu’il réussisse.

L’apprentissage automatique est ce qui permet aux voitures autonomes de réagir suffisamment bien aux changements de l’environnement pour pouvoir acheminer leurs passagers en toute sécurité vers la destination de leur choix. D'autres applications d'apprentissage automatique exécutent des programmes de reconnaissance d'image et de parole, des applications de traduction linguistique, des agents IA axés sur les personas, des outils de data mining ou de détection de fraudes par carte de crédit, des diagnostics de soins de santé et des recommandations de réseaux sociaux, de produits ou de marques.

Réseaux neuronaux et Deep Learning

Le Deep Learning est une forme d’apprentissage automatique basée sur l’utilisation de réseaux neuronaux avancés, des algorithmes d’apprentissage automatique qui émulent la manière dont les neurones d’un cerveau humain fonctionnent afin d’identifier des schémas complexes dans de grands ensembles de données.

Par exemple, même les très jeunes enfants peuvent instantanément distinguer leurs parents des autres adultes, car leur cerveau peut analyser et comparer des centaines de détails uniques ou distinctifs en un clin d’œil, de la couleur de leurs yeux et de leurs cheveux aux expressions distinctives ou aux traits du visage.

Les réseaux neuronaux reproduisent le fonctionnement des cerveaux humains en analysant de manière similaire des milliers ou des millions de minuscules détails dans les données qu’ils reçoivent pour détecter et reconnaître des schémas plus importants entre eux. Les systèmes d’IA générative (ou « GenAI ») tels que ChatGTP d’OpenAI ou le générateur d’images Midjourney, par exemple, utilisent le Deep Learning pour ingérer et analyser un grand nombre d’images ou de texte, puis utilisent ces données pour créer de nouveaux textes ou images qui sont similaires, mais différents, des données originales.

Quels sont les derniers développements en matière d’IA ?

Ces dernières années, les innovations révolutionnaires dans le traitement du langage naturel, la vision par ordinateur, l’apprentissage par renforcement et les technologies de pointe telles que les réseaux antagonistes génératifs (GAN), les modèles de transformateur et les machines véritablement compatibles avec l’IA (AIEM) ont considérablement élargi les capacités des systèmes d’IA pour imiter plus étroitement les processus d’intelligence humaine, générer un contenu plus réaliste et effectuer des tâches de plus en plus complexes.

Des avancées dans l’apprentissage automatique et le Deep Learning

Ces dernières années, les innovations révolutionnaires dans le traitement du langage naturel, la vision par ordinateur, l’apprentissage par renforcement et les technologies de pointe telles que les réseaux antagonistes génératifs (GAN), les modèles de transformateur et les véritables machines compatibles avec l’IA (AIEM) ont considérablement élargi les capacités des systèmes d’IA pour imiter plus étroitement les processus d’intelligence humaine, générer un contenu plus réaliste et effectuer des tâches de plus en plus complexes.

Des avancées dans l’apprentissage automatique et le Deep Learning

Les avancées révolutionnaires dans les algorithmes d’apprentissage automatique et de Deep Learning ont permis aux chercheurs et aux développeurs de créer des systèmes d’IA incroyablement sophistiqués pour une grande variété d’applications réelles.

Les chatbots d’IA, par exemple, sont utilisés par des millions d’entreprises chaque jour pour répondre à des questions, vendre des produits et interagir avec leurs clients. Les entreprises utilisent également des algorithmes d'IA pour découvrir les tendances basées sur les achats passés d'un client et faire des recommandations personnalisées pour de nouveaux produits, marques ou services.

Dans le domaine de la reconnaissance vocale automatique (ASR), les services d’IA comme Siri et Alexa utilisent le traitement du langage naturel (NLP) pour traduire la parole humaine en contenu écrit. De même, les progrès réalisés dans les réseaux neuronaux de « vision par ordinateur » basés sur l’IA ont facilité l’identification des photos sur les réseaux sociaux et ont rendu les voitures autonomes plus sûres.

Parmi les autres exemples d’IA utilisant le machine learning ou le Deep Learning, on peut citer les algorithmes automatisés de trading d’actions, les robots intelligents qui peuvent effectuer des tâches répétitives dans les usines ou sur les chaînes d’assemblage, et l’utilisation de l’apprentissage automatique pour aider les banques à repérer les transactions suspectes et à arrêter la fraude financière.

Le rôle évolutif de l’IA dans la cybersécurité

En ce qui concerne le rôle de l’IA dans la cybersécurité, il existe deux domaines distincts, mais interconnectés, à prendre en compte : Sécurité de l’IA et cybersécurité de l’IA.

La sécurité de l’IA (également appelée sécurité pour l’IA) fait référence à l’utilisation de mesures de cybersécurité pour protéger le stack IA d’une organisation, réduire ou éliminer les risques de sécurité de l’IA, et sécuriser chaque système, composant et application d’IA sur un réseau, des endpoints aux modèles d’IA. Cela inclut :

- Protection du stack IA, de l’infrastructure, des modèles et des données d’entraînement contre les attaques

- Préserver l’intégrité des données des pipelines d’apprentissage automatique et de Deep Learning

- Répondre aux problèmes de biais, de transparence, d’explicabilité et d’autres préoccupations éthiques liés à l’IA

S’assurer que l’utilisation ou le développement de l’IA est entièrement conforme à toutes les lois, politiques et réglementations pertinentes

La cybersécurité basée sur l’IA couvre toutes les différentes façons dont les outils compatibles avec l’IA peuvent améliorer de manière proactive les défenses de cybersécurité d’une organisation, plus rapidement, plus précisément et plus efficacement que n’importe quelle équipe de cybersécurité humaine ou centre d’opérations de sécurité (SOC) ne l’aurait jamais pu. Cela inclut l’utilisation de l’IA pour :

- Identifier les cybermenaces et se défendre contre les cyberattaques en temps réel

- Éliminer les failles et vulnérabilités de cybersécurité plus rapidement et avec une plus grande précision

- Automatiser la détection et la réponse aux menaces et d'autres outils de cybersécurité pour une réponse aux incidents plus rapide

- Améliorer la veille sur les menaces pour renforcer ou prendre en charge une gestion des menaces plus efficace

- Automatiser les tâches de routine telles que l’analyse des vulnérabilités et l’analyse des journaux de données pour libérer du temps pour l’équipe de cybersécurité humaine et lui permettre de traiter des menaces plus complexes

Exemples d’applications d’IA dans la cybersécurité

Les organisations utilisent déjà l’IA de différentes manières pour améliorer leur posture de cybersécurité, détecter et répondre aux cyberattaques, et défendre leurs réseaux contre les cybermenaces telles que les violations de données, les attaques par déni de service distribué (DDoS), les ransomware, les malware, les attaques de phishing et les menaces liées à l’identité.

Dans le domaine de la détection et de la réponse aux menaces, l’IA peut identifier et prédire les cybermenaces, analyser les schémas dans les journaux d’activité et le trafic réseau, authentifier et protéger les mots de passe et les connexions des utilisateurs, utiliser la reconnaissance faciale et les connexions CAPTCHA, simuler les cyberattaques, rechercher les vulnérabilités du réseau et créer des défenses automatisées contre les menaces nouvelles ou émergentes. Cela inclut des outils tels que :

- Pare-feu nouvelle génération (NGFW) alimentés par l’IA

- Gestion des événements et des informations de sécurité (SIEM) IA

- Systèmes sécurité du cloud et des endpoints optimisés par IA

- Détection et réponse réseau (NDR) optimisés par IA

- XDR optimisé par IA

Lorsqu’une attaque se produit, l’IA peut également proposer des stratégies de remédiation efficaces ou répondre automatiquement aux incidents de sécurité en fonction des stratégies et des playbooks prédéfinis d’une organisation. Cela peut aider à réduire les coûts et les dommages causés par une attaque, et permettre aux organisations de se restaurer plus rapidement.

Quelles considérations éthiques sont impliquées dans le développement et l’utilisation de l’IA ?

L’IA offre clairement un certain nombre d’avantages puissants par rapport à d’autres types de systèmes informatiques. Mais comme pour toute nouvelle technologie, il existe des risques, des défis et des questions éthiques qui doivent être pris en compte dans le développement, l’adoption et l’utilisation de l’IA.

Préjugés et équité

Les modèles d’IA sont entraînés par des êtres humains à l’aide de données tirées de contenus existants. Cela crée un risque que le modèle puisse refléter ou renforcer des préjugés implicites présents dans ces contenus. Ces préjugés peuvent potentiellement entraîner une inégalité, une discrimination ou une injustice dans les algorithmes, les prédictions et les décisions qui sont prises à l’aide de ces modèles.

De plus, comme le contenu qu'ils créent peut être si réaliste, les outils GenAI peuvent être utilisés à mauvais escient pour créer ou diffuser des fausses informations, du contenu nuisible et des vidéos, audio et images factices.

Préoccupations en matière de confidentialité

Il existe également plusieurs préoccupations en matière de confidentialité concernant le développement et l’utilisation de l’IA, en particulier dans les secteurs tels que les soins de santé, les services bancaires et juridiques qui traitent des informations hautement personnelles, sensibles ou confidentielles.

Pour protéger ces informations, les applications basées sur l’IA doivent suivre un ensemble clair de bonnes pratiques en matière de sécurité, de confidentialité et de protection des données. Cela inclut l’utilisation de techniques d’anonymisation des données, la mise en œuvre d’un chiffrement robuste des données et l’utilisation de défenses de cybersécurité avancées pour se protéger contre le vol de données, les violations de données et les pirates.

Conformité réglementaire

De nombreux organismes et cadres réglementaires, comme le Règlement général sur la protection des données (RGPD), exigent que les entreprises respectent des règles claires en matière de protection des informations personnelles, pour assurer la transparence et les responsabilités, et protéger la vie privée.

Pour se conformer à ces réglementations, les organisations doivent s’assurer qu’elles ont mis en place des politiques d’IA d’entreprise pour surveiller et contrôler les données utilisées pour créer de nouveaux modèles d’IA, et pour protéger tous les modèles d’IA qui pourraient contenir des informations sensibles ou personnelles provenant d’acteurs malveillants.

Quel est l’avenir de la technologie d’IA ?

Ce qui se passera à l’avenir de l’IA est, bien sûr, impossible à prévoir. Mais il est possible de faire quelques hypothèses éclairées sur ce qui va suivre en fonction des tendances actuelles en matière d’utilisation et de technologie de l’IA.

Tendances émergentes dans la recherche sur l’IA

En termes de recherche sur l’IA, les innovations dans les systèmes d’IA autonomes, le méta-IA et le méta-learning, les modèles LLM open source, les jumeaux numériques, le red teaming pour la validation des risques, et la prise de décision conjointe homme-IA pourraient révolutionner la façon dont l’IA est développée.

De nouveaux systèmes complexes comme l’IA neurosymbolique, les machines véritablement compatibles avec l’IA (AIEM) et l’apprentissage automatique quantique amélioreront probablement davantage la portée et les capacités des modèles, outils et applications d’IA.

Une autre technologie qui a le potentiel de révolutionner le fonctionnement de l’IA est le passage à l’IA agentique de nouvelle génération, qui a la capacité de prendre des décisions et des actions seules, sans direction, supervision ou intervention humaine.

Selon l’analyste technologique Gartner, d’ici 2028, l’IA agentique pourrait être utilisée pour prendre jusqu’à 15 % de toutes les décisions de travail quotidiennes. Les interfaces utilisateur (IU) de l’IA agentique pourraient également devenir plus proactives et axées sur le persona, car elles apprennent à agir comme des agents humains avec des personnalités définies, à effectuer des tâches commerciales plus complexes, à prendre des décisions business plus importantes et à fournir des recommandations plus personnalisées aux clients.

Impacts potentiels de l’IA sur la main-d’œuvre

À mesure que l’IA augmente l’efficacité opérationnelle et prend en charge les tâches de routine, et que les moteurs GenAI tels que ChatGPT et Midjourney deviennent plus puissants et étendus, des préoccupations émergent quant à l’impact possible sur l’emploi dans de nombreux secteurs.

Mais, comme avec l’introduction d’Internet, d’ordinateurs personnels, de téléphones portables et d’autres technologies changeant de paradigme dans le passé, l’IA créera probablement également de nouvelles opportunités et peut-être même de tout nouveaux secteurs qui auront besoin de travailleurs qualifiés et talentueux.

Par conséquent, au lieu de gérer les pertes d’emploi, le plus grand défi peut consister à déterminer la meilleure façon de former les travailleurs pour ces nouvelles opportunités, et de faciliter leur transition de la réduction à des professions croissantes.

Le rôle de l’IA pour relever les défis mondiaux

En plus d’accroître l’efficacité opérationnelle et d’améliorer la cybersécurité, l’IA peut aider à résoudre certains des plus grands défis auxquels l’humanité est confrontée aujourd’hui.

Dans le domaine des soins de santé, l’IA peut aider les médecins à établir des diagnostics plus rapides et plus précis, à suivre la propagation des futures pandémies et à accélérer la découverte de nouveaux médicaments, traitements et vaccins pharmaceutiques.

Les technologies d’IA pourraient améliorer la vitesse et l’efficacité des réponses en urgence aux catastrophes naturelles et causées par l’homme et aux événements météorologiques graves.

L’IA pourrait également aider à lutter contre le changement climatique en optimisant l’utilisation des énergies renouvelables, en réduisant l’empreinte carbone des entreprises, en suivant les niveaux mondiaux de déforestation et de pollution des océans, et en améliorant l’efficacité des systèmes de recyclage, de traitement de l’eau et de gestion des déchets.

Autres tendances et développements probables

Voici quelques-unes des autres tendances, capacités et applications futures probables pour l’IA :

- Sécurité des modèles LLM pour protéger ces modèles contre les attaques malveillantes, les utilisations abusives générales, les accès non autorisés et d'autres cybermenaces. Cela comprend des mesures pour protéger les données des LLM, ainsi que leurs systèmes et composants associés.

- Une IA personnalisée et centrée sur l’utilisateur pour offrir un service client plus personnalisé et intelligent, y compris pour le marketing par email sur les endpoints.

- L’utilisation de modèles d’IA pour faciliter les exercices de red teaming et de jumeaux numériques en simulant les attaques sur les systèmes informatiques d’une organisation, tester les vulnérabilités et atténuer les failles ou faiblesses.

Où puis-je obtenir de l’aide en matière d’IA et de cybersécurité ?

Trend Vision One- offre une protection inégalée pour l’ensemble du stack IA, au sein d’une plateforme unique et unifiée optimisée par l’IA.

En tirant parti des fonctionnalités riches de Trend Cybertron, la première IA proactive de cybersécurité au monde, Trend Vision One comprend une suite de fonctionnalités d’IA agentique qui évoluent en continu sur la base d’opérations de veille et de sécurité réelles.

Cela permet de s’adapter rapidement aux menaces émergentes afin d’améliorer la posture de sécurité d’une organisation, d’améliorer l’efficacité opérationnelle, de transformer les opérations de sécurité de réactives à proactives, et de sécuriser chaque couche d’infrastructure d’IA.

Fernando Cardoso est vice-président de la gestion des produits chez Trend Micro, et se concentre sur le monde en constante évolution de l’IA et du cloud. Sa carrière a commencé en tant qu’ingénieur réseau et commercial, où il a perfectionné ses compétences dans les centres de données, le cloud, les DevOps et la cybersécurité, des domaines qui continuent de nourrir sa passion.

Foire aux questions (FAQ)

Qu’est-ce qu’une IA ?

L’intelligence artificielle (IA) est un ordinateur qui utilise la technologie pour imiter la façon dont les êtres humains pensent, fonctionnent et prennent des décisions.

Que fait vraiment l’IA ?

Les modèles d’IA utilisent des algorithmes complexes et s’appuient sur de grandes quantités d’informations « apprises » pour calculer les réponses aux questions des utilisateurs ou générer du contenu basé sur les invites des utilisateurs.

Siri est-il une IA ?

Siri est une forme simple d’IA qui utilise des technologies telles que l’apprentissage automatique et la reconnaissance vocale pour comprendre et répondre à la parole humaine.

L’IA est-elle bonne ou mauvaise ?

Comme toutes les technologies, l’IA n’est pas intrinsèquement bonne ou mauvaise. C'est un outil qui peut être utilisé à des fins positives et négatives.

Quel est l’objectif principal de l’IA ?

L’objectif principal de l’IA est de permettre aux ordinateurs de prendre des décisions plus intelligentes, d’accomplir des tâches plus difficiles et d’apprendre de l’expérience sans contribution humaine constante.

Pourquoi l’IA a-t-elle été créée ?

L’IA a été développée pour aider à automatiser les tâches répétitives, à résoudre des problèmes complexes et à permettre une recherche et une innovation plus avancées dans plusieurs secteurs différents.

Quels sont les risques liés à l’IA ?

Certains risques posés par l’IA comprennent les préoccupations concernant les préjugés et l’équité, les risques pour la confidentialité, les risques de cybersécurité et le potentiel de déplacement d’emploi.

Qui a créé l’IA ?

Les informaticiens Alan Turing (1912 – 1954) et John McCarthy (1927 – 2011) sont généralement considérés comme les « pères de l’IA » non officiels.

Qu’est-ce que l’IA dans la vie réelle ?

Il existe de nombreux exemples d’IA dans notre vie quotidienne, des logiciels sur votre smartphone aux chatbots qui répondent aux questions courantes du service client.

Qu’est-ce qu’une IA simple ?

Parmi les exemples d’IA simples figurent les assistants vocaux tels que Siri ou Alexa, les moteurs de recherche intelligents tels que Google, les chatbots de service client et même les aspirateurs robot.

Quels sont les inconvénients de l’IA ?

Parmi les inconvénients de l’IA figurent les préoccupations concernant la confidentialité et les préjugés, les risques de cybersécurité et l’impact potentiel sur les emplois dans certains domaines.

Quels sont les 5 inconvénients de l’IA ?

Selon la manière dont elle est utilisée, l’IA peut causer des pertes d’emploi, générer des informations erronées, compromettre les informations privées, réduire la créativité et entraîner une dépendance excessive à la technologie.

Comment activer l’IA ?

La plupart des outils d’IA peuvent être activés ou désactivés dans les fonctionnalités de paramètres des téléphones portables, ordinateurs, applications logicielles ou sites Web.

Puis-je utiliser l’IA gratuitement ?

De nombreux outils d’IA comme les moteurs de recherche ou Alexa sont entièrement gratuits. D'autres, comme ChatGPT, proposent des options gratuites et payantes. L’IA de qualité commerciale est généralement payée uniquement.

Quelle IA est entièrement gratuite ?

La plupart des entreprises d’IA proposent des versions d’introduction gratuites, notamment Microsoft Copilot, Grammarly, Google Gemini et ChatGPT.

Quelle est l’application d’IA la plus populaire en ce moment ?

Actuellement, les applications d’IA les plus populaires comprennent ChatGPT, Google Maps, Google Assistant, Microsoft Copilot et Google Gemini.

Quelle est l’application d’écriture IA que tout le monde utilise ?

Parmi les applications d'écriture assistées par IA les plus populaires figurent Grammarly, ChatGPT, Writesonic, Jasper et Claude.

Quelle est l’application d’IA que tout le monde utilise gratuitement ?

Google Gemini, Copilot de Microsoft et ChatGPT figurent parmi les applications d’IA gratuites les plus largement utilisées à l’heure actuelle.

Quel est le meilleur chatbot d’IA actuellement ?

Le « meilleur » chatbot dépend de vos besoins, mais certains des chatbots d’IA les plus populaires comprennent Perplexity, Google Gemini, Jasper et ChatGPT.

Quel est un exemple d’IA dans la vie quotidienne ?

Les exemples courants d’IA dans la vie quotidienne comprennent les smartphones, les moteurs de recherche d’IA, les chatbots de service client et les assistants vocaux numériques comme Siri et Alexa.

Articles associés

Top 10 2025 des risques et des réductions pour les LLM et les applications d’IA de génération

Gestion des risques émergents pour la sécurité publique

Jusqu'où les normes internationales peuvent-elles nous emmener ?

Comment rédiger une politique de cybersécurité IA générative

Attaques malveillantes améliorées par l’IA parmi les principaux risques

Menace croissante des identités factices