Phishing

Je raffinierter die KI desto komplexer die Risiken

Trend Micros Untersuchung der KI-Sicherheit im ersten Halbjahr bietet umfassende Einblicke sowohl in die Weiterentwicklungen als auch in die Schwachstellen, die mit dem Einsatz von immer mehr KI sowohl von Unternehmen als auch durch Cyberkriminelle einhergehen.

KI ist weiterhin auf dem besten Weg, viele Facetten unseres Lebens zu durchdringen, von digitalen Assistenten (DAs), die die täglichen Aufgaben von Menschen verwalten, bis hin zu KI-Agenten, die Geschäftsentscheidungen automatisieren können. Der breite Nutzen künstlicher Intelligenz (KI) bringt Effizienzsteigerungen sowohl für Unternehmen als auch für die Bedrohungsakteure, die diese in ihre Aktivitäten einbeziehen. Da 93 % der Sicherheitsverantwortlichen sich auf tägliche KI-Angriffe im Jahr 2025 einstellen, sind Entscheidungsträger aller Branchen gezwungen, ihre Arbeitsabläufe und Sicherheitsstrategien zu überdenken: Laut dem Global Cybersecurity Outlook Report des Weltwirtschaftsforums gehen 66 % der befragten Unternehmen davon aus, dass KI in diesem Jahr den größten Einfluss auf die Cybersicherheit haben wird.

Wir haben in einem neuen Forschungsbericht das erste Halbjahr 2025 bezüglich der Cybersicherheit im Bereich der künstlichen Intelligenz (KI) (Trend State of AI Security Report) untersucht, sowohl die Chancen als auch die Risiken.

Schwachstellen/Exploits in kritischen Komponenten

Unternehmen, die KI-Anwendungen entwickeln, bereitstellen und nutzen möchten, müssen mehrere spezialisierte Software-Komponenten und -Frameworks einsetzen. Diese können Schwachstellen enthalten, wie sie auch in herkömmlicher Software zu finden sind.

Angriffe auf KI-Infrastruktur

Die Aufnahme einer eigenen KI-Kategorie in den Pwn2Own Berlin, einem der weltweit führenden Hacking-Wettbewerbe, war nicht nur eine Anerkennung des aktuellen Trends zur KI, sondern auch ihrer Schlüsselrolle bei der Neudefinition der Grenzen der Cybersicherheit geschuldet. Dabei waren en die Teilnehmer aufgefordert, in das KI-Ökosystem der unterstützenden Architektur einzudringen. 28 einzigartige Zero Day-Schwachstellen, davon sieben in der KI-Kategorie wurden aufgedeckt. Der Bericht zeigt Zero-Day-Schwachstellen und Exploits in Kernkomponenten wie ChromaDB, Redis, NVIDIA Triton und NVIDIA Container Toolkit auf.

Chroma DB ist eine Open-Source-Vektordatenbank, die bei KI-Agenten auf Basis von Retrieval Augmented Generation immense Popularität erlangt hat. Bislang waren nur wenige Schwachstellen in Chroma bekannt, aber bei dieser Pwn2Own-Veranstaltung gelang es, einen Exploit erfolgreich auszuführen – der erste Sieg in der Kategorie KI überhaupt.

Redis ist ein Key-Value-Speicher, beliebt in Content-Serving-Anwendungen und als Cache für schnelle Antworten auf häufige Datenbankabfragen. Auch gelang es, über eine Use-after-Free (UAF)-Lücke einzudringen.

Ein Großteil der KI-Infrastruktur läuft auf Containern, was bedeutet, dass sie denselben Sicherheitslücken und Bedrohungen ausgesetzt ist, die auch Cloud- und Containerumgebungen betreffen. Teilnehmer konnten das NVIDIA Container Toolkit „knacken“, über eine Schwachstelle bei der externen Initialisierung vertrauenswürdiger Variablen. Der Exploit unterstreicht die Notwendigkeit, alle externen Eingaben zu validieren und sicherzustellen, dass kritische Variablen sicher initialisiert werden. Er weist auch auf die Notwendigkeit umfassender Sicherheitsüberprüfungen von containerisierten Umgebungen hin, die zunehmend in KI- und ML-Anwendungen eingesetzt werden. Weitere Einzelheiten zu den Schwachstellen liefert der Originalbeitrag.

KI-spezifische Schwachstellen

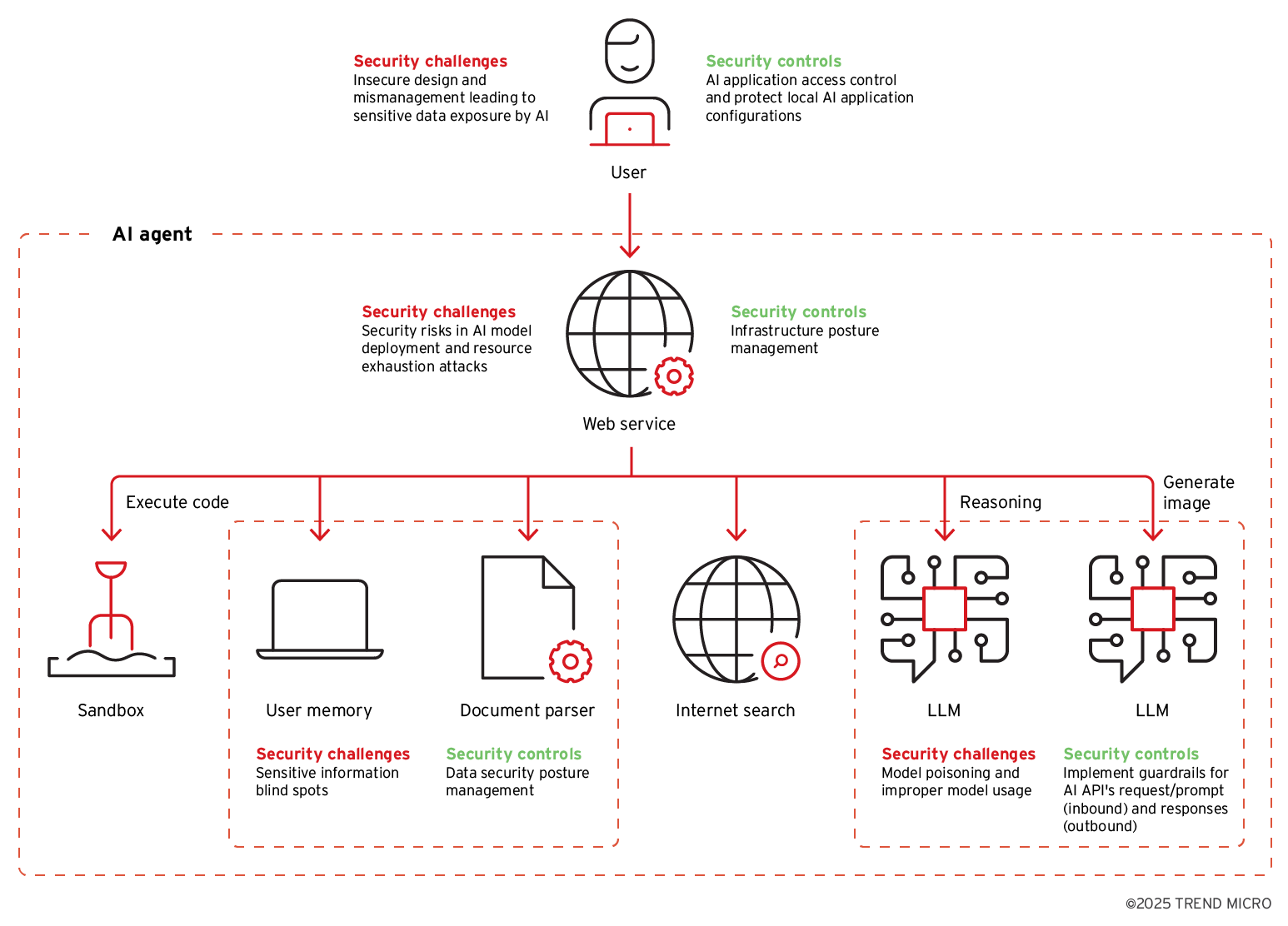

An den Angriffen, die beim Pwn2Own demonstriert wurden, war nichts KI-Spezifisches, außer den Zielen selbst. Doch Sicherheitslücken in KI-Agenten gibt es ebenfalls, über die LLM-basierte Anwendungen zur Zielscheibe werden. Ausführliche Einzelheiten dazu liefert die vierteilige Serie „Schwachstellen in KI-Agenten“.

Bild 1. Sicherheitsherausforderungen und empfohlene Kontrollmechanismen für typische Komponenten eines LLM-getriebenen KI-Agenten

Viele der KI-spezifischen Angriffe basieren auf immer ausgefeilteren Prompt-Angriffstechniken. Das KI-Modell DeepSeek-R1 ist ein Paradebeispiel dafür, wie KI-Technologien unbeabsichtigt Möglichkeiten für Angreifer eröffnen können – insbesondere durch die Chain-of-Thought-Argumentation (CoT). Während andere Modelle dazu aufgefordert werden können, ihre Argumentationskette anzuzeigen, ist DeepSeek-R1 insofern ungewöhnlich, als dass diese standardmäßig zwischen speziellen Tags deutlich sichtbar angezeigt wird. Dies ist zwar für den Nutzer hilfreich, um seine Eingabeaufforderungen zu optimieren, aber böswillige Akteure können diese Transparenz nutzen, um mehr über das Verhalten eines Modells zu erfahren.

Ein Beispiel für eine solche Instrumentalisierung ist die Link-Falle, bei der Angreifer ein GenAI-Modell dazu bringen, ahnungslosen Nutzern eine Antwort mit einer bösartigen URL zu senden. Die URL, die oft als harmloser Referenz-Link getarnt ist, sendet heimlich Nutzerdaten an den Server des Angreifers, wenn sie angeklickt wird. Link-Fallen umgehen herkömmliche Einschränkungen der Zugriffsrechte oder der ausgehenden Kommunikation des Modells.

LLMs können auch durch unsichtbare Prompt-Injections manipuliert werden, bei denen Angreifer das Verhalten eines KI-Modells verändern, indem sie ihre bösartigen Inhalte als Unicode-Zeichen verstecken. Es handelt sich um einen heimtückischen Angriff, der in Verbindung mit anderen Prompt-Injection-Techniken eingesetzt werden kann, da jeder englische Text in Unicode-Zeichen umgewandelt werden kann, die in Benutzeroberflächen nicht angezeigt werden. Daher ist es unerlässlich, dass Entwickler diese Art von unsichtbarem Text als Eingabe für ihre KI-Anwendungen verbieten und alle in den Wissensdatenbanken ihres Modells verwendeten Materialien sorgfältig prüfen.

Einfachere Formen des Prompt Engineering, wie „Do Anything Now“ (DAN) oder „vorherige Anweisungen ignorieren“, werden zunehmend durch fortgeschrittenere Methoden abgelöst. Der Prompt Leakage-Angriff (PLeak) beispielsweise kann die Datensicherheit untergraben, indem er die integrierten Sicherheitsbeschränkungen eines LLM umgeht.

KI und die Cyberkriminalität

KI wird zu einem grundlegenden Werkzeug für Cyberkriminelle, um darüber ihre aktuellen Aktivitäten zu stärken oder neue Möglichkeiten zu erschließen.

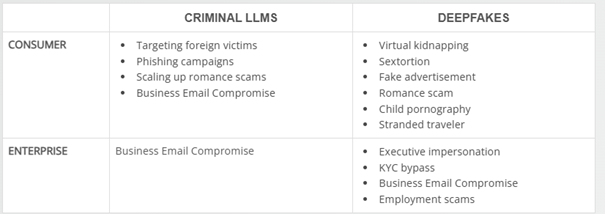

Tabelle. Zusammenfassung der kriminellen Nutzung von GenAI

Für die russischsprachigen Kriminellen liegt der Nutzen der KI vor allem in der Bereitstellung automatisierter Übersetzungen und kultureller Kontextualisierung. Dadurch können sie glaubwürdigere Köder erstellen und ihr Netz auf Opfer in bisher unzugänglichen Regionen ausweiten. Durch die Kombination von GenAI mit offengelegten biometrischen Daten und Informationen, die durch doppelte Erpressungs-Ransomware-Taktiken abgegriffen wurden, können sie sogar digitale Identitäten erstellen, um ihre Betrugs- oder Erpressungsaktivitäten mit Kryptowährungen zu intensivieren.

In Untergrundkreisen kursieren auch Angebote für „kriminelle GPTs“. Obwohl sie mehr Anonymität bieten als kommerzielle Alternativen, finden diese kriminellen LLMs nur begrenzte Verwendung. Zum einen wurden die meisten nicht für illegale Zwecke trainiert. Viele von ihnen, wie BlackhatGPT, erwiesen sich als kaum getarnte kommerzielle Jailbreak KI-Plattformen. Im Gegensatz zu den nicht so erfolgreichen Angeboten wird Jailbreak-as-a-Service in den Untergrundforen immer beliebter.

Es ist unwahrscheinlich, dass böswillige Akteure ihre Arsenale und Operationen im Hinblick auf neue Technologien überarbeiten, solange sie keinen erheblichen Gewinn darin sehen. Aus diesem Grund befindet sich beispielsweise die agentenbasierte KI noch in den Kinderschuhen.

Derzeit gibt es wohl keine andere KI-Technologie, die eine größere Wirkung erzielt hat als Deepfakes. 36 % der Verbraucher unter den Trend-Anwendern geben an, bereits Betrugsversuche mit Deepfake-Inhalten erlebt zu haben. Kriminelle wenden sich zunehmend von maßgeschneiderten Untergrund-Services ab und bevorzugen Mainstream-Plattformen zur Erstellung von Deepfakes. Diese bieten fortschrittliche Funktionen – wie Echtzeit-Streaming-Manipulation, mehrsprachiges Klonen von Stimmen und Entkleidung von Bildern – zu geringen Kosten, teilweise sogar kostenlos. In der kriminellen Untergrundszene mangelt es nicht an einfach zu bedienenden Tools, Tutorials und Support für Deepfake-basierte Angriffe – ein eindeutiger Beweis dafür, wie leicht zugänglich diese selbst für Kriminelle mit begrenzten technischen Fähigkeiten.

Eine wichtige Anwendung der Deepfake-Technologie für Kriminelle ist die Umgehung der KI-Technologie, die elektronische Know-Your-Customer (eKYC)-Systeme sichert. Dies geschieht häufig, um anonyme Konten auf Kryptowährungsplattformen für Geldwäschezwecke zu erstellen. Mit KI lassen sich Deepfake-Bilder oder -Videos generieren, die überzeugend genug sind, um die KI-Modelle von eKYC zu täuschen, wodurch de facto KI-Technologien gegeneinander ausgespielt werden.

Komplexität der agentenbasierten KI und Assistenten

Der Markt wird derzeit von einer Flut so genannter „agenten-basierter“ Lösungen überschwemmt, doch viele davon verfügen nicht über alle adaptiven und selbstgesteuerten Verhaltensweisen, die agentenbasierte KI von einfacher Automatisierung unterscheiden: Echte agentenbasierte Systeme sind zielorientiert, kontextbewusst und handlungsorientiert. Außerdem sind sie in der Lage, mehrstufige Schlussfolgerungen zu ziehen und auf der Grundlage neuer Daten und Erfahrungen selbstständig zu lernen.

Mit zunehmender Reife der agentenbasierten KI wird sie über ihre derzeitigen Konfigurationen hinausgehen und schließlich Komponenten wie Marktplätze für Tools von Drittanbietern und Agenten-Repositories mit integrieren, um ihre Vielseitigkeit zu verbessern. Damit entstehen aber auch gleichzeitig neue Fronten für Angriffe auf die Supply Chain.

Wenn Komponenten wie KI-Modelle, APIs oder Datenspeicher unsachgemäß in öffentlichen Netzwerken zugänglich gemacht werden, könnte dies außerdem Angreifern die Möglichkeit bieten, sensible Daten und Kernfunktionen zu stehlen oder zu manipulieren. Da Agenten häufig mit externen Ressourcen interagieren, sind herkömmliche perimeterbasierte Abwehrmaßnahmen angesichts der zunehmenden Komplexität agentenbasierter KI nicht mehr wirksam.

Die überwiegende Mehrheit der agentenbasierten KI-Anwendungen für Verbraucher wird durch die nächste Generation digitaler Assistenten (DA) gesteuert werden, bei denen mehrere KI-Agenten hinter den Kulissen zusammenarbeiten, um komplexe Aufgaben zu bewältigen, wobei jedem Agenten eine individuelle Rolle zugewiesen ist. Die Verwendung von Funktionen oder Plugins von Drittanbietern vergrößert ebenfalls die Angriffsfläche, da böswillige Akteure schädlichen Code als legitime Add-ons tarnen, um Nutzer auszuspionieren, Daten zu stehlen oder sogar einen DA kapern könnten.

Fazit

Fortschritte in der KI vergrößern zwangsläufig die Angriffsfläche. Daher ist es unerlässlich, dass Sicherheitsmaßnahmen in jede Phase des KI-Lebenszyklus integriert werden, um Schwachstellen oder Angriffsvektoren, die dabei auftreten können, einen Schritt voraus zu sein. Agentenbasiertes Denken ist nur eine von vielen paradigmenverändernden Entwicklungen, die sowohl in der KI als auch in der Cybersicherheit die nächsten Grenzen verschieben werden.

Initiativen wie die CUDA-Q-Entwicklungsplattform von NVIDIA und das geplante Accelerated Quantum Research Center sollen Forschern bei der Entwicklung quantenresistenter Verschlüsselungsalgorithmen für hybride quantenklassische Computer und bei der zukünftigen praktischen Anwendung von Quantencomputern helfen. Forscher von Trend Micro haben ebenfalls Erkenntnisse zum Entwurf und der Implementierung von Lösungen für die Probleme der Quantencomputer beigetragen. Obwohl Quanten-ML noch in den Kinderschuhen steckt, ist jetzt ein guter Zeitpunkt, sich mit seinen Möglichkeiten und Grenzen vertraut zu machen.

Trend Cybertron, ein im März vorgestelltes KI-Modell und -Agent, kann selbstständig auf Cyberbedrohungen reagieren. Die Lösung analysiert komplexe Umgebungen, automatisiert die Untersuchung von Vorfällen und koordiniert Reaktion eines Unternehmens auf Angriffe. Weitere Informationen bietet der Originalbeitrag.