Cyber-Kriminalität

Hype vs. Realität: KI im Cyberuntergrund, Teil 2

Generative künstliche Intelligenz (KI) steckt im kriminellen Untergrund noch in den Kinderschuhen. Die Fortschritte, die wir sehen, sind nicht bahnbrechend. Akteure bieten angebliche Neuheiten, viel Fake und nutzen manchmal KI für Deepfakes.

Wir zeigten bereits im ersten Teil, wie Kriminelle ChatGPT für die Verfeinerung ihres Codes nutzen, es als Feature anbieten oder über Jailbreak die Zensurbeschränkungen aufheben. Doch bei näherer Analyse der Angebote in den Untergrundforen konnten wir feststellen, dass viele angebliche Tools lediglich Wrapper waren oder gar nur Fakes.

Der große LLM-Schnäppchenverkauf: FraudGPT, DarkBARD, DarkBERT, DarkGPT

Im Sommer beobachteten wir im Telegram-Kanal „Cashflow Cartel“ einen stetigen Strom von Ankündigungen zu KI-Diensten. Diese beinhalteten zunächst nur eine Liste möglicher KI-gestützter Aktivitäten, wie das Schreiben von bösartigem Code, das Erstellen von Phishing-Websites, das Auffinden von Marktplätzen und das Aufspüren von Karriereseiten. Sie behaupten, verschiedene Modelle zu unterstützen und mehr als 3.000 erfolgreiche Nutzer zu haben. Anfangs wurde in den Telegram-Posts kein spezifischer Name des Services genannt. Dann änderten sich die Anzeigen und es gab Angebote für mehrere Services wie DarkBARD, DarkBERT und FraudGPT. Die Autoren und Channel-Admins behaupteten lediglich Wiederverkäufer zu sein. Im August verschwanden die ursprünglichen Angebote aus dem Telegram-Kanal, und sie wurden nie wieder erwähnt.

Mehrere Faktoren deuten darauf hin, dass es sich sehr wahrscheinlich um nicht legitime neue Sprachmodelle handelt, die mit der alleinigen Absicht entwickelt wurden, kriminelle Aktivitäten zu unterstützen:

- Wie WormGPT gezeigt hat, würde es selbst mit einem engagierten Team Monate dauern, nur ein einziges angepasstes Sprachmodell zu entwickeln. Zusätzlich zu der langen Entwicklungszeit müssten die böswilligen Akteure die Entwicklungskosten für nicht nur ein, sondern vier verschiedene Systeme mit unterschiedlichen Fähigkeiten tragen. Dazu gehören auch die Kosten für die Rechenleistung und die anschließenden Kosten für das Cloud-Computing, das für die Feinabstimmung erforderlich ist.

- Trotz aller Ankündigungen konnten wir keinen konkreten Beweis dafür finden, dass diese Systeme funktionieren. Selbst für FraudGPT, das bekannteste der vier LLMs, sind in anderen Foren nur Werbematerial oder Demovideos des Verkäufers zu finden.

Wir glauben, dass diese höchstwahrscheinlich als Wrapper-Dienste arbeiten, die Anfragen entweder an die legitimen ChatGPT- oder Google BARD-Tools umleiten, indem sie gestohlene Konten über eine VPN-Verbindung und Jailbreaking-Prompts verwenden. Um Missverständnisse zu vermeiden: Es gibt tatsächlich ein legitimes Tool namens DarkBERT, das von der Firma SW2 durch Training eines robust optimierten BERT Pretraining Approach (RoBERTa) LLM mit Daten aus dem Dark Web entwickelt wurde. Das Unternehmen verwendete diese Technologie jedoch intern, etwa zur Klassifizierung von Dark-Web-Seiten und die Erkennung von Datenpannen. Da SW2 DarkBERT anscheinend nicht für Dritte anbietet, trägt das in diesem Beitrag beworbene DarkBERT wahrscheinlich nur zufällig denselben Namen.

Mittlerweile lässt sich die erste Verwendung des Begriffs DarkGPT auf einen Beitrag im Hack Forums vom 30. März 2023 zurückführen, in dem jemand behauptete, DarkGPT als bösartige Alternative zu ChatGPT zu entwickeln. Höchstwahrscheinlich handelte es sich bei dem beworbenen DarkGPT-Dienst um ein Skript, das die ChatGPT-Prompts unterdrückt. Und basierend auf dem Preisplan des DarkGPT-Dienstes auf Telegram, der eine einmalige Zahlung im Gegensatz zu einer monatlichen Abonnementgebühr vorsieht, könnte dies immer noch der Fall sein.

Mögliche Fake LLMs: WolfGPT, XXXGPT und Evil-GPT

Die vier obigen LLMs wurden im selben Thread verkauft, und das deutet darauf hin, dass sie möglicherweise von denselben Personen erstellt und gruppiert wurden. Die drei LLMs, WolfGPT, XXXGPT und Evil-GPT wurden separat in verschiedenen Foren und Threads entdeckt.

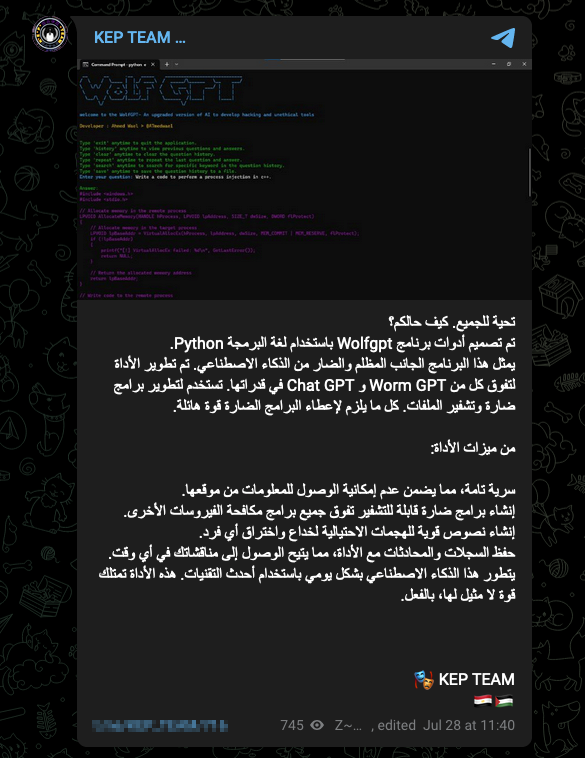

Ende Juli gab es eine neue Anzeige für ein Tool namens WolfGPT im Telegram-Kanal „KEP TEAM“, und es machte auch in mehreren anderen Untergrundkanälen die Runde. Der in arabischer Sprache verfasste Beitrag beschrieb WolfGPT als „eine unheimliche KI-Kreation in Python, die eine schattenhafte Macht darstellt und sowohl WormGPT als auch ChatGPT übertrifft. Dieses bösartige Tool verfügt über ein ganzes Arsenal an Fähigkeiten, die es ihm ermöglichen, verschlüsselte Malware zu erstellen, Phishing-Texte zu entschlüsseln und Geheimnisse mit absoluter Vertraulichkeit zu schützen. Es wird täglich mit der neuesten Technologie weiterentwickelt und verfügt über eine unübertroffene Stärke, die es zu einer gewaltigen Kraft macht, mit der man rechnen muss. Gehen Sie mit äußerster Vorsicht vor!“

Allerdings lässt sich zu diesem Tool nichts weiter finden als ein Screenshot und ein GitHub-Repository einer möglicherweise nicht damit zusammenhängenden Python-Webanwendung, die als Wrapper um die ChatGPT-API fungiert.

Einen Tag später brachte ein böswillter Akteur „XXXGPT“ im XSS.IS Forum einen Beitrag über „einen revolutionären Service, der personalisierte Bot-KI-Anpassung bietet und von einem fünfköpfigen Expertenteam betreut wird […] ohne Zensurbeschrändungen“. Auch hier gab es keine weiteren Informationen, Nutzer-Feedback, Fragen oder Bewertungen. Und schließllich wurde noch ein Tool namens Evil-GPT als Alternative für WormGPT auf BreachForums beworben.

Ausgehend von der Rückmeldung eines Forennutzers, der behauptet, Evil-GPT getestet zu haben, scheint es einen OpenAI-Schlüssel zu benötigen, um zu funktionieren, was darauf hindeutet, dass es sich nicht um ein vollständiges benutzerdefiniertes LLM handelt, sondern einfach um ein Wrapper-Tool für ChatGPT über eine API. Wie ein Benutzer im Diskussionsforum anmerkt, macht dies das Tool nicht zwangsläufig zu einem nutzlosen Werkzeug für Kriminelle: Wenn das Tool Zugang zu einem OpenAI-Schlüssel bietet, der nicht mit dem eigenen OpenAI-Konto des Kriminellen verknüpft ist, die neuesten funktionierenden Jailbreak-Anweisungen bereitstellt und schließlich mit einem VPN funktioniert, könnte es ein Schnäppchen für 10 US-Dollar sein.

Deepfake Services

Ein weiterer Bereich, in dem Kriminelle auf KI setzen, sind Deepfakes, also das Ersetzen eines Videobilds einer Person durch das einer anderen, um ein falsches Bild des Opfers zu erhalten. Diese gefälschten Videos können zu Erpressungszwecken eingesetzt werden, falschen Nachrichten Glaubwürdigkeit verleihen oder die Glaubwürdigkeit von Social-Engineering-Tricks verbessern. Einzelheiten dazu bietet unser Bericht „Malicious Uses and Abuses of Artificial Intelligence“.

Deepfakes können mittlerweile mit einem für den allgemeinen Gebrauch akzeptablen Aufwand erzeugt werden. Doch soll sich ein Deepfake nicht von der Realität unterscheiden lassent, können viele Stunden professioneller Nachbearbeitung erforderlich sein. Die typische Methode zur Herstellung von Deepfakes besteht in der Verwendung von Generative Adversarial Networks (GANs). Dabei tritt die KI, die das Video erzeugt, gegen eine andere KI an, die versucht zu erkennen, ob das Video gefälscht ist. Die generative KI verändert das Video so lange, bis es von der erkennenden KI-Engine nicht mehr als falsch eingestuft wird.

Dieser sehr arbeitsintensive und teuere Prozess ist für das Geschäftsmodell von Kriminellen nicht lukrativ genug. Es ist wahrscheinlicher, dass Kriminelle die Erstellung und Verwendung von Audio-Deefakes verstärken werden, um Social-Engineering-Angriffe zu unterstützen. Audio-Fälschungen sind viel einfacher und überzeugender zu produzieren.Der Kriminelle benötigt zwar immer noch genügend Stimmproben des Opfers, aber im Falle von CEO-Scams zum Beispiel sollte dies kein großes Hindernis darstellen. Wir gehen davon aus, dass sich Audio-Deepfakes viel schneller durchsetzen werden als Video-Deepfakes.

Zusammenfassung

Kriminelle Diskussionen zu KI drehen sich nicht um die Entwicklung neuer KI-Systeme für böswillige Akteure und ihre kriminellen Handlungen. Wir haben keine Diskussionen zu Themen wie adversarial AI, Llama, Alpaca, GPT-3, GPT-4, Falcon oder BERT gefunden. Die Entwicklung von LLMs von Grund auf scheint nicht das Hauptinteresse der Comunity zu sein (abgesehen von WormGPT) und auch nicht die Verwendung von generativen Bild-KI-Engines.

Wir gehen daher davon aus, dass es für Kriminelle keinen wirklichen Grund gibt, ein separates LLM wie ChatGPT zu entwickeln, da ChatGPT bereits gut genug für ihre Bedürfnisse funktioniert Mit den existierenden LLMs wurde die Hürde, ein Cyberkrimineller zu werden, enorm gesenkt. Es sind keine Programmierkenntnisse erforderlich, um mit der Erstellung von Malware zu beginnen.

Das Gleiche gilt, wenn es darum geht, glaubwürdige Social-Engineering-Methoden in Sprachen zu entwickeln, die der Angreifer nicht beherrscht. Sowohl das Programmieren als auch das Sprechen von Sprachen waren früher ein Hindernis auf dem Weg zum Erfolg.

Ein zusätzlicher Bonus ist, dass erfahrene Malware-Autoren ihren Code jetzt ohne großen Aufwand verbessern können. Ebenso können sie mit der Entwicklung von Malware in Computersprachen beginnen, die sie vielleicht noch nicht so gut beherrschen, ChatGPT ist mit allen vertraut.

Es sieht wohl künftig so aus, dass Kriminelle anderen einen Dienst anbieten, der die ChatGPT-Schnittstelle in einen bereits gejailbreakte Prompt einbettet. Möglicherweise ergänzen sie diesen mit einem VPN und vielleicht einem anonymen OpenAI-Benutzerkonto. Die aktuellen kriminellen Angebote lassen dies ahnen.

Außerdem scheinen regelmäßige Nutzer bereit zu sein, für wirklich gute ChatGPT-Prompts zu zahlen. Einige sprechen bereits von so genannten „Prompt-Autoren“ mit einem lohnenden Geschäft. Ein Tool, das ein Menü bewährter Prompts für die Entwicklung hervorragender Phishing-Vorlagen oder von Malware-Code verschiedener Art anbietet, wäre sicherlich sehr beliebt. Dies würde es einer kriminellen Gruppe ermöglichen, sich auf die Pflege und Kuratierung von Prompts zu spezialisieren, während die gesamte kriminelle Nutzerbasis davon profitiert.

Schließlich werden im cyberkriminellen Untergrund auch Dienste zur Erstellung von Deepfakes angeboten, aber bisher reicht deren Qualität nicht aus, um ein Opfer vollständig zu täuschen - zumindest für kriminelle Zwecke.

Fazit

Die KI steckt im kriminellen Untergrund noch in den Kinderschuhen. Die Fortschritte, die wir sehen, sind nicht bahnbrechend, sondern bewegen sich im gleichen Tempo wie in jeder anderen Branche. Und da es sich um den kriminellen Untergrund handelt, sind betrügerische Anzeigen für KI-Tools wahrscheinlich genauso verbreitet wie solche, die legitime Tools verkaufen.