Cyberbedrohungen

Agentengetriebene Edge-KI: Architektur am Rand

Das Konzept der Agentic Edge AI bietet mehr Vorteile für Geräte, die latenzkritische Entscheidungsfindung lokal vorhalten, sodass sie in Echtzeit reagieren und offline weiter funktionieren können. Wie sieht die mehrschichtige Architektur dafür aus?

Wichtige Erkenntnisse:

- Agentengetriebene Edge-KI-Geräte führen ihre Kernfunktionen Wahrnehmung/Schlussfolgerung/–Ausführung lokal (On the Edge, am Rand) aus und können als unabhängige Agenten in ihrer Betriebsumgebung agieren.

- Dazu gehören Smart-Home-Roboter, autonome Fahrzeuge, fortschrittliche Wearables, intelligente Sicherheitssysteme, das industrielle Internet der Dinge (IIoT) und Robotik-Instrumente sowie Verteidigungs- und Luftfahrtwerkzeuge.

- Alle agentengetriebenen Edge-KI-Geräte implementieren eine Variante einer mehrschichtigen KI-Architektur, die die Intelligenz auf das Gerät und die Cloud verteilt.

ChatGPT 3.5 machte dialogorientierte KI-Chatbots von Open AI einem breiten Publikum bekannt und löste einen rasanten Innovationszyklus aus. Die nächste Version GPT-4(Vision) konnte dann sowohl Bilder als auch Texte analysieren. Innerhalb weniger Monate unterstützten alle führenden KI-Chatbots durch die Verarbeitung von Text, Bild, Audio und Video ein gewisses Maß an Multimodalität. Vor einem Jahr kamen agentengetriebenen KI-Systeme auf den Markt, die dann auch die Planung, Entscheidung und Ausführung mehrstufiger Aufgaben beherrschten.

Heute ist der Begriff „agential“ in KI-Diskussionen allgegenwärtig, aber nicht alle als agentengetrieben bezeichneten Systeme sind es wirklich. Um wirklich agentengetrieben zu sein, sollte ein System zielorientiert und kontextsensitiv sein, mehrstufige Schlussfolgerungen ziehen können, handlungsorientiert sein und sich schließlich selbst verbessern können, so die Definition von Trend Micro.

Fortschritte in der KI-Hardware und im Edge-Computing – CPUs mit geringem Stromverbrauch, Grafikprozessoren (GPU), neuronale Prozessoren (NPU), eingebettete Sensor Stacks usw. – haben eine neue Klasse intelligenter Geräte ermöglicht, die auch bei schlechter oder fehlender Cloud-Verbindung zielgerichtet und autonom arbeiten können. Diese KI-gestützten Geräte führen ihre Kernfunktionen Wahrnehmung/Schlussfolgerung/Ausführung lokal (On the Edge, am Rand) aus und können als unabhängige Agenten in ihrer Betriebsumgebung (Haushalte, Fabriken, Fahrzeuge, Wearables usw.) agieren.

KI Edge-Geräte sind die Verschmelzung einer agentengetriebenen Softwarearchitektur mit Edge-Hardware, wobei die Cloud die Autonomie des Geräts ergänzt, statt sie zu ersetzen.

- Agentischer Aspekt – In jedem agentengetriebenen Edge-KI-Gerät befindet sich ein Orchestrator und eine Reasoning Engine (die wahrscheinlich ein kompaktes/leichtgewichtiges/kleines Sprachmodell verwendet, das einen geringeren Speicherbedarf hat und weniger Energie verbraucht), die Zielaufgaben vom Benutzer empfängt und an einen oder mehrere spezialisierte Agenten delegiert. Unter der Aufsicht des Orchestrators bilden diese Agenten zusammen einen adaptiven Workflow, der komplexe Aufgaben mit minimalem menschlichem Eingriff lösen kann, indem er sowohl die nächsten Schritte als auch die Vorgehensweise auswählt.

- Edge-Aspekt – Kritische Aufgaben wie Wahrnehmung, Entscheidungsfindung und Ausführung werden auf den integrierten CPUs, GPUs oder NPUs des Geräts erledigt, sodass das System in Echtzeit reagieren und auch dann weiter funktionieren kann, wenn die Cloud-Verbindung schlecht oder nicht vorhanden ist. Cloud-Dienste werden optional für aufwändige Analysen und Schlussfolgerungen, groß angelegtes Modelltraining und die Koordination auf Flottenebene eingesetzt – als opportunistische Beschleuniger, nicht als einzelne Fehlerquellen.

Ein aktuelles Beispiel für ein agentengetriebenes Edge-KI-Gerät ist Samsungs Ballie, der als smarter Begleiter für zu Hause konzipiert ist. Er ist mit Kameras, Lichtdetektion und -entfernungsmessung (LiDAR), Mikrofonen und einem integrierten Projektor ausgestattet.

Ballie verkörpert den agentengetriebenen Aspekt, indem er proaktiv mit seiner Umgebung interagiert, und den „Edge”-Aspekt, indem es On-Board-Computing für Echtzeitreaktionen nutzt. Weitere Produkte beschreibt der Originalbeitrag.

Mehrschichtige Architektur

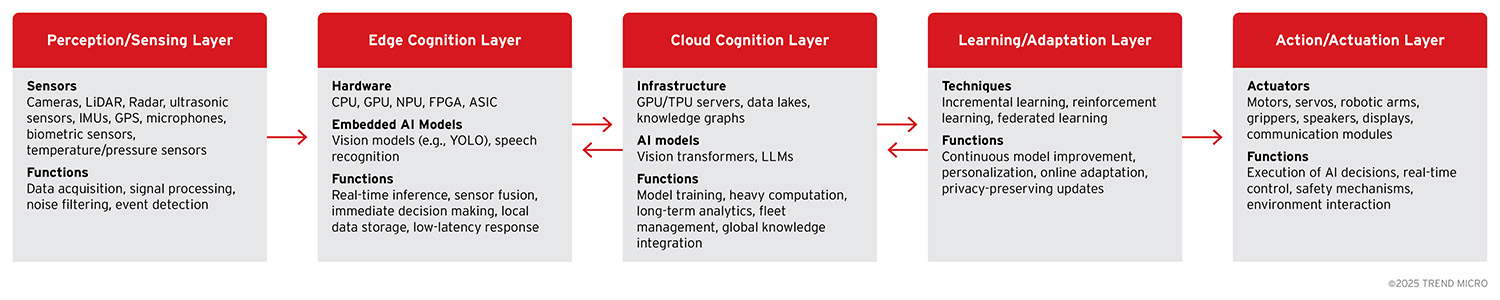

Alle agentengetriebenen Edge-KI-Geräte implementieren eine Variante einer mehrschichtigen KI-Architektur, die die Intelligenz auf das Gerät und die Cloud verteilt. Durch dieses mehrschichtige Design kann das System Echtzeitfunktionen auf dem Gerät von aufwändigeren, Cloud-gestützten Aufgaben trennen und so ein Gleichgewicht zwischen Autonomie und Konnektivität herstellen.

Wahrnehmungs/Erfassungsschicht

Die Schicht ist das „Sinnesorgan“ des agentengetriebenen Edge-KI-Geräts, das für die Beobachtung der Umgebung und deren Umwandlung in Daten zur Verarbeitung zuständig ist. Sie ist über eine Reihe von Sensoren wie Kameras, GPS, Mikrofone, Thermometer usw. mit der physischen Welt verbunden, die kontinuierlich Rohsignale aus der Umgebung des Geräts erfassen.

Die Wahrnehmungsebene umfasst auch Low-Level-Firmware und Treiber, die die Sensorhardware auslesen und eine erste Signalverarbeitung durchführen. Bei einem Heimroboter wie Ballie beispielsweise dienen seine Kamera und sein LiDAR als elektronische Augen, um Personen und Hindernisse in Echtzeit zu erkennen.

Edge-Cognition-Schicht

Sie ist die geräteinterne Intelligenz, das „lokale Gehirn” des Geräts, das Sensordaten sofort verarbeitet und entscheidet in Echtzeit, wie der Agent reagieren soll. Wenn Ballie beispielsweise ein Hindernis auf seinem Weg erkennt, entscheidet die Edge-Kognitionsebene sofort, ob es wenden oder anhalten soll, ohne dass die Cloud dabei helfen muss.

Diese lokale Verarbeitung ist für sicherheitskritische Entscheidungen oder interaktive Verhaltensweisen unerlässlich, bei denen selbst eine Latenzzeit von wenigen hundert Millisekunden in der Cloud inakzeptabel wäre. Daher werden hier nur Aufgaben ausgeführt, die strenge Latenzanforderungen erfüllen, während rechenintensivere oder nicht dringende Analysen auf die Cloud-Ebene verlagert werden können.

Cloud-Cognition-Ebene

Diese Ebene bietet Off-Device-Berechnungen und Deep Intelligence, die die Fähigkeiten des Edge erweitern. Sie ist das „große Gehirn in der Cloud“, auf das Edge-Geräte zurückgreifen, wenn sie schwere Aufgaben zu bewältigen haben. Rechenintensive Aufgaben, groß angelegte Datenanalysen oder Aufgaben, die eine globale Sichtweise über die lokale Perspektive des Geräts hinaus erfordern, werden in die Cloud ausgelagert.

Die Cloud aggregiert auch Daten und Erkenntnisse aus vielen Edge-Geräten, und Deep-Learning-Modelle werden anhand dieser aggregierten Gerätedaten neu trainiert. Cloud-KI-Dienste können groß angelegte Datenspeicherung für Deep Learning aus aggregierten Gerätedaten, große vortrainierte Modelle, wie sie in riesigen Transformer-Netzwerken für Bildverarbeitung oder natürliche Sprachverarbeitung (NLP) zu finden sind, die auf Edge-Geräten nicht praktikabel sind, sowie Koordinationsdienste für Geräteflotten umfassen. Auch das Modelltraining und –updates gehören dazu, bei denen KI-Modelle regelmäßig mit neuen Daten aus dem Feld neu trainiert werden, aufwändige Analysen, z. B. die Suche nach Anomalien in den Aufzeichnungen von Sicherheitskameras eines Monats, und die Bereitstellung eines globalen Kontexts für das Edge-KI-Gerät des Agenten.

Lern-/Anpassungsschicht

Das Edge-Gerät nutzt die Lern-/Anpassungsschicht, um seine KI-Modelle zu aktualisieren, sie an seinen Benutzer oder seine Umgebung anzupassen und neue Erkenntnisse zu integrieren. Das Lernen kann auf dem Gerät (sofern rechnerisch möglich) und/oder in der Cloud erfolgen und kontinuierlich oder periodisch durchgeführt werden.

Beispielsweise lernt ein KI-gestützter Heimroboter die Raumaufteilung eines Hauses und die täglichen Routinen der Familie kennen und verbessert so im Laufe der Zeit seine Navigation und seine vorausschauende Unterstützung. Häufiger umfasst das Lernen jedoch eine Cloud-Komponente: Geräte senden aggregierte Modellaktualisierungen oder Datenzusammenfassungen an die Cloud, wo das aufwändige erneute Training durchgeführt wird, und anschließend werden die aktualisierten Modelle wieder an alle Geräte verteilt.

Aktions/Ausführungsebene

Diese Schicht führt die Entscheidungen des Agenten in der physischen oder digitalen Welt aus. Sie ist das Ausgangsende der Wahrnehmungs/Aktions-Schleife. In einem physischen Agenten wie einem Roboter oder einem autonomen Fahrzeug steuert die Aktionsschicht Motoren, Räder, Roboterarme oder andere Mechanismen, um sich zu bewegen und mit der Umgebung zu interagieren.

Bei einem reinen Softwareagenten, wie z. B. einem Edge-KI-System zur Verwaltung des Netzwerkverkehrs, erfolgt die Ausführung über API-Aufrufe oder Steuersignale an andere Systeme. Bei den meisten agentengetriebenen Edge-KI-Geräten verfügt diese Schicht über eine Echtzeitsteuerung – sie steuert Hardware, die schnell und sicher auf die Entscheidungen der KI reagieren muss. Bei Ballie sind es die Motoren, die den Roboter zum Rollen bringen, den Mechanismus zur Steuerung seines eingebauten Projektors (zum Projizieren von Bildern oder Videos), seinen Lautsprecher oder einen IR-Blaster zum Senden von Signalen an Geräte.

Diese Schicht ist ebenfalls auf Redundanz und Sicherheit ausgelegt: beispielsweise mehrere Bremskreise in einem selbstfahrenden Auto oder Begrenzer, die verhindern, dass sich ein Roboterarm zu schnell bewegt.

Für bestimmte Anwendungen mit hohem Risiko in den Bereichen Verteidigung und Strafverfolgung wird diese Ebene menschliche Entscheidungspunkte beinhalten, eine Human-in-the-Loop, wenn kritische Aktionen wie das Abfeuern von Waffen oder die Anwendung von Gewalt eine ausdrückliche menschliche Genehmigung erfordern, Human-on-the-Loop, um autonom zu agieren, aber menschliche Bediener das Vetorecht und das Situationsbewusstsein behalten.

Zu allen Schichten liefert der Originalbeitrag weitere Einzelheiten. Dort findet sich ebenfalls die Beschreibung der mehrschichtigen Architektur für agentengetriebene Edge-KI als Markov-Kette.

Klassen von agentengetriebenen Edge-KI-Geräten

Agentische Edge-KI umfasst eine breite Palette von Gerätetypen und Anwendungsbereichen. Jede Klasse nutzt die von uns diskutierte mehrschichtige Architektur, allerdings mit unterschiedlichen Verhältnissen zwischen Edge und Cloud und unterschiedlichen Hauptzielen.

KLASSE |

BESCHREIBUNG |

Smart-Home-Roboter |

Entwickelt für Wohnumgebungen; priorisiert benutzerfreundliche Interaktion, sichere Navigation in Innenräumen. Intensive Edge-Verarbeitung für Bildverarbeitung, Hindernisvermeidung und simultane Lokalisierung und Kartierung |

Autonome Fahrzeuge |

Echtzeit-Sensorfusion (Multi-Kamera, LiDAR, Radar, IMU) und Regelkreise unter 100 ms laufen vollständig auf leistungsstarken Edge-Computern. Die Cloud unterstützt das Flottenlernen, die Verteilung hochauflösender (HD) Karten und die Ferndiagnose. |

Fortschrittliche Wearables |

Edge-KI übernimmt die kontinuierliche Analyse von Biosignalen (Herzrhythmus, Blutdruck, Bewegung), die Erkennung von Aktivierungswörtern und das Verständnis von AR-Szenen. Die Cloud wird für aufwändige NLP, Langzeitanalysen und föderiertes Lernen genutzt. |

Intelligente Sicherheitssysteme |

KI-gestützte Kameras, Türklingeln, Sicherheitsdrohnen etc. Geräteinterne KI-Modelle klassifizieren Personen/Fahrzeuge, erkennen Anomalien (Glasbruch, Herumlungern) und entscheiden, ob ein Alarm ausgelöst werden soll. Die Cloud bietet optionalen Speicherplatz, forensische Suche und Gesichtsabgleich mit großen Datensätze. |

IIoT- und Robotik-Instrumente |

Autonome Lagerfahrzeuge, kollaborative Roboterarme etc. Echtzeitsteuerung und Sicherheitsschleifen laufen auf eingebetteten Edge-Controllern; lokale „Fog“-Server hosten aufwändigere Bildverarbeitungs- oder Analyseaufgaben; die Cloud aggregiert Flottendaten aus allen Werken. |

Werkzeuge für Verteidigung und Luft- und Raumfahrt |

Bei der Konstruktion liegt der Schwerpunkt auf gehärteten Komponenten, Strahlungsbeständigkeit, Manipulationsschutz und einer mehrschichtigen Ausfallsicherheit, um Missbrauch oder Erfassung zu verhindern. Edge-Autonomie erfordert oft eine menschliche Autorisierung, insbesondere in Fällen, in denen irreversible oder potenziell schädliche Maßnahmen ergriffen werden sollen. |

Obwohl jede Kategorie ein unterschiedliches Verhältnis zwischen Edge und Cloud aufweist, das auf die erforderlichen Latenz-, Sicherheits- und Datenschutzparameter zugeschnitten ist, haben sie alle denselben Kern: Wahrnehmung auf dem Gerät, lokales Denken, zielorientierte Autonomie und die Fähigkeit, im Laufe der Zeit zu lernen.

Im nächsten Beitrag unserer vierteiligen Serie zum Thema der agentengetriebenen KI-Edge-Systeme geht es um Cybersicherheitsbedrohungen für die mehrschichtige Architektur sowie Maßnahmen zur Risikominimierung.