ИИ-безопасность — это, с одной стороны, инструменты, технологии и меры, которые организации используют для защиты своего ИИ-стека, а с другой — использование ИИ для укрепления систем кибербезопасности, то есть для улучшенного обнаружения уязвимостей, корреляции и реагирования с целью перейти на проактивный подход к обеспечению безопасности.

Содержание

Термин «искусственный интеллект» (ИИ) был придуман в 1950-х годах для описания компьютеров и машин, которые имитируют структуру и функцию человеческого мозга для выполнения сложных задач, решения сложных проблем, прогнозирования будущих результатов и обучения на опыте.

ИИ-безопасность — это область кибербезопасности, которая охватывает все процессы, практики и меры, используемые организациями для защиты своих ИИ-стеков, систем, данных и приложений от потенциальных угроз. Инструменты и технологии на базе ИИ используются для следующих задач:

- Защита всех аспектов сети ИИ организации: от конечных устройств до ИИ-моделей.

- Защита ИИ-моделей, систем и приложений от широкого спектра киберугроз, киберпреступников и кибератак.

- Выявление и устранение уязвимостей и пробелов в системе защиты ИИ и кибербезопасности, пока ими не воспользовались злоумышленники.

- Защита ИИ-инфраструктуры и обучающих данных, чтобы предотвратить повреждение, отравление или кражу данных ИИ-моделей.

- Обеспечение качества и целостности данных для больших языковых моделей (LLM), движков генеративных ИИ и конвейеров глубокого и машинного обучения.

- Устранение этических проблем, связанных с предвзятостью, прозрачностью, конфиденциальностью и объяснимостью.

- Контроль соответствия использования ИИ, данных и разработок всем применимым законам, политикам компании и отраслевым нормам.

Безопасность для ИИ и кибербезопасность на базе ИИ

Хотя эти два термина почти идентичны, между безопасностью для ИИ и кибербезопасностью на базе ИИ есть существенные различия.

Безопасность для ИИ — это защита самого ИИ: стека, систем, компонентов, сетей и приложений.

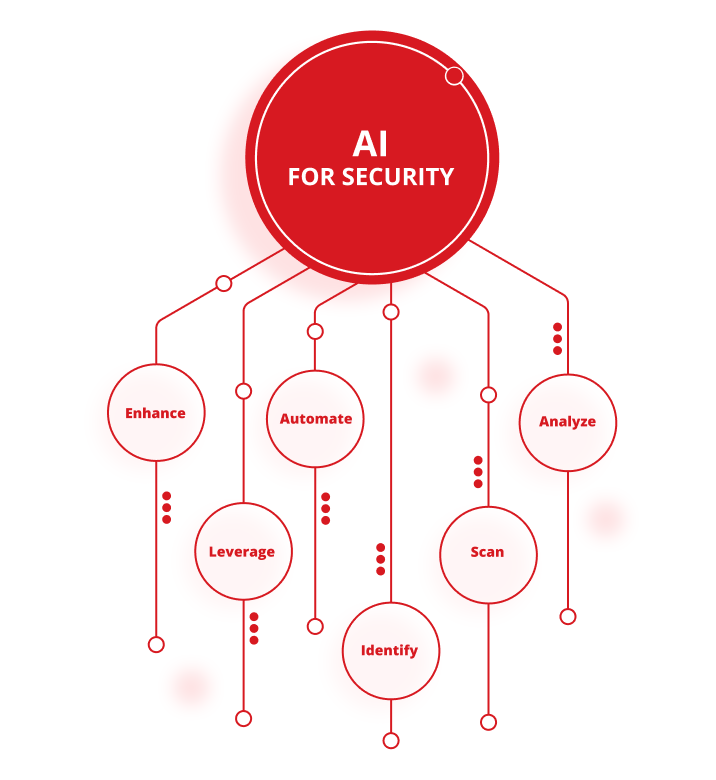

Кибербезопасность на базе ИИ (ИИ для безопасности) заключается в использовании инструментов и технологий ИИ для защиты ИТ-инфраструктур от киберпреступников, кибератак и других киберугроз. Применения ИИ для безопасности:

- Анализ больших объемов данных для выявления закономерностей, аномалий и потенциальных рисков безопасности.

- Поиск и устранение уязвимостей и пробелов в системе кибербезопасности.

- Выявление утечек данных и других кибератак в режиме реального времени и защита от них.

- Автоматизация средства обнаружения угроз и реагирования для снижения нагрузки на специалистов по безопасности и повышения скорости и точности киберзащиты.

- Использование новейшей аналитики угроз, чтобы опережать злоумышленников и отслеживать новые векторы атак.

- Улучшение общих стратегий и возможностей организации по управлению киберугрозами.

Важность обеспечения безопасности ИИ-систем

Хотя идея искусственного интеллекта существует уже несколько десятилетий, только в последнее время новейшие ИИ-технологии активно внедряются во все отрасли, от транспорта и здравоохранения до кибербезопасности. К сожалению, злоумышленники тоже используют возможности ИИ, что привело к значительному росту количества, масштаба и сложности кибератак.

В результате организации должны сделать все возможное, чтобы сохранить целостность, конфиденциальность и доступность своих данных, связанных с ИИ, защитить свои ИИ-инструменты и приложения от новых киберрисков и кибератак, а также обеспечить безопасность ИИ-моделей, систем и алгоритмов от широкого спектра постоянно развивающихся киберугроз.

Неспособность защитить ИИ-системы от любой из этих угроз повышает опасность атак и подвергает клиентов и партнеров риску, в итоге восстановление систем, выплата выкупа, упущенные сделки и снижение производительности могут стоить компании миллионы долларов.

С какими рисками связана ИИ-безопасность?

Искусственный интеллект может радикально изменить сферу кибербезопасности, однако организациям не стоит забывать о проблемах и рисках при реализации эффективной стратегии ИИ-безопасности. Сюда входят:

- Риск увеличения поверхности атаки. Интеграция собственных и сторонних ИИ-моделей в ИТ-инфраструктуру организации может значительно расширить поверхность атаки, увеличить количество слабых мест и сделать ИИ-системы уязвимыми для более мощных и частых кибератак.

- Риск вредоносных или состязательных атак на данные и алгоритмы ИИ. Злоумышленники могут получать несанкционированный доступ к ИИ-инструментам и данным, манипулировать данными и алгоритмами ИИ, чтобы внедрить в результат погрешности и предвзятость, помешать ИИ-моделям делать точные прогнозы и защищаться от будущих атак, а также неправомерно использовать и красть ИИ-модели и алгоритмы.

- Риск отравления, повреждения и манипулирования данными. Киберпреступники могут повредить конвейеры машинного обучения или «отравить» ИИ-модели, намеренно изменяя входные данные или вставляя новые данные, чтобы скомпрометировать ИИ-инструменты и системы.

- Риски для моделей обучения ИИ. Киберпреступники могут украсть, использовать в своих целях или реконструировать проприетарные модели обучения ИИ. Они также могут повредить, украсть или изменить данные, используемые для разработки и обучения ИИ-моделей, чтобы нарушить их точность, эффективность и целостность.

- Риск предвзятости, дискриминации, конфиденциальности данных и недостаточной прозрачности. Человеческий фактор и кибератаки усугубляют проблемы конфиденциальности данных и предвзятость в ИИ-моделях и могут поставить под угрозу принципы прозрачности, справедливости и ответственности.

- Риск несоблюдения отраслевых и государственных нормативных требований. Ненадлежащая защита чувствительных, персональных или конфиденциальных данных, в том числе несоблюдение Общего регламента по защите данных (GDPR), может привести к серьезным штрафам и наказаниям со стороны государственных и отраслевых регулирующих органов.

- Риск атак через сторонних поставщиков. Злоумышленники могут атаковать ИИ-системы в любой точке цепочки поставок организации, чтобы воспользоваться слабыми местами в ИИ-сетях, компонентах, фреймворках и программных библиотеках сторонних партнеров и через эти уязвимости атаковать другие ИИ-модели в любой точке цепочки.

- Риски дрейфа и устаревания ИИ-моделей. Со временем все ИИ-модели подвергаются дрейфу или устареванию. Злоумышленники могут использовать этот недостаток, чтобы изменить поведение модели или снизить ее точность и надежность.

- Риск кражи учетных данных чат-ботов. Киберпреступники могут украсть учетные данные чат-ботов для поставщиков ИИ, таких как ChatGPT, или купить украденные учетные данные в даркнете, чтобы с их помощью получать незаконный доступ к проприетарным ИИ-инструментам и системам.

- Риск дипфейковых фотографий, видео и аудио. Злоумышленники могут использовать генерируемые ИИ дипфейки для обмана организаций, вымогательства у физических лиц или компаний, обмана сотрудников с целью получения доступа к критически важным системам, раскрытия конфиденциальной информации или кражи ценных данных.

- Риск прямых и косвенных атак с помощью промпт-инъекций. При атаках с помощью промпт-инъекций злоумышленники используют вредоносный код, чтобы обманом заставить большие языковые модели (LLM) и другие ИИ-инструменты выдать конфиденциальную информацию, разрешить несанкционированный доступ или удалить ключевые документы.

- Риск злоупотребления галлюцинациями ИИ. Злоумышленники могут воспользоваться распространенными «галлюцинациями» ИИ, чтобы намеренно испортить данные, на которых обучаются ИИ-модели, и повлиять на решения, которые они принимают.

- Риски для облачных активов и инфраструктуры. Киберпреступники могут взломать облачные ИИ-модели, а также повредить или украсть свои данные и другие активы.

Если организации не обеспечат надежные, комплексные и актуальные меры безопасности ИИ, злоумышленники могут воспользоваться этими и другими рисками, чтобы снизить эффективность и надежность ИИ-моделей, украсть конфиденциальные или чувствительные данные и нанести значительный финансовый и репутационный ущерб.

Каковы преимущества безопасности для ИИ?

Организации, которые внедряют меры безопасности для защиты своих ИИ-стеков, получают ряд убедительных преимуществ. Например:

- Защита данных ИИ от компрометации, повреждения, манипуляций, утечки или кражи.

- Защита ИИ-моделей от взломов и кибератак с помощью инструментов и технологий обнаружения угроз и реагирования, поиска угроз и сканирования уязвимостей в реальном времени.

- Защита ИИ-инфраструктур путем проактивного устранения пробелов или уязвимостей в киберзащите, управления киберрисками, а также защиты ИИ-активов.

- Защита пользователей ИИ и локальных приложений от вредоносных кодов, незаконного или несанкционированного доступа, мошенничества и фишинговых схем, а также программ-вымогателей

- Контроль доступа к частным и общедоступным ИИ-сервисам, включая приложения на основе LLM.

- Защита от атак «нулевого дня», направленных на ранее неизвестные уязвимости программного или аппаратного обеспечения с целью украсть данные, раскрыть конфиденциальную информацию, установить вредоносное ПО и другие вирусы или получить доступ к ИТ-инфраструктуре организации

Передовые методы обеспечения безопасности для ИИ

Самые эффективные решения по безопасности для ИИ используют ряд передовых методов, принятых в отрасли, для защиты ИИ-инструментов и ресурсов. Например:

- Разработка комплексной стратегии безопасности для ИИ, которая сочетает в себе функции моделирования продвинутых угроз и активного поиска угроз с возможностями оценки рисков на базе ИИ, комплексными средствами контроля безопасности ИИ и подробными планами и процедурами реагирования на инциденты для защиты ИИ-систем и данных организации.

- Обеспечение качества, целостности и надежности данных для обучения ИИ для решения проблем, связанных с прозрачностью, предвзятостью и объяснимостью, а также для обеспечения максимальной точности и эффективности ИИ-моделей.

- Внедрение фреймворков безопасности для ИИ по отраслевым стандартам для создания четкого набора стандартов и рекомендаций по защите ИИ-систем, устранению пробелов или уязвимостей в защите ИИ и соблюдению всех соответствующих требований к безопасности ИИ. Сюда входит интеграция систем безопасности, таких как Система управления рисками, связанными с искусственным интеллектом, (Artificial Intelligence Risk Management framework) Национального института стандартов и технологий (NIST), матрица MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) и Разумная нормативно-правовая база для ИИ-безопасности (Sensible Regulatory Framework for AI Security), список Десять лучших практик для приложений на базе больших языковых моделей от Open Worldwide Application Security Project (OWASP), Secure AI Framework (SAIF) от Google и стандарты ISO/IEC 27001 для систем управления информационной безопасностью (ISMS).

- Интеграция ИИ-безопасности с существующими мерами безопасности и кибербезопасности для создания комплексной защиты от киберугроз для всех ИИ- и ИТ-приложений, инструментов, систем и сетей.

- Регулярное обучение и повышение осведомленности сотрудников с целью информировать о последних угрозах и мерах безопасности как специалистов по кибербезопасности, так и других сотрудников, а также развивать корпоративную культуру, основанную на постоянном совершенствовании.

- Непрерывный мониторинг, оценка и обновление ИИ-моделей для поиска и устранения уязвимостей в ИИ-инструментах и системах, выявления возникающих угроз по мере их возникновения и постоянного совершенствования ИИ-моделей и приложений для повышения их точности, производительности и надежности.

Примеры применения ИИ для кибербезопасности

По мере развития ИИ-инструментов появляются все новые применения ИИ в кибербезопасности.

Средства кибербезопасности на базе ИИ могут значительно расширить охват и повысить эффективность защиты от киберугроз, поскольку с их помощью можно автоматизировать обнаружение угроз и реагирование на инциденты, регулярно или непрерывно выполнять сканирование уязвимостей и другие проактивные действия, а также использовать новейшие аналитические данные об угрозах и безопасности для прогнозирования и предотвращения новых киберугроз.

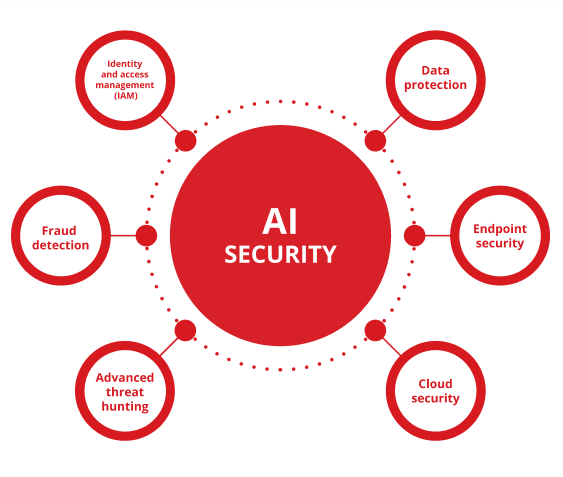

К наиболее эффективным и широко используемым сценариям применения ИИ для кибербезопасности относятся использование ИИ для защиты данных, безопасности конечных точек, безопасности облака, активного поиска угроз, выявления мошенничества и управления идентификацией и доступом (IAM).

- Защита данных

Организации могут использовать ИИ для классификации и шифрования своей конфиденциальной и чувствительной информации, мониторинга доступа к системам для более быстрого и точного обнаружения утечек данных, защиты данных ИИ от потери или повреждения, а также защиты ИИ-стека от несанкционированного доступа, использования или раскрытия. «Слепые зоны» в ИИ-средах могут привести к серьезным утечкам конфиденциальных данных и проблемам с комплаенсом, поэтому так важно проактивно выявлять и устранять эти уязвимости.

- Безопасность конечных точек

Решения для обнаружения угроз и реагирования на инциденты на конечных точках (EDR) с поддержкой ИИ помогают защищать ноутбуки, компьютеры, серверы, мобильные устройства и другие сетевые конечные точки в режиме реального времени путем проактивного обнаружения и блокировки вредоносных программ, программ-вымогателей и других кибератак до инцидента.

- Защита облака

Технологии безопасности облачных сред на базе ИИ могут круглосуточно отслеживать и контролировать доступ к облакам, выявлять любые аномалии или подозрительную активность, предупреждать специалистов по безопасности о потенциальных угрозах по мере их возникновения и защищать облачные данные и приложения от несанкционированного доступа и утечки данных.

- Проактивный поиск сложных угроз

Передовые инструменты для активного поиска угроз на базе ИИ позволяют быстро и просто анализировать журналы данных, шаблоны сетевого трафика, действия и поведение пользователей, чтобы выявлять вредоносные атаки и останавливать их, прежде чем они смогут нанести серьезный ущерб, а также защищать ИИ-системы и инфраструктуру от сложных постоянных угроз (APT) и других кибератак.

- Выявление мошенничества

Организации, оказывающие банковские и финансовые услуги, могут с помощью алгоритмов машинного обучения, нейросетей и других передовых технологии ИИ обнаруживать потенциально мошеннические действия, блокировать несанкционированный доступ к банковским или другим счетам и предотвращать кражу личных данных в финансовых и электронных транзакциях.

- Управление идентификацией и доступом (IAM)

Решения для управления идентификацией и доступом (IAM) с поддержкой ИИ помогают организациям отслеживать и защищать каждый этап процессов аутентификации, авторизации и управления доступом, чтобы контролировать соблюдение всех корпоративных политик по ИИ, плейбуков и отраслевых требований, предотвращать несанкционированный доступ к чувствительным данным и защищаться от атак.

Где получить помощь в обеспечении безопасности ИИ?

Trend Vision One™ — это комплексная платформа кибербезопасности с поддержкой ИИ.

Trend Vision One предлагает широкий набор ведущих в отрасли ИИ-инструментов и технологий, которые могут обнаруживать, прогнозировать и предотвращать киберугрозы гораздо быстрее и эффективнее, чем традиционные средства безопасности под руководством человека. Для обеспечения эффективной безопасности ИИ-стека требуется защита каждого уровня — от данных до инфраструктуры и пользователей — путем обеспечения видимости теневых развертываний ИИ, применения строгих средств контроля доступа в целях комплаенса и установления ограничений для API ИИ, чтобы предотвращать несанкционированное использование и отравление моделей. Эти возможности позволяют организациям защитить весь ИИ-стек и свои данные, приложения и системы ИИ от подавляющего большинства кибератак до их возникновения.

Trend Vision One также включает непревзойденные возможности Trend Cybertron — первого в мире по-настоящему проактивного ИИ в области кибербезопасности. Благодаря проверенной коллекции больших языковых моделей (LLM), наборов данных, современных ИИ-агентов и более чем 20-летнему опыту инвестиций в сферу безопасности ИИ, Trend Cybertron анализирует тенденции и данные, чтобы прогнозировать атаки, специфичные для каждого клиента, позволяя организациям на 99% быстрее устранять проблемы по сравнению с традиционным процессом реагирования на инциденты и почти моментально менять подход к безопасности с реактивного на проактивный.

Trend Cybertron непрерывно развивается и адаптируется к потребностям организации и отслеживает новейшие тактики, техники и процедуры (TTP), используемые киберпреступниками. Он помогает организациям обеспечивать максимально надежную, комплексную и актуальную безопасность для ИИ и на базе ИИ.

Майкл Хабиби — лидер в области кибербезопасности с более чем 12-летним опытом работы, специализирующийся на разработке продуктов и стратегических инновациях. На посту вице-президента по управлению продуктами в Trend Micro Майкл управляет адаптацией стратегии по продуктам для конечных точек к быстро развивающемуся ландшафту угроз.

Часто задаваемые вопросы

Что такое безопасность ИИ?

Безопасность для ИИ подразумевает использование различных инструментов, практик и технологий для защиты стека ИИ в организации.

Что означает ИИ в безопасности?

ИИ расшифровывается как «искусственный интеллект». ИИ используется для улучшения защиты от киберугроз и обеспечения безопасности ИИ-стеков.

Как можно использовать ИИ в безопасности?

ИИ может использоваться для защиты сетей, моделей, систем, конечных точек и приложений от кибератак, повреждения данных и других угроз.

Что такое ИИ в кибербезопасности?

Применение ИИ в кибербезопасности подразумевает использование инструментов и технологий ИИ для защиты организаций от кибератак.

Представляет ли ИИ угрозу безопасности?

Как и любая технология, ИИ может использоваться для усиления мер безопасности или запуска более мощных кибератак.

Стоит ли строить карьеру в сфере ИИ?

Безопасность ИИ — растущая область, в которой специалистов ждет перспективная и хорошо оплачиваемая работа.

Сколько зарабатывают специалисты по безопасности ИИ?

В зависимости от своего опыта и местоположения специалисты по безопасности ИИ могут зарабатывать от 60 000 до 120 000 долларов США в год.

Как попасть в сферу безопасности ИИ?

Для начала карьеры понадобится пройти онлайн-курсы, получить диплом по информатике или кибербезопасности или пройти сертификацию в области ИИ-безопасности.

В чем разница между кибербезопасностью и безопасностью ИИ?

Кибербезопасность — это инструменты или системы, которые защищают организации от кибератак. Безопасность ИИ направлена на защиту ИИ-стека организации.

Может ли ИИ обеспечить кибербезопасность?

Технологии ИИ под наблюдением человека могут значительно повысить скорость, точность и эффективность практически всех аспектов кибербезопасности.

В чем разница между традиционной кибербезопасностью и кибербезопасностью на базе ИИ?

Несмотря на то, что их цели и методы одинаковы, кибербезопасность на базе ИИ может обеспечить более быструю, точную и активную защиту по сравнению с традиционной кибербезопасностью.

Требуются ли навыки написания кода в кибербезопасности?

Хотя умение писать код может быть ценным навыком в сфере кибербезопасности, многие задачи не требуют опыта или знаний в области программирования.

Почему ИИ представляет угрозу для безопасности?

ИИ может использоваться злоумышленниками для взлома ИТ-систем, кражи конфиденциальных данных, повреждения ИИ-стеков или запуска сложных кибератак.

Приведите пример утечки данных ИИ.

Дипфейки, созданные с помощью ИИ, используются для подделки голосов или видеоизображений реальных людей с целью выманить у сотрудников конфиденциальную информацию.

Защищено ли приложение безопасности ИИ?

В конечном итоге защищенность приложения по безопасности зависит от надежности его разработчика, а не от его цены. Выбирайте крупных поставщиков, прошедших независимое тестирование, и избегайте приложений из неизвестных источников.

С какими рисками связана ИИ-безопасность?

В сфере безопасности ИИ можно выделить такие распространенные риски, как расширенные поверхности атак, отравление и повреждение данных, а также риски для данных, алгоритмов и моделей обучения.

Связана ли моя ИИ-система с высокими рисками?

Организации могут снизить риски для ИИ-систем, анализируя свои текущие защитные механизмы, следуя передовым отраслевым практикам и внедряя комплексные стратегии безопасности и кибербезопасности ИИ.

Следует ли доверять детектору ИИ?

Хотя детекторы ИИ могут быть эффективными инструментами, иногда они ошибаются. Поэтому их результаты следует использовать только в качестве предварительного сигнала для начала расследования, которое должно основываться на человеческом суждении.

Как проявлять осторожность при работе с ИИ?

По-настоящему осторожный подход к ИИ требует от пользователей и создателей иного подхода. Используя или разрабатывая ИИ, помните главное правило: относитесь к ИИ как к эффективному, но несовершенному инструменту, а не авторитетному эксперту или надежному помощнику.

Как защитить ИИ?

Комплексная система безопасности для ИИ-стека не оставляет слепых зон, применяя защиту для каждого компонента — от пользователей и данных, которые они генерируют, до моделей, микросервисов и базовой инфраструктуры.

Статьи по теме

10 основных рисков и мер по их снижению для LLM и генеративного ИИ в 2025 году

Управление возникающими рисками для общественной безопасности

Как далеко заведут нас международные стандарты?

Как написать политику кибербезопасности для генеративного ИИ

Атаки с использованием ИИ — один из самых серьезных рисков

Распространение угроз, связанных с дипфейками