Внедрение ИИ-технологий приводит к появлению новых уязвимостей, которых не было в традиционных вычислительных средах. К ним относятся вредоносные кибератаки, инициированные злоумышленниками, и уязвимости, связанные с платформой и поведением пользователей.

Содержание

Уязвимости ИИ

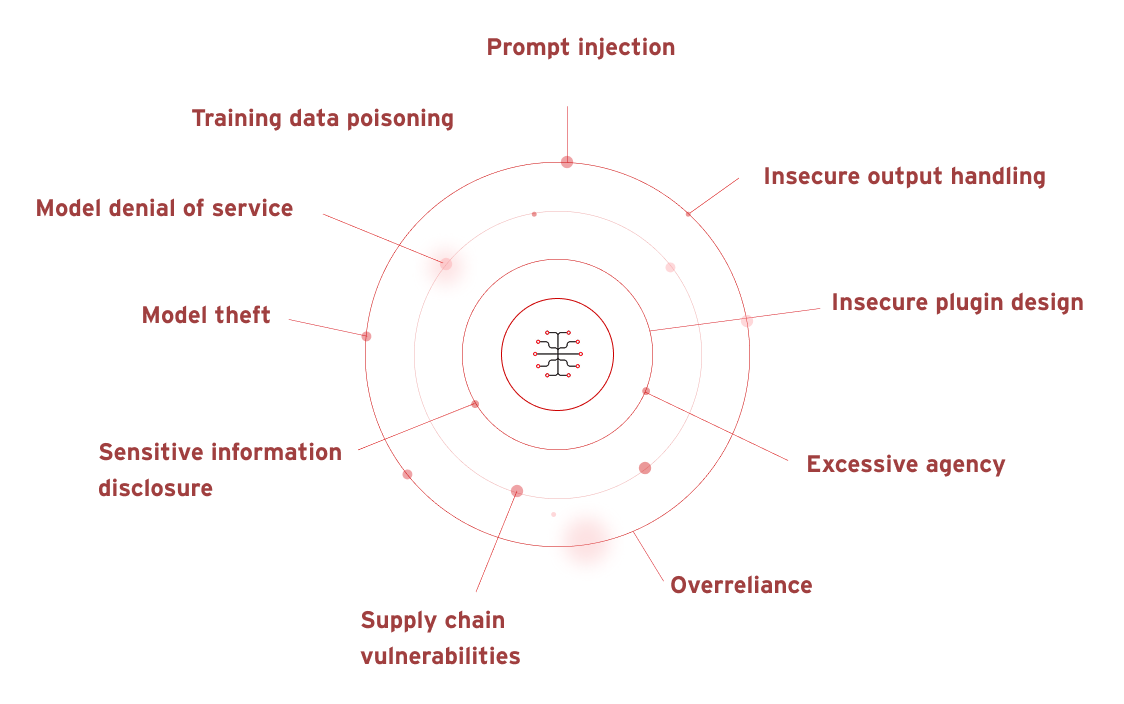

Некоммерческая организация OWASP (Open Web Application Security Project) выявила ряд уязвимостей ИИ, построенного на больших языковых моделях (LLM). К ним относятся:

- промпт-инъекции;

- небезопасная обработка выходных данных;

- отравление обучающих данных;

- отказ в обслуживании;

- уязвимости в цепочке поставок;

- раскрытие конфиденциальной информации;

- небезопасный дизайн плагинов;

- чрезмерная самостоятельность;

- излишнее доверие к модели;

- кража модели.

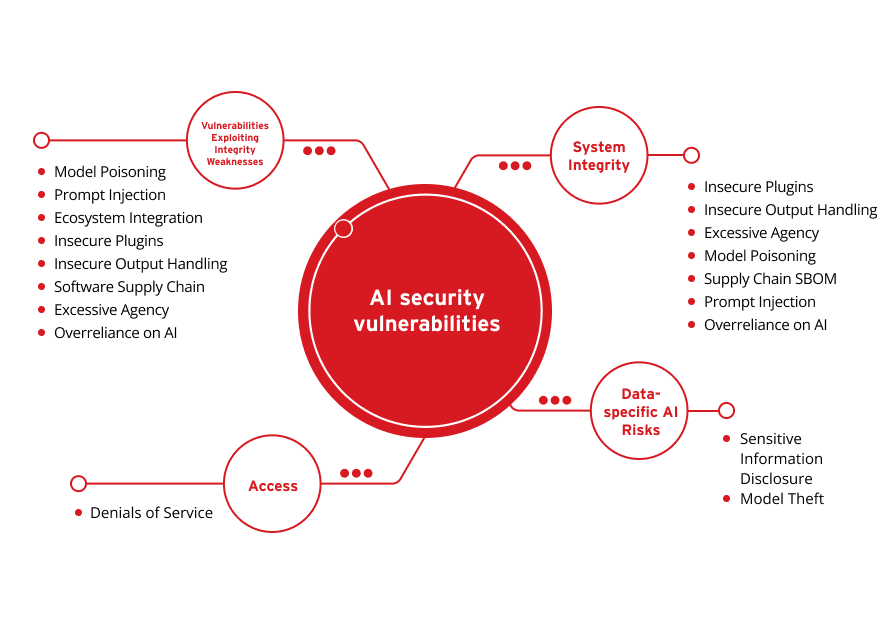

Эти уязвимости можно упрощенно разбить на следующие основные категории:

Риски ИИ, связанные с данными

Целостность системы

Доступ

Уязвимости и слабые места

Раскрытие конфиденциальной информации

Кража модели

Небезопасные плагины

Небезопасная обработка выходных данных

Чрезмерная самостоятельность

Отравление модели

Список зависимостей в цепочке поставок

Промпт-инъекции

Излишнее доверие к ИИ

Отказ в обслуживании

Отравление модели

Промпта-инъекции

Интеграция с экосистемой

Небезопасные плагины

Небезопасная обработка выходных данных

Цепочка поставок ПО

Чрезмерная самостоятельность

Излишнее доверие к ИИ

ИИ чрезвычайно зависим от доступной ему информации и от данных, которые вводят пользователи, поэтому ИИ все чаще становится мишенью для злоумышленников, которые пытаются взломать цифровую защиту и похитить конфиденциальную информацию. В ходе исследования, которое недавно провела компания Gartner®, были выявлены пять новых рисков, самых распространенных в I кв. 2024 г. Два первых места в списке заняли риски, связанные с ИИ — атаки с применением ИИ и дезинформация с помощью ИИ. Gartner отмечает, что усовершенствование ИИ может облегчить применение фишинга и социальной инженерии, повысив к ним доверие жертв — это приведет к более успешным вторжениям и более разрушительным атакам.

Rogue AI

Rogue AI («вышедший из подчинения ИИ») — это ситуация, когда ИИ действует вопреки поставленной цели. Такое отклонение может произойти случайно, например, из-за отсутствия соответствующих управляющих правил. Также это может быть преднамеренное вмешательство, когда злоумышленники пытаются подчинить себе ИИ-систему и использовать ее, или устанавливают в среду вредоносные модели ИИ.

Автоматизация мошенничества

Автоматизация мошенничества — это создание синтетического контента: текстового, аудио или видео, для компрометации бизнес-процессов с помощью фишинговых и BEC-атак, а также видео- или аудио-дипфейков. Автоматизация мошенничества легко масштабируется с помощью ИИ.

Управление данными

Системы ИИ зависят от данных. Поэтому данные, используемые в системах искусственного интеллекта, в том числе вводимые в данный момент, должны соответствовать всем нормам конфиденциальности и добросовестного использования. Чтобы минимизировать риски, необходимо обеспечить проактивное и эффективное управление данными.

Риски безопасности, связанные с большими языковыми моделями (LLM)

LLM-модели сталкиваются с критическими уязвимостями, включая промпт-инъекции для манипуляции поведением модели, раскрытие чувствительной информации и конфиденциальных данных, а также ненадлежащую обработку выходных данных для атаки на последующие системы. К серьезным рискам также относятся уязвимости в цепочке поставок в связи с зависимостью от третьих сторон, предоставление чрезмерных разрешений, отравление данных, которое ставит под угрозу целостность модели, и утечка промптов с конфиденциальными инструкциями. Кроме того, слабые места, связанные с векторными представлениями, генерация недостоверной информации и атаки, использующие неограниченное потребление, угрожают безопасности, надежности и доступности LLM-приложений.

Риски безопасности, связанные с промптами для генеративного ИИ

Генеративный ИИ использует для ответов данные, полученные ранее и в данный момент. Поэтому при работе с инструментами, требующими промпта (текстового запроса от пользователя), необходимо быть очень внимательным к тому, что вы вводите в поле запроса. Некоторые ИИ-инструменты позволяют пользователям отказаться от участия в сборе данных, например в ChatGPT есть возможность отключить историю чата. В зависимости от политики управления и использования ИИ, которую внедряет регулирующий орган в данной отрасли, превентивные меры и подобные им действия могут быть обязательными для обеспечения соответствия требованиям.

Учтите, что если вы введете финансовые данные, конкретные характеристики еще не выпущенного программного обеспечения, персональные данные, например личные адреса и реквизиты, или другие конфиденциальные данные, то ИИ-приложение будет иметь к ним свободный доступ. Такие данные представляют собой риск: приложение может вставить их в ответ на аналогичные запросы, злоумышленники могут их использовать для манипулирования кем-то или украсть. Это особенно опасно, когда генеративный ИИ используются для генерации идей или для быстрой компиляции большого объема данных, тем более, если шифрование и средства безопасности неудовлетворительные.

Риски безопасности при использовании ChatGPT

ChatGPT — это чат-бот на базе генеративного ИИ, который выдает текстовые ответы на запросы пользователя (промпты). Злоумышленники могут использовать ChatGPT для маскировки фишинговых писем или повышения уровня их воздействия. Кроме того, они могут атаковать саму платформу, чтобы получить доступ к данным пользователей для неправомерного использования. Например, чтобы составить фишинговые письма на основе образцов писем организации или частного лица, а также исправить опечатки, грамматику и стиль, сделав письма более убедительными. Также существует риск кражи пользовательских данных и взлома с помощью промпта-инъекций или джейлбрейка.

Существуют также риски безопасности, которые не связаны напрямую со злоумышленниками. Например, информация, которую ChatGPT получает от пользователя, может быть использована для обучения LLM. Существует также риск неудовлетворительного шифрования данных. Так, недавно в приложении ChatGPT для macOS обнаружили опасную проблему: чаты пользователей хранились открытым текстом.

Риски безопасности при использовании OpenAI

Сам OpenAI API может стать целью для киберпреступников. Несмотря на соответствие стандарту SOC 2 и регулярные тестирования на проникновение полностью исключить риски нельзя, поскольку киберугрозы постоянно развиваются. В недавней статье Soft Kraft всесторонне рассматриваются риски безопасности данных OpenAI. Часть из них представляет особый интерес для корпоративных пользователей:

- данные из разговоров в ChatGPT могут использоваться для переобучения моделей;

- данные, которые пересылаются через API, могут быть открыты для внутреннего и внешнего доступа;

- обеспечить соответствие требованиям Общего регламента по защите данных (GDPR) довольно трудно;

- наличие сторонних субпроцессоров усложняет процесс локализации и обработки данных.

Риски безопасности ИИ при использовании Microsoft Copilot

Благодаря поддержке приложений Microsoft 365, Microsoft Copilot доступен для широкой аудитории. Более того, новые ПК на базе Windows будут оснащаться клавиатурой с клавишами Copilot, что еще больше упростит взаимодействие с пользователями. Оптимизированный доступ может создать дополнительный риск для безопасности, если Copilot так же, как другим инструментам генеративного ИИ, будет доступна конфиденциальная информация. Если разрешения будут установлены неправильно или в документах, сгенерированных ИИ, не будут включены соответствующие настройки, может произойти утечка конфиденциальных данных или нарушена защита. То же самое относится и к управлению доступом пользователей. Наконец, атаки на саму платформу могут позволить злоумышленникам изменять способы доступа к данным и обмена ими.

Кто поможет управлять рисками безопасности для ИИ?

Непрерывное развитие инноваций в области ИИ требует проактивной защиты, которая опирается на 35-летний опыт в области аналитики угроз, 20-летний опыт разработки ИИ и непревзойденную защиту от уязвимостей, — Trend Vision One™ AI Security.

С помощью нашего решения по безопасности для ИИ мы защищаем критически важные рабочие нагрузки, включая весь ИИ-стек, и одновременно укрепляем общую безопасность. Благодаря Trend Cybertron наша система безопасности для ИИ прогнозирует пути атак и обнаруживает аномалии, защищая от дипфейков и атак, генерируемых ИИ, чтобы устранить слепые зоны безопасности и превратить инструменты безопасности для ИИ в катализатор инноваций.

Статьи по теме

10 основных рисков и мер по их снижению для LLM и генеративного ИИ в 2025 году

Управление возникающими рисками для общественной безопасности

Как далеко заведут нас международные стандарты?

Как написать политику кибербезопасности для генеративного ИИ

Атаки с использованием ИИ — один из самых серьезных рисков

Распространение угроз, связанных с дипфейками