La sicurezza dell'IA riguarda sia le misure per proteggere le tecnologie e gli strumenti di intelligenza artificiale, sia l’uso dell’IA per rafforzare la cybersecurity, migliorando il rilevamento delle vulnerabilità e la risposta agli incidenti in modo proattivo.

Sommario

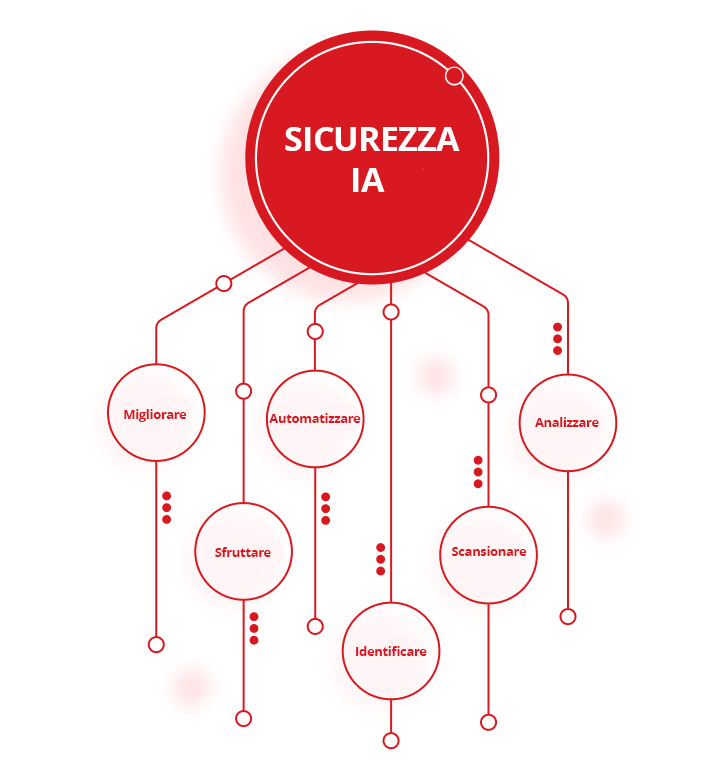

Sicurezza IA

Il termine "intelligenza artificiale" (IA) è stato coniato per la prima volta negli anni '50 per descrivere computer e macchine che imitano la struttura e la funzione del cervello umano per svolgere attività complicate, risolvere problemi complessi, prevedere risultati futuri e imparare dall'esperienza.

La sicurezza dell'intelligenza artificiale (chiamata anche sicurezza dell'intelligenza artificiale o "sicurezza per l'intelligenza artificiale") è un ramo della cybersecurity che comprende tutti i processi, le pratiche e le misure che le organizzazioni utilizzano per proteggere i loro stack di intelligenza artificiale e salvaguardare i loro sistemi, dati e applicazioni di intelligenza artificiale da potenziali minacce. Ciò include l'uso di strumenti e tecnologie basati sull'intelligenza artificiale per:

- Proteggere ogni aspetto della rete IA di un'organizzazione dagli endpoint ai modelli IA

- Proteggere modelli, sistemi e applicazioni IA da un'ampia gamma di minacce informatiche, cyber criminali e attacchi informatici

- Identificare e mitigare eventuali lacune o vulnerabilità nella sicurezza IA e nelle difese di cybersecurity prima che possano essere sfruttate

- Proteggere l'infrastruttura IA e i dati di addestramento per prevenire la corruzione, l'avvelenamento o il furto di dati dei modelli IA

- Garantirere la qualità e l'integrità dei dati dei modelli linguistici di grandi dimensioni (LLM), dei motori di IA generativi (GenAI) e delle pipeline di deep learning e machine learning (ML)

- Affrontare potenziali problemi etici e preoccupazioni relative a questioni di pregiudizio, trasparenza, privacy dei dati e spiegabilità

- Assicurare che tutti gli usi, i dati e lo sviluppo dell'IA siano pienamente conformi alle leggi, alle politiche aziendali e alle normative del settore pertinenti

Sicurezza IA VS Cybersecurity IA

Anche se i due termini sembrano quasi identici, c'è una differenza essenziale tra la sicurezza IA e la cybersecurity IA.

La sicurezza dell'IA consiste nel proteggere l'IA stessa, proteggendo lo stack IA di un'organizzazione e i suoi sistemi, componenti, reti e applicazioni IA.

La cybersecurity basata sull'intelligenza artificiale (chiamata anche "IA per la sicurezza") riguarda l'utilizzo di strumenti e tecnologie IA per proteggere le infrastrutture IT da cyber criminali, attacchi informatici e altre minacce informatiche. Ciò include l'utilizzo dell'IA per:

- Analizzare grandi volumi di dati per rilevare schemi, identificare anomalie ed evidenziare potenziali rischi per la sicurezza

- Scansionare ed eliminare le lacune e le vulnerabilità nelle difese di cybersecurity di un'organizzazione

- Identificare e difendersi dalle violazioni dei dati e da altri attacchi informatici in tempo reale

- Automatizzare gli strumenti di rilevamento e risposta alle minacce per ridurre la domanda dei team di sicurezza e migliorare la velocità e l'accuratezza delle difese informatiche

- Sfruttare le ultime informazioni sulle minacce per stare al passo con i malintenzionati e rimanere aggiornati sui vettori di attacco nuovi o emergenti

- Migliorare le strategie e le capacità complessive di gestione delle minacce informatiche di un'organizzazione

L'importanza di proteggere i sistemi IA

Mentre l'idea di intelligenza artificiale esiste da decenni, i recenti progressi nella tecnologia IA hanno trasformato settori che vanno dai trasporti e dall'assistenza sanitaria alla cybersecurity. Purtroppo, l'adozione diffusa dell'IA ha consentito agli attori malintenzionati di sfruttarla, portando a un aumento significativo del numero, della portata e della sofisticatezza degli attacchi informatici.

Di conseguenza, le organizzazioni devono assicurarsi di fare tutto il possibile per mantenere l'integrità, la riservatezza e la disponibilità dei propri dati IA, salvaguardare i propri strumenti e applicazioni IA da rischi informatici e attacchi informatici nuovi ed emergenti e proteggere i propri modelli, sistemi e algoritmi IA da un'ampia varietà di minacce informatiche in continua evoluzione.

La mancata salvaguardia e protezione dei sistemi IA da una qualsiasi di queste minacce potrebbe potenzialmente aprire un'organizzazione ad attaccare, mettere a rischio i propri clienti e partner e finire per costare loro milioni di dollari in spese di ripristino, richieste di riscatto, vendite perse e produttività persa.

Quali sono i rischi per la sicurezza dell'IA?

Il potenziale dell'intelligenza artificiale di rivoluzionare il campo della cybersecurity è chiaramente promettente. Ma c'è un numero crescente di rischi e sfide per la sicurezza IA che le organizzazioni devono considerare quando implementano una strategia di sicurezza IA efficace. Tra cui:

- Rischio di un aumento della superficie di attacco: l'integrazione di modelli IA proprietari e di terze parti nell'infrastruttura IT di un'organizzazione può espandere drasticamente la sua superficie di attacco, aumentare il numero di punti deboli che i malintenzionati possono sfruttare e lasciare i sistemi IA vulnerabili a attacchi informatici più potenti o frequenti.

- Rischio di attacchi dannosi o avversari a dati e algoritmi di IA: i malintenzionati possono ottenere l'accesso non autorizzato a strumenti e dati di IA, manipolare dati e algoritmi di IA per inserire lacune o pregiudizi, mettere a rischio la capacità dei modelli di IA di fare previsioni accurate o difendersi da attacchi futuri e manipolare, usare in modo improprio o rubare modelli e algoritmi di IA.

- Rischio di avvelenamento, corruzione e manipolazione dei dati: i cyber criminali possono corrompere le pipeline di machine learning (ML) o i modelli di avvelenamento IA modificando deliberatamente i dati di input o inserendo nuovi dati per compromettere gli strumenti e i sistemi di IA.

- Rischi per i modelli di addestramento dell’IA: i cyber criminali possono rubare, manipolare o invertire i modelli di addestramento dell’IA proprietari. Possono anche corrompere, violare o manomettere i dati utilizzati per sviluppare e addestrare modelli IA per comprometterne l'accuratezza, l'efficacia e l'integrità.

- Rischio di pregiudizi, discriminazione, privacy dei dati e mancanza di trasparenza: gli errori umani e gli attacchi informatici possono aumentare le preoccupazioni e i pregiudizi sulla privacy dei dati nei modelli di IA e potenzialmente compromettere i principi di trasparenza, equità e responsabilità.

- Rischio di non conformità alle normative del settore e del governo: la mancata protezione dei dati sensibili, personali o riservati può comportare pesanti sanzioni e accuse di non conformità da parte sia del governo che delle autorità di regolamentazione del settore, incluso il Regolamento generale sulla protezione dei dati (GDPR).

- Rischio di attacchi a fornitori di terze parti: gli aggressori possono prendere di mira i sistemi di IA in qualsiasi punto della catena di fornitura di un'organizzazione per sfruttare i punti deboli nelle reti, componenti, framework e librerie software di partner di terze parti e quindi utilizzare tali vulnerabilità per prendere di mira altri modelli di IA in qualsiasi altro punto della catena.

- Rischi di deriva e decadimento del modello IA: nel tempo, tutti i modelli IA possono essere vulnerabili a deriva o decadimento. I malintenzionati possono sfruttare modelli di IA degradati o deviati per alterare il loro comportamento o comprometterne la precisione e l'affidabilità.

- Rischio di furto delle credenziali dei chatbot: i cyber criminali possono rubare le credenziali dei chatbot per provider di IA come ChatGPT o acquistare credenziali rubate sul dark web e utilizzarle per ottenere l'accesso illegale a strumenti e sistemi di IA proprietari.

- Rischio di foto, video e audio deepfake: i malintenzionati possono utilizzare immagini e video deepfake generati dall'intelligenza artificiale per frodare organizzazioni, estorcere individui o aziende, indurre i dipendenti a concedere l'accesso a sistemi critici, divulgare informazioni riservate o rubare dati preziosi.

- Rischio di attacchi prompt injection diretti e indiretti: gli attacchi di prompt injection possono utilizzare codice dannoso per ingannare i modelli linguistici di grandi dimensioni (LLM) e altri strumenti di intelligenza artificiale in una fuga di informazioni sensibili, consentendo l'accesso non autorizzato o eliminando i documenti chiave.

- Rischio di abuso di allucinazioni da parte dell'IA: i malintenzionati possono sfruttare le "allucinazioni" comuni dell'IA per compromettere deliberatamente i dati su cui si basano i modelli di IA e le decisioni che prendono.

- Rischi per le risorse e le infrastrutture cloud: i cyber criminali possono accedere a modelli di IA basati su cloud e corrompere o rubare i loro dati e altre risorse.

Se le organizzazioni non si assicurano che le loro misure di sicurezza e cybersecurity dell'IA siano il più solide, complete e aggiornate possibile, i malintenzionati possono sfruttare questi e altri rischi per minare l'efficacia e l'affidabilità dei modelli di IA, rubare dati sensibili o privati e potenzialmente causare danni finanziari e alla reputazione significativi.

Quali sono i vantaggi della sicurezza IA?

Le aziende che implementano misure di sicurezza IA per proteggere i loro stack IA beneficiano di una serie di vantaggi interessanti. Questi includono capacità migliorate di:

- Protezione dei dati IA da compromissione, corruzione, manipolazione, violazione o furto

- Protezione dei modelli IA da attacchi informatici o hacker eseguendo rilevamento e risposta alle minacce in tempo reale, ricerca delle minacce, e strumenti e tecnologie per la scansione delle vulnerabilità

- Protezione delle infrastrutture IA eliminando in modo proattivo le lacune o le vulnerabilità nelle difese informatiche, gestendo e mitigando i rischi informatici e proteggendo le risorse IA

- Protezione degli utenti IA e delle applicazioni locali da attacchi di codice dannoso, accessi illegali o non autorizzati, schemi di frode e phishing e attacchi malware e ransomware

- Controllo dell'accesso ai servizi IA pubblici e privati, comprese le applicazioni LLM (Large Language Model)

- Difesa dagli attacchi zero-day che prendono di mira vulnerabilità software o hardware precedentemente sconosciute per consentire ai malintenzionati di rubare dati, violare informazioni riservate, installare malware e altri virus o ottenere l'accesso all'infrastruttura IT di un'organizzazione

Best practice per la sicurezza IA

Le soluzioni di sicurezza IA più efficaci seguono una serie di best practice standard del settore per proteggere i loro strumenti e risorse IA e migliorare il loro stato di sicurezza. Queste pratiche includono:

- Sviluppo di una strategia di sicurezza IA completa che combina attività di modellazione avanzata delle minacce e di ricerca delle minacce con funzionalità di valutazione del rischio basate sull'IA, controlli di sicurezza IA completi e piani e procedure dettagliati di risposta agli incidenti per proteggere i sistemi e i dati IA di un'organizzazione.

- Garantire la qualità, l'integrità e l'affidabilità dei dati di training IA per affrontare i problemi relativi a trasparenza, pregiudizi e spiegabilità e garantire che i modelli di IA siano il più accurati ed efficaci possibile.

- Implementazione di framework di sicurezza IA standard del settore per stabilire una serie chiara di standard e linee guida per proteggere i sistemi IA, eliminare eventuali lacune o vulnerabilità nelle difese IA e mantenere la conformità a tutte le normative di sicurezza IA pertinenti. Ciò include l'integrazione di framework di sicurezza come il framework di gestione del rischio dell'intelligenza artificiale del National Institute of Standards and Technology (NIST), la matrice MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) e Sensible Regulatory Framework for AI Security, l'elenco Open Worldwide Application Security Project (OWASP) delle prime 10 best practice per le applicazioni con modelli linguistici di grandi dimensioni (LLM), Secure AI Framework (SAIF) di Google, e gli standard ISO/IEC 27001 per i sistemi di gestione della sicurezza delle informazioni (ISMS).

- Integrazione della sicurezza IA con le misure di sicurezza e cybersecurity esistenti per creare una protezione end-to-end dalle minacce informatiche per tutte le applicazioni, gli strumenti, i sistemi e le reti IA e IT.

- Svolgere regolarmente programmi di formazione e sensibilizzazione dei dipendenti per aumentare la consapevolezza delle ultime minacce e misure di sicurezza sia tra i team di cybersecurity che tra gli altri dipendenti e promuovere una cultura aziendale basata sul miglioramento continuo.

- Monitoraggio, valutazione e aggiornamento continui dei modelli di IA per individuare e mitigare le vulnerabilità negli strumenti e nei sistemi di IA, identificare le minacce emergenti quando e quando si presentano e perfezionare costantemente i modelli e le applicazioni di IA per migliorarne l'accuratezza, le prestazioni e l'affidabilità.

Esempi di applicazioni di cybersecurity IA

Man mano che gli strumenti di intelligenza artificiale diventano più avanzati, i potenziali usi e le applicazioni per l'IA nella cybersecurity si stanno espandendo quasi ogni giorno.

Tra gli altri vantaggi, le applicazioni di cybersecurity basate sull'intelligenza artificiale possono migliorare significativamente la portata e l'efficacia delle difese di cybersecurity di un'organizzazione automatizzando le attività di rilevamento delle minacce e di risposta agli incidenti, eseguendo scansioni delle vulnerabilità e altre misure proattive su base regolare o continua e utilizzando le più recenti informazioni sulle minacce e analisi della sicurezza per prevedere, prevenire e proteggere le organizzazioni dalle minacce informatiche nuove ed emergenti.

Alcune delle applicazioni più efficaci e ampiamente adottate della cybersecurity IA includono l'uso dell'intelligenza artificiale nella protezione dei dati, nella sicurezza degli endpoint, nella sicurezza del cloud, nella ricerca avanzata delle minacce, nel rilevamento delle frodi e nella gestione di identità e accesso (IAM).

Protezione dei dati

Le organizzazioni possono utilizzare l'IA per classificare e crittografare le proprie informazioni riservate o sensibili, monitorare l'accesso ai sistemi per rilevare le violazioni dei dati in modo più rapido e accurato, proteggere i dati IA da perdite o corruzione e proteggere il loro stack IA da accessi, utilizzi o divulgazioni non autorizzati. Tuttavia, i punti ciechi delle informazioni sensibili negli ambienti IA possono portare a gravi violazioni dei dati e problemi di conformità, rendendo fondamentale identificare e mitigare tali vulnerabilità in modo proattivo.

Endpoint security

Le soluzioni di rilevamento e risposta degli endpoint (EDR) abilitate per l'intelligenza artificiale possono aiutare a proteggere laptop, desktop, server informatici, dispositivi mobili e altri endpoint di rete in tempo reale rilevando e bloccando in modo proattivo malware, ransomware e altri attacchi informatici prima che si verifichino.

Sicurezza del cloud

Le tecnologie di sicurezza cloud basate sull'intelligenza artificiale possono monitorare e controllare l'accesso agli ambienti cloud 24 ore su 24, identificare eventuali anomalie o attività sospette, avvisare i team di sicurezza di potenziali minacce man mano che si verificano e proteggere i dati e le applicazioni basati su cloud da accessi non autorizzati e violazioni dei dati.

Rilevazione delle minacce avanzate

Gli strumenti avanzati di ricerca delle minacce IA possono analizzare rapidamente e facilmente i log, gli schemi del traffico di rete e le attività e i comportamenti degli utenti per cercare attacchi dannosi, catturare i cyber criminali prima che possano causare danni duraturi e salvaguardare i sistemi e l'infrastruttura IA dalle minacce persistenti avanzate (APT) e da altri attacchi informatici.

Rilevamento delle frodi

Le organizzazioni del settore bancario e dei servizi finanziari possono utilizzare algoritmi di machine learning (ML), reti neurali e altre tecnologie IA avanzate per rilevare attività potenzialmente fraudolente, bloccare l'accesso non autorizzato a conti bancari o altri conti online e prevenire il furto di identità nelle transazioni finanziarie ed e-commerce.

Gestione delle identità e degli accessi (IAM)

Le soluzioni IAM (Identity and Access Management) abilitate per l'intelligenza artificiale possono aiutare le organizzazioni a monitorare e proteggere ogni fase dei processi di autenticazione, autorizzazione e gestione degli accessi per assicurarsi di seguire tutte le politiche e i playbook aziendali di IA, mantenere la conformità alle normative del settore, prevenire l'accesso non autorizzato ai dati sensibili e tenere gli hacker lontani dai loro sistemi.

Dove posso ottenere aiuto con la sicurezza dell'IA?

Trend Vision One™ è una piattaforma multifunzione di cybersecurity basata sull'intelligenza artificiale.

Trend Vision One offre un potente set di strumenti e tecnologie IA leader nel settore, in grado di rilevare, prevedere e prevenire le minacce informatiche in modo molto più rapido ed efficace rispetto ai tradizionali team di sicurezza guidati da persone. Raggiungere una sicurezza efficace dello stack IA richiede la protezione di ogni livello, dai dati all'infrastruttura e agli utenti, garantendo la visibilità delle distribuzioni IA shadow, applicando rigorosi controlli di accesso per la conformità e stabilendo guardrail per le API IA per prevenire l'uso improprio e l'avvelenamento dei modelli. Queste funzionalità consentono alle organizzazioni di proteggere l'intero stack IA e i dati, le applicazioni e i sistemi IA dalla stragrande maggioranza degli attacchi informatici prima che si verifichino.

Trend Vision One include anche le ineguagliabili funzionalità basate sull'intelligenza artificiale di Trend Cybertron: la prima intelligenza artificiale di cybersecurity realmente proattiva al mondo. Attingendo alla comprovata raccolta di modelli linguistici di grandi dimensioni (LLM), set di dati, agenti IA avanzati e oltre 20 anni di investimenti nel campo della sicurezza IA di Trend Micro, Trend Cybertron è in grado di analizzare schemi e dati storici per prevedere gli attacchi specifici per ciascun cliente, consentire alle organizzazioni di raggiungere tempi di ripristino più rapidi del 99% rispetto alla risposta agli incidenti tradizionale e trasformare le operazioni di sicurezza di un'organizzazione da reattive a proattive praticamente durante la notte.

Trend Cybertron è stato inoltre progettato per evolversi continuamente e adattarsi per tenere il passo con i cambiamenti nelle esigenze di un'organizzazione e rimanere aggiornato sulle ultime tattiche, tecniche e procedure (TTP) impiegate dai cyber criminali. Ciò consente alle organizzazioni di assicurarsi che sia la sicurezza IA che le difese di cybersecurity IA siano sempre il più solide, complete e aggiornate possibile.

Michael Habibi è un leader della cybersecurity con oltre 12 anni di esperienza, specializzato nello sviluppo dei prodotti e nell'innovazione strategica. In qualità di Vice President of Product Management di Trend Micro, Michael guida l'allineamento della strategia del prodotto endpoint con il panorama delle minacce in rapida evoluzione.

Domande frequenti (FAQ)

Che cos'è la sicurezza IA?

Security for AI (o "sicurezza IA") è l'uso di diversi strumenti, pratiche e tecnologie per proteggere lo stack IA di un'organizzazione.

Qual è lo scopo dell'IA nella sicurezza?

L'IA si riferisce all'"intelligenza artificiale". L'IA viene utilizzata nella sicurezza per migliorare le difese di cybersecurity di un'organizzazione e proteggere gli stack IA.

Come si può usare l'IA nella sicurezza?

L'IA può essere utilizzata per proteggere reti, modelli, sistemi, endpoint e applicazioni IA da attacchi informatici, corruzione dei dati e altre minacce.

Che cos'è l'IA nella cybersecurity?

L'IA nella cybersecurity si riferisce all'uso di strumenti e tecnologie IA per aiutare a proteggere le organizzazioni dagli attacchi informatici.

L'IA è un rischio per la sicurezza?

Come qualsiasi tecnologia, l'IA può essere utilizzata per migliorare le misure di sicurezza o lanciare attacchi informatici più potenti.

La sicurezza IA è una buona carriera?

La sicurezza IA è un campo in crescita che offre numerose opportunità di carriera impegnative e ben retribuite.

Quanto guadagnano i responsabili della sicurezza IA?

A seconda della loro esperienza e della loro posizione, i responsabili della sicurezza IA possono guadagnare da 60.000 a oltre 120.000 dollari all'anno.

Come posso accedere alla sicurezza IA?

I corsi di formazione online, le lauree in informatica o cybersecurity e le certificazioni di sicurezza IA sono tutti buoni punti di partenza per una carriera nella sicurezza IA.

Qual è la differenza tra cybersecurity IA e sicurezza IA?

La cybersecurity si riferisce a strumenti o sistemi che proteggono le organizzazioni dagli attacchi informatici. La sicurezza IA consiste nella salvaguardia dello stack IA di un'organizzazione.

L'IA può fare cybersecurity?

Sotto la supervisione umana, le tecnologie IA possono migliorare notevolmente la velocità, la precisione e l'efficacia di quasi tutti gli aspetti della cybersecurity.

Qual è la differenza tra cybersecurity tradizionale e cybersecurity IA?

Anche se i loro obiettivi e metodi sono gli stessi, la cybersecurity IA può fornire una protezione più rapida, accurata e proattiva rispetto alla cybersecurity tradizionale.

La cybersecurity richiede lo sviluppo di codice?

Anche se la codifica può essere una competenza preziosa per molti lavori di cybersecurity, ci sono numerose posizioni nella cybersecurity che non richiedono alcuna esperienza o competenza di codifica.

Perché l'IA è una minaccia per la sicurezza?

L'IA può essere utilizzata dai malintenzionati per violare i sistemi IT, rubare dati riservati, corrompere gli stack IA o lanciare sofisticati attacchi informatici.

Qual è un esempio di violazione dei dati IA?

I deepfake basati sull'intelligenza artificiale sono stati utilizzati per simulare le voci o le immagini video di persone reali, convincendo i dipendenti delle organizzazioni a condividere informazioni riservate che avrebbero dovuto essere mantenute private.

L'app di sicurezza IA è sicura?

In definitiva, la sicurezza di un'app di sicurezza dipende dall'affidabilità del suo sviluppatore, non dal suo prezzo. Attieniti ai principali marchi testati in modo indipendente ed evita le app provenienti da fonti sconosciute.

Quali sono i rischi della sicurezza con l'IA?

Alcuni rischi comuni associati alla sicurezza IA includono superfici di attacco estese, avvelenamento e corruzione dei dati e rischi per i dati, gli algoritmi e i modelli di addestramento dell'IA.

Il mio sistema IA è ad alto rischio?

Le organizzazioni possono ridurre i rischi per i sistemi IA analizzando le loro difese attuali, seguendo le best practice del settore e implementando strategie complete di sicurezza e cybersecurity IA.

Devo fidarmi di un rilevatore IA?

Anche se i rilevatori IA possono essere strumenti efficaci, possono anche commettere errori. Pertanto, i loro risultati devono essere utilizzati solo come segnale preliminare per sollecitare ulteriori indagini, che devono basarsi sul giudizio umano.

Come fare attenzione all'IA?

Un approccio veramente attento all'IA richiede diverse azioni da parte di utenti e creatori. Che tu lo stia utilizzando o costruendo, la regola fondamentale è quella di trattare l'IA come uno strumento potente ma imperfetto, non come un esperto infallibile o un fiduciario sicuro.

Come posso proteggere l'IA?

Una strategia di sicurezza completa per lo stack IA non lascia lacune, applicando la protezione su ogni componente, dagli utenti e dai dati che generano ai modelli, ai microservizi e all'infrastruttura sottostante.

Articoli correlati

I 10 principali rischi e mitigazioni per LLM e app IA generative per il 2025

Gestione dei rischi emergenti per la pubblica sicurezza

Quanto possono portarci lontano gli standard internazionali?

Come scrivere una politica di cybersecurity per l'intelligenza artificiale generativa

Attacchi dannosi potenziati dall'intelligenza artificiale tra i principali rischi

Minaccia crescente delle identità Deepfake