Le politiche aziendali sull'IA sono l'insieme di regole operative di gestione relative al corretto utilizzo della tecnologia IA. Aiutano a rispettare la conformità, garantire la privacy dei dati e mantenere la sicurezza digitale.

Sommario

Modello di politica aziendale sull'IA

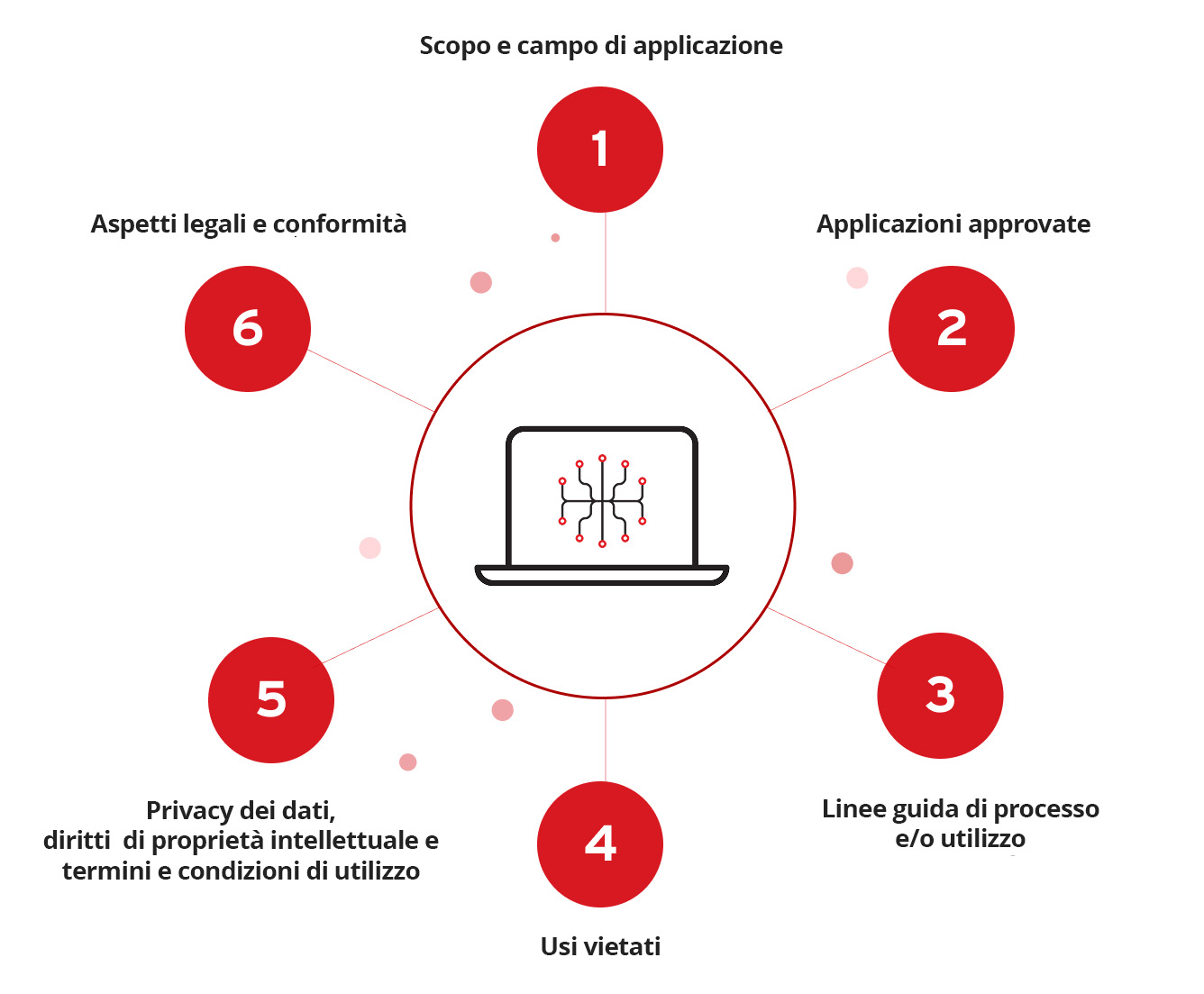

Affinché una politica educhi efficacemente sulle migliori pratiche e mitighi il rischio, deve concentrarsi su diverse aree chiave. Tra queste troviamo:

Scopo e campo di applicazione

Questa sezione di apertura ha lo scopo di chiarire l'intenzione della politica aziendale sull'IA. Dovrebbe anche specificare chi deve aderire ai suoi requisiti, come individui o agenzie esterne sotto contratto oltre ai dipendenti regolari.

Applicazioni approvate

Qui dovrebbero essere elencate le sole applicazioni relative all'IA il cui uso è approvato. Qui possono anche essere specificate le procedure di accesso corrette per ciascuna applicazione al fine di garantire la conformità, anche se i dettagli sensibili come le credenziali di accesso dovrebbero essere omessi. Queste possono invece essere fornite dalla direzione in modo sicuro su richiesta della persona che richiede l'accesso e/o durante il processo di onboarding.

Linee guida di processo e/o utilizzo

Riassume il processo corretto per l'utilizzo dell'IA, ad esempio attraverso un elenco puntato, per aiutare gli utenti a comprendere i passaggi appropriati e a rispettarli. Questa è un'opportunità per implementare guardrail operativi e comunicare come dovrebbero essere gestiti le autorizzazioni, le comunicazioni interne, la garanzia della qualità dei contenuti generati dall'IA e l'accesso complessivo ai dati e agli strumenti concessi ai sistemi di IA. Inoltre, può essere utile specificare cosa fare se/quando si sospetta un rischio o una vulnerabilità correlata a quanto sopra.

Usi vietati

Questa sezione dovrebbe chiarire quando, dove e come le applicazioni di IA approvate non devono essere utilizzate. Qui, se esistenti, dovrebbero essere incluse anche specifiche eccezioni ragionevoli. Come per il resto della politica, la terminologia scelta deve essere chiara, concisa e facile da seguire, riducendo al minimo il rischio di interpretazioni errate o confusione.

Privacy dei dati, diritti di proprietà intellettuale e termini e condizioni di utilizzo

Questa sezione ricorda agli utenti di esaminare i termini e le condizioni degli strumenti di IA a cui sono autorizzati ad accedere, contribuendo a proteggere da abusi e/o problemi relativi alla responsabilità. Dovrebbe inoltre concentrarsi sull'importanza di mantenere la privacy dei dati ed evitare il plagio, rispettare i diritti di proprietà intellettuale e i loro titolari e non dare agli strumenti in questione l'accesso a informazioni riservate.

Aspetti legali e conformità

Qui vanno specificati gli organi direttivi e i regolamenti rispetto ai quali l'organizzazione, e per estensione il team, deve mantenere la conformità nell'utilizzo dell'IA. Questi dovrebbero includere gli atti legislativi approvati ed eventuali requisiti per il tuo team legale, di sicurezza e/o IT.

Esempi di politica aziendale sull'IA

La strategia di IA pan-canadese

Divisa in più priorità strategiche ma unificata nella sua missione, la strategia di IA pan-canadese ha come obiettivo "portare benefici sociali, economici e ambientali positivi per le persone e il pianeta".

Pratiche Microsoft relative all'IA responsabile

Si tratta di una raccolta di documentazione relativa a ricerche, politiche e ingegneria incentrata sull’avanzamento dell'IA in modo etico e responsabile. A maggio 2024, Microsoft ha anche pubblicato il suo Responsible AI Transparency Report, che copre tutti gli aspetti, dalla mappatura, alla misurazione e gestione dei rischi dell'IA, alla creazione di modelli di IA di frontiera sicuri e responsabili.

Standard sull'IA e contributi sulle politiche National Institute of Standards and Technology (NIST)

Il NIST ha lavorato a stretto contatto con le principali parti interessate del settore pubblico e privato e con le agenzie federali per sviluppare nuovi standard per l'IA. Il NIST è "fortemente impegnato negli sforzi statunitensi e internazionali in materia di politiche sull'IA come l'US-EU Trade and Technology Council, l'OECD, il Consiglio d'Europa, il Dialogo quadrilaterale sulla sicurezza" e diverse altre iniziative. Il NIST sta inoltre collaborando con l'Amministrazione del commercio internazionale del Dipartimento del Commercio degli Stati Uniti e il Dipartimento di Stato degli Stati Uniti nell'ambito di questi sforzi.

Nel luglio 2024, il NIST ha anche pubblicato quattro pubblicazioni che "intendono contribuire a migliorare la sicurezza e l'affidabilità dei sistemi di IA". Tra cui:

- Generative AI

- Software sicuro

- Standard IA

- Bozza pubblica iniziale del report Managing Misuse Risk for Dual-Use Foundation Models

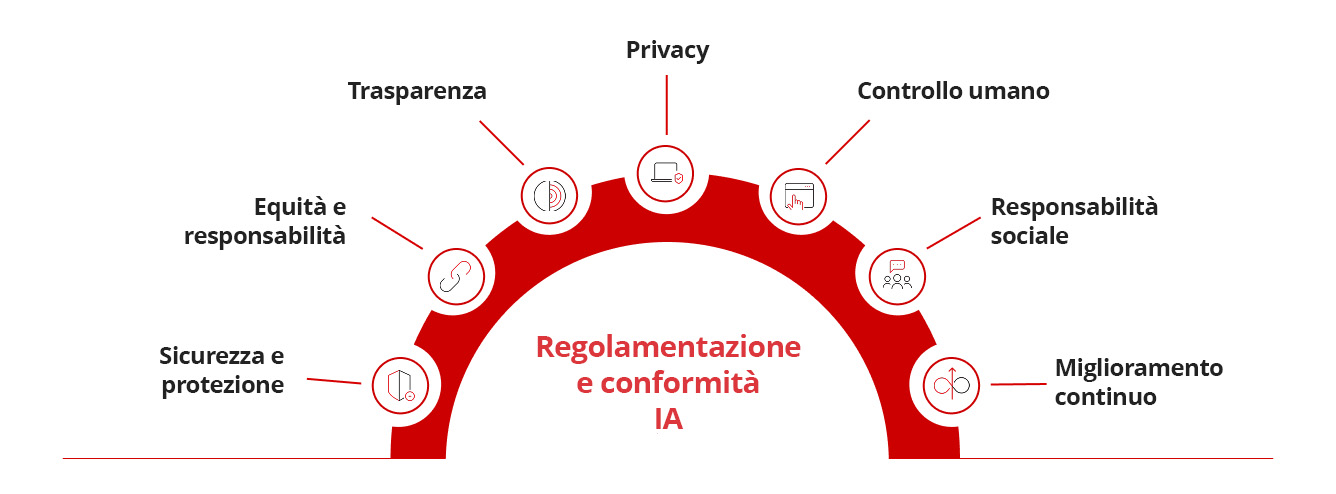

Regolamentazione e conformità dell'IA

Definizione dell'etica dell'IA

L'etica dell'IA implica principi e linee guida che regolano lo sviluppo, l'implementazione e l'uso responsabili dei sistemi di IA. Affronta questioni come l'allineamento, l'equità, la responsabilità, la trasparenza, la privacy, il rischio e l'impatto sociale delle tecnologie di IA.

Raccomandazioni degli esperti sulla regolamentazione dell'IA di frontiera

Un report pubblicato sui OpenAI (arXiv:2307.03718: Frontier AI Regulation: Managing Emerging Risks to Public Safety) evidenzia diverse sfide associate alla regolamentazione dei modelli di IA di frontiera per garantire la salvaguardia degli utenti. Afferma che "i modelli di IA di frontiera rappresentano una sfida normativa unica: le capacità pericolose possono sorgere inaspettatamente. È difficile impedire in modo robusto che un modello implementato venga utilizzato in modo improprio ed è difficile impedire che le capacità di un modello proliferino ampiamente".

Inoltre, il riepilogo del report rileva che ci sono "almeno tre elementi costitutivi" necessari per la regolamentazione:

- "Processi di definizione degli standard per identificare i requisiti appropriati per gli sviluppatori di IA di frontiera"

- "Requisiti di registrazione e rendicontazione per fornire alle autorità di regolamentazione visibilità sui processi di sviluppo dell'IA di frontiera"

- "Meccanismi per garantire la conformità agli standard di sicurezza per lo sviluppo e l'implementazione di modelli di IA di frontiera"

Chi può aiutarci a gestire le nostre politiche aziendali in materia di IA?

Le organizzazioni possono sviluppare policy IA efficaci attraverso due approcci complementari: l'utilizzo dei loro team di sicurezza interni o la collaborazione con società di consulenza specializzate e la conduzione di valutazioni di Red Teaming. Mentre i team o i consulenti interni si concentrano sulla definizione e sull'implementazione delle politiche di base, il Red Teaming fornisce informazioni critiche identificando le vulnerabilità e i potenziali rischi, garantendo che le politiche siano solide e complete.

Le società di consulenza mettono a disposizione competenze in materia di governance dell'intelligenza artificiale, conformità normativa e best practice, aiutando le organizzazioni a creare politiche che affrontano aree chiave come la privacy dei dati, la protezione della proprietà intellettuale e la mitigazione del rischio, allineandosi con gli standard del settore. Il Red Teaming completa tutto questo scoprendo le vulnerabilità del sistema, simulando minacce reali come attacchi avversari, avvelenamento dei dati o furto di modelli e fornendo informazioni utili per perfezionare e rafforzare i framework delle policy. Queste valutazioni testano anche l'efficacia delle policy esistenti, rivelano potenziali scenari di uso improprio come distribuzioni IA shadow o accesso non autorizzato e identificano pregiudizi o problemi etici nei sistemi IA. Integrando le informazioni provenienti sia dalla consulenza strategica che dalle valutazioni delle vulnerabilità, le organizzazioni possono stabilire policy di IA sicure, eque e adattabili, soddisfacendo al contempo le loro esigenze operative e strategiche specifiche.

Domande frequenti (FAQ)

Quali sono le politiche IA?

Le politiche IA sono linee guida aziendali per un uso etico, trasparente e conforme dell’intelligenza artificiale.

Cosa deve includere una politica IA aziendale?

Deve includere principi etici, requisiti di conformità, protezione dati, responsabilità, trasparenza e strategie di gestione del rischio.

Le aziende hanno bisogno di una politica IA?

Sì, per garantire uso responsabile, conformità normativa, riduzione dei rischi e fiducia di clienti e partner.

Qual è la regola del 30% per l’IA?

Limita automazione IA al 30% delle attività, mantenendo supervisione umana e decisioni equilibrate.

Quali sono i 7 principi dell’AI Act?

Trasparenza, equità, responsabilità, sicurezza, privacy, supervisione umana e robustezza per un’IA affidabile.

Come creare una politica IA?

Definire obiettivi, valutare rischi, stabilire standard etici, garantire conformità, coinvolgere stakeholder e implementare monitoraggio.

Articoli correlati

I 10 principali rischi e mitigazioni per LLM e app IA generative per il 2025

Gestione dei rischi emergenti per la pubblica sicurezza

Quanto possono portarci lontano gli standard internazionali?

Come scrivere una politica di cybersecurity per l'intelligenza artificiale generativa

Attacchi dannosi potenziati dall'intelligenza artificiale tra i principali rischi

Minaccia crescente delle identità Deepfake