I rischi per la sicurezza dell'IA sono conseguenti all'implementazione e/o all'uso della tecnologia IA. Tali rischi includono cyberattack dannosi avviati da malintenzionati e vulnerabilità derivanti dal comportamento della piattaforma e/o dell'utente.

Sommario

Vulnerabilità di sicurezza dell'IA

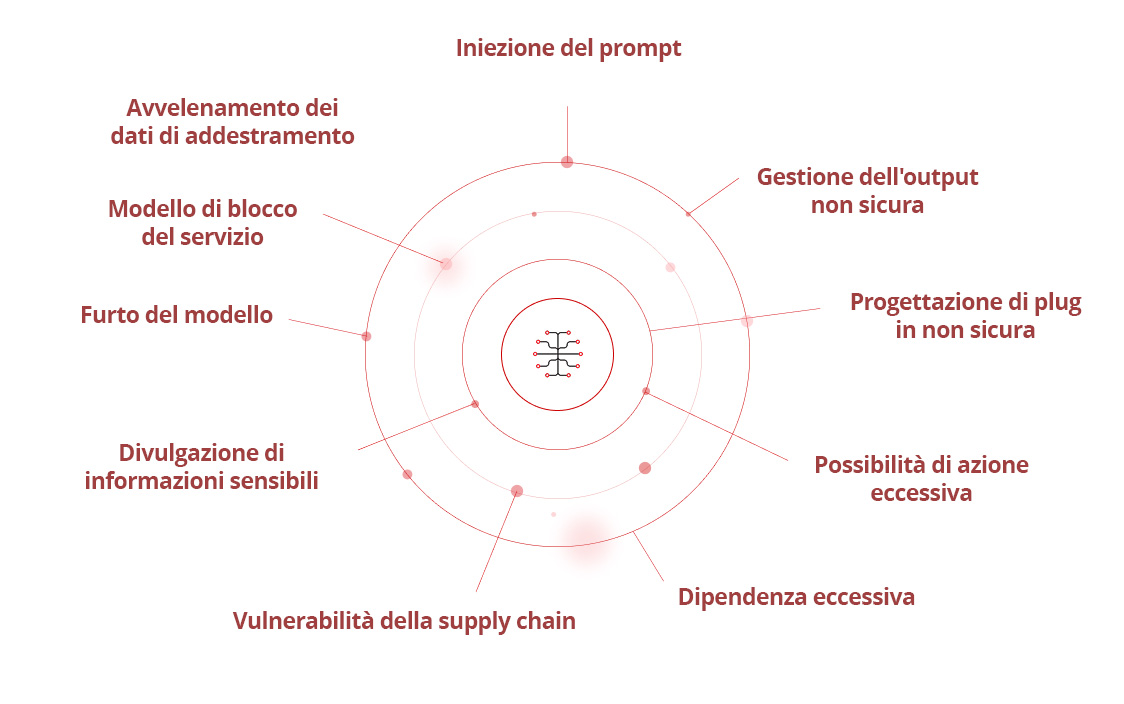

L'Open Worldwide Application Security Project (OWASP) ha identificato una serie di vulnerabilità relative all'IA relative a Learning Language Model (LLM). Tra queste troviamo:

- Iniezione del prompt

- Gestione dell'output non sicura

- Avvelenamento dei dati di addestramento

- Modello di blocco del servizio

- Vulnerabilità della supply chain

- Divulgazione di informazioni sensibili

- Progettazione di plug in non sicura

- Possibilità di azione eccessiva

- Dipendenza eccessiva

- Furto del modello

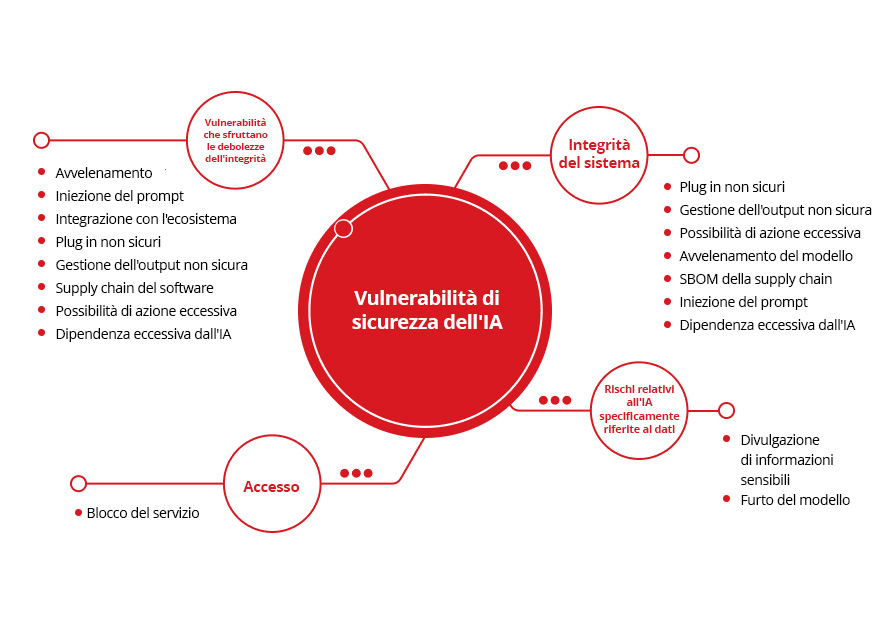

Queste vulnerabilità possono essere ulteriormente condensate e semplificate nelle seguenti categorie principali:

Rischi relativi all'IA specificamente

riferite ai dati

Integrità del sistema

Accesso

Vulnerabilità che sfruttano le debolezze dell'integrità

Divulgazione di informazioni sensibili

Furto del modello

Plug in non sicuri

Gestione dell'output non sicura

Possibilità di azione eccessiva

Avvelenamento del modello

SBOM della supply chain

Iniezione del prompt

Dipendenza eccessiva dall'IA

- Blocco del servizio

Avvelenamento del modello

Iniezione del prompt

Integrazione con l'ecosistema

Plug in non sicuri

Gestione dell'output non sicura

Supply chain del software

Possibilità di azione eccessiva

Dipendenza eccessiva dall'IA

Essendo in gran parte dipendente dai dati disponibili e dall'input dell'utente, l'IA è sempre più presa di mira dai malintenzionati che mirano a violare le difese digitali e sottrarre informazioni sensibili. In un recente sondaggio Gartner®, sono stati rivelati i cinque rischi emergenti più citati nel primo trimestre del 2024. I rischi legati all'IA occupano i primi due posti sotto forma di attacchi maligni potenziati dall'IA e di disinformazione assistita dall'IA. Come osserva Gartner, il miglioramento dell'IA può "facilitare le attività di phishing e di ingegneria sociale, che consentono una migliore intrusione, una maggiore credibilità e attacchi più dannosi".

Rogue IA

Il termine Rogue IA indica un comportamento dell'IA disallineato rispetto all'obiettivo dell'utente. Questo disallineamento può essere accidentale, ad esempio a causa di un malfunzionamento di guardrail opportuni. Può però anche essere intenzionale, nel qual caso i malintenzionati possono cercare di sovvertire il sistema o l'uso dell'IA per un obiettivo, oppure possono tentare di installare modelli di IA allineati a obiettivi illeciti all'interno di un ambiente.

Automazione delle frodi

L'automazione delle frodi consiste nella creazione di contenuti sintetici di testo, audio e/o video che compromettono i processi aziendali tramite phishing, Business Email Compromise (BEC), video o audio deepfake. L'automazione delle frodi può essere facilmente scalata con l'IA.

Governance dei dati

I sistemi di IA dipendono dai dati. Pertanto, i dati utilizzati nei sistemi di IA e i dati in tempo reale che gestiscono devono essere conformi a tutte le normative sulla privacy e sull'uso corretto. Da qui la necessità di una governance dei dati proattiva ed efficace che contribuisca a ridurre al minimo il rischio.

Rischi per la sicurezza del Large Language Model (LLM)

Gli LLM affrontano vulnerabilità critiche, tra cui la prompt injection che manipola il comportamento del modello, la divulgazione di informazioni sensibili che espongono dati riservati e la gestione impropria dell'output che consente gli attacchi ai sistemi a valle. Altri rischi principali includono le vulnerabilità della catena di approvvigionamento causate da dipendenze di terze parti, l'eccessiva concessione di autorizzazioni non necessarie da parte dell'agenzia, l'avvelenamento dei dati che compromette l'integrità del modello e la diffusione di prompt di sistema che espone le istruzioni riservate. Inoltre, i punti deboli dell'integrazione dei vettori, la generazione di disinformazione e gli attacchi al consumo non limitati minacciano la sicurezza, l'affidabilità e la disponibilità delle applicazioni LLM.

Rischi relativi alla sicurezza dell'IA generativa che coinvolgono i prompt degli utenti

L'IA generativa (GenAI) utilizza i dati passati e presenti disponibili per assistere gli utenti. Pertanto, per gli strumenti che richiedono l'inserimento di prompt, è meglio essere consapevoli e proattivi su ciò che si inserisce nel relativo campo. Alcuni strumenti consentono agli utenti di disattivare la raccolta dei dati, come l'opzione di ChatGPT per disattivare la cronologia delle chat. A seconda della governance dell'IA e delle politiche di utilizzo applicate dal regolatore del settore in questione, misure preventive e/o comportamenti come questi possono essere un requisito per mantenere la conformità.

L'inserimento di informazioni finanziarie, specifiche riservate su software ancora da rilasciare, informazioni di identificazione personale (PII) come indirizzi personali e dettagli di contatto e/o altri dati sensibili significa che le informazioni sono liberamente accessibili dall'applicazione IA. Questi dati rischiano di essere manipolati, condivisi con altri nelle raccomandazioni dello strumento in risposta a domande simili e/o sottratti da malintenzionati in caso di violazione delle misure di protezione dell'IA. Ciò è particolarmente rischioso quando si utilizzano strumenti di IA generativa per assistere nell'ideazione o compilare rapidamente grandi quantità di dati, soprattutto se non sono in atto misure di crittografia e sicurezza adeguate.

Rischi relativi alla sicurezza di ChatGPT

Come forma di IA generativa che fornisce risposte testuali ai prompt degli utenti, ChatGPT può essere manipolato dai malintenzionati per aiutare a mascherare e/o rafforzare i loro tentativi di phishing. In alternativa, la piattaforma stessa può essere utilizzata per ottenere l'accesso e potenzialmente l'uso improprio dei dati degli utenti. Ciò può includere la stesura di email di phishing sfruttando sample di scrittura dell'organizzazione o dell'individuo presi di mira, nonché la correzione di errori di battitura, grammatica e linguaggio al fine di ottenere un messaggio che appaia più convincente. Esiste anche il rischio di furto e/o violazione dei dati degli utenti tramite iniezione del prompt o jailbreak.

Ci sono anche rischi per la sicurezza derivanti dall'uso che non coinvolgono direttamente i malintenzionati. Ad esempio, le informazioni che ChatGTP riceve da un utente possono essere sfruttate per addestrare dei LLM. C'è anche il rischio dell'utilizzo di una crittografia dei dati insufficiente, come dimostra l'app ChatGPT MacOS inizialmente lanciata con le chat degli utenti memorizzate come testo in chiaro.

Rischi relativi alla sicurezza di OpenAI

L'API OpenAI stessa ha il potenziale per essere presa di mira dai criminali informatici. Sebbene sia conforme a SOC 2 e sia sottoposto a regolari test di penetrazione, il rischio non è mai completamente assente poiché le minacce cyber sono in continua evoluzione. Un recente articolo di Soft Kraft esplora in dettaglio i rischi per la sicurezza dei dati di OpenAI, rivelandone cinque di particolare interesse per gli utenti aziendali:

- I dati delle conversazioni ChatGPT potrebbero essere utilizzati per scopi di riaddestramento del modello

- I dati inviati tramite l'API potrebbero essere esposti internamente ed esternamente

- Potrebbe essere una sfida garantire la conformità al Regolamento generale sulla protezione dei dati (GDPR)

- L'uso di sub-processori di terze parti complica la localizzazione e la gestione dei dati

Rischi relativi alla sicurezza di Microsoft Copilot AI

Con il supporto per le applicazioni Microsoft 365, Microsoft Copilot AI è prontamente disponibile per gli utenti. Inoltre, a livello hardware, gli ultimi PC con marchio Copilot+ vengono forniti con chiavi Copilot fisiche dedicate per incoraggiare un input dell'utente ancora più rapido. Queste misure di accesso semplificate possono introdurre rischi per la sicurezza se le informazioni sensibili vengono rese disponibili a Copilot, proprio come accade con altri strumenti di IA generativa. Se le autorizzazioni non vengono impostate correttamente o se i documenti generati dall'intelligenza artificiale non presentano le impostazioni di privacy appropriate abilitate, ci si potrebbe anche trovare di fronte a perdite e/o violazioni di dati riservati. Lo stesso vale per la gestione degli accessi degli utenti. Infine, gli attacchi alla piattaforma stessa potrebbero consentire ai malintenzionati di modificare il modo in cui questa accede e condivide i tuoi dati.

Chi può aiutarci a gestire i rischi per la sicurezza dell'IA?

La continua evoluzione dell'innovazione dell'IA richiede una sicurezza proattiva e supportata da 35 anni di threat intelligence leader del settore, 20 anni di sviluppo pionieristico dell'IA e una protezione dalle vulnerabilità senza pari, ovvero Trend Vision One™ AI Security.

Con la nostra soluzione AI Security, proteggiamo i carichi di lavoro aziendali critici, compreso l'intero stack IA, migliorando al contempo il tuo stato di sicurezza complessivo. Basata su Trend Cybertron, la nostra AI Security prevede i percorsi di attacco e rileva le anomalie difendendosi al contempo da deepfake e attacchi generati dall'IA per eliminare i punti ciechi della sicurezza e trasformare la sicurezza IA in un catalizzatore per l'innovazione.

Domande frequenti (FAQ)

Quali sono i rischi di sicurezza dell’IA?

I rischi includono violazioni dati, attacchi, manipolazione modelli, problemi privacy e uso improprio in cybercriminalità.

Chi è il vero padre dell’IA?

John McCarthy è considerato il padre dell’IA per aver coniato il termine e avviato la ricerca.

Quali sono le 4 categorie di rischio dell’AI Act?

L’AI Act definisce quattro categorie: rischio inaccettabile, alto rischio, rischio limitato e rischio minimo per sistemi IA.

Qual è la regola del 30% per l’IA?

La regola del 30% limita automazione IA al 30% delle attività, garantendo supervisione umana e responsabilità.

Come l’IA influisce sulla sicurezza?

L’IA migliora la sicurezza informatica ma introduce vulnerabilità come deepfake, attacchi automatizzati e abuso dei dati.

Il mio sistema IA è ad alto rischio?

È ad alto rischio se influisce su sicurezza, diritti fondamentali, infrastrutture critiche o dati sensibili.

Articoli correlati

I 10 principali rischi e mitigazioni per LLM e app IA generative per il 2025

Gestione dei rischi emergenti per la pubblica sicurezza

Quanto possono portarci lontano gli standard internazionali?

Come scrivere una politica di cybersecurity per l'intelligenza artificiale generativa

Attacchi dannosi potenziati dall'intelligenza artificiale tra i principali rischi

Minaccia crescente delle identità Deepfake