La seguridad de la IA abarca tanto la protección de las tecnologías de IA como su uso para fortalecer la ciberseguridad, mejorando la detección de vulnerabilidades y la respuesta proactiva ante amenazas.

Índice

AI Security

El término “inteligencia artificial” (IA) se acuñó por primera vez en la década de 1950 para describir ordenadores y máquinas que imitan la estructura y la función del cerebro humano para llevar a cabo tareas complicadas, resolver problemas complejos, predecir resultados futuros y aprender de la experiencia.

La seguridad de IA (también llamada seguridad de inteligencia artificial o “seguridad para IA”) es una rama de ciberseguridad que abarca todos los procesos, prácticas y medidas que las organizaciones utilizan para proteger sus pilas de IA y proteger sus sistemas de inteligencia artificial, datos y aplicaciones frente a posibles amenazas. Esto incluye el uso de herramientas y tecnologías impulsadas por IA para:

- Proteja todos los aspectos de la red de IA de una organización desde los endpoints hasta los modelos de IA

- Proteja modelos, sistemas y aplicaciones de IA de una amplia gama de ciberamenazas, cibercriminales y ciberataques

- Identifique y mitigue cualquier brecha o vulnerabilidad en la seguridad de IA y las defensas de ciberseguridad antes de que se puedan aprovechar

- Proteja la infraestructura de IA y los datos de formación para evitar la corrupción, el envenenamiento o el robo de datos de los modelos de IA

- Garantice la calidad e integridad de los datos de los modelos de lenguaje grande (LLM) de IA, motores de IA generativa (GenAI) y tuberías de deep learning y machine learning (ML)

- Abordar posibles problemas e inquietudes éticas en torno a cuestiones de sesgo, transparencia, privacidad de datos y explicabilidad

- Asegúrese de que todo el uso, los datos y el desarrollo de la IA cumplen plenamente con las leyes, las políticas de la empresa y las normativas del sector pertinentes

AI security VS AI Cybersecurity

Aunque los dos términos suenan casi idénticos, existe una diferencia esencial entre la seguridad de la IA y la ciberseguridad de la IA.

La seguridad de la IA consiste en proteger la propia IA, protegiendo la pila de IA de una organización y protegiendo sus sistemas, componentes, redes y aplicaciones de IA.

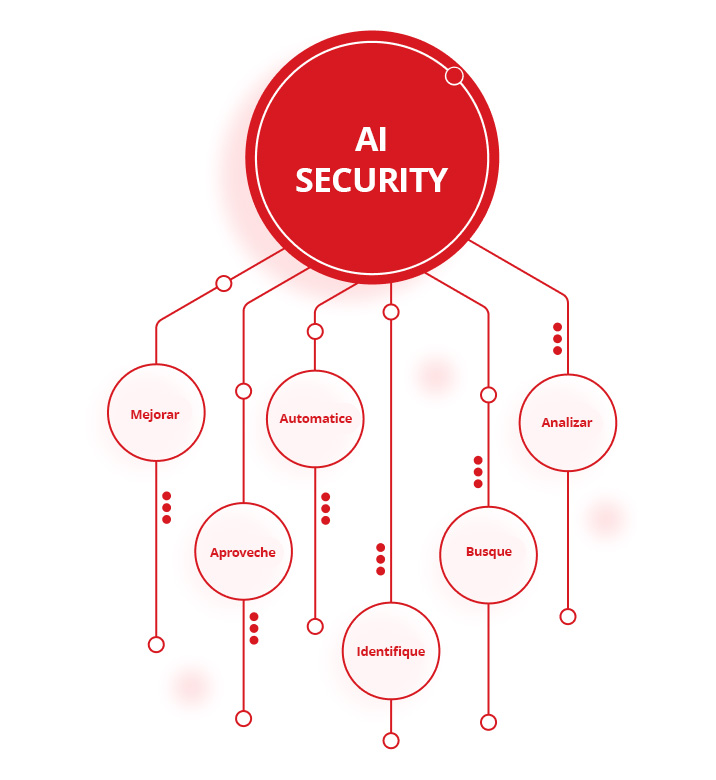

La ciberseguridad de IA (también llamada “IA para seguridad”) consiste en utilizar herramientas y tecnologías de IA para proteger las infraestructuras de TI de cibercriminales, ciberataques y otras ciberamenazas. Esto incluye el uso de IA para:

- Analizar grandes volúmenes de datos para detectar patrones, identificar anomalías y destacar posibles riesgos de seguridad

- Busque y elimine brechas y vulnerabilidades en las defensas de ciberseguridad de una organización

- Identifique y defienda frente a filtraciones de datos y otros ciberataques en tiempo real

- Automatice las herramientas de detección y respuesta de amenazas para reducir la demanda de equipos de seguridad y mejorar la velocidad y precisión de las ciberdefensas

- Aproveche la información sobre amenazas más reciente para adelantarse a los agentes maliciosos y mantenerse al tanto de vectores de ataque nuevos o emergentes

- Mejorar las estrategias y capacidades generales de gestión de ciberamenazas de una organización

La importancia de proteger los sistemas de IA

Aunque la idea de la inteligencia artificial ha existido durante décadas, los recientes avances en la tecnología de IA han transformado sectores que van desde el transporte y la atención sanitaria hasta la ciberseguridad. Desafortunadamente, la adopción generalizada de la IA ha permitido a los agentes maliciosos explotarla, lo que ha provocado un aumento significativo en el número, alcance y sofisticación de los ciberataques.

Como resultado, las organizaciones deben asegurarse de que están haciendo todo lo posible para mantener la integridad, confidencialidad y disponibilidad de sus datos de IA, proteger sus herramientas y aplicaciones de IA de ciberriesgos y ciberataques nuevos y emergentes, y proteger sus modelos, sistemas y algoritmos de IA de una amplia variedad de ciberamenazas en constante evolución.

La falta de protección y protección de los sistemas de IA frente a cualquiera de estas amenazas podría potencialmente abrir una organización a ataques, poner en riesgo a sus clientes y socios y acabar costándoles millones de dólares en gastos de remediación, demandas de rescate, ventas perdidas y productividad perdida.

¿Cuáles son los riesgos para la seguridad de la IA?

El potencial de la inteligencia artificial para revolucionar el campo de la ciberseguridad es claramente prometedor. Pero hay un número creciente de riesgos y desafíos de seguridad de IA que las organizaciones deben tener en cuenta al implementar una estrategia de seguridad de IA efectiva. Estas incluyen:

- Riesgo de una mayor superficie de ataque: la integración de modelos de IA propios y de terceros en la infraestructura de TI de una organización puede ampliar drásticamente su superficie de ataque, aumentar el número de puntos débiles que los agentes maliciosos pueden explotar y dejar los sistemas de IA vulnerables a ciberataques más potentes o frecuentes.

- Riesgo de ataques maliciosos o adversarios en datos y algoritmos de IA: los agentes maliciosos pueden obtener acceso no autorizado a herramientas y datos de IA, manipular datos y algoritmos de IA para insertar brechas o sesgos, poner en peligro la capacidad de los modelos de IA para realizar predicciones precisas o defenderse contra futuros ataques, y manipular, usar indebidamente o robar modelos y algoritmos de IA.

- Riesgo de envenenamiento, corrupción y manipulación de datos: los cibercriminales pueden corromper las canalizaciones de machine learning (ML) o los modelos de IA “envenenados” cambiando deliberadamente sus datos de entrada o insertando nuevos datos propios para poner en peligro las herramientas y los sistemas de IA.

- Riesgos para los modelos de entrenamiento de IA: los cibercriminales pueden robar, manipular o aplicar ingeniería inversa a modelos de entrenamiento de IA patentados. También pueden corromper, violar o alterar los datos utilizados para desarrollar y entrenar modelos de IA para poner en peligro su precisión, efectividad e integridad.

- Riesgo de sesgo, discriminación, privacidad de los datos y falta de transparencia: los errores humanos y los ciberataques pueden aumentar las preocupaciones sobre la privacidad de los datos y el sesgo en los modelos de IA y comprometer potencialmente los principios de transparencia, equidad y responsabilidad.

- Riesgo de incumplimiento de las normativas gubernamentales y del sector: el incumplimiento de la protección de los datos confidenciales, personales o sensibles puede dar lugar a graves sanciones y cargos por incumplimiento tanto del gobierno como de los reguladores del sector, incluido el Reglamento General de Protección de Datos (RGPD).

- Riesgo de ataques a proveedores externos: los atacantes pueden dirigirse a sistemas de IA en cualquier parte de la cadena de suministro de una organización para aprovechar las debilidades en las redes, componentes, marcos y bibliotecas de software de IA de socios externos y, a continuación, utilizar esas vulnerabilidades para dirigirse a otros modelos de IA en cualquier otro lugar de la cadena.

- Riesgos de descomposición y descomposición del modelo de IA: con el tiempo, todos los modelos de IA pueden ser vulnerables a descomposición o descomposición. Los agentes maliciosos pueden aprovechar modelos de IA deteriorados o en desfase para alterar su comportamiento o comprometer su precisión y fiabilidad.

- Riesgo de robo de credenciales de chatbot: los cibercriminales pueden robar credenciales de chatbot para proveedores de IA como ChatGPT o comprar credenciales robadas en la web oscura y utilizarlas para obtener acceso ilegal a herramientas y sistemas de IA patentados.

- Riesgo de fotos, vídeos y audio falsos: los agentes maliciosos pueden utilizar imágenes y vídeos falsos generados por IA para estafar a organizaciones, extorsionar a personas o empresas, engañar a los empleados para que otorguen acceso a sistemas críticos, revelen información confidencial o roben datos valiosos.

- Riesgo de ataques directos e indirectos de inyección rápida: los ataques de inyección rápida pueden utilizar código malicioso para engañar a modelos de lenguaje grande (LLM) y otras herramientas de IA para que filtren información confidencial, permitan el acceso no autorizado o eliminen documentos clave.

- Riesgo de abuso de alucinaciones de IA: los agentes maliciosos pueden aprovechar las “alucinaciones” comunes de IA para comprometer deliberadamente los datos en los que confían los modelos de IA y las decisiones que toman.

- Riesgos para los activos y la infraestructura de la nube: los cibercriminales pueden hackear modelos de IA basados en la nube y corromper o robar sus datos y otros activos.

Si las organizaciones no se aseguran de que sus medidas de seguridad y ciberseguridad de IA sean lo más sólidas, completas y actualizadas posible, los agentes maliciosos pueden aprovechar estos y otros riesgos para socavar la efectividad y fiabilidad de los modelos de IA, robar datos confidenciales o privados y potencialmente causar daños financieros y de reputación significativos.

¿Cuáles son los beneficios de la seguridad de IA?

Las organizaciones que implementan medidas de seguridad de IA para proteger sus pilas de IA se benefician de una serie de ventajas convincentes. Estas incluyen capacidades mejoradas para:

- Proteja sus datos de IA para que no se vean comprometidos, dañados, manipulados, vulnerados o robados

- Proteja los modelos de IA de ataques informáticos o ciberataques ejecutando detección y respuesta de amenazas en tiempo real, búsqueda de amenazas y análisis de vulnerabilidadesherramientas y tecnologías

- Proteja las infraestructuras de IA eliminando proactivamente las brechas o vulnerabilidades en las defensas cibernéticas, gestionando y mitigando los riesgos cibernéticos y protegiendo los activos de IA

- Proteja a los usuarios de IA y aplicaciones locales de ataques de código malicioso, acceso ilegal o no autorizado, esquemas de fraude y phishing, y ataques de malware y ransomware

- Controle el acceso a servicios de IA públicos y privados, incluidas aplicaciones de modelo de lenguaje grande (LLM)

- Defiéndase frente a ataques de día cero dirigidos a vulnerabilidades de software o hardware previamente desconocidas para permitir que los agentes maliciosos roben datos, violen información confidencial, instalen malware y otros virus u obtengan acceso a la infraestructura de TI de una organización

Prácticas recomendadas para la seguridad de IA

Las soluciones de seguridad de IA más eficaces siguen una serie de prácticas recomendadas estándar del sector para proteger sus herramientas y recursos de IA y mejorar su postura de seguridad. Estas prácticas incluyen:

- Desarrollo de una estrategia de seguridad de IA completa que combina modelado avanzado de amenazas y actividades de búsqueda de amenazas con capacidades de evaluación de riesgos impulsadas por IA, controles de seguridad de IA completos y procedimientos y planes detallados de respuesta ante incidentes para proteger los datos y sistemas de IA de una organización.

- Garantizar la calidad, integridad y fiabilidad de los datos de formación de IA para abordar los problemas relacionados con la transparencia, el sesgo y la explicabilidad, y garantizar que los modelos de IA sean lo más precisos y eficaces posible.

- Implementar marcos de seguridad de IA estándar del sector para establecer un conjunto claro de estándares y directrices para proteger los sistemas de IA, eliminar cualquier brecha o vulnerabilidad en las defensas de IA y mantener el cumplimiento de todas las normativas de seguridad de IA relevantes. Esto incluye la integración de marcos de seguridad como el marco de gestión de riesgos de inteligencia artificial del Instituto Nacional de Estándares y Tecnología (NIST), la matriz MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) y el marco normativo sensible para la seguridad de la IA, la lista del Open Worldwide Application Security Project (OWASP) de las 10 mejores prácticas para aplicaciones de modelo de lenguaje grande (LLM), Secure AI Framework (SAIF) de Google, y los estándares ISO/IEC 27001 para sistemas de gestión de seguridad de la información (ISMS).

- Integración de la seguridad de IA con medidas de seguridad y ciberseguridad existentes para crear una protección integral sin problemas frente a ciberamenazas para todas las aplicaciones, herramientas, sistemas y redes de IA y TI.

- Llevar a cabo programas regulares de formación y concienciación de empleados para aumentar la concienciación sobre las últimas amenazas y medidas de seguridad tanto entre equipos de ciberseguridad como entre otros empleados, y fomentar una cultura corporativa basada en la mejora continua.

- Supervisión, evaluación y actualización continuas de modelos de IA para analizar y mitigar vulnerabilidadesen herramientas y sistemas de IA, identificar amenazas emergentes cuando y a medida que surgen y perfeccionar constantemente modelos y aplicaciones de IA para mejorar su precisión, rendimiento y fiabilidad.

Ejemplos de aplicaciones de ciberseguridad de IA

A medida que las herramientas de inteligencia artificial se vuelven más avanzadas, los posibles usos y aplicaciones de la IA en ciberseguridad se están expandiendo de forma similar casi a diario.

Entre otros beneficios, las aplicaciones de ciberseguridad impulsadas por IA pueden mejorar significativamente el alcance y la efectividad de las defensas de ciberseguridad de una organización automatizando sus actividades de detección de amenazas y respuesta a incidencias, llevando a cabo análisis de vulnerabilidades y otras medidas proactivas de forma regular o continua, y utilizando la información sobre amenazas más reciente y análisis de seguridad para predecir, adelantar y proteger a las organizaciones de ciberamenazas nuevas y emergentes.

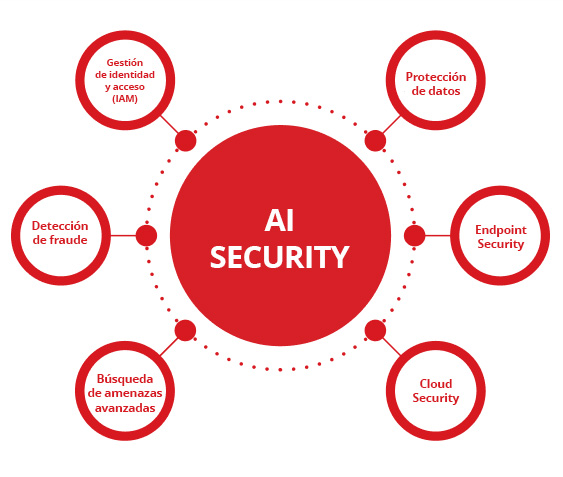

Algunas de las aplicaciones más efectivas y ampliamente adoptadas de la ciberseguridad de IA incluyen el uso de inteligencia artificial en la protección de datos, seguridad de endpoints, seguridad en la nube, búsqueda avanzada de amenazas, detección de fraude y gestión de identidad y acceso (IAM).

Protección de datos

Las organizaciones pueden utilizar la IA para clasificar y cifrar su información confidencial o sensible, supervisar el acceso a los sistemas para detectar filtraciones de datos de forma más rápida y precisa, proteger los datos de IA de pérdidas o corrupción y proteger su pila de IA del acceso, uso o divulgación no autorizados. Sin embargo, los puntos ciegos de la información confidencial en entornos de IA pueden provocar graves filtraciones de datos y problemas de cumplimiento, lo que hace que sea crucial identificar y mitigar esas vulnerabilidades de forma proactiva.

Endpoint Security

Las soluciones de respuesta y detección de endpoints (EDR) habilitadas para IA pueden ayudar a proteger portátiles, ordenadores de sobremesa, servidores informáticos, dispositivos móviles y otros endpoints de red en tiempo real detectando y bloqueando proactivamente malware, ransomware y otros ciberataques antes de que ocurran.

Cloud Security

Las tecnologías de seguridad en la nube impulsadas por IA pueden supervisar y controlar el acceso a entornos en la nube las 24 horas, identificar cualquier anomalía o actividad sospechosa, alertar a los equipos de seguridad de posibles amenazas a medida que se producen y proteger los datos y aplicaciones basados en la nube frente al acceso no autorizado y las filtraciones de datos.

Búsqueda de amenazas avanzadas

Las herramientas avanzadas de búsqueda de amenazas de IA pueden analizar rápida y fácilmente registros de datos, patrones de tráfico de red y actividades y comportamientos de usuarios para buscar ataques maliciosos, detectar cibercriminales en el acto antes de que puedan causar cualquier daño duradero y proteger los sistemas e infraestructura de IA de amenazas persistentes avanzadas (APT) y otros ciberataques.

Detección de fraude

Las organizaciones de los sectores de servicios financieros y bancarios pueden utilizar algoritmos de machine learning (ML), redes neuronales y otras tecnologías avanzadas de IA para detectar actividades potencialmente fraudulentas, bloquear el acceso no autorizado a cuentas bancarias u otras cuentas online y evitar el robo de identidad en transacciones financieras y de comercio electrónico.

Gestión de identidad y acceso (IAM)

Las soluciones de gestión de identidad y acceso (IAM) habilitadas para IA pueden ayudar a las organizaciones a supervisar y proteger cada paso de sus procesos de autenticación, autorización y gestión de acceso para asegurarse de que siguen todas las políticas y manuales de la empresa de IA, mantienen el cumplimiento de las normativas del sector, evitan el acceso no autorizado a datos confidenciales y mantienen a los hackers fuera de sus sistemas.

¿Dónde puedo obtener ayuda con la seguridad de la IA?

La Trend Vision One es una plataforma todo en uno impulsada por la ciberseguridad de IA.

Trend Vision One cuenta con un potente conjunto de herramientas y tecnologías de IA líderes en el sector que pueden detectar, predecir y prevenir ciberamenazas de forma mucho más rápida y efectiva que los equipos de seguridad tradicionales dirigidos por humanos. Lograr una seguridad efectiva de la pila de IA requiere proteger cada capa, desde los datos hasta la infraestructura y los usuarios, garantizando la visibilidad de las implementaciones de IA en la sombra, aplicando estrictos controles de acceso para el cumplimiento y estableciendo barreras para las API de IA para evitar el uso indebido y la intoxicación de modelos. Estas capacidades permiten a las organizaciones proteger toda su pila de IA y proteger sus datos, aplicaciones y sistemas de IA de la gran mayoría de ciberataques antes de que ocurran.

Trend Vision One también incluye las inigualables capacidades impulsadas por IA de Trend Cybertron: la primera IA de ciberseguridad verdaderamente proactiva del mundo. Gracias a la probada colección de modelos de lenguaje grande (LLM), conjuntos de datos, agentes de IA avanzados y más de 20 años de inversión en el campo de la seguridad de IA de Trend Micro, Trend Cybertron puede analizar patrones históricos y datos para predecir ataques específicos para cada cliente, permitir a las organizaciones lograr tiempos de remediación un 99 % más rápidos que la respuesta a incidencias tradicional y transformar las operaciones de seguridad de una organización de reactivas a proactivas prácticamente de la noche a la mañana.

Trend Cybertron también se diseñó para evolucionar y adaptarse continuamente para mantenerse al día de los cambios en las necesidades de una organización y mantenerse al tanto de las últimas tácticas, técnicas y procedimientos (TTP) que emplean los cibercriminales. Esto permite a las organizaciones asegurarse de que tanto su seguridad de IA como sus defensas de ciberseguridad de IA son siempre lo más sólidas, completas y actualizadas posible.

Michael Habibi es un líder en ciberseguridad con más de 12 años de experiencia, especializado en desarrollo de productos e innovación estratégica. Como Vice President of Product Management en Trend Micro, Michael dirige la alineación de la estrategia de productos de endpoint con el panorama de amenazas en constante evolución.

Preguntas frecuentes (FAQ)

¿Qué es la seguridad de la IA?

La seguridad para la IA (o “seguridad de IA”) es el uso de diferentes herramientas, prácticas y tecnologías para proteger la pila de IA de una organización.

¿Cuál es el significado de la IA en seguridad?

La IA se refiere a la “inteligencia artificial”. La IA se utiliza en seguridad para mejorar las defensas de ciberseguridad de una organización y proteger pilas de IA.

¿Cómo se puede utilizar la IA en seguridad?

La IA se puede utilizar para proteger redes, modelos, sistemas, endpoints y aplicaciones de IA frente a ciberataques, corrupción de datos y otras amenazas.

¿Qué es la IA en ciberseguridad?

La IA en ciberseguridad se refiere al uso de herramientas y tecnologías de IA para ayudar a proteger a las organizaciones de los ciberataques.

¿Es la IA un riesgo para la seguridad?

Al igual que cualquier tecnología, la IA se puede utilizar para mejorar las medidas de seguridad o lanzar ciberataques más potentes.

¿Es la seguridad de la IA una buena carrera?

La seguridad de la IA es un campo en crecimiento que ofrece numerosas oportunidades profesionales desafiantes y bien pagadas.

¿Cuánto ganan los responsables de seguridad de IA?

Dependiendo de su experiencia y ubicación, los responsables de seguridad de IA pueden ganar entre 60 000 y más de 120 000 dólares al año.

¿Cómo puedo acceder a la seguridad de la IA?

Los cursos de formación online, los títulos en informática o ciberseguridad y las certificaciones de seguridad de IA son buenos puntos de partida para una carrera en seguridad de IA.

¿Cuál es la diferencia entre ciberseguridad y seguridad de IA?

La ciberseguridad se refiere a herramientas o sistemas que protegen a las organizaciones de los ciberataques. La seguridad de la IA consiste en proteger la pila de IA de una organización.

¿Puede la IA hacer ciberseguridad?

Bajo supervisión humana, las tecnologías de IA pueden mejorar drásticamente la velocidad, la precisión y la efectividad de casi todos los aspectos de la ciberseguridad.

¿Cuál es la diferencia entre ciberseguridad tradicional e IA?

Aunque sus objetivos y métodos son los mismos, la ciberseguridad de IA puede proporcionar una protección más rápida, precisa y proactiva que la ciberseguridad tradicional.

¿La ciberseguridad requiere codificación?

Si bien la codificación puede ser una habilidad valiosa para muchos trabajos de ciberseguridad, hay numerosas posiciones en ciberseguridad que no requieren experiencia ni conocimientos de codificación.

¿Por qué la IA es una amenaza para la seguridad?

Los agentes maliciosos pueden utilizar la IA para piratear sistemas de IT, robar datos confidenciales, corromper pilas de IA o lanzar ciberataques sofisticados.

¿Cuál es un ejemplo de una filtración de datos de IA?

Se han utilizado falsificaciones profundas de IA para simular las voces o imágenes de vídeo de personas reales, convenciendo a los empleados de organizaciones para que compartan información confidencial que debería haberse mantenido privada.

¿Es segura la aplicación de seguridad de IA?

En última instancia, la seguridad de una aplicación de seguridad depende de la fiabilidad de su desarrollador, no de su precio. Siga las principales marcas probadas de forma independiente y evite aplicaciones de fuentes desconocidas.

¿Cuáles son los riesgos de la seguridad con IA?

Algunos riesgos comunes asociados con la seguridad de la IA incluyen superficies de ataque ampliadas, intoxicación y corrupción de datos, y riesgos para los datos, algoritmos y modelos de formación de la IA.

¿Es mi sistema de IA de alto riesgo?

Las organizaciones pueden reducir los riesgos para los sistemas de IA analizando sus defensas actuales, siguiendo las prácticas recomendadas del sector e implementando estrategias integrales de ciberseguridad y seguridad de IA.

¿Debo confiar en un detector de IA?

Aunque los detectores de IA pueden ser herramientas eficaces, también pueden cometer errores. Por lo tanto, sus resultados solo deben utilizarse como una señal preliminar para impulsar una investigación adicional, que debe basarse en el juicio humano.

¿Cómo tener cuidado con la IA?

Un enfoque verdaderamente cuidadoso de la IA requiere diferentes acciones de usuarios y creadores. Tanto si la utiliza como si la construye, la regla fundamental es tratar la IA como una herramienta potente pero imperfecta, no como un experto infalible o un seguro.

¿Cómo protejo la IA?

Una postura de seguridad completa para la pila de IA no deja brechas, aplicando protección en todos los componentes, desde los usuarios y los datos que generan hasta los modelos, los microservicios y la infraestructura subyacente.

Artículos relacionados

Los 10 principales riesgos y mitigaciones de 2025 para aplicaciones de IA de generación y LLM

Gestión de riesgos emergentes para la seguridad pública

¿Hasta dónde nos pueden llevar los estándares internacionales?

Cómo redactar una política de ciberseguridad de IA generativa

Ataques maliciosos mejorados con IA entre los principales riesgos

Aumento de la amenaza de identidades falsas