L'intelligenza artificiale (IA) è una tecnologia che consente a computer e macchine di apprendere, comprendere, creare, risolvere problemi, prevedere i risultati e prendere decisioni.

Sommario

Cos'è l'IA?

A livello più basilare, l'IA si riferisce a computer o sistemi che utilizzano tecnologie come il machine learning (ML), le reti neurali e le architetture cognitive per eseguire i tipi di attività complicate che in precedenza solo gli esseri umani erano in grado di svolgere.

Questi includono tutto, dalla creazione di contenuti alla pianificazione, al ragionamento, alla comunicazione, all'apprendimento dall'esperienza e al prendere decisioni complesse. Detto questo, poiché i sistemi e gli strumenti IA sono così ampi e vari, nessuna definizione singola si applica perfettamente a tutti.

Sin dalla sua introduzione negli anni '50, l'IA ha trasformato quasi ogni aspetto della vita moderna, della società e della tecnologia. Grazie alla sua capacità di analizzare grandi quantità di dati, comprendere i modelli e acquisire nuove conoscenze, l'IA è diventata uno strumento indispensabile praticamente in ogni campo dell'attività umana, dal business e dai trasporti all'assistenza sanitaria, fino alla cybersecurity.

Tra le altre applicazioni, le organizzazioni utilizzano l'IA per:

- Ridurre i costi

- Promuovere l'innovazione

- Potenziare i team

- Semplificare le operazioni

- Accelerare il processo decisionale

- Consolidare e analizzare i risultati della ricerca

- Fornirere supporto e assistenza clienti tempestivi

- Automatizzare le attività ripetitive

- Assistere nella generazione di idee

Una breve storia dell'IA

L'idea di una macchina in grado di pensare da sola risale a migliaia di anni fa. Nel suo contesto moderno, l'intelligenza artificiale come concetto definito può essere ricondotta all'anno 1950, quando il matematico e informatico Alan Turing, creatore del famoso "Turing Test" per determinare se un computer può pensare come un essere umano, ha pubblicato il suo documento influente sul concetto di intelligenza artificiale, computer e intelligenza.

Nei decenni successivi alla prima apparizione del documento di Turing, l'IA ha subito una drastica evoluzione nella sua portata e nelle sue capacità, spinta da progressi esponenziali nella potenza di elaborazione, nella sofisticatezza algoritmica, nella disponibilità dei dati e dall'introduzione di tecnologie come il machine learning, il data mining e le reti neurali.

Pietre miliari nell'evoluzione dell'intelligenza artificiale

Anno

Traguardi significativi

Anni '50

- Pubblicazione del documento "Computing Machinery and Intelligence" di Alan Turing

- John McCarthy conia il termine "intelligenza artificiale"

- Creazione di Logic Theorist, il primo programma informatico IA

Anni '60

- Creazione di Mark 1 Perceptron, il primo computer a imparare per tentativi ed errori

Anni '80

- Crescita delle tecniche di deep learning e delle reti neurali

Anni '90

- L'aumento della potenza di elaborazione e dei dati accelera la crescita e gli investimenti nell'IA

- Deep Blue AI di IBM sconfigge il campione mondiale di scacchi Garry Kasparov

Anni 2000

- L'intelligenza artificiale diventa un elemento di riferimento con i lanci del motore di ricerca basato sull'intelligenza artificiale di Google, del motore di raccomandazione dei prodotti di Amazon, del sistema di riconoscimento facciale di Facebook e delle prime auto a guida autonoma

Anni 2010

- Vengono introdotti assistenti IA come Siri di Apple e Alexa di Amazon

- Google lancia il suo framework di machine learning open source, TensorFlow

- La rete neurale AlexNet rende popolare l'uso di unità di elaborazione grafica (GPU) per il training di modelli IA

Anni 2020

- OpenAI lancia la terza iterazione del suo popolarissimo modello linguistico di grandi dimensioni (LLM) ChatGPT, l'intelligenza artificiale generativa (GenAI)

- L'ondata di GenAI continua con il lancio di generatori di immagini come Midjourney e Dall-E 2 e chatbot LLM come Gemini di Google

Come funziona l'IA?

I sistemi IA funzionano alimentando o ingerendo grandi quantità di dati e utilizzando processi cognitivi simili a quelli umani per analizzare e valutare tali dati. In questo modo, i sistemi IA identificano e classificano i modelli e li utilizzano per svolgere attività o fare previsioni sui risultati futuri senza supervisione o istruzioni umane dirette.

Ad esempio, un programma di IA che genera immagini come Midjourney, alimentato da un numero enorme di fotografie, può imparare a creare immagini "originali" basate sui prompt inseriti da un utente. Allo stesso modo, un chatbot IA del servizio clienti addestrato su grandi volumi di testo può imparare a interagire con i clienti in modi che imitano gli agenti del servizio clienti umano.

Mentre ogni sistema è diverso, i modelli IA sono solitamente programmati seguendo lo stesso processo in cinque fasi:

- Addestramento: il modello IA viene alimentato da enormi quantità di dati e utilizza una serie di algoritmi per analizzare e valutare i dati.

- Ragionamento: il modello IA classifica i dati ricevuti e identifica eventuali modelli al suo interno.

- Ottimizzazione: mentre il modello IA prova diversi algoritmi, apprende quali tendono ad avere più successo e perfeziona le proprie azioni di conseguenza.

- Creazione: il modello IA utilizza ciò che è stato appreso per svolgere le attività assegnate, prendere decisioni o creare musica, testo o immagini.

- Miglioramento: in definitiva, il modello IA apporta modifiche continue per migliorarne l'accuratezza, "imparando" efficacemente dalla sua esperienza.

Machine learning vs. deep learning

La maggior parte dei moderni sistemi IA utilizza una varietà di tecniche e tecnologie per simulare i processi di intelligenza umana. I più importanti sono il deep learning e il machine learning (ML). Anche se i termini machine learning e deep learning sono a volte utilizzati in modo intercambiabile, in realtà sono processi molto distinti nel contesto del training con IA.

Il machine learning utilizza algoritmi per analizzare, categorizzare, ordinare, apprendere e dare un senso a enormi quantità di dati per produrre modelli precisi e prevedere i risultati senza dover essere informati esattamente su come farlo.

Il deep learning è una sottocategoria del machine learning che raggiunge gli stessi obiettivi utilizzando reti neurali per simulare la struttura e la funzione del cervello umano. Esamineremo entrambi questi concetti in maggiore dettaglio di seguito.

Principi di base del machine learning

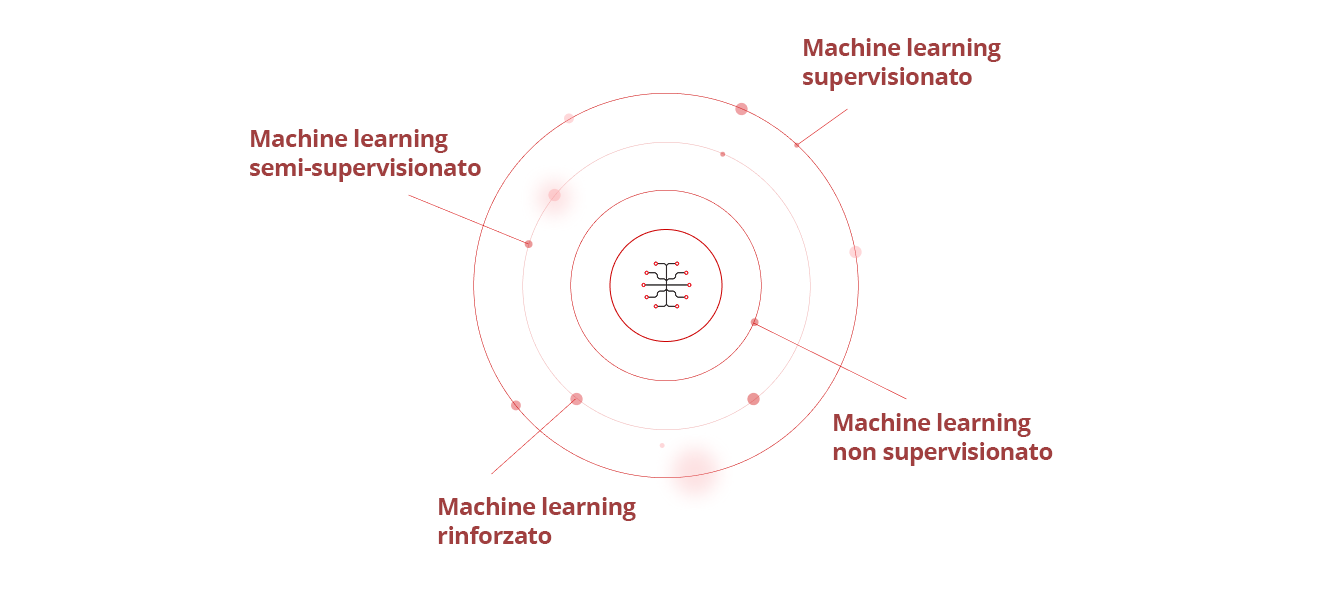

Esistono quattro tipi principali di machine learning:

- Machine learning supervisionato: l'IA utilizza set di dati noti, stabiliti e classificati per scoprire degli schemi prima di inserirli nell'algoritmo.

- Machine learning semi-supervisionato: l'IA viene addestrata su un piccolo set di dati noto ed etichettato, che poi si applica a set di dati più grandi, non etichettati e sconosciuti.

- Machine learning non supervisionato: l'intelligenza artificiale impara da set di dati sconosciuti, non etichettati e non classificati.

- Machine learning rinforzato: il modello IA non viene inizialmente addestrato su alcun set di dati, quindi impara invece dalla prova e dall'errore e ne modifica i comportamenti fino al suo successo.

Il machine learning è ciò che consente alle auto a guida autonoma di rispondere ai cambiamenti dell'ambiente abbastanza bene da poter portare i propri passeggeri in modo sicuro alla destinazione scelta. Altre applicazioni di machine learning spaziano tra programmi di riconoscimento di immagini e vocali, app di traduzione linguistica, agenti IA basati sulla persona e data mining, rilevamento delle frodi con carte di credito, diagnosi di assistenza sanitaria e raccomandazioni su social media, prodotti o marchi.

Deep learning e reti neurali

Il deep learning è una forma di machine learning basata sull'uso di reti neurali avanzate: algoritmi di machine learning che emulano il modo in cui i neuroni in un cervello umano funzionano al fine di identificare schemi complessi in grandi set di dati.

Ad esempio, anche i bambini molto piccoli possono distinguere istantaneamente i genitori dagli altri adulti perché il loro cervello può analizzare e confrontare centinaia di dettagli unici o distintivi in un batter d'occhio, dal colore degli occhi e dei capelli alle espressioni distintive o alle caratteristiche del viso.

Le reti neurali replicano il modo in cui funzionano i cervelli umani analizzando in modo simile migliaia o milioni di piccoli dettagli nei dati che vengono alimentati per rilevare e riconoscere modelli più ampi tra di loro. Sistemi di IA generativa (o "GenAI") come ChatGTP di OpenAI o il generatore di immagini di Midjourney, ad esempio, utilizzano il deep learning per acquisire e analizzare un gran numero di immagini o testi, quindi utilizzano tali dati per creare nuovi testi o immagini simili, ma diversi, ai dati originali.

Quali sono gli ultimi sviluppi nell'IA?

Negli ultimi anni, le innovazioni all'avanguardia nell'elaborazione del linguaggio naturale, nella computer vision, nell'apprendimento per rinforzo e nelle tecnologie all'avanguardia come le reti generative avversarie (GAN), i modelli trasformatori e le vere macchine abilitate all'intelligenza artificiale (AIEM) hanno notevolmente ampliato le capacità dei sistemi IA per simulare i processi di intelligenza umana più da vicino, generare contenuti più realistici ed eseguire attività sempre più complesse.

Innovazioni nel machine learning e nel deep learning

Negli ultimi anni, le innovazioni all'avanguardia nell'elaborazione del linguaggio naturale, nella computer vision, nell'apprendimento per rinforzo e nelle tecnologie all'avanguardia come le reti generative avversarie (GAN), i modelli trasformatori e le vere macchine abilitate all'intelligenza artificiale (AIEM) hanno notevolmente ampliato le capacità dei sistemi IA per simulare i processi di intelligenza umana più da vicino, generare contenuti più realistici ed eseguire attività sempre più complesse.

Innovazioni nel machine learning e nel deep learning

Rivoluzionarie innovazioni negli algoritmi di machine learning e deep learning hanno consentito a ricercatori e sviluppatori di creare sistemi IA incredibilmente sofisticati per un'ampia varietà di applicazioni reali.

I chatbot IA, ad esempio, vengono utilizzati da milioni di aziende ogni giorno per rispondere a domande, vendere prodotti e interagire con i propri clienti. Le aziende utilizzano anche algoritmi di intelligenza artificiale per scoprire le tendenze basate sugli acquisti passati di un cliente e formulare raccomandazioni personalizzate per nuovi prodotti, marchi o servizi.

Nel campo del riconoscimento vocale automatico (ASR), i servizi IA come Siri e Alexa utilizzano l'elaborazione del linguaggio naturale (NLP) per tradurre il linguaggio umano in contenuti scritti. Allo stesso modo, i progressi nelle reti neurali basate sull'intelligenza artificiale hanno reso più facile taggare le foto sui social media e hanno reso più sicure le auto a guida autonoma.

Altri esempi di IA che utilizzano il machine learning o il deep learning includono algoritmi di compravendita di titoli automatizzati, robot intelligenti in grado di eseguire attività ripetitive nelle fabbriche o sulle linee di assemblaggio e l'uso del machine learning per aiutare le banche a individuare le transazioni sospette e bloccare le frodi finanziarie.

Il ruolo in evoluzione dell'IA nella cybersecurity

Quando si tratta del ruolo dell'IA nella cybersecurity, ci sono due aree distinte ma interconnesse da considerare: Sicurezza IA e cybersecurity IA.

La sicurezza IA (chiamata anche sicurezza per l'IA) si riferisce all'uso di misure di cybersecurity per proteggere lo stack IA di un'organizzazione, ridurre o eliminare i rischi di sicurezza IA e proteggere ogni sistema, componente e applicazione IA in tutta la rete, dagli endpoint ai modelli IA. Ciò include:

- Proteggere lo stack, l'infrastruttura, i modelli e i dati di addestramento dell'IA dagli attacchi

- Mantenere l'integrità dei dati delle pipeline di machine learning e deep learning

- Affrontare i problemi di pregiudizi, trasparenza, spiegabilità e altre preoccupazioni etiche dell'IA

Garantire che l'uso o lo sviluppo dell'IA siano pienamente conformi a tutte le leggi, le politiche e le normative pertinenti

La cybersecurity basata sull'intelligenza artificiale copre tutti i diversi modi in cui gli strumenti abilitati all'intelligenza artificiale possono migliorare in modo proattivo le difese di cybersecurity di un'organizzazione in modo più rapido, accurato ed efficace di quanto qualsiasi team di cybersecurity umano o centro operativo di sicurezza (SOC) possa mai fare. Ciò include l'utilizzo dell'IA per:

- Identificare le minacce informatiche e difendersi dagli attacchi informatici in tempo reale

- Eliminare le lacune e le vulnerabilità della cybersecurity più velocemente e con maggiore precisione

- Automatizzare il rilevamento e la risposta alle minacce e altri strumenti di cybersecurity per una risposta più rapida agli incidenti

- Migliorare la threat intelligence per potenziare o supportare una gestione più efficiente delle minacce

- Automatizzare le attività di routine come la scansione delle vulnerabilità e l'analisi dei log per consentire al team di cybersecurity umano di affrontare le minacce più complesse

Esempi di applicazioni IA nella cybersecurity

Le aziende stanno già utilizzando l'IA in diversi modi per migliorare la loro cybersecurity, rilevare e rispondere agli attacchi informatici e difendere le loro reti da minacce informatiche come violazioni dei dati, attacchi DDoS (Distributed Denial-of-Service), ransomware, malware, attacchi di phishing e minacce all’identità.

Nell'area del rilevamento e della risposta alle minacce, l'IA può identificare e prevedere le minacce informatiche, analizzare i modelli nei log delle attività e nel traffico di rete, autenticare e proteggere password e accessi degli utenti, utilizzare il riconoscimento facciale e gli accessi basati su CAPTCHA, simulare gli attacchi informatici, eseguire la scansione delle vulnerabilità di rete e creare difese automatizzate di cybersecurity contro le minacce nuove o emergenti. Ciò include strumenti come:

- Firewall di nuova generazione (NGFW) basati sull'intelligenza artificiale

- Informazioni sulla sicurezza IA e gestione degli eventi (SIEM)

- Sistemi di sicurezza per endpoint e cloud IA

- Rilevamento e risposta della rete IA (NDR)

- Rilevamento e risposta estesi con IA (XDR)

Quando si verifica un attacco, l'IA può anche offrire strategie di correzione efficaci o rispondere automaticamente agli incidenti di sicurezza in base alle politiche e ai playbook predefiniti di un'organizzazione. Ciò può aiutare a ridurre i costi e a ridurre al minimo i danni causati da un attacco e consentire alle organizzazioni di tornare operative più rapidamente.

Quali considerazioni etiche sono coinvolte nello sviluppo e nell'uso dell'IA?

L'intelligenza artificiale offre chiaramente una serie di potenti vantaggi rispetto ad altri tipi di sistemi informatici. Ma come per qualsiasi nuova tecnologia, ci sono rischi, sfide e questioni etiche che devono essere prese in considerazione nello sviluppo, nell'adozione e nell'uso dell'IA.

Pregiudizio ed equità

I modelli di IA sono addestrati dagli esseri umani utilizzando i dati ricavati dai contenuti esistenti. Ciò crea il rischio che il modello possa riflettere o rafforzare eventuali pregiudizi impliciti contenuti in quel contenuto. Questi pregiudizi potrebbero potenzialmente portare a disuguaglianza, discriminazione o slealtà negli algoritmi, nelle previsioni e nelle decisioni che vengono prese utilizzando tali modelli.

Inoltre, poiché i contenuti che creano possono essere così realistici, gli strumenti GenAI possono potenzialmente essere utilizzati in modo improprio per creare o diffondere disinformazione, contenuti dannosi e video, audio e immagini deepfake.

Problemi di privacy

Ci sono anche diverse preoccupazioni sulla privacy relative allo sviluppo e all'uso dell'IA, specialmente in settori come sanità, servizi bancari e legali che trattano informazioni altamente personali, sensibili o riservate.

Per salvaguardare tali informazioni, le applicazioni basate sull'intelligenza artificiale devono seguire una serie chiara di best practice in materia di sicurezza, privacy e protezione dei dati. Ciò include l'utilizzo di tecniche di anonimizzazione dei dati, l'implementazione di una solida crittografia dei dati e l'utilizzo di difese avanzate di cybersecurity per proteggere da furto di dati, violazioni dei dati e hacker.

Conformità alle normative

Molte agenzie di regolamentazione e framework come il Regolamento generale sulla protezione dei dati (GDPR) richiedono alle aziende di seguire una serie di regole chiara quando si tratta di proteggere le informazioni personali, garantire trasparenza e responsabilità e salvaguardare la privacy.

Per rispettare tali normative, le organizzazioni devono assicurarsi di disporre di politiche aziendali sull'intelligenza artificiale per monitorare e controllare i dati utilizzati per costruire nuovi modelli di IA e per proteggere qualsiasi modello di IA che potrebbe contenere informazioni sensibili o personali da malintenzionati.

Qual è il futuro della tecnologia IA?

Ciò che accadrà nel futuro dell'IA è, naturalmente, impossibile da prevedere. Ma è possibile fare alcune ipotesi informate su ciò che verrà dopo in base alle tendenze attuali nell'uso e nella tecnologia dell'IA.

Tendenze emergenti nella ricerca sull'IA

In termini di ricerca sull'IA, le innovazioni nei sistemi di IA autonomi, nel meta-AI e nel meta-learning, nei modelli linguistici di grandi dimensioni open source (LLM), nei digital twin e nel red teaming per la convalida del rischio e nel processo decisionale congiunto tra IA umana potrebbero rivoluzionare il modo in cui l'IA viene sviluppata.

Anche nuovi sistemi complessi come l'IA neuro-simbolica, le vere macchine abilitate all'IA (AIEM) e il machine learning quantistico probabilmente miglioreranno ulteriormente la portata e le capacità di modelli, strumenti e applicazioni IA.

Un'altra tecnologia che ha il potenziale di rivoluzionare il modo in cui funziona l'IA è il passaggio all'IA agentica di nuova generazione, che ha la capacità di prendere decisioni e intraprendere azioni da sola, senza la direzione, la supervisione o l'intervento umano.

Secondo l'analista tecnologico Gartner, entro il 2028 l'IA agentica potrebbe essere utilizzata per prendere fino al 15% di tutte le decisioni lavorative quotidiane. Le interfacce utente (UI) di intelligenza artificiale agentica potrebbero anche diventare più proattive e guidate dalle persone mentre imparano ad agire come più agenti umani con personalità prestabilite, a svolgere attività aziendali più complesse, a prendere decisioni aziendali più importanti e a fornire consigli più personalizzati ai clienti.

Potenziali impatti dell'IA sulla forza lavoro

Man mano che l'IA aumenta l'efficienza operativa e assume il controllo delle attività di routine e che i motori GenAI come ChatGPT e Midjourney diventano più potenti e diffusi, ci sono valide preoccupazioni sul possibile impatto sui lavori in numerosi settori.

Ma come per l'introduzione di internet, personal computer, telefoni cellulari e altre tecnologie che cambiano paradigma in passato, l'IA creerà probabilmente anche nuove opportunità e forse anche nuovi settori che avranno bisogno di lavoratori qualificati e di talento.

Di conseguenza, piuttosto che affrontare le perdite di lavoro, la sfida più grande potrebbe essere determinare come formare al meglio i lavoratori per queste nuove opportunità e facilitare le loro transizioni dalla riduzione alle occupazioni in crescita.

Il ruolo dell'IA nell'affrontare le sfide globali

Oltre ad aumentare l'efficienza operativa e migliorare la cybersecurity, l'IA ha il potenziale per aiutare a risolvere alcune delle maggiori sfide che l'umanità deve affrontare oggi.

Nel campo dell'assistenza sanitaria, l'IA può aiutare i medici a formulare diagnosi più rapide e accurate, monitorare la diffusione delle future pandemie e accelerare la scoperta di nuovi farmaci, trattamenti e vaccini.

Le tecnologie IA potrebbero migliorare la velocità e l'efficienza delle risposte alle emergenze in caso di disastri naturali e causati dall'uomo e di eventi meteorologici gravi.

L'intelligenza artificiale potrebbe anche contribuire a contrastare il cambiamento climatico ottimizzando l'uso delle energie rinnovabili, riducendo le emissioni di carbonio delle aziende, monitorando i livelli globali di deforestazione e inquinamento degli oceani e migliorando l'efficienza dei sistemi di riciclaggio, trattamento delle acque e gestione dei rifiuti.

Altre tendenze e sviluppi probabili

Alcune delle altre probabili tendenze, capacità e applicazioni future per l'IA includono:

- Sicurezza del modello linguistico di grandi dimensioni (LLM) per proteggere gli LLM da attacchi dannosi, uso improprio generale, accesso non autorizzato e altre minacce informatiche. Ciò include misure per proteggere i dati LLM, i modelli e i sistemi e i componenti associati.

- IA personalizzata e incentrata sull'utente per offrire un servizio clienti più personalizzato, intelligente e personalizzato, anche per l'endpoint marketing via email.

- Utilizzo di modelli IA per facilitare il red teaming e gli esercizi di digital twin simulando gli attacchi ai sistemi IT di un'organizzazione per testare le vulnerabilità e mitigare eventuali difetti o punti deboli.

Dove posso ottenere aiuto con l'IA e la cybersecurity?

Trend Vision One™ offre una protezione end-to-end senza pari per l'intero stack IA in un'unica piattaforma unificata basata sull'intelligenza artificiale.

Sfruttando le funzionalità ricche di funzionalità di Trend Cybertron, la prima intelligenza artificiale proattiva per la cybersecurity al mondo, Trend Vision One include una suite di funzionalità di intelligenza artificiale agentiche che si evolvono continuamente in base alle operazioni di intelligence e sicurezza del mondo reale.

Ciò consente di adattarsi rapidamente alle minacce emergenti al fine di migliorare il livello di sicurezza di un'organizzazione, migliorare l'efficienza operativa, trasformare le operazioni di sicurezza da reattive a proattive e proteggere ogni livello di infrastruttura IA.

Fernando Cardoso è vicepresidente della gestione dei prodotti presso Trend Micro, concentrandosi sul mondo in continua evoluzione dell'IA e del cloud. La sua carriera è iniziata come Network and Sales Engineer, dove ha affinato le sue competenze in datacenter, cloud, DevOps e cybersecurity, aree che continuano a alimentare la sua passione.

Domande frequenti (FAQ)

Che cos'è l'IA?

L'intelligenza artificiale (o "IA") è un computer che utilizza la tecnologia per imitare il modo in cui gli esseri umani pensano, funzionano e prendono decisioni.

Cosa fa davvero l'IA?

I modelli IA utilizzano algoritmi complessi e sfruttano grandi quantità di informazioni "apprese" per calcolare le risposte alle domande degli utenti o generare contenuti in base ai prompt degli utenti.

Siri è un'IA?

Siri è una semplice forma di IA che utilizza tecnologie come il machine learning e il riconoscimento vocale per comprendere e rispondere al linguaggio umano.

L'IA è buona o cattiva?

Come tutte le tecnologie, l'IA non è intrinsecamente buona o cattiva. È uno strumento che può essere utilizzato sia per scopi positivi che negativi.

Qual è l'obiettivo principale dell'IA?

L'obiettivo principale dell'IA è consentire ai computer di prendere decisioni più intelligenti, svolgere attività più difficili e imparare dall'esperienza senza un costante contributo umano.

Perché è stata creata l'IA?

L'IA è stata sviluppata per aiutare ad automatizzare le attività ripetitive, risolvere problemi complessi e consentire ricerche e innovazioni più avanzate in diversi settori.

Quali sono i rischi dell'IA?

Alcuni rischi posti dall'IA includono preoccupazioni su pregiudizi e correttezza, rischi per la privacy, rischi per la cybersecurity e il potenziale spostamento del lavoro.

Chi ha realizzato l'IA?

Gli scienziati informatici Alan Turing (1912 – 1954) e John McCarthy (1927 – 2011) sono solitamente considerati i "padri non ufficiali dell'IA".

Che cos'è l'IA nella vita reale?

Ci sono molti esempi di IA nella nostra vita quotidiana, dal software sullo smartphone in tasca ai chatbot che rispondono alle domande comuni del servizio clienti.

Che cos'è una semplice IA?

Alcuni esempi di semplici IA includono assistenti vocali come Siri o Alexa, motori di ricerca intelligenti come Google, chatbot del servizio clienti e persino aspirapolvere robotizzati.

Quali sono gli svantaggi dell'IA?

Alcuni svantaggi dell'IA includono preoccupazioni su privacy e pregiudizi, rischi di cybersecurity e il potenziale impatto sui lavori in alcuni campi.

Quali sono i 5 svantaggi dell'IA?

A seconda di come viene utilizzata, l'IA può causare perdite di lavoro, generare disinformazione, compromettere le informazioni private, ridurre la creatività e portare a una dipendenza eccessiva dalla tecnologia.

Come posso attivare l'IA?

La maggior parte degli strumenti IA può essere attivata o disattivata nelle funzionalità delle impostazioni di cellulari, computer, applicazioni software o siti web.

Posso usare l'IA gratuitamente?

Molti strumenti IA come i motori di ricerca o Alexa sono completamente gratuiti. Altri, come ChatGPT, offrono opzioni gratuite e a pagamento. L'IA di livello commerciale è solitamente a pagamento.

Quale IA è completamente gratuita?

La maggior parte delle aziende di IA offre versioni introduttive gratuite, tra cui Microsoft Copilot, Grammarly, Google Gemini e ChatGPT.

Qual è l'app IA più popolare in questo momento?

Attualmente, le app IA più popolari includono ChatGPT, Google Maps, Google Assistant, Microsoft Copilot e Google Gemini.

Qual è l'app di scrittura IA che tutti utilizzano?

Alcune delle app di scrittura assistita dall'intelligenza artificiale più popolari sono Grammarly, ChatGPT, Writesonic, Jasper e Claude.

Qual è l'app IA che tutti utilizzano gratuitamente?

Google Gemini, Copilot di Microsoft e ChatGPT sono tutte le app IA gratuite più utilizzate in questo momento.

Qual è il miglior chatbot IA in questo momento?

Il chatbot "migliore" dipende da quello che ti serve, ma alcuni dei chatbot IA più popolari includono Perplexity, Google Gemini, Jasper e ChatGPT.

Qual è un esempio di IA nella vita quotidiana?

Esempi comuni di IA nella vita quotidiana includono smartphone, motori di ricerca IA, chatbot di servizio clienti e assistenti vocali digitali come Siri e Alexa.

Articoli correlati

I 10 principali rischi e mitigazioni per LLM e app IA generative per il 2025

Gestione dei rischi emergenti per la pubblica sicurezza

Quanto possono portarci lontano gli standard internazionali?

Come scrivere una politica di cybersecurity per l'intelligenza artificiale generativa

Attacchi dannosi potenziati dall'intelligenza artificiale tra i principali rischi

Minaccia crescente delle identità Deepfake