Yapay zeka teknolojilerinin uygulanması, geleneksel bilgi işlem ortamlarında bulunmayan yeni güvenlik açığı noktaları getiriyor. Bunlar, tehdit aktörleri tarafından başlatılan kötü amaçlı siber saldırıları ve platform ve kullanıcı davranışından kaynaklanan güvenlik açıklarını içeriyor.

İçindekiler

Yapay zeka güvenlik açıkları

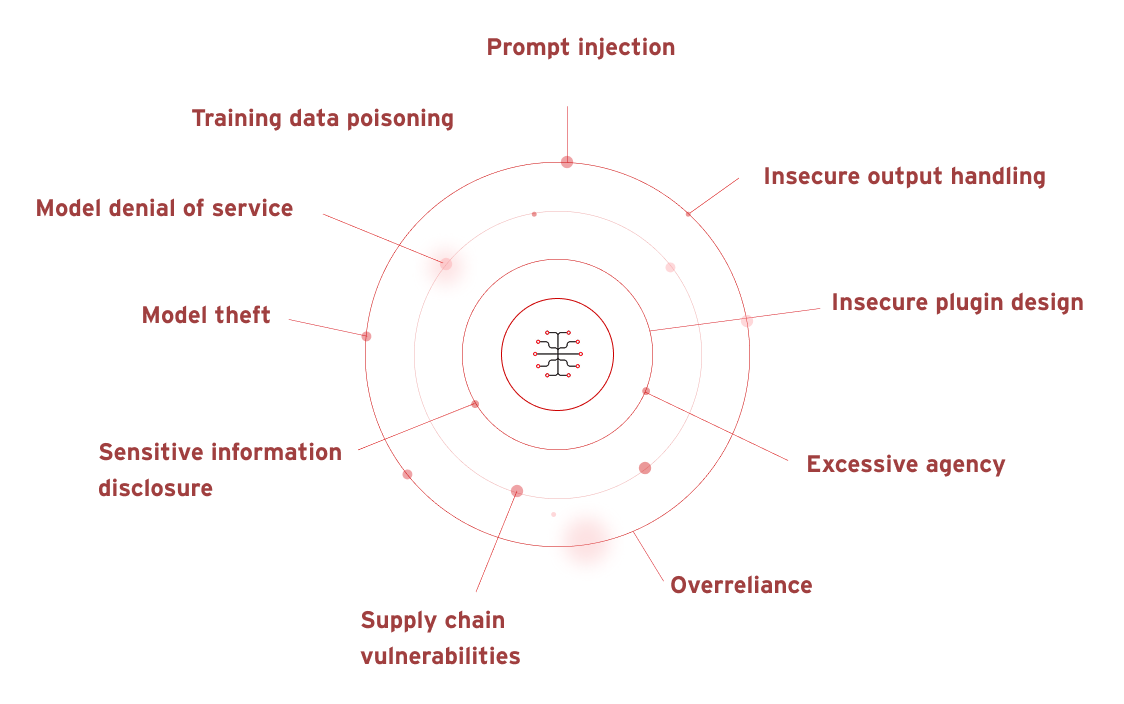

Open Worldwide Application Security Project (OWASP), öğrenme dili modelleri (LLM'ler) ve GenAI üzerine kurulu yapay zeka (AI) ile ilgili bir dizi güvenlik açığı belirledi. Bunlar şunları içerir:

- İstem enjeksiyonu

- Güvensiz çıktı işleme

- Eğitim verisi zehirlenmesi

- Model hizmet reddi

- Tedarik zinciri güvenlik açıkları

- Hassas bilgi ifşası

- Güvensiz eklenti tasarımı

- Aşırı yetki

- Aşırı Güven

- Model hırsızlığı

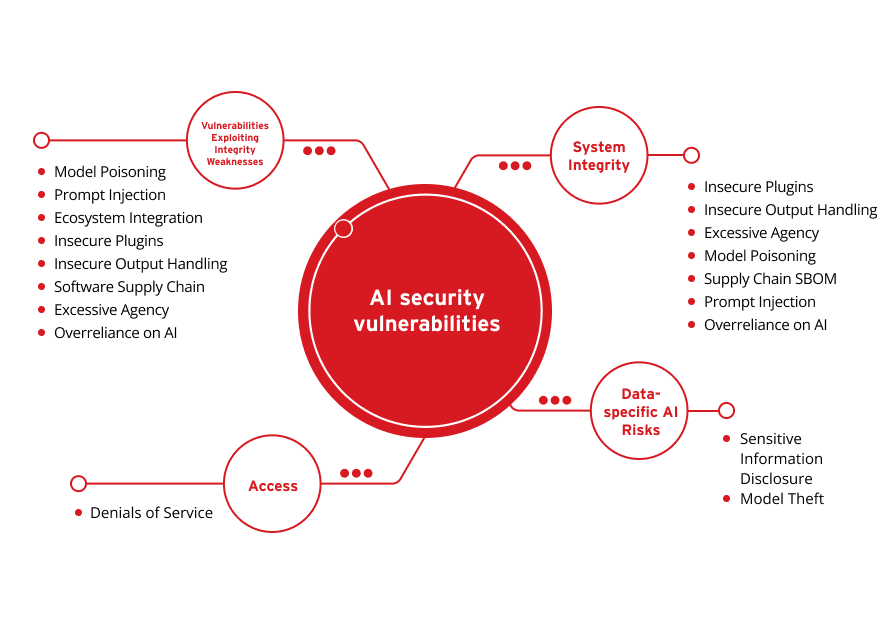

Bu güvenlik açıkları aşağıdaki temel kategorilerde daha da yoğunlaştırılabilir ve basitleştirilebilir:

Veriye Özel Yapay Zeka Riskleri

Sistem Bütünlüğü

Erişim

Güvenlik Açıkları Bütünlük Zayıf Yönlerini Ortaya Çıkarıyor

Hassas Bilgi İfşası

Model Hırsızlığı

Güvensiz Eklentiler

Güvensiz Çıktı İşleme

Aşırı Yetki

Model Zehirlenmesi

Tedarik Zinciri SBOM

İstem Enjeksiyonu

Yapay zekaya aşırı güven

Hizmet Reddi

Model Zehirlenmesi

İstem Enjeksiyonu

Ekosistem Entegrasyonu

Güvensiz Eklentiler

Güvensiz Çıktı İşleme

Yazılım Tedarik Zinciri

Aşırı Yetki

Yapay zekaya aşırı güven

Büyük ölçüde mevcut verilere ve kullanıcı girdisine bağımlı olan yapay zeka, dijital savunmaları ihlal etmek ve hassas bilgileri hortumlamak için tehdit aktörleri tarafından giderek daha fazla hedef alınıyor. Yakın zamanda yapılan bir Gartner® anketinde, 2024'ün ilk çeyreğinde ortaya çıkan en çok alıntı yapılan beş risk ortaya çıktı. Yapay zeka ile ilgili riskler, yapay zeka ile geliştirilmiş kötü niyetli saldırılar ve yapay zeka destekli yanlış bilgilendirme şeklinde ilk iki sırada yer aldı. Gartner'ın belirttiği gibi, yapay zekanın geliştirilmesi “kimlik avı ve sosyal mühendisliği kolaylaştırabilir, bu da daha iyi izinsiz giriş, artan güvenilirlik ve daha zarar verici saldırılara neden oluyor.”

Başı Bozuk Yapay Zeka

Sahte yapay zeka, yapay zekanın kullanıcının hedefiyle uyumlu olmamasıdır. Bu yanlış yönlendirme, uygun korkulukların olmaması gibi kazara olabilir. Kasıtlı da olabilir, bu durumda tehdit aktörleri bir hedefin yapay zeka sistemini veya kullanımını yıkmaya çalışabilir veya bir ortama kötü niyetli olarak hizalanmış yapay zeka modelleri kurmaya çalışabilirler.

Dolandırıcılık otomasyonu

Dolandırıcılık otomasyonu; kimlik avı, iş e- posta gizliliğinin bozulması (BEC) veya deepfake video veya ses yoluyla iş süreçlerini istismar eden metin, ses ve/veya videodan oluşan sentetik içerik oluşturulmasıdır. Dolandırıcılık otomasyonu yapay zeka ile kolayca ölçeklendirilebilir.

Veri yönetişimi

Yapay zeka sistemleri veriye bağımlıdır. Bu nedenle, yapay zeka sistemlerinde kullanılan veriler -ve dokundukları canlı veriler- tüm gizlilik ve adil kullanım düzenlemelerine uygun olmalıdır, dolayısıyla riski en aza indirmeye yardımcı olan proaktif ve etkili veri yönetimine ihtiyaç vardır.

Öğrenme dil modeli (LLM) güvenlik riskleri

LLM'ler, model davranışını manipüle eden hızlı enjeksiyon, gizli verileri açığa çıkaran hassas bilgi ifşası ve aşağı akış sistemlerine saldırılara olanak tanıyan uygunsuz çıktı işleme dahil olmak üzere kritik güvenlik açıklarıyla karşılaşır. Diğer önemli riskler arasında üçüncü taraf bağımlılıklarından tedarik zinciri güvenlik açıkları, gereksiz izinler veren aşırı kurum, model bütünlüğünü tehlikeye atan veri zehirlenmesi ve gizli talimatları açığa çıkaran sistem hızlı sızıntısı yer alır. Ek olarak, vektör yerleştirme zayıflıkları, yanlış bilgi oluşturma ve sınırsız tüketim saldırıları LLM uygulamalarının güvenliğini, güvenilirliğini ve kullanılabilirliğini tehdit eder.

Kullanıcı istemlerini içeren üretken yapay zeka güvenlik riskleri

Üretken Yapay Zeka (GenAI), kullanıcılara yardımcı olmak için mevcut geçmiş ve güncel verileri kullanır. Bu nedenle, komut istemi gerektiren araçlar için, komut istemi alanına ne koyduğunuz konusunda dikkatli ve proaktif olmak en iyisidir. ChatGPT'nin sohbet geçmişini kapatma seçeneği gibi bazı araçlar kullanıcıların veri toplamayı devre dışı bırakmasına izin verir. Söz konusu sektör düzenleyicisi tarafından uygulanan yapay zeka yönetişim ve kullanım politikalarına bağlı olarak, önleyici tedbirler ve/veya bunun gibi davranışlar uyumluluğun sürdürülmesi için bir gereklilik olabilir.

Finansal bilgiler, henüz yayınlanmamış yazılımlara ilişkin gizli bilgiler, kişisel adresler ve iletişim bilgileri gibi kişisel tanımlayıcı bilgiler (PII) ve/veya diğer hassas verilerin eklenmesi, bu bilgilerin yapay zeka uygulaması tarafından serbestçe erişilebilir olduğu anlamına gelir. Bu veriler manipüle edilme, benzer sorgulara yanıt olarak araçtan gelen önerilerde başkalarıyla paylaşılma ve/veya yapay zekanın koruma önlemleri ihlal edilirse tehdit aktörleri tarafından çalınma riski altındadır. Bu durum, özellikle fikir üretmeye yardımcı olmak veya büyük miktarda veriyi hızlı bir şekilde derlemek için üretken yapay zeka araçları kullanıldığında, özellikle de yetersiz şifreleme ve güvenlik önlemleri mevcut değilse bir risktir.

ChatGPT güvenlik riskleri

Kullanıcı istemlerine metin tabanlı yanıtlar veren bir tür üretici yapay zeka olan ChatGPT, kimlik avı girişimlerini gizlemeye ve/veya güçlendirmeye yardımcı olmak için tehdit aktörleri tarafından manipüle edilebilir. Alternatif olarak, platformun kendisi kullanıcı verilerine erişmek ve potansiyel olarak kötüye kullanmak için hedef alınabilir. Bu, hedeflenen kurum veya kişinin yazı örneklerinden yararlanarak kimlik avı e-postaları hazırlamanın yanı sıra daha ikna edici görünmek için yazım hatalarını, dilbilgisini ve dili düzeltmeyi de içerebilir. Ayrıca, hızlı enjeksiyon veya jailbreak yoluyla kullanıcı verilerinin çalınması ve/veya ihlal edilmesi riski de vardır.

Doğrudan tehdit aktörlerini içermeyen kullanımdan kaynaklanan güvenlik riskleri de vardır. Örneğin, ChatGPT'nin sizden aldığı bilgiler LLM'leri eğitmek için kullanılabilir. ChatGPT MacOS uygulamasının başlangıçta düz metin olarak saklanan kullanıcı sohbetleriyle başlatılmasının gösterdiği gibi, yetersiz veri şifreleme riski de vardır.

OpenAI güvenlik riskleri

OpenAI API'nin kendisi siber suçlular tarafından hedef alınma potansiyeline sahiptir. SOC 2 ile uyumlu olmasına ve düzenli sızma testlerinden geçmesine rağmen, siber tehditler sürekli geliştiğinden riskiniz asla tamamen ortadan kalkmaz. Yakın zamanda yayınlanan bir Soft Kraft makalesi, OpenAI veri güvenliği risklerini kapsamlı bir şekilde inceleyerek, özellikle ilgilenilenleri kurumsal kullanıcılara açıklıyor:

- ChatGPT konuşma verileri modelin yeniden eğitilmesi amacıyla kullanılabilir

- API aracılığıyla gönderilen veriler dahili ve harici olarak ifşa edilebilir

- Genel Veri Koruma Yönetmeliği (GDPR) uyumluluğunu sağlamak zor olabilir

- Üçüncü taraf alt işleyicilerin kullanımı konum ve veri işlemeyi zorlaştırır

Microsoft Copilot Yapay Zeka güvenlik riskleri

Microsoft 365 uygulamalarını destekleyen Microsoft Copilot Yapay Zeka, kullanıcılar tarafından kolayca kullanılabilir. Ayrıca, donanım düzeyinde, en yeni Copilot+ markalı bilgisayarlar, daha da hızlı kullanıcı girişini teşvik etmek için özel fiziksel Copilot tuşlarıyla birlikte gönderilir. Bu kolaylaştırılmış erişim önlemleri, tıpkı diğer üretici yapay zeka araçlarında olduğu gibi, hassas bilgilerin Copilot'un kullanımına sunulması durumunda güvenlik riskleri doğurabilir. İzinlerin doğru şekilde ayarlanmaması veya yapay zeka tarafından oluşturulan belgelerde uygun gizlilik ayarlarının etkinleştirilmemesi durumunda, kendinizi gizli veri sızıntıları ve/veya ihlalleri ile karşı karşıya bulabilirsiniz. Aynı durum kullanıcı erişim yönetimi için de geçerlidir. Son olarak, platformun kendisine yönelik saldırılar, tehdit aktörlerinin verilerinize nasıl eriştiğini ve paylaştığını değiştirmesini sağlayabilir.

Yapay zeka güvenlik risklerimizi yönetmemize kimler yardımcı olabilir?

Yapay zeka inovasyonunun sürekli evrimi, proaktif olan ve 35 yıllık sektör lideri tehdit istihbaratı, 20 yıllık öncü yapay zeka geliştirme ve benzersiz güvenlik açığı koruması yani Trend Vision One™ AI Security ile desteklenen güvenliği gerektirir.

Yapay Zeka Güvenliği çözümümüzle, tüm yapay zeka yığınınız da dahil olmak üzere kritik iş yüklerinizi korurken genel güvenlik duruşunuzu iyileştiriyoruz. Trend Cybertron tarafından desteklenen yapay zeka tabanlı güvenlik çözümümüz, saldırı yollarını öngörüp anormallikleri tespit ederken, aynı zamanda deepfake ve yapay zeka tarafından oluşturulan tehditlere karşı koruma sağlar. Güvenlikteki kör noktaları ortadan kaldırarak, yapay zeka güvenliğini savunmadan çıkarıp inovasyonun itici gücüne dönüştürür.

İlgili Makaleler

2025 Yılı için Büyük Dil Modelleri (LLM) ve Üretici Yapay Zeka Uygulamaları İçin En İyi 10 Risk Azaltma Önlemi

Yükselen Riskleri Kamu Güvenliğine Göre Yönetme

Uluslararası Standartlar Bizi Ne Kadar Uzaka Götürebilir?

Üretken Bir Yapay Zeka Siber Güvenlik Politikası Nasıl Yazılır

En Önemli Riskler Arasında Yapay Zeka ile Geliştirilmiş Kötü Amaçlı Saldırılar

Deepfake Kimliklerin Artan Tehdidi