A segurança em IA refere-se tanto às ferramentas, tecnologias e medidas de segurança que as organizações usam para proteger sua pilha de IA, quanto ao uso da IA para aumentar os sistemas de segurança cibernética, melhorando a detecção de vulnerabilidades, correlações e ações de resposta, transformando suas operações de segurança de uma postura reativa para uma postura proativa.

Índice

O termo “inteligência artificial” (IA) foi cunhado pela primeira vez na década de 1950 para descrever computadores e máquinas que imitam a estrutura e função do cérebro humano para realizar tarefas complexas, resolver problemas, prever resultados futuros e aprender com a experiência.

A segurança em IA (também chamada de segurança de inteligência artificial ou “security for AI”) é um ramo da Cibersegurança que abrange todos os processos, práticas e medidas que as organizações utilizam para proteger suas pilhas de IA e resguardar seus sistemas de inteligência artificial, dados e aplicações contra ameaças potenciais. Isso inclui o uso das seguintes ferramentas e tecnologias de IA para:

- Proteger todos os aspectos da rede de IA de uma organização, desde Endpoints até modelos de IA

- Proteger modelos de IA, sistemas e aplicações contra uma ampla gama de ameaças cibernéticas, crimes cibernéticos e ataques cibernéticos

- Identificar e mitigar quaisquer lacunas ou vulnerabilidades na segurança em IA e nas defesas de Cibersegurança antes que possam ser exploradas

- Proteger a infraestrutura de IA e os dados de treinamento para evitar corrupção, envenenamento ou roubo de dados dos modelos de IA

- Garantir a qualidade e a integridade dos dados de todos os grandes modelos de linguagem (LLMs), IA generativa (GenAI) e pipelines de machine learning (ML)

- Abordar questões e preocupações éticas potenciais envolvendo viés, transparência, privacidade de dados e explicabilidade

- Garantir que todo uso, dados e desenvolvimento de IA estejam totalmente em conformidade com as leis relevantes, políticas da empresa e regulamentos da indústria

Segurança em IA versus Cibersegurança de IA

Embora os dois termos pareçam quase idênticos, existe uma diferença essencial entre segurança em IA e Cibersegurança de IA.

A segurança em IA trata da própria IA — protegendo a pilha de IA de uma organização e garantindo a segurança de seus sistemas, componentes, redes e aplicações de IA.

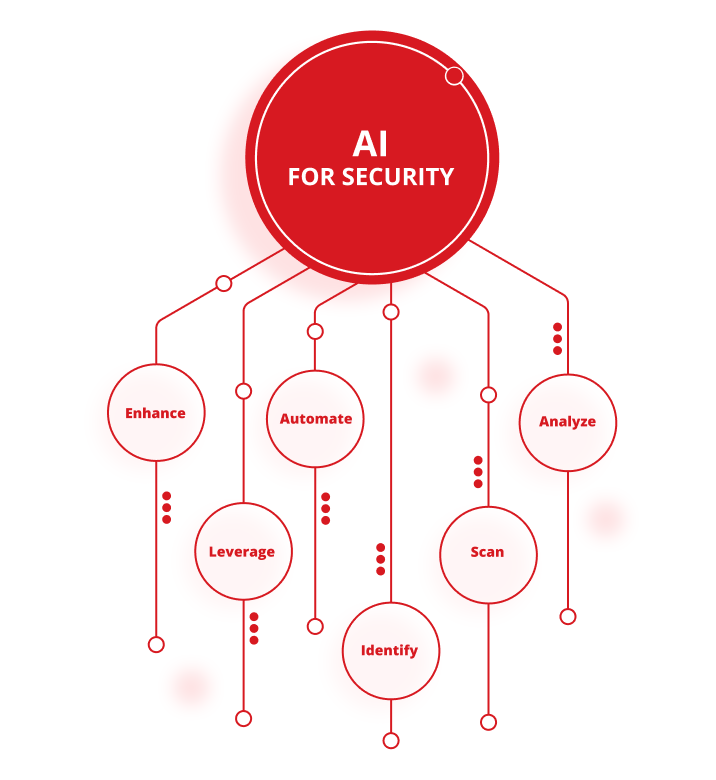

A Cibersegurança de IA (também chamada de “IA para segurança”) trata do uso de ferramentas e tecnologias de IA para proteger infraestruturas de TI contra crimes cibernéticos, ataques cibernéticos e outras ameaças cibernéticas. Isso inclui o uso de IA para:

- Analisar grandes volumes de dados para detectar padrões, identificar anomalias e destacar riscos de segurança cibernética

- Buscar e eliminar lacunas e vulnerabilidades nas defesas de Cibersegurança de uma organização

- Identificar e defender contra vazamentos de dados e outras ameaças cibernéticas em tempo real

- Automatizar o monitoramento e resposta a incidentes para reduzir a carga das equipes de segurança e melhorar a velocidade e precisão das respostas a ameaças

- Utilizar as últimas informações sobre ameaças para se antecipar aos maus atores e acompanhar novos ou emergentes vetores de ataque

- Melhorar a estratégia e os recursos gerais de gerenciamento de ameaças de uma organização

A importância de proteger os sistemas de IA

Embora a inteligência artificial exista há décadas, os avanços recentes em tecnologia de IA transformaram indústrias que vão do transporte à saúde e à Cibersegurança. Infelizmente, o uso generalizado da IA também capacitou agentes maliciosos a explorá-la, levando a um aumento significativo no número, alcance e sofisticação dos ataques cibernéticos.

Como resultado, as organizações precisam garantir que estão fazendo tudo ao seu alcance para manter a integridade, confidencialidade e disponibilidade de seus dados de IA, proteger suas ferramentas e aplicações de IA contra riscos e ataques cibernéticos novos e emergentes, e proteger seus modelos, sistemas e algoritmos de IA contra uma ampla variedade de ameaças cibernéticas em constante evolução.

O fracasso em proteger e assegurar sistemas de IA contra qualquer uma dessas ameaças pode potencialmente abrir uma organização a ataques, colocar seus clientes e parceiros em risco, e acabar custando milhões de dólares em remediações, demandas por resgates, perdas de dados, vendas perdidas e perda de produtividade.

Quais são os riscos para a IA?

O potencial da inteligência artificial para revolucionar o campo da Cibersegurança é claramente promissor. Mas há um número crescente de riscos à segurança da IA que as organizações precisam considerar ao implementar uma estratégia eficaz de segurança de IA. Isso inclui:

- Risco de uma superfície de ataque aumentada— Integrar proativamente modelos de terceiros de IA na infraestrutura de TI de uma organização pode expandir dramaticamente sua superfície de ataque, aumentar o número de pontos fracos que agentes maliciosos podem explorar, e deixar os sistemas de IA vulneráveis a ataques cibernéticos mais poderosos ou frequentes.

- Risco de ataques maliciosos ou adversariais a dados e algoritmos de IA— Agentes maliciosos podem obter acesso não autorizado a ferramentas e dados de IA, manipular dados e algoritmos de IA para inserir lacunas ou distorções, comprometer a capacidade dos modelos de IA de fazer previsões precisas ou se defender contra ataques futuros, além de manipular, abusar ou roubar modelos e algoritmos de IA.

- Risco de envenenamento, corrupção e manipulação de dados— Cibercriminosos podem corromper pipelines de machine learning (ML), envenenar modelos de IA deliberadamente alterando seus dados de entrada ou inserindo novos dados com o objetivo de comprometer modelos e sistemas de IA.

- Riscos para modelos de treinamento de IA— Cibercriminosos podem roubar, manipular ou fazer engenharia reversa em modelos de treinamento de IA proprietários. Eles também podem interromper, violar ou adulterar os dados usados para desenvolver e treinar modelos de IA para comprometer sua precisão, eficácia e integridade.

- Risco de preconceito, discriminação, privacidade de dados e falta de transparência— Erros humanos e ataques cibernéticos podem aumentar preocupações com privacidade de dados e viés em modelos de IA e potencialmente comprometer princípios de transparência, equidade e responsabilidade.

- Risco de não conformidade com regulamentações da indústria e do governo— O fracasso em proteger informações sensíveis, pessoais ou confidenciais pode resultar em multas pesadas e acusações de não conformidade tanto de reguladores governamentais quanto da indústria, incluindo o Regulamento Geral de Proteção de Dados (GDPR).

- Risco de ataques em fornecedores de terceiros— Agentes maliciosos podem atacar sistemas de IA em qualquer lugar da cadeia de suprimentos de uma organização para explorar fraquezas em redes, componentes, frameworks e bibliotecas de software de parceiros de terceiros, e depois usar essas vulnerabilidades para atingir outros modelos de IA em qualquer lugar da cadeia.

- Risco de degradação e deterioração do modelo de IA— Com o tempo, todos os modelos de IA podem ser vulneráveis à deterioração ou degradação. Agentes maliciosos podem explorar modelos de IA degradados ou desviantes para alterar seu comportamento ou comprometer sua precisão e confiabilidade.

- Risco de roubo de credenciais de chatbot— Cibercriminosos podem roubar credenciais para provedores de IA como ChatGPT ou comprar credenciais roubadas na dark web e usá-las para obter acesso ilegal a ferramentas e sistemas de IA proprietários.

- Risco de deepfakes em fotos, vídeos e áudio— Agentes maliciosos podem usar imagens e vídeos gerados por IA deepfake para desinformar organizações, extorquir indivíduos ou empresas, enganar funcionários para obter acesso a sistemas críticos, divulgar informações confidenciais ou roubar dados valiosos.

- Risco de ataques diretos e indiretos baseados em engenharia social— Ataques de prompt injection podem usar código malicioso para enganar modelos de linguagem de grande porte (LLMs) e outras ferramentas de IA para vazarem informações confidenciais, permitir acesso não autorizado ou excluir documentos importantes.

- Risco de abuso de IA com alucinação— Agentes maliciosos podem tirar vantagem de “alucinações” de IA para comprometer intencionalmente os modelos de IA e as decisões que eles tomam.

- Riscos para aplicações em nuvem e infraestrutura— Cibercriminosos podem invadir modelos de IA baseados em nuvem e corromper ou roubar seus dados e outros ativos.

Se as organizações não protegerem sua segurança de IA de forma abrangente e tão rapidamente quanto possível, agentes maliciosos podem explorar essas e outras falhas para minar a eficácia e confiabilidade de todos os modelos de IA, roubar dados e causar impactos financeiros e de reputação significativos.

Quais são os benefícios da segurança da IA?

As organizações que implementam medidas de segurança da IA para proteger suas pilhas de IA se beneficiam de uma série de vantagens convincentes. Estas incluem capacidades aprimoradas para:

- Proteger seus dados de IA contra exposição, corrupção, manipulação, roubo ou violação.

- Proteger modelos de IA contra hacks ou ciberataques executando detecção e resposta a ameaças em tempo real, caça a ameaças e ferramentas e tecnologias de varredura de vulnerabilidades

- Proteger infraestruturas de IA eliminando proativamente lacunas ou vulnerabilidades nas defesas cibernéticas, gerenciando e mitigando riscos cibernéticos e protegendo todos os ativos de IA

- Proteger todos os usuários e aplicações locais de IA contra ataques de código malicioso, acesso ilegal ou não autorizado, fraude e esquemas de phishing, e ataques de malware e ransomware

- Controlar o acesso a serviços e aplicações de IA, incluindo aplicações de large language model (LLM)

- Defender contra ataques de zero-day que visam vulnerabilidades de software ou hardware previamente desconhecidas para permitir que agentes maliciosos roubem dados, violem informações confidenciais, instalem malware e outros vírus ou obtenham acesso à infraestrutura de TI de uma organização

Melhores práticas para segurança de IA

As soluções de segurança de IA mais eficazes seguem diversas melhores práticas reconhecidas pelo setor para proteger todas as ferramentas e recursos de IA e melhorar sua postura de segurança. Essas práticas incluem:

- Desenvolver uma estratégia abrangente de segurança de IA que combine modelagem avançada de ameaças e caça a ameaças com avaliações de risco baseadas em IA, controles abrangentes de segurança de IA e planos e procedimentos detalhados de resposta a incidentes para proteger os sistemas e dados de uma organização.

- Garantir a qualidade, integridade e confiabilidade dos dados de treinamento de IA para abordar questões relacionadas à transparência, viés e explicabilidade, e garantir que os modelos de IA sejam tão precisos e eficazes quanto possível.

- Implementar frameworks de segurança de IA reconhecidos pelo setor para estabelecer um conjunto claro de padrões e diretrizes para proteger sistemas de IA, eliminar quaisquer lacunas ou vulnerabilidades nas defesas de IA e manter conformidade com todas as regulamentações relevantes de segurança de IA. Isso inclui a integração de frameworks de segurança como o National Institute of Standards and Technology (NIST), Artificial Intelligence Risk Management framework, MITRE Adversarial Threat Landscape for Artificial-Intelligence Systems (ATLAS) matrix and Sensible Regulatory Framework for AI Security, the Open Worldwide Application Security Project (OWASP) list of lista do Top 10 Best Practices for Large Language Model (LLM) Applications, Google’s Secure AI Framework (SAIF), e os padrões ISO/IEC 27001 para sistemas de gestão de segurança da informação (ISMS).

- Integrar a segurança de IA com medidas existentes de segurança e Cibersegurança para criar proteção integrada de ponta a ponta contra ameaças cibernéticas para todas as aplicações, ferramentas, sistemas e redes de IA e TI.

- Realizar regularmente programas de treinamento e conscientização com funcionários para aumentar a conscientização sobre as ameaças e medidas de segurança mais recentes entre equipes de Cibersegurança e outros colaboradores e fomentar uma cultura corporativa baseada em melhoria contínua.

- Monitorar, avaliar e atualizar continuamente todos os modelos de IA para identificar e mitigar vulnerabilidades em ferramentas e sistemas de IA, identificar ameaças emergentes conforme surgem e constantemente refinar modelos e aplicações de IA para melhorar sua precisão, desempenho e confiabilidade.

Exemplos de aplicações da Cibersegurança em IA

À medida que as ferramentas de inteligência artificial se tornam mais avançadas, o potencial de uso e as aplicações da IA na Cibersegurança também se expandem quase diariamente.

Entre outros benefícios, aplicações de Cibersegurança impulsionadas por IA podem aumentar significativamente o alcance e a eficácia das defesas de Cibersegurança de uma organização ao automatizar suas atividades de detecção de ameaças e resposta a incidentes, realizar varreduras de vulnerabilidades e outras medidas proativas de forma regular ou contínua, e utilizar as mais recentes inteligências de ameaças e análises de segurança para prever, antecipar e proteger as organizações contra ameaças cibernéticas novas e emergentes.

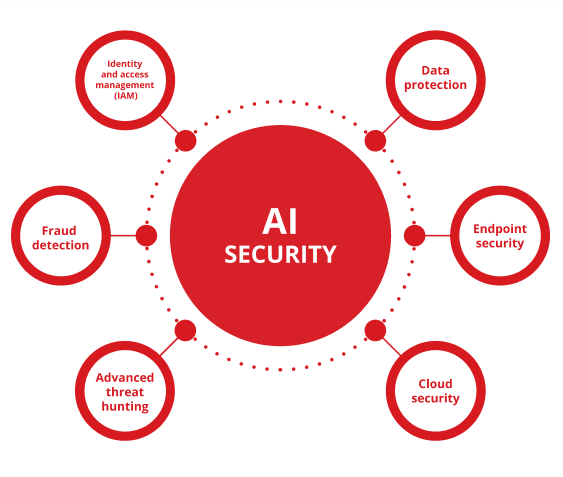

Algumas das aplicações mais eficazes e amplamente adotadas da Cibersegurança com IA incluem o uso de inteligência artificial na proteção de dados, Endpoint Protection, segurança em nuvem, caça a ameaças avançadas, detecção de ameaças, e gerenciamento de identidade e acesso (IAM).

- Proteção de dados

As organizações podem usar IA para classificar e criptografar proativamente informações confidenciais, monitorar o acesso aos sistemas para detectar violações de dados com mais rapidez e precisão, proteger a IA contra perda ou corrupção de dados e proteger sua pilha de segurança de IA contra acesso, uso ou divulgação não autorizados. No entanto, pontos cegos de informação sensível em ambientes de IA podem causar violações graves de dados e problemas de compliance, tornando crucial identificar e mitigar essas vulnerabilidades de forma proativa.

- Segurança de Endpoints

Soluções de detecção e resposta de endpoint (EDR) habilitadas por IA protegem laptops, desktops, servidores, dispositivos móveis e outros Endpoints de rede em tempo real, detectando e bloqueando proativamente malware, ransomware e outros ataques cibernéticos antes que ocorram.

- Segurança em nuvem

Tecnologias de segurança em nuvem com IA podem monitorar e controlar continuamente os ambientes de nuvem, identificar quaisquer anomalias ou atividades suspeitas, alertar as equipes de segurança sobre ameaças potenciais assim que elas acontecem, e proteger aplicações baseadas em nuvem contra acesso não autorizado e violações de dados.

- Advanced threat hunting

Ferramentas de caça a ameaças com IA avançada podem classificar e analisar rapidamente grandes volumes de dados, padrões de tráfego de rede e atividades e comportamentos dos usuários para identificar ataques maliciosos, capturar agentes cibernéticos em ação antes que causem danos duradouros e proteger sistemas e infraestrutura de IA contra ameaças persistentes avançadas (APTs) e outros ciberataques.

- Detecção de fraudes

As organizações nos setores bancário e de serviços financeiros podem usar algoritmos de machine learning (ML), redes neurais e outras tecnologias avançadas de IA para detectar atividades fraudulentas em potencial, bloquear acesso não autorizado a contas bancárias ou on-line e prevenir roubo de identidade em transações financeiras e de comércio eletrônico.

- Gerenciamento de identidade e acesso (IAM)

Soluções de IAM habilitadas por IA podem ajudar as organizações a monitorar e proteger cada etapa dos seus processos de autenticação, autorização e gerenciamento de acesso para garantir que sigam todas as políticas e playbooks de IA da empresa, manter a conformidade com regulamentações do setor, prevenir o acesso não autorizado a dados sensíveis e manter invasores fora de seus sistemas.

Onde posso obter ajuda com a segurança de IA?

O The Trend Vision One™ é uma plataforma de Cibersegurança com IA tudo-em-um.

Trend Vision One apresenta um conjunto poderoso de ferramentas de IA líderes do setor que podem detectar, prever e prevenir ameaças cibernéticas de forma muito mais rápida e eficaz do que equipes tradicionais de segurança lideradas por humanos. Alcançar uma pilha de segurança de IA eficaz requer proteção de dados desde a infraestrutura até os usuários, garantindo visibilidade em implantações ocultas de IA, impondo controles de acesso rigorosos e estabelecendo guardrails contra uso indevido e envenenamento de modelos. Esses recursos permitem que as organizações protejam sua pilha de segurança de IA, dados, aplicações e sistemas contra a grande maioria dos ciberataques antes que ocorram.

Trend Vision One também inclui o Threat Intelligence AI alimentado por machine learning proprietário da Trend Cybertron: a primeira IA de Cibersegurança verdadeiramente proativa do mundo. Baseando-se na coleção incomparável de dados da Trend Micro sobre aplicações de large language models (LLM), agentes avançados e mais de 20 anos de investimento no campo da segurança de IA, o Trend Cybertron pode analisar padrões históricos e dados em tempo real para prever as necessidades de cada cliente, habilitar as organizações a acelerar os tempos de remediação em até 99% em relação às equipes de segurança tradicionais e transformar a pilha de segurança de uma organização de reativa para proativa praticamente da noite para o dia.

Trend Vision One também foi projetado para monitorar continuamente mudanças no ambiente de rede de uma organização e se manter atualizado com as mais recentes táticas, técnicas e procedimentos (TTPs) empregados por agentes cibernéticos. As soluções de IA da Trend garantem que tanto sua pilha de segurança de IA quanto suas defesas de Cibersegurança estejam sempre tão robustas, completas e atualizadas quanto possível.

Michael Habibi é um líder de Cibersegurança com mais de 12 anos de experiência, especializado em desenvolvimento de produto e inovação estratégica. Como Vice-Presidente de Gerenciamento de Produto na Trend Micro, Michael conduz o alinhamento da estratégia de produto de Endpoint com o cenário em rápida evolução.

Perguntas Frequentes (FAQs)

O que é segurança de IA?

Segurança para IA (ou “segurança de IA”) é o uso de diferentes ferramentas, práticas e tecnologias para proteger a pilha de IA de uma organização.

Qual é o significado de IA em segurança?

IA se refere à “inteligência artificial.” A IA é usada em segurança para melhorar as defesas de cibersegurança de uma organização e proteger pilhas de IA.

Como a IA pode ser usada em segurança?

Ela pode ser usada para proteger redes de IA, modelos, sistemas, Endpoints e aplicações contra ciberataques, corrupção de dados e outras ameaças.

O que é IA em cibersegurança?

Em cibersegurança, IA se refere ao uso de ferramentas e tecnologias de IA para ajudar a proteger organizações contra ciberataques.

A IA é um risco de segurança?

Como qualquer tecnologia, a IA pode ser usada tanto para melhorar medidas de segurança quanto para lançar ciberataques mais poderosos.

Segurança de IA é uma boa carreira?

A segurança de IA é um campo em crescimento que oferece inúmeras oportunidades de carreira desafiadoras e bem remuneradas.

Quanto ganham os oficiais de segurança de IA?

Dependendo da experiência e localização, oficiais de segurança de IA podem ganhar de US$ 60.000 a mais de US$ 120.000 por ano.

Como eu entro na segurança de IA?

Cursos on-line, diplomas em ciência da computação ou cibersegurança e certificações em segurança de IA são todos bons pontos de partida para uma carreira em segurança de IA.

Qual é a diferença entre cibersegurança e segurança de IA?

Cibersegurança se refere a ferramentas ou sistemas que protegem organizações contra ciberataques. A segurança de IA é sobre proteger a pilha de IA de uma organização.

A IA pode fazer cibersegurança?

Sob supervisão humana, tecnologias de IA podem melhorar drasticamente a velocidade, precisão e eficácia de quase todos os aspectos da cibersegurança.

Qual é a diferença entre cibersegurança tradicional e cibersegurança com IA?

Embora seus objetivos e métodos sejam os mesmos, a cibersegurança com IA pode fornecer proteção mais rápida, precisa e proativa do que a cibersegurança tradicional.

A cibersegurança exige programação?

Embora programação possa ser uma habilidade valiosa para muitos empregos em cibersegurança, há inúmeras posições em cibersegurança que não exigem nenhuma experiência ou conhecimento em programação.

Por que a IA é uma ameaça à segurança?

A IA pode ser usada por agentes mal-intencionados para invadir sistemas de TI, roubar dados confidenciais, corromper pilhas de IA ou lançar ciberataques sofisticados.

Qual é um exemplo de um vazamento de dados de IA?

Deepfakes de IA têm sido usados para simular vozes ou imagens de vídeo de pessoas reais, convencendo funcionários de organizações a compartilhar informações confidenciais que deveriam ter permanecido privadas.

O aplicativo de segurança de IA é seguro?

Em última análise, a segurança de um aplicativo depende da confiabilidade de seu desenvolvedor, não de seu preço. Mantenha-se fiel a marcas grandes, testadas de forma independente e evite aplicativos de fontes desconhecidas.

Quais são os riscos de segurança com a IA?

Alguns riscos comuns associados à segurança de IA incluem superfícies de ataque expandidas, envenenamento e corrupção de dados e riscos para dados de IA, algoritmos e modelos de treinamento.

Meu sistema está em alto risco?

As organizações podem reduzir riscos para sistemas de IA analisando suas defesas atuais, seguindo as melhores práticas da indústria e implementando estratégias abrangentes de segurança e cibersegurança de IA.

Devo confiar em um detector de IA?

Embora detectores de IA possam ser ferramentas eficazes, eles também podem cometer erros. Portanto, seus resultados devem ser usados apenas como um sinal preliminar para promover investigação adicional, que deve se basear no julgamento humano.

Como ter cuidado com a IA?

Uma abordagem verdadeiramente cuidadosa da IA exige ações diferentes de usuários e criadores. Quer você esteja usando ou construindo, a regra fundamental é tratar a IA como uma ferramenta poderosa, mas imperfeita — não um especialista infalível ou um confidente seguro.

Como eu protejo a IA?

Uma postura de segurança abrangente para a pilha de IA não deixa lacunas, aplicando proteção em todos os componentes — desde os usuários e os dados que eles geram até os modelos, microsserviços e a infraestrutura subjacente.

Artigos Relacionados

As 10 Principais Ameaças & Mitigações para LLMs e Aplicativos GenAI em 2025

Gerenciando riscos emergentes à segurança pública

Até Onde os Padrões Internacionais Podem Nos Levar?

Como escrever uma política de Cibersegurança para IA generativa

Ataques maliciosos aprimorados por IA entre os principais riscos

Ameaça crescente de identidades deepfake