AI 기술을 구현하면 기존 컴퓨팅 환경에 존재하지 않았던 새로운 취약점이 발생합니다. 여기에는 위협 범죄자가 시작한 악성 사이버 공격과 플랫폼 및 사용자 행동에서 기인하는 취약점이 포함됩니다.

목차

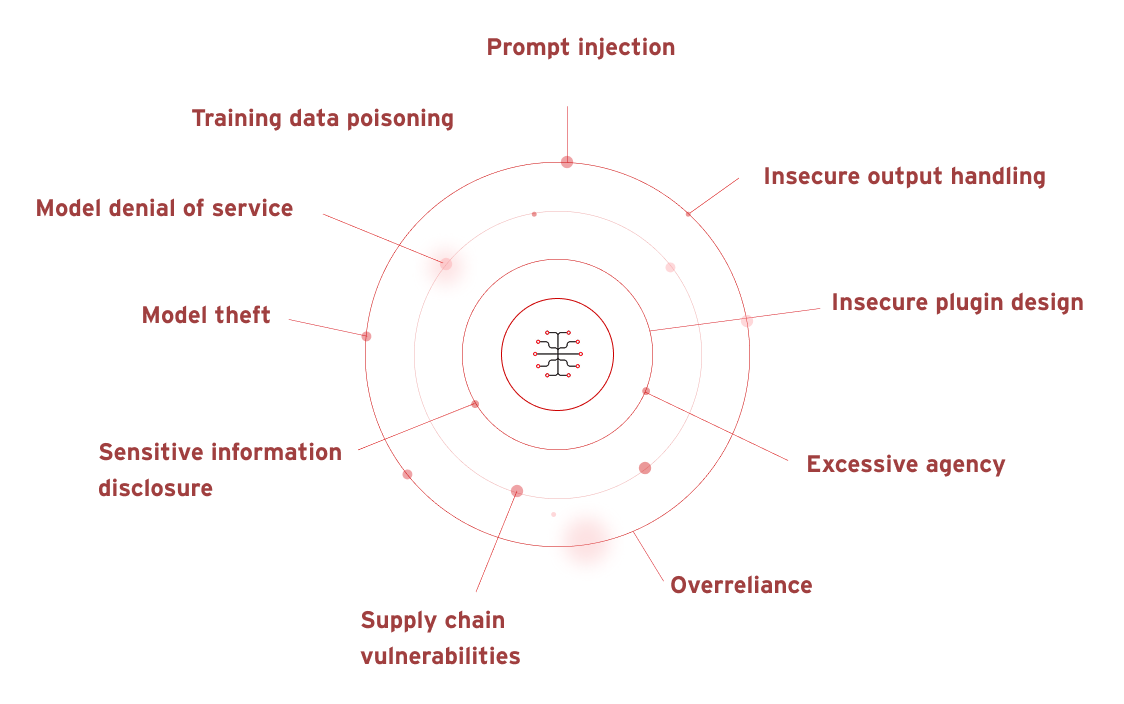

AI 보안 취약점

OWASP(Open Worldwide Application Security Project)는 학습 언어 모델(LLM) 및 GenAI에 구축된 인공 지능(AI)과 관련된 일련의 취약점을 식별했습니다. 여기에는 다음이 포함됩니다.

- 신속한 주입

- 안전하지 않은 출력 처리

- 교육 데이터 중독

- 모델 서비스 거부

- 공급망 취약점

- 민감한 정보 공개

- 안전하지 않은 플러그인 설계

- 과도한 기관

- 과신

- 모델 도난

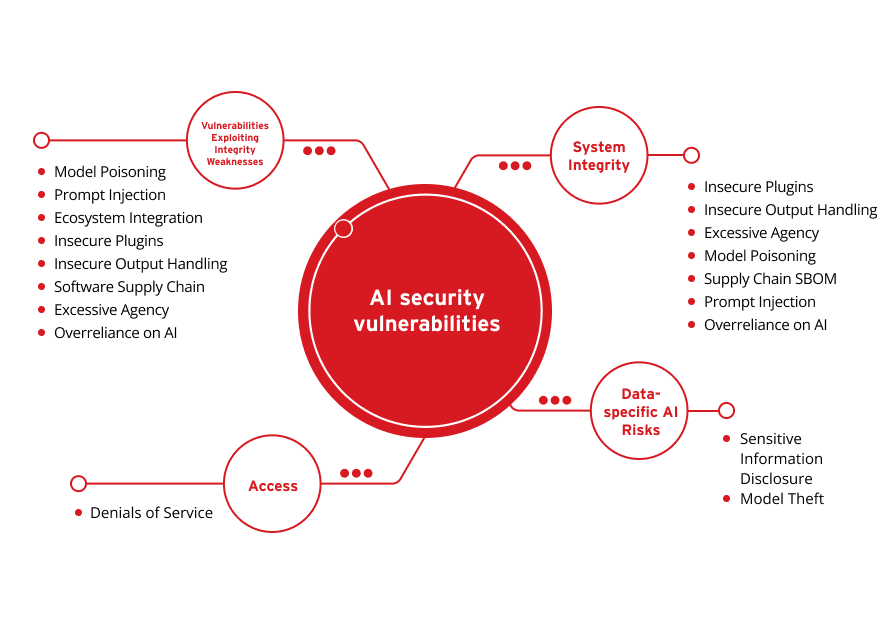

이러한 취약점은 다음과 같은 핵심 범주로 더욱 요약되고 단순화될 수 있습니다.

데이터별 AI 위험

시스템 무결성

액세스

취약점 도덕성 활용 약점

민감한 정보 공개

모델 도난

안전하지 않은 플러그인

안전하지 않은 출력 처리

과도한 기관

모델 중독

공급망 SBOM

신속한 주입

AI에 대한 과신

서비스 거부

모델 중독

신속한 주입

생태계 통합

안전하지 않은 플러그인

안전하지 않은 출력 처리

소프트웨어 공급망

과도한 기관

AI에 대한 과신

사용 가능한 데이터와 사용자 입력에 크게 의존하는 AI는 점점 더 위협 범죄자가 디지털 방어 및 사이펀 민감 정보를 침해하도록 표적으로 삼고 있습니다. 최근 Gartner® 설문조사에서 2024년 Q1에 가장 많이 인용된 다섯 가지 새로운 위험이 드러났습니다. AI 관련 위험은 AI 강화 악성 공격과 AI 지원 잘못된 정보 형태로 상위 두 곳을 차지했습니다. Gartner가 언급한 바와 같이, AI 향상은 “피싱 및 소셜 엔지니어링을 촉진하여 더 나은 침입, 더 높은 신뢰성 및 더 많은 피해를 주는 공격을 가능하게 합니다.”

Rogue AI

Rogue AI는 AI가 사용자의 목표에 맞지 않는 경우입니다. 이러한 오정렬은 적절한 가드레일의 고장과 같이 우발적일 수 있습니다. 또한 의도적일 수 있으며, 이 경우 위협 행위자는 표적의 AI 시스템 또는 사용을 반전시키려거나 환경 내에 악의적으로 정렬된 AI 모델을 설치하려고 시도할 수 있습니다.

사기 자동화

사기 자동화는 피싱, 비즈니스 이메일 손상(BEC) 또는 딥페이크 비디오 또는 오디오를 통해 비즈니스 프로세스를 활용하는 텍스트, 오디오 및/또는 비디오의 합성 콘텐츠 생성입니다. 사기 자동화는 AI로 쉽게 확장할 수 있습니다.

데이터 거버넌스

AI 시스템은 데이터에 의존합니다. 따라서 AI 시스템에 사용되는 데이터와 AI 시스템이 접촉하는 실시간 데이터는 모든 개인정보 보호 및 공정 사용 규정을 준수해야 하므로 위험을 최소화하는 데 도움이 되는 선제적이고 효과적인 데이터 거버넌스가 필요합니다.

학습 언어 모델(LLM) 보안 위험

LLM은 모델 동작을 조작하는 신속한 주입, 기밀 데이터를 노출하는 민감한 정보 공개, 다운스트림 시스템에 대한 공격을 가능하게 하는 부적절한 출력 처리를 포함한 중요한 취약점에 직면합니다. 다른 주요 위험에는 제3자 의존성으로 인한 공급망 취약점, 불필요한 권한을 부여하는 과도한 기관, 모델 무결성을 손상시키는 데이터 중독 및 기밀 지침을 노출시키는 시스템 프롬프트 누출이 포함됩니다. 또한 취약점, 잘못된 정보 생성 및 미결합 소비 공격을 포함하는 벡터는 LLM 애플리케이션의 보안, 신뢰성 및 가용성을 위협합니다.

사용자 프롬프트와 관련된 생성형 AI 보안 위험

Generative AI(GenAI)는 사용 가능한 과거 및 현재 데이터를 사용하여 사용자를 지원합니다. 따라서 프롬프트가 필요한 도구의 경우 프롬프트 필드에 입력하는 내용에 대해 주의하고 선제적으로 생각하는 것이 가장 좋습니다. 일부 도구는 사용자가 채팅 기록을 끄는 ChatGPT 옵션과 같은 데이터 수집을 거부할 수 있도록 합니다. 해당 산업 규제 기관이 시행하는 AI 거버넌스 및 사용 정책에 따라, 이러한 예방 조치 및/또는 행동은 규정 준수를 유지하기 위한 요구 사항이 될 수 있습니다.

아직 출시되지 않은 소프트웨어의 재무 정보, 기밀 세부 정보, 개인 주소 및 연락처 세부 정보와 같은 개인 식별 정보(PII) 및/또는 기타 민감한 데이터를 삽입하는 것은 AI 애플리케이션에서 자유롭게 액세스할 수 있는 정보를 의미합니다. 이 데이터는 조작되거나 유사한 쿼리에 대한 대응으로 툴의 권장 사항에서 다른 사람과 공유되거나 AI의 보호 조치가 침해될 경우 위협 행위자가 도난당할 위험이 있습니다. 이는 아이디어 구상을 지원하거나 대량의 데이터를 신속하게 컴파일하기 위해 생성적 AI 도구를 사용할 때 특히 위험합니다. 특히 암호화 및 보안 조치가 충분하지 않은 경우 더욱 그렇습니다.

ChatGPT 보안 위험

사용자 프롬프트에 텍스트 기반 응답을 제공하는 생성적 AI의 한 형태로, ChatGPT는 위협 행위자가 피싱 시도를 위장 및/또는 강화하는 데 도움을 주기 위해 조작할 수 있습니다. 또는 플랫폼 자체가 사용자 데이터에 액세스하고 잠재적으로 오용하도록 표적이 될 수 있습니다. 여기에는 대상 조직 또는 개인의 샘플을 작성하여 피싱 이메일 초안을 작성하는 것뿐만 아니라 오타, 문법 및 언어를 수정하여 더 설득력 있게 보이도록 하는 것이 포함될 수 있습니다. 또한 신속한 주입 또는 징역형을 통해 사용자 데이터 도난 및/또는 침해의 위험이 있습니다.

또한 위협 행위자와 직접 관련이 없는 사용으로 인한 보안 위험도 있습니다. 예를 들어, ChatGPT가 귀하로부터 받는 정보는 LLM 교육에 활용될 수 있습니다. ChatGPT MacOS 앱이 처음에 일반 텍스트로 저장된 사용자 채팅과 함께 시작함에 따라 데이터 암호화가 불충분할 위험도 있습니다.

OpenAI 보안 위험

OpenAI API 자체는 사이버 범죄자의 표적이 될 가능성이 있습니다. SOC 2를 준수하며 정기적인 침투 테스트를 거치지만 사이버 위협이 끊임없이 진화하고 있기 때문에 위험이 완전히 제거되지는 않습니다. 최근 Soft Kraft 기사는 OpenAI 데이터 보안 위험을 포괄적으로 자세히 살펴보고 엔터프라이즈 사용자에게 특히 관심이 있는 위험을 공개합니다.

- ChatGPT 대화 데이터는 모델 재교육 목적으로 사용할 수 있습니다.

- API를 통해 전송된 데이터는 내부 및 외부에 노출될 수 있습니다.

- 일반 데이터 보호 규정(GDPR) 준수를 보장하는 것은 어려울 수 있습니다.

- 제3자 하위 처리자의 사용은 위치 및 데이터 처리를 복잡하게 합니다.

Microsoft Copilot AI 보안 위험

Microsoft 365 애플리케이션을 지원하여 Microsoft Copilot AI를 사용자가 쉽게 사용할 수 있습니다. 또한 하드웨어 수준에서 최신 Copilot+ 브랜드 PC는 전용 물리적 Copilot 키와 함께 제공되므로 사용자의 입력이 더 빨라집니다. 이러한 간소화된 액세스 조치는 다른 생성 AI 도구와 마찬가지로 민감한 정보를 Copilot에 제공하는 경우 보안 위험을 초래할 수 있습니다. 권한이 올바르게 설정되지 않았거나 AI 생성 문서에 적절한 개인정보 보호 설정이 활성화되지 않은 경우 기밀 데이터 유출 및/또는 침해에 직면할 수도 있습니다. 사용자 액세스 관리에도 마찬가지입니다. 마지막으로, 플랫폼 자체에 대한 공격은 위협 행위자가 데이터에 액세스하고 공유하는 방법을 수정할 수 있도록 합니다.

AI 보안 위험을 관리하는 데 도움을 줄 수 있는 사람은 누구입니까?

AI 혁신의 지속적인 발전을 위해서는 35년의 업계 최고의 위협 인텔리전스, 20년의 AI 개발 선구자, 탁월한 취약점 보호, 즉 Trend Vision One™ AI Security가 지원하는 보안이 필요합니다.

AI 보안 솔루션을 통해 전체 AI 스택을 포함한 중요한 비즈니스 워크로드를 보호하는 동시에 전반적인 보안 태세를 강화합니다. Trend Cybertron을 기반으로 하는 AI Security는 공격 경로를 예측하고 이상을 탐지하는 동시에 딥페이크 및 AI 생성 공격으로부터 방어하여 보안 사각지대를 제거하고 AI 보안을 혁신을 위한 촉매로 전환합니다.